Dans le monde de la science des données, la gestion de flux de travail complexes est essentielle pour gérer des tâches telles que l'ingestion de données, le prétraitement, la formation et le déploiement. Les outils d'orchestration simplifient ces processus en automatisant les dépendances, la planification et la mise à l'échelle. Voici un bref aperçu des quatre principaux outils :

Chaque outil possède des atouts uniques, de l'optimisation de l'IA au traitement par lots, ce qui fait que votre choix dépend de l'expertise de l'équipe et des besoins du projet.

Choisissez l'outil qui correspond à la complexité de votre flux de travail, à l'expertise de votre équipe et à vos besoins d'évolutivité.

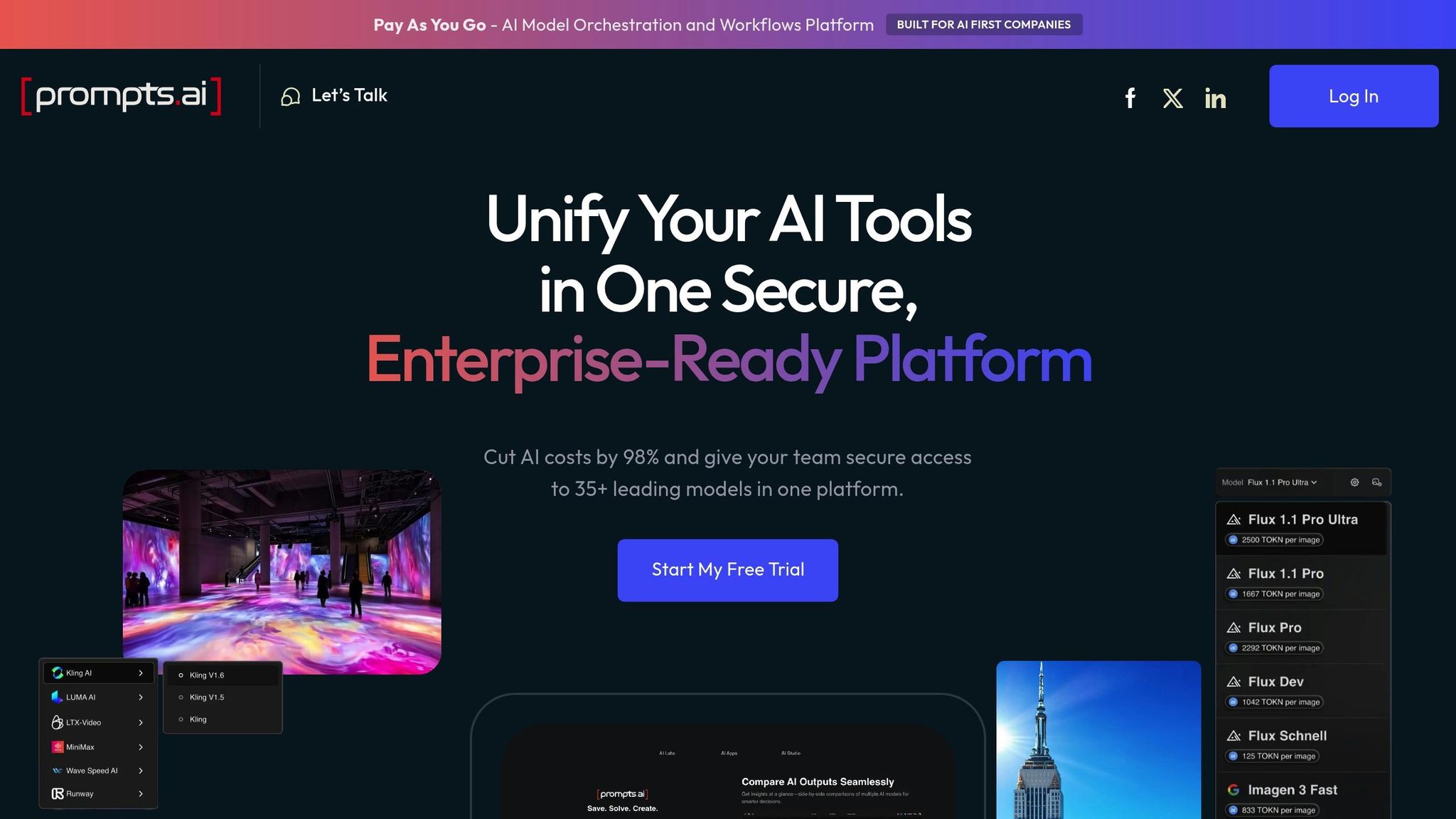

Prompts.ai est une plateforme de pointe conçue pour rationaliser les flux de travail d'IA d'entreprise en réunissant plus de 35 grands modèles de langage (dont GPT-5, Claude, Lama, et Gémeaux) dans un système sécurisé et centralisé. Pour les data scientists travaillant en entreprise, cette approche unifiée simplifie l'accès à de multiples outils d'IA tout en garantissant une gouvernance et une rentabilité solides. En consolidant l'accès aux modèles, les organisations peuvent réduire de manière significative leurs dépenses en matière de logiciels d'IA.

Cette plateforme s'intègre parfaitement aux flux de travail existants. Son cadre indépendant des modèles garantit que les entreprises peuvent continuer à utiliser leurs investissements actuels en matière d'IA sans avoir à suivre une nouvelle formation ou à reconfigurer des bibliothèques rapides à mesure que de nouveaux modèles sont introduits.

Prompts.ai prend en charge de nombreuses tâches répétitives dans le Flux de travail IA. Les data scientists peuvent développer des modèles d'invite standardisés pour maintenir la cohérence et intégrer les meilleures pratiques dans tous les projets. La plateforme automatise également la sélection et la comparaison des modèles, en proposant des outils d'évaluation intégrés. De plus, des contrôles de gouvernance automatisés garantissent la conformité aux normes de l'entreprise pour chaque interaction avec l'IA.

Conçu pour les entreprises, Prompts.ai est conçu pour évoluer aux côtés de votre organisation. Qu'il s'agisse d'ajouter d'autres utilisateurs, d'intégrer de nouveaux modèles ou d'étendre l'utilisation à d'autres services, la mise à l'échelle est rapide et efficace. Le système de crédit TOKN pay-as-you-go de la plateforme garantit que les coûts correspondent directement à l'utilisation réelle, permettant aux équipes ayant des charges de travail variables de fonctionner de manière flexible tout en maintenant une isolation des données et des contrôles d'accès stricts.

Prompts.ai inclut une couche FinOps qui fournit des informations en temps réel sur les dépenses au niveau des jetons. Cette fonctionnalité permet aux data scientists de surveiller les coûts par projet, modèle ou membre de l'équipe, en reliant directement les dépenses liées à l'IA aux résultats commerciaux. Grâce à des outils de suivi du retour sur investissement et d'optimisation des coûts, les équipes peuvent prendre des décisions plus intelligentes pour équilibrer les performances et le budget.

Ces fonctionnalités font de Prompts.ai une solution robuste pour gérer et optimiser les flux de travail d'IA d'entreprise.

Apache Airflow est devenue une plateforme open source incontournable pour orchestrer les flux de travail et gérer les pipelines de données. Il utilise une structure de graphe acyclique dirigé (DAG), permettant aux data scientists de définir les flux de travail sous forme de code Python. Cette approche garantit la transparence, le contrôle des versions et un cadre solide pour créer des processus évolutifs et automatisés.

Airflow propose une variété de connecteurs prédéfinis qui facilitent l'intégration aux outils de données et aux services cloud les plus courants. Que vous travailliez avec Flocon de neige, BigQuery, Amazon S3, Databricks, ou Kubernetes, les opérateurs et les crochets d'Airflow simplifient le processus de connexion. La plateforme utilise également son Com permet de transmettre des données entre les tâches, tandis que son API REST permet une intégration transparente avec des systèmes externes de surveillance et d'alertes.

Pour encore plus de flexibilité, les packages fournisseurs d'Airflow facilitent l'ajout de nouvelles intégrations. Des fournisseurs officiels gérés par les principaux services cloud, tels que ÉTAIT, Flux de données Google Cloud, et Fabrique de données Azure - étendre la portée d'Airflow, en permettant aux équipes d'orchestrer les flux de travail sur un large éventail de plateformes.

Airflow excelle dans l'automatisation des flux de travail grâce à des outils intégrés de planification, de gestion des dépendances et de gestion des nouvelles tentatives. Les tâches sont exécutées dans le bon ordre, car les tâches en aval ne sont exécutées qu'une fois les tâches en amont terminées avec succès. Les mécanismes de nouvelle tentative configurables rendent le dépannage plus efficace, tandis que capteurs et les opérateurs personnalisés activent des déclencheurs basés sur des événements.

L'une des caractéristiques les plus remarquables est génération dynamique de DAG, qui permet aux équipes de créer des pipelines par programmation à partir de modèles. Cela est particulièrement utile pour gérer les flux de travail à grande échelle, car cela réduit les configurations répétitives et garantit la cohérence entre des pipelines similaires.

Airflow est conçu pour s'adapter à vos besoins. En utilisant Executeur Celery ou Exécuteur Kubernetes, les tâches peuvent être distribuées dynamiquement pour un traitement parallèle. Ses capacités de mise à l'échelle horizontale garantissent des performances efficaces, même lorsque les charges de travail augmentent. En outre, les fonctionnalités multi-tenant permettent à plusieurs équipes de partager l'infrastructure tout en maintenant une isolation stricte des tâches et des données.

Bien que l'utilisation d'Airflow soit gratuite, l'infrastructure et la maintenance nécessaires à son fonctionnement peuvent augmenter les coûts d'exploitation. Pour vous aider à gérer ces dépenses, Airflow fournit des mesures détaillées sur l'exécution des tâches et l'utilisation des ressources. Cette visibilité permet aux équipes de surveiller les frais généraux et d'optimiser l'allocation des ressources de manière efficace.

Prefect met l'accent sur une expérience fluide pour les développeurs et des opérations simples pour l'orchestration des flux de travail. Contrairement à de nombreux outils traditionnels, il considère les échecs comme une partie naturelle de son processus plutôt que de les traiter comme des exceptions. Cette philosophie de conception intègre la résilience au cœur de ses préoccupations, ce qui la rend particulièrement attrayante pour les data scientists à la recherche d'une automatisation fiable sans avoir à gérer une infrastructure complexe.

Le système d'intégration du préfet s'articule autour de blocs et collections, offrant des connexions prêtes à l'emploi aux principales plateformes de données. Il fournit des intégrations natives avec les principaux services cloud tels que AWS S3, Stockage dans le cloud de Google, et Stockage Azure Blob. Ces intégrations sont équipées d'une gestion intégrée des informations d'identification et d'un pool de connexions, ce qui rationalise le processus de configuration souvent fastidieux des projets de science des données.

La plateforme bibliothèque de tâches étend la prise en charge des flux de travail d'apprentissage automatique avec des blocs spécialisés qui se connectent directement à des outils tels que Débit ML, Poids et biais, et Visage étreignant. Pour les tâches gourmandes en ressources de calcul, Prefect s'intègre à Docker et Kubernetes, permettant une exécution fluide dans des environnements conteneurisés. De plus, des outils tels que Slack et Microsoft Teams les blocs permettent de recevoir des notifications automatisées en cas d'achèvement de tâches ou de problèmes, ce qui permet aux équipes de rester informées sans effort supplémentaire. Ces intégrations améliorent collectivement l'écosystème d'automatisation de Prefect.

Les outils d'automatisation de Prefect excellent dans planification intelligente et logique conditionnelle. Les flux de travail peuvent être déclenchés par des planifications, des événements ou des API, tandis que sous-flux Cette fonctionnalité permet aux utilisateurs de décomposer des pipelines complexes en composants réutilisables dans tous les projets.

Les flux conditionnels permettent une exécution dynamique en fonction de conditions de données spécifiques ou de résultats antérieurs. Par exemple, une tâche de validation des données peut lancer différents processus en aval en fonction de la qualité des données. Le préfet soutient également exécution parallèle, gérant automatiquement les ressources de manière à ce que plusieurs les tâches peuvent être exécutées simultanément sans configuration supplémentaire.

La plateforme mécanismes de nouvelle tentative inclut des fonctionnalités telles que l'arrêt exponentiel et les conditions de nouvelle tentative personnalisées, tandis que son mise en cache le système empêche les calculs redondants en stockant les résultats des tâches. Prefect gère également gestion de l'État automatiquement, en suivant l'état des tâches et des flux à l'aide de journaux détaillés et de métadonnées pour une surveillance facile.

Prefect est conçu pour évoluer sans effort afin de répondre aux demandes de charge de travail fluctuantes. Son modèle d'exécution hybride combine une orchestration gérée via Cloud parfait avec la flexibilité nécessaire pour exécuter des charges de travail sur la propre infrastructure d'une équipe. Cette approche permet aux équipes de trouver un équilibre entre commodité et contrôle.

Pour les déploiements plus importants, Prefect prend en charge mise à l'échelle horizontale à l'aide de son pools de travail et travailleurs architecture, qui distribue dynamiquement les tâches sur plusieurs machines ou instances cloud. L'intégration de Kubernetes améliore encore son évolutivité, en permettant l'allocation automatique des ressources pour les tâches gourmandes en calcul. La plateforme architecture basée sur les agents permet aux équipes de déployer des employés dans divers environnements, qu'ils soient sur site, dans le cloud ou hybrides, tout en maintenant une supervision et une orchestration centralisées.

Prefect fournit des informations opérationnelles claires grâce à son tableau de bord Flow Run et métriques d'exécution, en suivant des informations telles que le temps de calcul et l'utilisation de la mémoire pour chaque flux de travail. Cette transparence aide les équipes à affiner leurs pipelines pour une meilleure efficacité.

Pour les petites équipes, Cloud parfait inclut un niveau gratuit avec jusqu'à 20 000 exécutions de tâches par mois, ce qui en fait une option accessible pour de nombreux projets de science des données. En outre, le balisage des ressources permet aux équipes de suivre les coûts par projet ou par département, offrant une vue granulaire qui permet de démontrer le retour sur investissement et de prendre des décisions éclairées concernant l'allocation des ressources.

Luigi, un outil Python open source développé par Spotify, adopte une approche ciblée du traitement des données par lots. Il permet aux utilisateurs de créer des pipelines de traitement par lots complexes en reliant les tâches entre elles, qu'elles soient en cours d'exécution Hadoop tâches, transfert de données ou exécution d'algorithmes d'apprentissage automatique. Cela en fait un choix fiable pour les flux de travail qui reposent sur le traitement séquentiel des données. De plus, la compatibilité intégrée de Luigi avec Hadoop et diverses bases de données simplifient la configuration des opérations par lots à grande échelle. L'accent mis sur les flux de travail séquentiels par lots en fait une option remarquable, qui mérite un examen plus approfondi de ses points forts et de ses inconvénients potentiels.

Le choix du bon outil dépend de l'expertise de votre équipe, de la complexité du projet et des besoins spécifiques en matière de flux de travail. Chaque outil comporte ses points forts et ses propres défis, donc les comprendre peut vous aider à prendre une décision.

Flux d'air Apache se distingue par sa conception native de Python et sa solide prise en charge par la communauté, ce qui en fait une référence pour les processus ETL/ELT par lots statiques et complexes et pour les pipelines complets d'apprentissage automatique. Cette flexibilité s'accompagne toutefois de défis, notamment une courbe d'apprentissage abrupte, des exigences d'infrastructure importantes et l'absence de gestion des versions natives des flux de travail.

Préfet simplifie les pipelines dynamiques grâce à des fonctionnalités telles que la gestion des erreurs, les nouvelles tentatives automatiques et l'évolutivité. Son architecture moderne en fait un choix judicieux pour les équipes qui privilégient la facilité d'utilisation. Cela dit, sa communauté plus restreinte et sa focalisation limitée sur les interfaces visuelles pourraient être des inconvénients pour certains utilisateurs.

Luigi excelle dans la gestion de processus par lots simples et stables grâce à son approche légère et axée sur la dépendance. Il offre un contrôle de version transparent et prend en charge une logique personnalisée, ce qui en fait un choix fiable pour des flux de données simples. Cependant, l'adaptation à des scénarios de mégadonnées peut s'avérer difficile, et son interface utilisateur minimale et sa documentation limitée risquent de ne pas satisfaire les équipes habituées à des outils plus avancés. Malgré ces limites, Luigi reste une solution pratique pour rationaliser le traitement par lots.

Prompts.ai adopte une approche axée sur l'IA, intégrant plus de 35 modèles linguistiques de premier plan sur une seule plateforme. Avec des fonctionnalités telles que la gouvernance de niveau entreprise, le contrôle des coûts en temps réel et la possibilité de réduire les dépenses liées aux logiciels d'IA jusqu'à 98 %, c'est une excellente option pour les organisations qui gèrent divers flux de travail d'IA. Son modèle de paiement à l'utilisation apporte de la flexibilité en supprimant les frais récurrents tout en offrant des fonctionnalités complètes de conformité et d'audit.

Voici une comparaison rapide des outils, mettant en évidence leurs forces, leurs faiblesses et leurs cas d'utilisation idéaux :

Pour le traitement par lots à grande échelle, Flux d'air Apache est souvent le choix préféré. Préfet se distingue par ses flux de travail dynamiques d'apprentissage automatique, offrant de la flexibilité et des fonctionnalités conviviales pour les développeurs. Les équipes spécialisées dans les projets pilotés par l'IA trouveront Prompts.ai particulièrement précieux pour ses capacités spécialisées, tandis que Luigi reste une option fiable pour des flux de travail plus simples et économes en ressources.

Après avoir examiné les comparaisons, il est clair que le bon outil d'orchestration dépend des besoins et de l'expertise spécifiques de votre équipe. Voici un bref récapitulatif : Flux d'air Apache est un excellent choix pour gérer des processus par lots complexes et à grande échelle si vous disposez de l'expertise en matière d'infrastructure nécessaire pour le prendre en charge. Préfet brille dans la gestion de pipelines d'apprentissage automatique dynamiques et agiles. Luigi fonctionne bien pour les flux de travail par lots simples, et Prompts.ai se distingue par ses processus axés sur l'IA dotés d'une gouvernance et d'une gestion des coûts solides.

Pour les équipes de petite ou moyenne taille, Luigi offre un point d'entrée simple pour les flux de travail par lots, tandis que Prompts.ai convient parfaitement aux projets pilotés par l'IA. Les grandes entreprises dotées d'équipes dédiées à l'infrastructure peuvent trouver Flux d'air Apache pour être la meilleure solution, tandis que les équipes agiles travaillant sur l'apprentissage automatique pourraient apprécier l'approche moderne de Préfet.

En fin de compte, le meilleur outil est celui que votre équipe peut utiliser de manière efficace et efficiente. Commencez par ce qui répond à vos besoins actuels et adaptez-vous en fonction de l'évolution de vos flux de travail et de vos exigences.

Lors du choix d'un outil d'orchestration, les équipes de data science doivent se concentrer sur des aspects clés tels que facilité d'utilisation, évolutivité, et dans quelle mesure il s'intègre aux flux de travail existants. Pour gérer des flux de travail complexes et statiques, des outils tels qu'Apache Airflow et Luigi constituent d'excellentes options. D'autre part, si vous avez besoin de pipelines natifs Python plus adaptables, Prefect offre une plus grande flexibilité.

Il est également important de prendre en compte les exigences d'infrastructure de chaque outil, car certains peuvent nécessiter des ressources plus importantes pour évoluer efficacement. Il est tout aussi essentiel d'évaluer dans quelle mesure l'expertise de l'équipe correspond au modèle de programmation de l'outil afin d'assurer une transition en douceur et de maintenir la productivité. L'outil idéal dépendra en fin de compte de vos exigences spécifiques en matière de flux de travail et du degré d'automatisation ou de personnalisation dont vous avez besoin.

Prompts.ai simplifie la gestion des coûts et de la gouvernance des flux de travail d'IA en fournissant une plateforme centralisée dédiée aux équipes d'IA. Il met l'accent transparence des coûts, offrant un suivi détaillé des dépenses et de l'utilisation des ressources. Cela permet aux équipes de planifier leurs budgets en toute confiance et d'éviter les coûts imprévus.

Les outils d'orchestration traditionnels exigent souvent une expertise technique importante et peuvent entraîner des dépenses cachées ou imprévisibles. Prompts.ai, cependant, est spécialement conçu pour faciliter Orchestration de l'IA. En donnant la priorité à une utilisation et à une gouvernance efficaces des ressources, il aide les équipes à rationaliser les flux de travail tout en maîtrisant leurs budgets.

Prefect propose un moyen intelligent et flexible de gérer les défaillances des flux de travail, ce qui en fait un outil hors pair pour les data scientists. Grâce à des fonctionnalités telles que les nouvelles tentatives automatiques, les notifications personnalisées et la possibilité d'ajuster les flux de travail de manière dynamique en cas de problème, il simplifie le dépannage et accélère la restauration. Cela signifie moins de temps d'arrêt pour les pipelines de données complexes et plus de temps consacré à des analyses pertinentes.

Contrairement aux outils qui s'en tiennent à des cadres rigides, la conception de Prefect permet aux flux de travail de s'adapter en temps réel. Cela est particulièrement utile pour les projets pilotés par l'IA ou urgents où la flexibilité est essentielle. En rationalisant les opérations et en améliorant la fiabilité, Prefect permet aux data scientists de se concentrer sur la découverte d'informations plutôt que sur les problèmes opérationnels.