L'IA générative redéfinit les entreprises, mais il est essentiel de choisir la bonne plateforme. Ce guide passe en revue cinq plateformes de premier plan pour vous aider à trouver la solution la mieux adaptée à vos flux de travail d'IA. Que vous cherchiez à réduire les coûts, à améliorer la gouvernance ou à développer vos opérations, voici ce que vous devez savoir :

Plats à emporter rapides: Prompts.ai apparaît comme le premier choix pour les entreprises à la recherche de rentabilité et de flux de travail rationalisés, tandis qu'IBM Watsonx Orchestrate excelle dans les environnements à forte gouvernance. Apache Airflow se distingue par sa flexibilité en matière d'open source.

Découvrez comment ces plateformes se comparent en termes d'intégration, de gouvernance, d'évolutivité et de gestion des coûts.

Prompts.ai est une plateforme d'orchestration d'IA d'entreprise qui regroupe plus de 35 grands modèles de langage (LLM) de premier plan, dont GPT-5, Claude, Lama, et Gémeaux - dans une interface sécurisée et unifiée. Il aborde le problème courant de la fragmentation des outils d'IA en simplifiant l'intégration des modèles, en garantissant la gouvernance et en réduisant les coûts.

Avec Prompts.ai, les organisations peuvent intégrer plusieurs LLM via des API et des connecteurs, permettant ainsi des transitions fluides entre des modèles tels que OpenAI GPT, Google Gemini et Anthropic Claude pour répondre à des besoins spécifiques. Par exemple, un important fournisseur de soins de santé américain a utilisé Prompts.ai pour alimenter des chatbots orientés vers les patients avec plusieurs LLM, offrant ainsi des interactions cohérentes et fiables dans différents scénarios de patients.

La conception de l'API ouverte de la plateforme permet également l'intégration avec des outils d'automatisation des flux de travail largement utilisés, des entrepôts de données d'entreprise et des systèmes de stockage dans le cloud. Cette compatibilité garantit que les capacités d'IA peuvent être intégrées aux infrastructures technologiques existantes sans interruption, ouvrant ainsi la voie à une rentabilité mesurable.

Prompts.ai aide les organisations à contrôler les coûts grâce à des analyses d'utilisation détaillées, à des outils FinOps en temps réel et à un suivi budgétaire automatisé. Les entreprises qui utilisent la plateforme ont réduit les coûts opérationnels liés aux réponses rapides jusqu'à 30 %, et certaines ont réalisé des économies allant jusqu'à 98 % sur les dépenses liées aux logiciels d'IA. Le système de crédits TOKN pay-as-you-go lie les coûts directement à l'utilisation, offrant des budgets mensuels prévisibles et une plus grande transparence financière pour les entreprises américaines. Cette focalisation sur le contrôle des coûts est complétée par des fonctionnalités de gouvernance qui améliorent la cohérence opérationnelle.

La gouvernance est la pierre angulaire de Prompts.ai, qui propose des outils tels que des contrôles d'accès basés sur les rôles, des journaux d'audit, des politiques personnalisables et un contrôle de version intégré avec des tests A/B. Ces fonctionnalités aident les organisations à répondre aux exigences réglementaires telles que HIPAA et CCPA, tout en améliorant la qualité des sorties rapides jusqu'à 20 % grâce à des améliorations itératives. L'architecture évolutive de la plateforme garantit la stabilité des performances même en cas d'augmentation de la demande.

Construit sur une base native du cloud, Prompts.ai prend en charge la mise à l'échelle horizontale pour gérer les demandes d'API à haut débit et les exécutions rapides simultanées. Hébergé sur les principaux fournisseurs de cloud américains tels que AWS, Azure, et Google Cloud, ses fonctionnalités de mise à l'échelle automatique et d'équilibrage de charge permettent de maintenir des performances constantes pendant les périodes de pointe. Les déploiements en entreprise ont atteint une disponibilité de 99,9 % avec des délais d'exécution inférieurs à la seconde. En outre, les espaces de travail collaboratifs permettent aux équipes d'ajouter facilement de nouveaux modèles et de nouveaux utilisateurs au fur et à mesure de leur croissance, renforçant ainsi la position de Prompts.ai en tant que solution incontournable pour rationaliser les flux de travail d'IA génératifs.

Il n'existe aucune vérification disponible des capacités de Vellum AI dans des domaines tels que l'intégration de modèles, la gouvernance ou l'évolutivité. Par conséquent, ces aspects ne sont pas pris en compte dans cette analyse. Ensuite, nous examinerons IBM watsonx Orchestrate.

IBM Watsonx Orchestrate est une plateforme d'IA d'entreprise conçue sur le cloud hybride d'IBM, qui simplifie l'automatisation des activités et les flux de travail d'IA génératifs. Il associe des fonctionnalités techniques avancées à une gouvernance intégrée pour aider les organisations à déployer efficacement des solutions d'IA à grande échelle. Contrairement à l'IA Vellum, plus limitée, Watsonx Orchestrate propose une solution complète adaptée aux besoins des entreprises.

La plateforme prend en charge une variété de grands modèles de langage, notamment BERT, Meta Llama 3, GPT-3, GPT-4 et Megatron-LM. Cette intégration diversifiée de modèles permet des opérations fluides tout en jetant les bases de ses capacités de gouvernance.

La gouvernance est une caractéristique essentielle de watsonx Orchestrate, avec des pratiques d'IA en matière de conformité, de sécurité et d'éthique intégrées directement dans son infrastructure. En intégrant ces mesures dès le départ, la plateforme garantit des opérations fiables et sécurisées, en alignant les performances techniques sur les normes organisationnelles.

Conçu pour les projets d'entreprise à grande échelle, watsonx Orchestrate exploite le cloud hybride d'IBM pour soutenir la croissance sans compromettre la gouvernance. Sa capacité d'évolutivité garantit des performances constantes, même lorsque les demandes augmentent, tout en maintenant des normes de gouvernance rigoureuses.

Apache Airflow se distingue comme une puissante plateforme open source conçue pour l'orchestration des flux de travail, offrant une alternative rentable aux solutions propriétaires. Développé à l'origine par Airbnb, il permet de créer des pipelines d'IA génératifs évolutifs et efficaces à l'aide de graphes acycliques orientés. Contrairement aux plateformes liées aux frais de licence d'entreprise, Airflow offre de la flexibilité sans frais supplémentaires.

Conçu pour gérer des projets de grande envergure, Airflow utilise une architecture d'exécution distribuée. Il prend en charge plusieurs exécuteurs testamentaires, tels que le Executeur Celery et Exécuteur Kubernetes, pour permettre une mise à l'échelle horizontale entre les nœuds de travail. Le KubernetesExecutor, par exemple, attribue chaque tâche à un pod individuel, ce qui permet une allocation dynamique des ressources en fonction des besoins de calcul. Cette architecture garantit que la plateforme peut s'adapter à différentes charges de travail tout en maintenant des opérations efficaces.

Pour les entreprises, Airflow intègre des fonctionnalités qui garantissent la conformité, la sécurité et la transparence. Il s'agit notamment journalisation des audits, contrôle d'accès basé sur les rôles (RBAC), et suivi du lignage des données. Ensemble, ces outils protègent les flux de travail, améliorent la supervision et fournissent une visibilité claire sur les processus pilotés par l'IA, ce qui en fait un choix fiable pour les organisations qui accordent la priorité à la gouvernance.

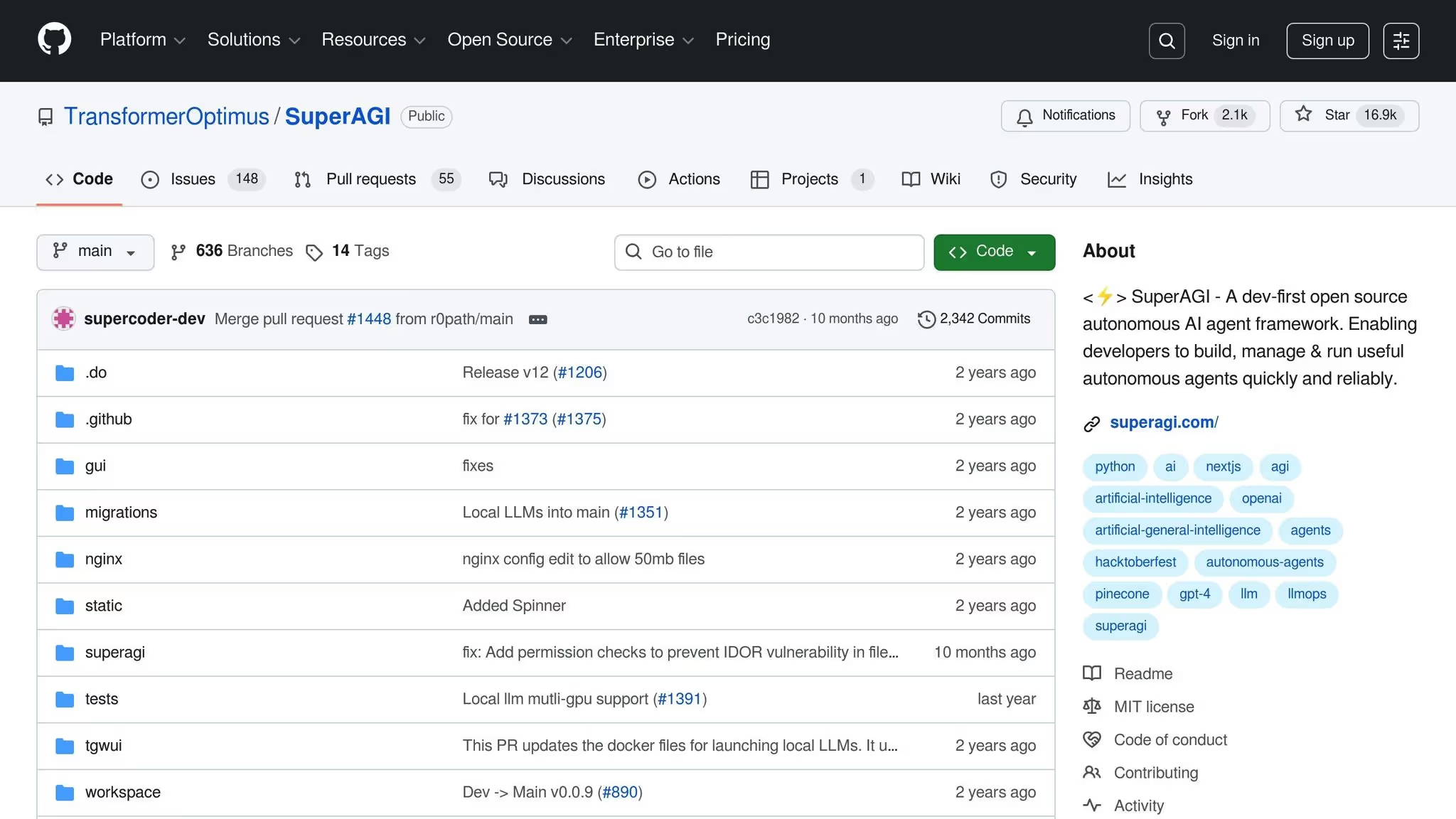

SuperAgi est un framework prometteur conçu pour les agents d'IA autonomes, spécifiquement destiné à améliorer les flux de travail d'IA génératifs. Bien qu'il soit prometteur, les informations accessibles au public sur son architecture, ses capacités d'intégration, son évolutivité et ses stratégies de gestion des coûts sont limitées. Pour obtenir les informations les plus précises et les plus récentes, reportez-vous directement à la documentation officielle de SuperAgi.

Sur la base de nos analyses détaillées de nos plateformes, voici un résumé concis des principaux points forts et limites de chaque solution. Chaque plateforme présente ses propres avantages et défis, déterminés par des facteurs tels que l'intégration des modèles, la gestion des coûts, la gouvernance et l'évolutivité.

Prompts.ai est un choix exceptionnel pour les entreprises, car il offre une orchestration fluide de plus de 35 grands modèles linguistiques de premier plan. Il se distingue par la simplification des flux de travail et la réduction de la prolifération des outils. Ses fonctionnalités FinOps en temps réel peuvent réduire les coûts de l'IA jusqu'à 98 %. Cependant, l'accent mis sur les flux de travail centrés sur les rapides risque de ne pas répondre pleinement aux besoins des utilisateurs à la recherche de fonctionnalités d'orchestration avancées que l'on trouve généralement sur des plateformes de flux de travail plus étendues.

Vélin AI se spécialise dans la gestion rapide et propose des outils de gestion des versions et de collaboration. Il s'intègre bien aux principaux fournisseurs de LLM, ce qui en fait une option solide pour les équipes chargées de projets complexes d'IA générative. En revanche, il peut rencontrer des problèmes d'évolutivité et ne pas être intégré à des modèles non LLM ou à des sources de données externes.

IBM Watsonx Orchestrate excelle dans les secteurs hautement réglementés, offrant de solides fonctionnalités de gouvernance et de conformité. Il prend en charge les déploiements de cloud hybride et s'intègre parfaitement à l'écosystème d'IA d'IBM. Cependant, ses coûts et sa complexité plus élevés peuvent poser des défis aux petites équipes, en particulier celles qui ne disposent pas d'une infrastructure IBM existante.

Flux d'air Apache offre une flexibilité inégalée en tant que système de gestion des flux de travail open source. Il est largement utilisé dans le domaine de la technologie pour orchestrer des pipelines de formation et de déploiement de modèles ML à grande échelle. Son architecture extensible prend en charge l'exécution distribuée et l'intégration de modèles basés sur Python. Cependant, elle nécessite une courbe d'apprentissage abrupte, une expertise technique et des implémentations de gouvernance personnalisées.

Super Agi est conçu pour une orchestration multi-agents modulaire et autonome, ce qui le rend idéal pour les flux de travail adaptatifs. Les laboratoires de recherche l'utilisent souvent pour des expériences impliquant des systèmes multi-agents autonomes et l'automatisation des flux de travail. Bien que sa nature open source permette de réduire les coûts, elle nécessite d'importantes ressources techniques et de personnalisation. De plus, ses fonctionnalités de gouvernance sont moins développées que celles des plateformes d'entreprise.

Voici une comparaison côte à côte des performances de ces plateformes selon les principaux critères d'évaluation :

Cette comparaison permet d'identifier la plateforme qui correspond le mieux à des objectifs opérationnels spécifiques. Pour les secteurs nécessitant une gouvernance stricte, IBM Watsonx Orchestrate est un choix fiable. Les équipes à la recherche d'une personnalisation approfondie peuvent être attirées par Flux d'air Apache. Super Agi s'adresse à ceux qui privilégient la flexibilité de l'open source et les flux de travail expérimentaux. Entre-temps, Prompts.ai est une option robuste pour les flux de travail rapides, alliant rentabilité et fonctionnalités de niveau entreprise.

Le choix de la plateforme de flux de travail d'IA interopérable adaptée à l'IA générative dépend des besoins uniques, de l'expertise technique et des objectifs à long terme de votre organisation. Voici un bref résumé de ce que chaque plateforme apporte à la table :

Chaque plateforme a ses points forts, et la compréhension de vos priorités vous guidera vers la meilleure solution.

Prompts.ai introduit un couche FinOps qui garde un œil sur chaque interaction, offrant des informations en temps réel sur l'utilisation, les dépenses et le retour sur investissement. Cette fonctionnalité vous permet de suivre de près les dépenses et de gérer les coûts avec précision.

En remplaçant le besoin de plus de 35 outils d'IA distincts, la plateforme consolide les flux de travail et peut réduire les coûts jusqu'à 95 %. C'est Payez à l'utilisation Ce modèle, alimenté par des crédits TOKN flexibles, vous garantit de ne payer que pour ce que vous utilisez, ce qui en fait un choix adaptable et rentable pour développer vos initiatives d'IA.

Prompts.ai intègre de puissants outils de gouvernance pour aider les organisations à rester en conformité avec les principales réglementations, notamment HIPAA, CCPA et GDPR. Ces outils comportent des mesures de protection des données strictes, des contrôles d'accès avancés et des pratiques de gestion des données sécurisées.

En respectant les normes industrielles établies telles que SOC 2 Type II, Prompts.ai fournit un environnement sécurisé pour le traitement des informations sensibles. Cela permet aux entreprises de tirer parti en toute confiance des solutions d'IA génératives tout en s'assurant de respecter leurs obligations réglementaires.

Prompts.ai est conçu pour évoluer, ce qui permet à votre organisation de gérer un trafic d'API important et de multiples exécutions rapides sans problème. Son infrastructure robuste et ses flux de travail rationalisés lui permettent de gérer facilement les demandes croissantes liées à l'expansion de projets d'IA générative.

Que vous traitiez des milliers de demandes par seconde ou que vous orchestiez des flux de travail d'IA complexes, Prompts.ai assure le bon fonctionnement des opérations. Son cadre évolutif garantit une vitesse, une fiabilité et une efficacité constantes, aidant les entreprises à gérer des scénarios de forte demande sans ralentissement opérationnel.