La gestion des flux de travail par IA peut être complexe et présenter des défis tels que la multiplication des outils, le suivi des coûts et les inefficacités. La bonne plateforme peut simplifier les processus, réduire les coûts et augmenter la productivité. Après avoir passé en revue plus de 30 outils, voici les 9 meilleures plateformes pour gérer efficacement les flux de travail liés à l'IA :

Chaque plateforme répond à des besoins différents, qu'il s'agisse de solutions d'entreprise ou d'outils pour les petites équipes. Qu'il s'agisse de consolider des outils d'IA, d'automatiser des flux de travail ou de gérer des coûts, il existe une option adaptée à vos objectifs.

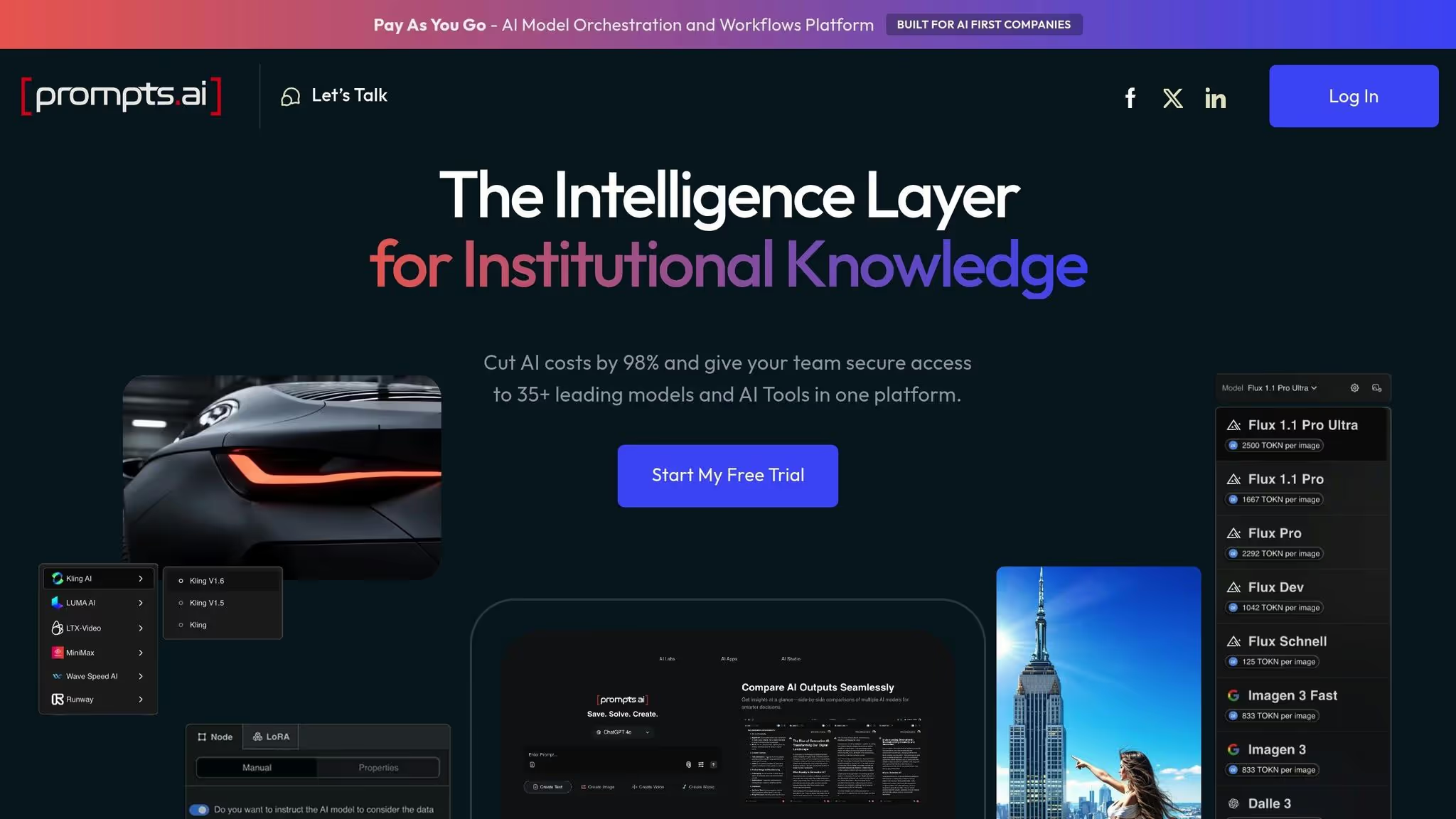

Prompts.ai est une plateforme d'orchestration d'IA avancée qui regroupe plus de 35 modèles de langage de premier plan, notamment GPT-5, Claude, Lama, Gémeaux, Grok-4, Flux Pro, et Kling - dans un système unique et sécurisé. Créée par Steven P. Simmons, directeur artistique lauréat d'un Emmy Award, la plateforme répond aux défis auxquels de nombreuses organisations sont confrontées en raison de la dispersion des outils d'IA, des dépenses cachées et des lacunes en matière de gouvernance. Il offre un environnement centralisé dans lequel les entreprises du Fortune 500, les agences de création et les instituts de recherche peuvent accéder à des modèles haut de gamme, comparer leurs performances côte à côte, appliquer les normes de conformité et surveiller l'utilisation des jetons en temps réel.

En remplaçant les expérimentations ponctuelles chaotiques par des processus rationalisés et reproductibles, Prompts.ai transforme la façon dont les organisations adoptent et gèrent l'IA. La plateforme introduit ce qu'elle appelle « la couche d'intelligence pour les connaissances institutionnelles », garantissant que les flux de travail d'IA sont à la fois transparents et gérables.

Prompts.ai tient sa promesse de gestion unifiée de l'IA grâce à une gamme d'outils spécialisés. Il s'agit notamment de solutions intégrées pour la création de contenu visuel, le développement d'agents d'IA personnalisés et l'automatisation avancée des flux de travail. Les utilisateurs peuvent former et affiner les LoRA (Low-Rank Adaptations), créer des agents d'IA personnalisés et concevoir des flux de travail qui intègrent plusieurs modèles et tâches de manière fluide.

Le moteur de flux de travail de la plateforme répond à des besoins variés en fonction des niveaux d'abonnement. Les plans personnels permettent aux utilisateurs d'exécuter des flux de travail préexistants, tandis que les plans de niveau supérieur débloquent des fonctionnalités complètes de création de flux de travail. Ce système hiérarchisé permet aux entreprises de commencer modestement et d'étendre leur utilisation à mesure qu'elles ont davantage confiance en leurs capacités d'IA. En outre, des analyses d'utilisation sont incluses dans tous les forfaits, ce qui permet aux équipes de savoir quels modèles et quels flux de travail offrent les meilleurs résultats.

L'une des offres les plus remarquables est le Programme de certification Prompt Engineer, qui formalise les meilleures pratiques et aide les équipes à développer une expertise interne. Prompts.ai favorise également une communauté mondiale où les utilisateurs peuvent partager des « gains de temps » conçus par des experts, c'est-à-dire des flux de travail prédéfinis conçus pour effectuer efficacement des tâches courantes. Cette fonctionnalité collaborative permet aux équipes de gagner du temps et de tirer parti d'approches éprouvées plutôt que de partir de zéro.

Prompts.ai prend en charge espaces de travail illimités et collaborateurs illimités sur les plans Business et Enterprise, ce qui facilite l'organisation des équipes dans différents départements ou projets. Les plans personnels commencent avec un espace de travail et un utilisateur, tandis que le plan familial peut accueillir jusqu'à cinq membres. Les forfaits Enterprise peuvent accueillir jusqu'à 99 collaborateurs au niveau Elite, avec des espaces de travail illimités pour répondre aux besoins organisationnels les plus complexes.

Les allocations de stockage dans le cloud vont de 1 Go pour les forfaits Pay As You Go à 10 Go pour les niveaux supérieurs, le regroupement de stockage étant disponible pour tous les forfaits afin d'optimiser l'efficacité. Les forfaits Business et Enterprise permettent également flux de travail interopérables, permettant aux équipes de connecter plusieurs opérations d'IA sans nécessiter d'intervention manuelle.

La sécurité est au cœur de ses préoccupations, la plateforme adhérant à SOC 2 Type II, HIPAA et RGPD normes. Un processus d'audit SOC 2 de type 2 a été lancé le 19 juin 2025, démontrant une fois de plus son engagement en matière de conformité. Le Trust Center de la plateforme fournit des mises à jour en temps réel sur son niveau de sécurité, répondant ainsi aux problèmes de gouvernance qui entravent souvent l'adoption de l'IA dans les grandes entreprises. Ces fonctionnalités d'intégration robustes permettent aux organisations de gérer plus facilement les coûts et de garantir des opérations évolutives.

Prompts.ai utilise un Système de crédit TOKN au lieu des frais d'abonnement traditionnels par siège ou par modèle. Ce modèle de paiement à l'utilisation lie les coûts directement à l'utilisation, éliminant ainsi les frais récurrents liés à la capacité inutilisée. Tous les plans incluent des fonctionnalités telles que la mise en commun des TOKN, la mise en commun du stockage, la surveillance de la conformité et l'administration de la gouvernance.

La plateforme prétend qu'elle peut réduire les coûts des logiciels d'IA jusqu'à 98 % en regroupant plusieurs abonnements dans une seule interface. Cette réduction est due à l'élimination des licences redondantes, à l'optimisation de la sélection de modèles pour des tâches spécifiques et à la fourniture d'informations sur les dépenses en temps réel.

La gouvernance est intégrée à chaque plan, et pas seulement aux offres destinées aux entreprises. Des fonctionnalités telles que Surveillance de la conformité et Gouvernance et administration sont inclus même dans le niveau gratuit Pay As You Go, garantissant ainsi que la sécurité et l'auditabilité sont des éléments fondamentaux.

Les fichiers Prompts.ai couche FinOps suit chaque jeton dépensé, associe les coûts aux résultats commerciaux et fournit des informations en temps réel sur les modèles et les flux de travail qui offrent le meilleur retour sur investissement. Les équipes peuvent fixer des limites budgétaires, recevoir des alertes lorsque les dépenses approchent des seuils et optimiser l'utilisation des modèles en fonction des performances et de la rentabilité.

Pour les organisations qui souhaitent évoluer rapidement, les plans Elite offrent une création illimitée de flux de travail, supprimant ainsi les obstacles artificiels à l'automatisation. Le modèle d'espace de travail illimité de la plateforme permet aux services de gérer des environnements distincts pour le développement, les tests et la production sans coûts ni complexité supplémentaires.

Reconnaissant que la technologie à elle seule ne garantit pas le succès, Prompts.ai met l'accent sur l'intégration pratique et la formation en entreprise. Son approche axée sur la communauté, qui comprend des flux de travail d'experts, des programmes de certification et un apprentissage par les pairs, aide les organisations à développer une expertise interne en matière d'IA au lieu de s'appuyer uniquement sur des consultants externes.

n8n est une plate-forme open source conçue pour l'automatisation des flux de travail, permettant aux utilisateurs de connecter diverses applications et services via une interface visuelle basée sur des nœuds. Initialement développé comme un outil à usage général, il s'est depuis étendu pour prendre en charge les flux de travail d'IA en intégrant des services d'IA externes via des API. Cette évolution permet aux utilisateurs de concevoir et de personnaliser des intégrations d'IA sans avoir besoin d'une expertise technique approfondie.

L'interface glisser-déposer de la plateforme simplifie la création de flux de travail d'automatisation complexes, tandis qu'un nœud Code dédié offre la flexibilité nécessaire pour mettre en œuvre des intégrations personnalisées en cas de besoin.

n8n améliore sa conception conviviale avec des fonctionnalités adaptées aux tâches liées à l'IA. En tirant parti des connexions API, il s'intègre parfaitement aux services d'IA externes, éliminant ainsi le besoin d'hébergement direct des modèles. Les nœuds prédéfinis simplifient le processus de connexion aux outils d'IA courants en gérant des tâches telles que l'authentification, le formatage des demandes et la gestion des réponses. Cela permet aux utilisateurs d'intégrer facilement des actions basées sur l'IA, telles que l'analyse des données ou la génération automatique de réponses, dans leurs flux de travail.

La plateforme propose un large éventail d'intégrations prédéfinies, couvrant des domaines tels que le stockage dans le cloud, les outils de communication, les systèmes CRM et les bases de données. De plus, les déclencheurs Webhook permettent de lancer le flux de travail en temps réel à partir de systèmes externes, en intégrant l'automatisation directement dans les applications existantes. n8n prend en charge les options de déploiement auto-hébergées et hébergées dans le cloud. L'auto-hébergement permet aux entreprises de contrôler totalement l'exécution de leurs données et de leurs flux de travail, tandis que le service cloud géré gère les besoins d'infrastructure et de dimensionnement.

Ces options de déploiement sont complétées par une structure tarifaire flexible.

n8n propose une version auto-hébergée gratuite adaptée à un usage personnel ou à de petites équipes. Pour une utilisation commerciale, une licence distincte est requise. Le service hébergé dans le cloud fonctionne selon un modèle d'abonnement avec des plans échelonnés, qui sont basés sur le volume de flux de travail et le niveau de support requis.

n8n est conçu pour évoluer horizontalement en répartissant les exécutions de flux de travail sur plusieurs serveurs. Il inclut une fonction d'historique des exécutions pour le dépannage et la surveillance des performances. En outre, des contrôles d'accès sont en place pour gérer les autorisations des utilisateurs, garantissant ainsi une gouvernance sécurisée et efficace des flux de travail.

Zapier structure sa tarification en fonction de différentes catégories de produits, offrant aux entreprises la flexibilité de choisir des forfaits adaptés à leurs besoins en matière de flux de travail d'IA. Ses outils d'orchestration de l'IA - Zaps, MCP, et Tableaux - combinez-les pour rationaliser les processus en plusieurs étapes, intégrer des services d'IA via des API et gérer les données pour Tâches basées sur l'IA. Cette configuration permet aux entreprises de gérer de manière organisée des flux de travail complexes liés à l'IA. Le modèle de tarification échelonnée permet aux entreprises d'aligner leurs besoins d'automatisation sur le bon niveau de coût, ce qui les aide à allouer les ressources de manière efficace à mesure que leurs besoins augmentent et évoluent.

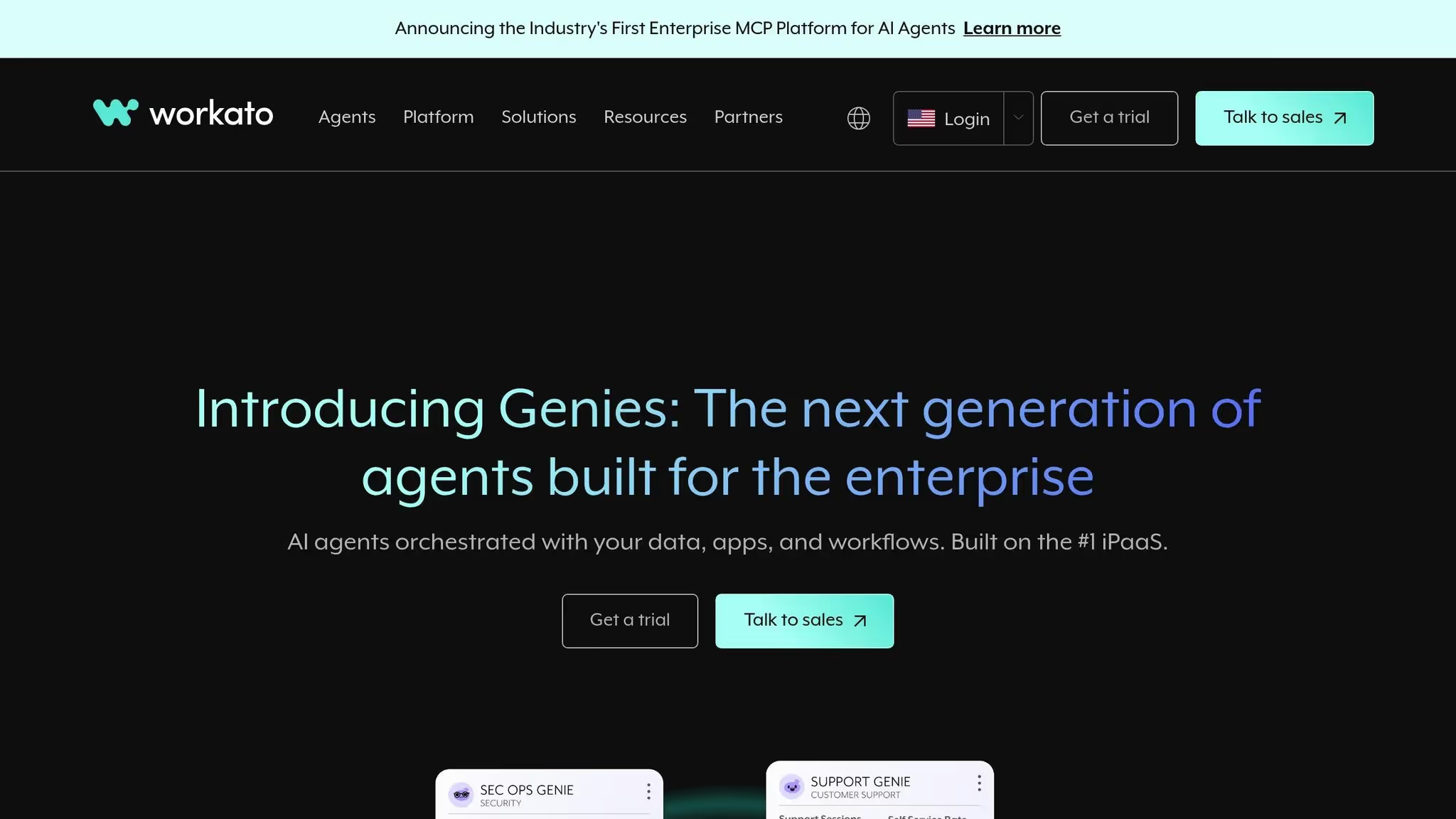

Workato se présente comme plateforme d'automatisation de niveau entreprise, conçu pour répondre aux demandes des organisations qui gèrent des flux de travail d'IA complexes à grande échelle. Au lieu de niveaux de tarification standard, Workato propose une tarification personnalisée, obligeant les entreprises à interagir directement avec leur équipe commerciale. Cette approche correspond à l'accent mis sur les déploiements à grande échelle, dont les coûts peuvent varier en fonction des besoins uniques de chaque organisation. Cette structure prend en charge les fonctionnalités avancées d'automatisation de l'IA de la plateforme, qui sont détaillées ci-dessous.

Workato intègre des fonctionnalités d'IA telles que l'analyse prédictive, la classification des documents et la révision humaine directement dans son moteur de flux de travail. Cela permet aux entreprises de créer des flux de travail automatisés sophistiqués qui incluent une supervision humaine en cas de besoin. La plateforme est particulièrement adaptée aux flux de travail en couches impliquant une logique complexe, ce qui la rend idéale pour les scénarios dans lesquels les décisions relatives à l'IA doivent être validées ou dans lesquels plusieurs modèles d'IA doivent collaborer au sein d'un seul processus.

Les équipes techniques peuvent concevoir des flux de travail qui intègrent des modèles d'apprentissage automatique pour classer les données, acheminer les documents en fonction de l'analyse de l'IA et déclencher des actions prédictives à l'aide de la reconnaissance des formes. Ces fonctionnalités font de Workato un choix judicieux pour les organisations qui gèrent Opérations de service client, systèmes de surveillance de la conformité ou flux de travail d'approvisionnement pilotés par l'IA, où la précision et la responsabilité sont essentielles.

Workato se distingue par ses capacités d'intégration robustes. Son vaste écosystème de connecteurs est particulièrement orienté vers applications de vente et de marketing, offrant des intégrations approfondies avec les plateformes CRM, les outils d'automatisation du marketing et les systèmes de business intelligence. Bien que cette approche serve efficacement les équipes de vente et de marketing des entreprises, elle réduit la portée de la plateforme par rapport à des outils d'automatisation plus généraux. Des connecteurs avancés pour des systèmes spécialisés sont disponibles, mais leur utilisation peut influencer les coûts globaux.

L'architecture de la plateforme prend en charge des flux de travail interfonctionnels qui couvrent plusieurs départements et systèmes. Professionnels de l'informatique et architectes d'intégration profitez de sa capacité à connecter en toute sécurité divers systèmes d'entreprise tout en respectant les normes de conformité. Workato gère également les transformations de données complexes et la logique de routage, qui sont souvent nécessaires dans les environnements d'entreprise.

Le modèle de tarification de Workato reflète son approche axée sur les entreprises, obligeant les organisations à établir un un investissement important. La tarification est déterminée par trois facteurs principaux : le nombre de tâches effectuées, l'utilisation de connecteurs avancés pour des systèmes spécialisés et le nombre d'utilisateurs accédant à la plateforme.

Ce modèle basé sur l'utilisation s'harmonise bien avec les stratégies budgétaires des entreprises pour les infrastructures critiques. Les entreprises sont facturées en fonction de leur utilisation réelle et de la complexité de leurs flux de travail, plutôt que d'un forfait mensuel. Pour les entreprises qui gèrent des flux de travail d'IA à volume élevé dans différents départements, cette structure peut fournir des coûts plus prévisibles. Cependant, l'investissement initial requis pour démarrer reste important.

Workato offre une gouvernance, des contrôles d'accès et une auditabilité robustes, essentiels pour les flux de travail impliquant des données sensibles ou des décisions commerciales critiques. Ses fonctionnalités de sécurité et ses outils de conformité sont conçus pour les organisations qui ont besoin d'une supervision stricte des processus automatisés. Les grandes équipes bénéficient de paramètres d'autorisation détaillés, qui leur permettent de contrôler qui peut créer, modifier ou exécuter des flux de travail spécifiques.

L'évolutivité est un autre point fort de la plateforme. Il prend en charge des flux de travail de plus en plus complexes à mesure que les besoins des entreprises évoluent, permettant des leaders de l'automatisation pour mettre en place des processus interservices sécurisés qui intègrent plusieurs systèmes. Les équipes informatiques et opérationnelles font souvent confiance à Workato pour gérer les chaînes d'approbation et les flux de travail financiers, où la gouvernance est une priorité absolue.

L'une des limites de la plateforme est sa nature exclusive, qui restreint la personnalisation du code en ligne et l'accès à des licences open source. Bien que ce compromis garantisse un support solide aux entreprises et une infrastructure gérée, il risque de ne pas intéresser les développeurs à la recherche de plus de flexibilité ou de solutions open source.

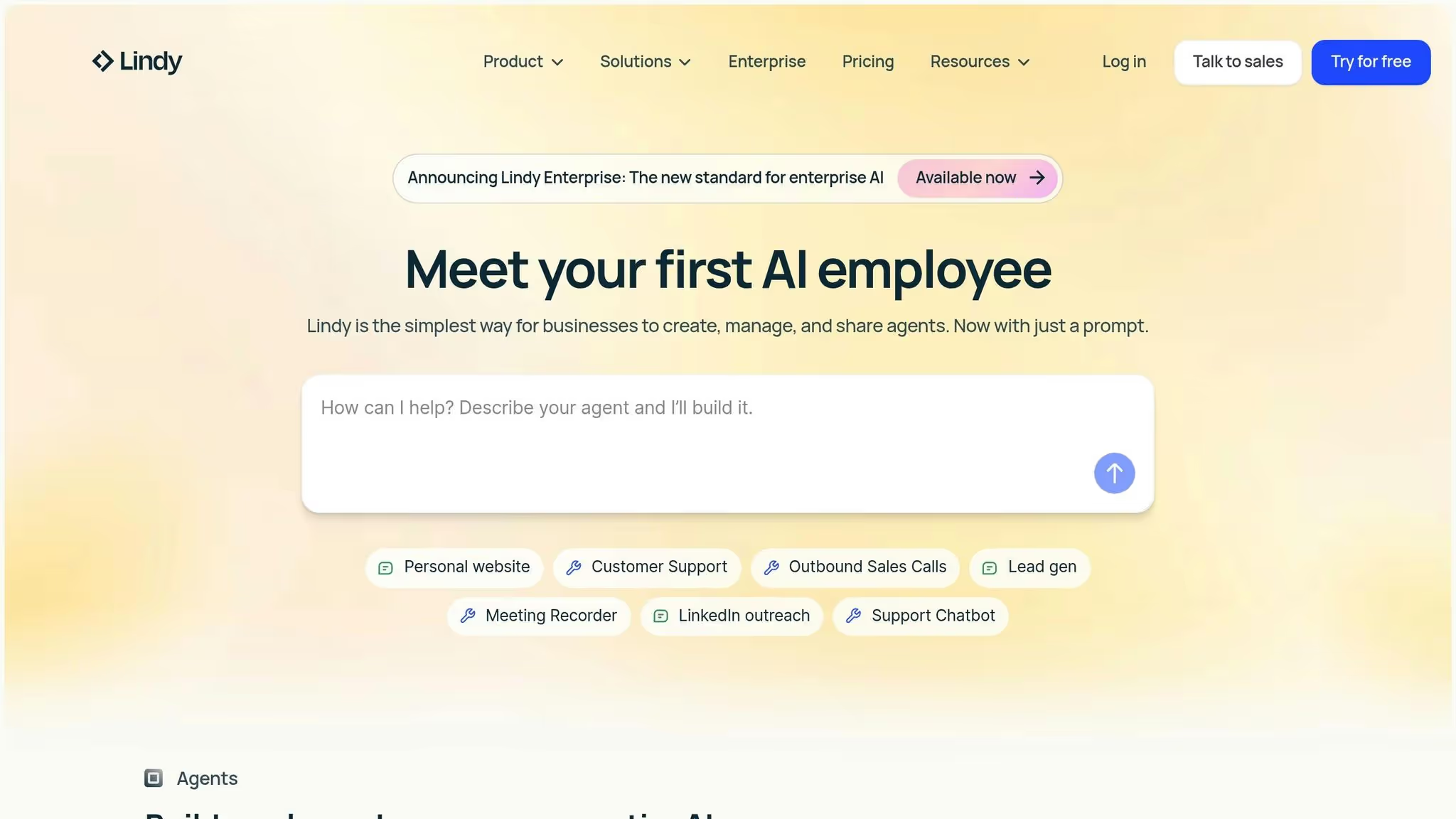

Lindy.ai est une plateforme spécialement conçue pour les entreprises qui cherchent à créer et à gérer une main-d'œuvre d'IA robuste. Contrairement aux outils de flux de travail traditionnels adaptés à l'IA, Lindy.ai a été conçu spécifiquement pour les agents d'IA. Il permet aux entreprises de créer, de déployer et de superviser de manière fluide des agents d'IA adaptés à des rôles dans les domaines du support, des ventes, du marketing et des opérations.

La caractéristique déterminante de la plateforme est la création d'agents sans code. Les utilisateurs peuvent décrire l'agent de leur choix en langage clair, et Lindy.ai convertit cette entrée en un agent entièrement fonctionnel en quelques minutes. Cette approche élimine les obstacles techniques, permettant même aux utilisateurs non techniques de déployer facilement des solutions d'IA. À partir de là, nous explorerons ses fonctionnalités exceptionnelles, ses capacités d'intégration, sa structure tarifaire et son évolutivité.

Lindy.ai propose des agents d'IA spécialisés conçus pour répondre à des besoins commerciaux distincts. Les utilisateurs peuvent choisir parmi une bibliothèque de modèles prédéfinis pour des tâches telles que l'assistance, la qualification des prospects, le marketing et la saisie de données. La conception indépendante du modèle de la plateforme permet aux utilisateurs de personnaliser davantage les agents simplement en fournissant des instructions en langage naturel. Chaque agent est également doté d'une base de connaissances consultable et prend en charge les interactions vocales via un agent vocal alimenté par l'IA. Des outils d'évaluation des performances sont inclus pour surveiller et optimiser les flux de travail des agents.

L'impact de la plateforme est évident dans les résultats obtenus dans le monde réel. Par exemple, TrueMed a réduit les coûts de support de 67 % grâce à un agent Lindy.ai qui a traité plus de 6 000 e-mails et gère désormais 36 % de tous les tickets d'assistance. Logiciel Ankor a déployé 30 agents d'IA, multipliant par 5 le retour sur investissement. De même, Le lieu du sauna économisé 15 à 20 heures par semaine, et DIRECTEUR FINANCIER DU CAPITAL-RISQUE a gagné 6 à 8 heures en arrière grâce à l'automatisation.

« Notre agent d'assistance gère désormais 36 % de tous les tickets d'assistance. » — Colin Budires, responsable du support, Truemed

Lindy.ai prend en charge des milliers d'intégrations, ce qui facilite la connexion aux outils professionnels existants. Ces intégrations permettent aux agents IA d'accéder aux données CRM, de répondre aux demandes, de qualifier les prospects et de mettre à jour les dossiers de manière fluide.

« Lindy fonctionne comme le SDR parfait : fiable, évolutif et totalement intégré à notre système de vente. » — John Nye, responsable du marketing, The Sauna Place

Lindy.ai propose une option d'inscription gratuite pour commencer. Bien que la tarification détaillée des forfaits payants ne soit pas divulguée publiquement, la plateforme utilise généralement un modèle de tarification personnalisé. Les coûts sont déterminés par des facteurs tels que le nombre d'agents déployés, les niveaux d'utilisation et les besoins spécifiques en matière de fonctionnalités.

Lindy.ai fournit des outils centralisés pour gérer et faire évoluer les agents d'IA au sein d'une organisation. Des contrôles d'accès stricts garantissent une gouvernance sécurisée, tandis que la plateforme est conforme aux principales normes telles que le RGPD, le SOC 2, l'HIPAA et la PIPEDA. Des fonctionnalités telles que l'intégration de machines virtuelles et les agents vocaux basés sur l'IA permettent une automatisation multimodale, permettant aux entreprises d'étendre leurs capacités d'IA sur différents canaux de communication et de constituer une main-d'œuvre IA complète.

Gumloop se distingue par sa plateforme visuellement intuitive, conçue pour simplifier la gestion des flux de travail basés sur l'IA tout en préservant l'accessibilité et l'efficacité.

Gumloop fonctionne comme un outil visuel d'automatisation des flux de travail, doté d'une interface basée sur des nœuds par glisser-déposer. Cette configuration permet aux utilisateurs de créer des flux de travail qui intègrent des modèles d'IA, le traitement des données et une logique métier, le tout sans avoir à écrire de code. Chaque nœud du flux de travail représente une tâche spécifique, telle que l'appel d'un modèle d'IA, le traitement de données ou le déclenchement d'un service externe. Cette structure claire facilite non seulement la compréhension des flux de travail, mais rationalise également le dépannage, ce qui en fait un outil précieux pour le prototypage rapide et le déploiement d'automatisations alimentées par l'IA.

Gumloop offre un accès direct à une variété de modèles d'IA dans son générateur de flux de travail, permettant aux utilisateurs d'intégrer le traitement du langage, l'analyse d'images et l'analyse des données dans leurs automatisations. La plateforme prend en charge l'utilisation de vos propres clés d'API, ce qui permet aux équipes de choisir leurs fournisseurs d'IA préférés et de gérer efficacement les coûts associés.

Le système basé sur des nœuds permet également des flux de travail complexes avec des fonctionnalités telles que la logique de branchement et le traitement conditionnel. Cela permet aux équipes d'acheminer les données en fonction des résultats de l'IA, de configurer des boucles de feedback pour des améliorations itératives ou d'exécuter plusieurs opérations d'IA simultanément, ce qui est parfait pour les projets qui doivent s'adapter et évoluer au fil du temps.

Gumloop s'intègre parfaitement aux outils et services professionnels les plus populaires via des webhooks et des API. Cela permet de déclencher des flux de travail à partir d'événements externes, d'envoyer les données traitées vers des feuilles de calcul ou des bases de données et d'intégrer les informations générées par l'IA dans les systèmes existants. Ces intégrations prennent en charge l'automatisation en temps réel, améliorant ainsi l'efficacité globale.

Gumloop utilise un modèle de tarification basé sur le crédit, dans lequel les coûts dépendent de la complexité de vos flux de travail. Le Forfait gratuit inclut 24 000 crédits par an, ce qui en fait un choix judicieux pour tester la plateforme ou gérer des automatisations de base. Pour des besoins plus avancés, le Forfait solo commence à 30$ par mois (facturé annuellement), offrant 120 000 crédits par an, des déclencheurs illimités, quatre exécutions simultanées, une assistance par e-mail, des webhooks et la possibilité d'utiliser vos propres clés d'API. Les prix évoluent en fonction de la complexité du flux de travail, comme sur des plateformes telles que Make, qui basent également les coûts sur l'utilisation.

Cependant, ce système basé sur le crédit peut rendre plus difficile la prévision des dépenses, car les coûts augmentent avec des automatisations plus complexes. Les utilisateurs doivent surveiller attentivement leur utilisation pour respecter leur budget.

Le plan Solo permet d'exécuter jusqu'à quatre flux de travail simultanément, ce qui peut limiter la capacité d'exécution des grandes équipes ou des projets plus exigeants. Les organisations doivent planifier en conséquence pour éviter les blocages. En outre, la fonctionnalité Bring-your-own-API-Keys permet aux entreprises de contrôler leurs fournisseurs de services d'IA et leurs dépenses, offrant ainsi une plus grande transparence et flexibilité dans la gestion des coûts. Cette fonctionnalité permet aux équipes d'aligner leur utilisation de l'IA sur les objectifs budgétaires tout en conservant le contrôle opérationnel.

Vellum.ai est spécialisé dans la création et le déploiement d'agents d'IA, ce qui en fait une plateforme incontournable pour les équipes qui souhaitent créer des solutions d'IA opérationnelles. En transformant les entrées en langage naturel en agents d'IA fonctionnels, il propose diverses options de développement pour répondre à différents niveaux d'expertise technique. Cette approche répond au besoin croissant d'outils qui simplifient et accélèrent la gestion des flux de travail basés sur l'IA.

La plateforme permet aux utilisateurs de décrire les exigences complexes des agents dans un anglais simple. À partir de là, il génère automatiquement la logique de flux de travail, les outils et les intégrations nécessaires pour donner vie à ces agents. Ce processus basé sur le langage naturel minimise le temps et le savoir-faire technique généralement nécessaires pour développer des systèmes d'IA avancés, ce qui permet aux professionnels occupant des postes divers de participer plus facilement à la création d'agents.

Vellum.ai propose trois méthodes distinctes pour créer des agents d'IA : saisie conversationnelle, interface visuelle low-code et codage direct. Cette flexibilité permet aux équipes de choisir la méthode qui correspond le mieux à leurs compétences techniques et aux besoins du projet.

La plateforme comprend une console de test pour le débogage en temps réel, ainsi qu'une surveillance après le lancement pour suivre les performances et identifier les domaines à améliorer. Ces outils créent une boucle de rétroaction continue, affinant les fonctionnalités des agents au fil du temps. Fonctions d'assurance qualité intégrées, telles que évaluations et suivi intégrés, assurez-vous que les agents maintiennent des performances constantes et signalent rapidement les écarts par rapport au comportement attendu. En outre, Vellum.ai favorise la collaboration en permettant aux équipes de partager et de gérer les déploiements d'agents de manière fluide.

L'une des caractéristiques les plus remarquables de Vellum.ai est sa flexibilité de déploiement. Les développeurs peuvent intégrer des agents directement dans les applications à l'aide de SDK ou d'appels d'API, ce qui leur permet de contrôler totalement l'expérience utilisateur. Pour un usage interne, les agents peuvent être publiés pour être accessibles à l'ensemble de l'équipe, ce qui permet aux départements d'utiliser l'IA sans développement personnalisé. Un outil de publication en un clic simplifie encore le processus, permettant aux équipes de partager rapidement des agents avec les utilisateurs finaux et de raccourcir le délai entre la création et le déploiement.

Vellum.ai est conçu pour répondre aux exigences de l'entreprise, offrant Conformité à la norme SOC 2 de type 2 et à la norme HIPAA pour les organisations des secteurs réglementés. Pour les entreprises ayant des exigences strictes en matière de résidence ou de sécurité des données, la plateforme prend en charge le cloud privé virtuel (VPC) et les options de déploiement sur site. Ces fonctionnalités garantissent que les déploiements d'IA à grande échelle restent sécurisés et conformes aux normes réglementaires.

L'architecture de la plateforme est conçue pour gérer la complexité des environnements d'entreprise, ce qui permet aux équipes informatiques de se concentrer plus facilement sur l'amélioration des fonctionnalités des agents plutôt que sur la gestion de l'infrastructure de déploiement. Cela permet aux organisations de faire évoluer leurs opérations d'IA de manière sécurisée et efficace.

La tarification de Vellum.ai est disponible sur demande, reflétant l'accent mis sur la fourniture de solutions personnalisées en fonction de l'échelle de déploiement et des besoins d'utilisation spécifiques de l'entreprise. Les entreprises intéressées par la plateforme sont invitées à contacter l'équipe commerciale pour obtenir des prix personnalisés adaptés à leurs besoins.

Make est une plateforme d'automatisation conçue pour les équipes techniques qui ont besoin d'un contrôle pratique des flux de travail d'IA. Grâce à son générateur de flux de travail visuel, les équipes peuvent créer des processus d'automatisation complexes via une simple interface glisser-déposer. Bien que la conception épurée du constructeur rationalise la création de flux de travail, la mise en place de scénarios plus avancés bénéficie souvent de la participation de spécialistes de l'automatisation.

L'une des caractéristiques les plus remarquables est le Grille, un tableau de bord centralisé qui fournit une vue complète des agents, des applications et des flux de travail. Cet outil améliore la visibilité en permettant aux équipes de suivre les indicateurs de performance et de résoudre les problèmes en toute simplicité. À mesure que les entreprises développent leurs opérations d'IA, la grille devient un outil essentiel pour gérer plusieurs flux de travail simultanément.

Make prend également en charge un nombre illimité de scénarios actifs sur ses forfaits payants, offrant un contrôle granulaire qui correspond à son objectif de gestion des flux de travail d'IA du début à la fin.

Make se connecte de manière fluide à une grande variété d'applications et de services, permettant aux équipes de créer des flux de travail couvrant plusieurs plateformes. Les forfaits payants incluent l'accès à l'API, permettant aux développeurs de gérer des scénarios par programmation et d'intégrer l'automatisation aux systèmes existants. Cette approche modulaire permet de créer des flux de travail complets qui fusionnent des outils commerciaux traditionnels avec des solutions pilotées par l'IA.

Pour les organisations ayant des besoins de sécurité stricts, Make fournit un contrôle d'accès limité basé sur les rôles. Cependant, ses fonctionnalités de gestion des secrets ne sont pas aussi robustes que certains pourraient l'exiger. L'évolutivité de la plateforme est soutenue par un système de crédit, mais son modèle de tarification par étape exige un suivi attentif afin d'éviter des coûts imprévus liés à la complexité croissante des flux de travail.

Make propose un plan gratuit qui inclut 1 000 crédits par mois, permettant aux équipes d'explorer ses capacités. Le plan Core commence à 9$ par mois (facturé annuellement) et offre 10 000 crédits par mois, des scénarios actifs illimités, des limites de transfert de données plus élevées et un accès à l'API. La facturation annuelle permet notamment d'accéder immédiatement aux crédits de l'année complète plutôt que de les distribuer tous les mois. Les crédits sont consommés par action, les tâches d'IA nécessitant souvent plusieurs crédits. Les organisations doivent évaluer avec soin leur utilisation prévue afin de gérer les coûts de manière efficace. Comme les autres plateformes de ce secteur, Make met l'accent à la fois sur le contrôle opérationnel et la transparence des coûts pour aider les équipes à gérer efficacement leurs flux de travail d'IA.

Relay.app apporte une nouvelle perspective à la gestion des flux de travail liés à l'IA en se concentrant sur la création d'agents d'IA qui collaborent directement avec des équipes humaines. Grâce à cette plateforme, les utilisateurs peuvent concevoir des équipes pilotées par l'IA pour les opérations commerciales grâce à des instructions en langage naturel. Décrivez simplement la tâche et le calendrier, et Relay.app générera l'agent IA pour la gérer. Cette approche met en évidence l'accent mis par la plateforme sur l'intégration des humains dans le processus d'IA.

L'une des caractéristiques les plus remarquables de Relay.app est sa l'humain au courant capacité, ce qui le distingue des systèmes entièrement automatisés. Cette fonctionnalité permet aux équipes d'intégrer des points de contrôle manuels dans les flux de travail de l'IA. Ces points de contrôle permettent l'implication humaine, par exemple en examinant les tâches, en approuvant des actions ou en attribuant des responsabilités, avant que l'IA ne poursuive son travail.

« Le modèle « humain dans la boucle » de Relay est très efficace pour les équipes. Non seulement c'est l'interface utilisateur la mieux conçue du marché pour l'automatisation des bâtiments, mais ils ont vraiment réfléchi à la façon dont tout ne peut pas être automatisé. C'est fantastique pour créer des SOP opérationnelles. »

Les agents d'IA de Relay.app sont équipés pour gérer diverses tâches, notamment la recherche, l'analyse, la synthèse, l'extraction d'informations, la prise de décision et la rédaction. La plateforme s'intègre parfaitement aux principaux fournisseurs de modèles d'IA tels que Anthropique, Google Gémeaux, Croissance, Mistral, IA ouverte, Perplexité, Qwen, et Axe I.

Pour rationaliser la mise en œuvre, Relay.app propose des modèles prédéfinis adaptés à des besoins spécifiques. Par exemple :

Ces modèles réduisent considérablement le temps nécessaire au déploiement d'agents d'IA pour les tâches commerciales courantes.

Relay.app se connecte à un large éventail d'outils pour améliorer ses fonctionnalités :

Un exemple pratique de ses capacités d'intégration a été présenté par Lucas Grey, qui a utilisé GPT dans un flux de travail Relay.app pour traiter les réponses aux questions posées par e-mail sur les listes d'attente et les stocker automatiquement dans une base de données Notion. Relay.app prend également en charge des outils de transcription tels que Fireflies.ai, Fathom, et Gong, ainsi que des services de web scraping tels que Apifier, Axiom.ai, Browse.ai, et Abeille à gratter.

Le modèle « human in-the-loop » de Relay.app garantit que les équipes gardent le contrôle des processus pilotés par l'IA. Cette approche fournit une gouvernance intégrée, permettant aux humains de revoir les décisions critiques tout en automatisant les tâches répétitives. Les équipes peuvent suspendre les automatisations, demander des informations supplémentaires ou attribuer des tâches selon les besoins, en trouvant un équilibre entre efficacité et supervision.

Relay.app propose un plan gratuit, ce qui en fait un excellent point de départ pour les équipes qui expérimentent l'automatisation des flux de travail par IA. Bien que les détails des prix pour les niveaux supérieurs ne soient pas encore précisés, la structure est conçue pour accueillir à la fois les petites équipes testant les capacités de l'IA et les grandes organisations qui étendent leurs opérations. Les équipes peuvent évaluer leur utilisation pour déterminer le plan le plus adapté.

Le choix de la bonne plateforme de flux de travail d'IA dépend de facteurs tels que les performances, l'évolutivité, les capacités d'intégration, les coûts et la gouvernance. Ci-dessous, nous décrivons les points forts et les défis de chaque plateforme, en résumant leurs caractéristiques et limites remarquables pour vous aider à prendre une décision éclairée.

prompts.ai est conçu pour les organisations qui gèrent plusieurs modèles d'IA, offrant une intégration transparente avec plus de 35 grands modèles de langage (LLM). Son système de crédit TOKN à paiement à l'utilisation élimine les frais d'abonnement, aligne les coûts sur l'utilisation réelle et réduit les dépenses liées à l'IA jusqu'à 98 %. Les utilisateurs bénéficient d'un suivi des coûts en temps réel, de comparaisons des performances des modèles et d'outils de gouvernance qui garantissent la conformité entre les équipes. Cependant, les équipes qui découvrent l'orchestration de l'IA peuvent être confrontées à une courbe d'apprentissage. Pour faciliter cela, prompts.ai propose une intégration pratique, une formation en entreprise et un programme rapide de certification des ingénieurs pour développer l'expertise.

n8n attire les organisations qui donnent la priorité au contrôle et à la personnalisation des données grâce à son framework open source auto-hébergé. Il permet aux équipes de gérer entièrement leur infrastructure et d'adapter les flux de travail à des besoins spécifiques. Son générateur de flux de travail visuel rend l'automatisation accessible même aux non-développeurs, et la plateforme prend en charge des centaines d'intégrations. Cependant, l'auto-hébergement nécessite une maintenance technique continue, ce qui peut représenter un défi pour les équipes qui ne disposent pas de ressources DevOps dédiées.

Zapier est connu pour sa simplicité et sa rapidité d'installation, ce qui le rend idéal pour les utilisateurs non techniques. Son vaste écosystème d'applications et ses « Zaps » prédéfinis permettent aux équipes d'automatiser les flux de travail en quelques minutes. Bien qu'elle soit idéale pour les tâches à petite échelle, les coûts peuvent augmenter de manière significative en cas de volumes de tâches élevés, et la gestion de flux de travail complexes peut devenir coûteuse.

Travaillez à cible les utilisateurs professionnels ayant des besoins d'intégration avancés. Il excelle dans la gestion des transformations de données complexes, la gestion des API et les exigences de conformité. Son système basé sur des recettes permet aux équipes de créer des flux de travail complexes sur plusieurs systèmes. Cependant, la maîtrise de la plateforme prend du temps et sa tarification la rend moins accessible aux petites équipes ayant des besoins plus simples.

Lindy.ai se concentre sur la création d'agents d'IA qui effectuent des tâches spécifiques en fonction d'instructions en langage naturel. Cela en fait un excellent choix pour les équipes qui cherchent à déployer rapidement l'IA pour des tâches telles que le support client ou la planification. Cependant, ses capacités sont limitées lorsqu'il s'agit de flux de travail hautement personnalisés ou de besoins d'automatisation plus larges.

Gumloop propose une interface glisser-déposer intuitive pour la conception de flux de travail visuels. Il simplifie la connexion des modèles d'IA, des API et des sources de données sans avoir besoin de code, ce qui permet un prototypage rapide et des tests en temps réel. Cependant, en tant que plate-forme plus récente, sa bibliothèque d'intégration continue de croître et la documentation pour les cas d'utilisation avancés est limitée par rapport aux outils plus établis.

Vellum.ai est conçu pour les équipes spécialisées dans le développement d'applications LLM. Il fournit des outils pour une ingénierie rapide, un contrôle de version, des tests A/B et des analyses détaillées. Bien qu'il soit excellent pour le développement de produits alimentés par l'IA, il convient moins à l'automatisation commerciale générale ou aux équipes qui cherchent à connecter des applications existantes.

Fabriquer (anciennement Integromat) fournit une automatisation puissante avec un contrôle détaillé du flux de données. Son générateur de scénarios fournit une visibilité sur chaque étape d'un flux de travail, et son modèle de tarification basé sur les opérations peut être rentable pour les automatisations complexes. Cependant, la profondeur technique et les fonctionnalités de la plate-forme, telles que les routeurs et les itérateurs, nécessitent une courbe d'apprentissage plus abrupte par rapport à des outils plus simples tels que Zapier.

Relay.app se distingue par ses flux de travail intégrés à l'humain, qui associent l'automatisation de l'IA à une supervision manuelle. Cela permet aux équipes d'insérer des points de contrôle où les humains peuvent revoir ou rediriger les actions de l'IA, garantissant ainsi la gouvernance pour les décisions sensibles. Bien que cette approche améliore le contrôle, elle ralentit naturellement l'automatisation, ce qui peut ne pas convenir à tous les cas d'utilisation.

Des plateformes comme prompts.ai, Travaillez à, et Fabriquer répondre aux déploiements à l'échelle de l'entreprise, en offrant une gouvernance et des pistes d'audit solides. D'autre part, des outils tels que Zapier et Relay.app sont mieux adaptés aux petites équipes, bien qu'ils puissent nécessiter des ajustements pour les opérations à plus grande échelle. n8n offre une évolutivité illimitée, mais uniquement si vous pouvez gérer vous-même l'infrastructure.

Les options d'intégration varient considérablement. Zapier possède le plus grand écosystème d'applications, suivi par Fabriquer et Travaillez à. prompts.ai se concentre sur l'intégration de modèles d'IA, offrant un accès à un large éventail de modèles linguistiques. Des plateformes spécialisées comme Vellum.ai et Lindy.ai proposent moins d'intégrations mais excellent dans leurs domaines d'intervention respectifs.

La gouvernance est essentielle pour les secteurs réglementés. prompts.ai intègre des outils de conformité de niveau entreprise à chaque flux de travail, tout en Travaillez à offre des fonctionnalités de sécurité robustes. Auto-hébergé n8n fournit un contrôle total sur le traitement des données. En revanche, des plateformes comme Zapier et Fabriquer fournissent une sécurité de base mais ne disposent pas des fonctionnalités de gouvernance avancées requises par les entreprises.

Enfin, les structures de coûts peuvent avoir un impact significatif sur la viabilité à long terme. prompts.aiLe modèle de paiement à l'utilisation vous garantit de ne payer que ce que vous utilisez, évitant ainsi des frais d'abonnement inutiles. Des plateformes comme Zapier et Fabriquer facturation basée sur le volume de tâches, ce qui peut devenir coûteux pour les utilisateurs à volume élevé. Travaillez àLa tarification reflète ses capacités au niveau de l'entreprise, tandis que n8n déplace les coûts vers l'infrastructure, qui peut être économique mais nécessite des investissements techniques.

Le choix de la plateforme de flux de travail d'IA idéale dépend de la compréhension de vos exigences uniques, de votre expertise technique et de vos objectifs futurs. Chaque plateforme apporte son lot d'avantages et de compromis, qu'il s'agisse de systèmes auto-hébergés garantissant le contrôle des données ou d'outils sans code donnant la priorité à la rapidité et à la simplicité. Ces différences sont souvent liées au coût, aux capacités d'intégration et aux fonctionnalités de gouvernance.

Des plateformes comme prompts.ai se distinguer grâce à une approche globale et unifiée. Pour les entreprises qui jonglent avec plusieurs modèles d'IA, prompts.ai regroupe plus de 35 LLM de premier plan en une seule interface sécurisée. Cette consolidation permet de résoudre des problèmes majeurs tels que les dépenses excessives et les flux de travail incohérents. Grâce à une tarification basée sur l'utilisation, elle évite les frais inutiles, tandis que ses outils de suivi des coûts et de gouvernance assurent transparence et contrôle. De plus, des programmes pratiques d'intégration et de certification aident les équipes à s'adapter rapidement et à acquérir les compétences nécessaires pour réussir sur le long terme.

Prompts.ai est doté d'un couche FinOps conçu pour aider les organisations à surveiller de près leurs coûts tout en optimisant les dépenses. Grâce à des informations en temps réel sur l'utilisation, les dépenses et le retour sur investissement (ROI), les entreprises peuvent faire des choix financiers plus éclairés.

En rationalisant la gestion des coûts sur une plateforme unique, Prompts.ai favorise la transparence et permet d'éviter les dépenses inutiles, même lorsque vous jonglez avec plusieurs modèles d'IA ou gérez des flux de travail complexes.

Prompts.ai donne la priorité à la sécurité et à la conformité au niveau de l'entreprise, en s'alignant sur des cadres clés tels que SOC 2 Type II, HIPAA, et GDPR. Ces normes sont en place pour protéger les données sensibles et renforcer la confiance des utilisateurs.

Pour garantir une supervision cohérente de la sécurité, Prompts.ai travaille avec Vanta pour la surveillance en temps réel de ses contrôles de sécurité. Le processus d'audit officiel du SOC 2 Type II a débuté le 19 juin 2025, démontrant une fois de plus leur engagement à respecter des normes de conformité rigoureuses. Ces efforts fournissent aux entreprises l'assurance dont elles ont besoin pour gérer les flux de travail d'IA de manière sécurisée et efficace.

Le Système de crédit TOKN sur Prompts.ai propose une solution simple, Payez à l'utilisation approche pour accéder aux services pilotés par l'IA, y compris la génération de texte, d'images, de vidéos, de sons et de musique. Au lieu d'obliger les utilisateurs à souscrire des abonnements récurrents, ce modèle garantit que vous ne payez que pour ce que vous utilisez réellement, ce qui le rend à la fois économique et adaptable aux besoins individuels.

Cette configuration fonctionne parfaitement pour les utilisateurs dont les demandes évoluent. Que vous soyez un créateur occasionnel ou une entreprise aux charges de travail changeantes, les crédits TOKN vous offrent la flexibilité nécessaire pour ajuster votre utilisation sans dépenser trop pour des fonctionnalités dont vous n'avez pas besoin.