La IA está transformando las empresas, pero también presenta riesgos graves. Para innovar de forma segura, las empresas deben proteger los datos confidenciales, evitar las infracciones y cumplir con las normativas. Plataformas de IA seguras, como Prompts.ai, lo hacen posible al combinar funciones de seguridad avanzadas con una escalabilidad rentable.

Las herramientas de IA seguras no solo mitigan los riesgos, sino que permiten a las empresas innovar con confianza y, al mismo tiempo, proteger su activo más importante: los datos.

La IA empresarial ha revolucionado la forma en que operan las empresas, pero también presenta obstáculos de seguridad únicos que los sistemas de TI tradicionales no están equipados para manejar. Para proteger el progreso y la innovación, las organizaciones deben abordar estos desafíos de manera frontal.

Una de las principales preocupaciones de la IA empresarial es la posibilidad de exposición de los datos. Los sistemas de IA prosperan con grandes cantidades de datos, que a menudo provienen de varios departamentos, bases de datos e incluso fuentes externas. Esto crea una red de vulnerabilidades en las que la información confidencial podría estar en riesgo.

Acceso no autorizado es una amenaza importante. Cuando las herramientas de inteligencia artificial tienen permisos amplios, pueden ofrecer inadvertidamente oportunidades de explotación. Una sola brecha de seguridad podría exponer simultáneamente los registros de los clientes, los datos financieros y la información empresarial exclusiva, lo que amplificaría el daño.

Otro problema es fuga de datos a través de las salidas del modelo. Los sistemas de IA pueden revelar involuntariamente información confidencial en sus respuestas o predicciones, especialmente cuando se entrenan con datos confidenciales. Esto se vuelve aún más riesgoso en entornos en los que los resultados son visibles para los usuarios que no deberían tener acceso a ellos.

Prácticas deficientes de manejo de datos también agravan estos riesgos. A medida que las organizaciones amplían sus proyectos de IA, muchas tienen dificultades para implementar una gobernanza de datos sólida. Sin una clasificación clara de los datos, unos controles de acceso sólidos y una supervisión continua, la información confidencial puede circular sin control por las canalizaciones de la IA.

La situación se vuelve aún más precaria con servicios de IA de terceros. Cuando los datos son procesados por proveedores externos, las organizaciones suelen perder visibilidad y control, lo que aumenta el riesgo de infracciones de cumplimiento y brechas de seguridad.

Los modelos de IA en sí mismos no son inmunes a la explotación. Los atacantes pueden atacar estos sistemas de formas que son exclusivas de la IA, creando nuevos niveles de vulnerabilidad.

Ataques adversarios implican introducir entradas manipuladas en un modelo para activar salidas incorrectas o dañinas. Estos ataques pueden interrumpir las operaciones, clasificar erróneamente los datos o incluso exponer información confidencial sobre el entrenamiento.

Otro riesgo es intoxicación modelo, donde los atacantes manipulan los datos de entrenamiento para alterar sutilmente el comportamiento de un modelo. Este tipo de ataque puede pasar desapercibido durante períodos prolongados, degradando gradualmente el rendimiento o incorporando capacidades malintencionadas.

Ataques de inferencia son otra preocupación. Al analizar los resultados de un modelo, los atacantes pueden extraer información sobre los datos de entrenamiento y, potencialmente, descubrir si se incluyeron personas o puntos de datos específicos. Esto supone un grave riesgo para la privacidad.

Robo de modelos es un problema cada vez mayor, ya que los atacantes utilizan diversas técnicas para aplicar ingeniería inversa a modelos de IA patentados. Para las empresas que han invertido mucho en soluciones de IA personalizadas, esto puede provocar la pérdida de propiedad intelectual y ventajas competitivas.

Por último, vulnerabilidades de la cadena de suministro en el desarrollo de la IA se añade otra capa de riesgo. Los modelos previamente entrenados, las bibliotecas de código abierto y los marcos de desarrollo pueden contener puertas traseras ocultas o fallas que los atacantes pueden aprovechar una vez que se implementan los sistemas.

Navegar por el cumplimiento normativo se vuelve mucho más difícil con la IA en juego. Los marcos existentes suelen tener dificultades para abordar las complejidades de los sistemas de IA, lo que deja a las organizaciones interpretar y adaptarse por sí mismas.

Por ejemplo, GDPR introduce requisitos estrictos para la protección de datos, el consentimiento y el «derecho a la explicación» para las decisiones automatizadas. Los sistemas de IA deben tener en cuenta estos derechos y, al mismo tiempo, ofrecer resultados eficientes.

En el ámbito de la salud, Cumplimiento de la HIPAA exige una protección rigurosa de los datos médicos. Los sistemas de IA que procesan la información médica protegida (PHI) deben cumplir los mismos estándares estrictos que los sistemas de salud tradicionales, lo que puede resultar difícil dada la complejidad de los flujos de trabajo de la IA.

SOC 2 conformidad exige que las organizaciones mantengan un control estricto sobre la seguridad, la disponibilidad y la confidencialidad de los datos durante todo el ciclo de vida de los datos. Los sistemas de IA, con sus intrincadas operaciones en múltiples conjuntos de datos, dificultan la aplicación de estos controles.

Las diferentes industrias también enfrentan sus propios obstáculos regulatorios únicos. Por ejemplo, las instituciones financieras deben cumplir con PCI DSS para los datos de pago, mientras que los contratistas gubernamentales deben cumplir con FISMA. Los sistemas de IA deben diseñarse para cumplir con estos estándares específicos, que pueden variar significativamente.

Requisitos de registro de auditoría son otro punto conflictivo. Muchos marcos de cumplimiento requieren registros detallados de las actividades de procesamiento y acceso a los datos. Los sistemas de IA suelen realizar tareas complejas en varias plataformas, lo que dificulta el mantenimiento de los registros detallados necesarios para cumplir con estas normativas.

Las organizaciones globales se enfrentan a complicaciones adicionales con normas de transferencia de datos transfronteriza. Los diferentes requisitos de localización y transferencia de datos entre países dificultan la implementación de sistemas de IA que funcionen sin problemas en todas las jurisdicciones sin dejar de cumplir con las normas.

A la complejidad se suma la ausencia de una orientación normativa clara específica para la IA en muchas industrias. Sin reglas explícitas, las organizaciones deben interpretar las regulaciones existentes y desarrollar sus propias estrategias para gestionar los riesgos relacionados con la IA, a menudo sin una dirección clara por parte de los órganos de gobierno.

La creación de sistemas de IA seguros implica un equilibrio cuidadoso entre la protección de los activos y el mantenimiento de operaciones eficientes. Las organizaciones deben adoptar estrategias prácticas que aborden las amenazas modernas y, al mismo tiempo, permitan a los equipos innovar con confianza.

La confianza cero se basa en el principio de que ningún usuario, dispositivo o sistema es intrínsecamente confiable. Esto adquiere especial importancia cuando los sistemas de IA interactúan con múltiples fuentes de datos en entornos distribuidos.

Estas medidas establecen un marco seguro, reforzado aún más por técnicas de cifrado y anonimización.

Una vez que se implementa una verificación de identidad sólida, es esencial proteger los datos durante su viaje y en reposo. El cifrado y la anonimización protegen la información confidencial en cada etapa de los flujos de trabajo de la IA.

Con los controles de acceso y la protección de datos establecidos, aprovechar la IA para la detección de amenazas mejora la resiliencia frente a los ataques en evolución. Las herramientas de seguridad impulsadas por la inteligencia artificial brindan una protección adaptable y eficiente.

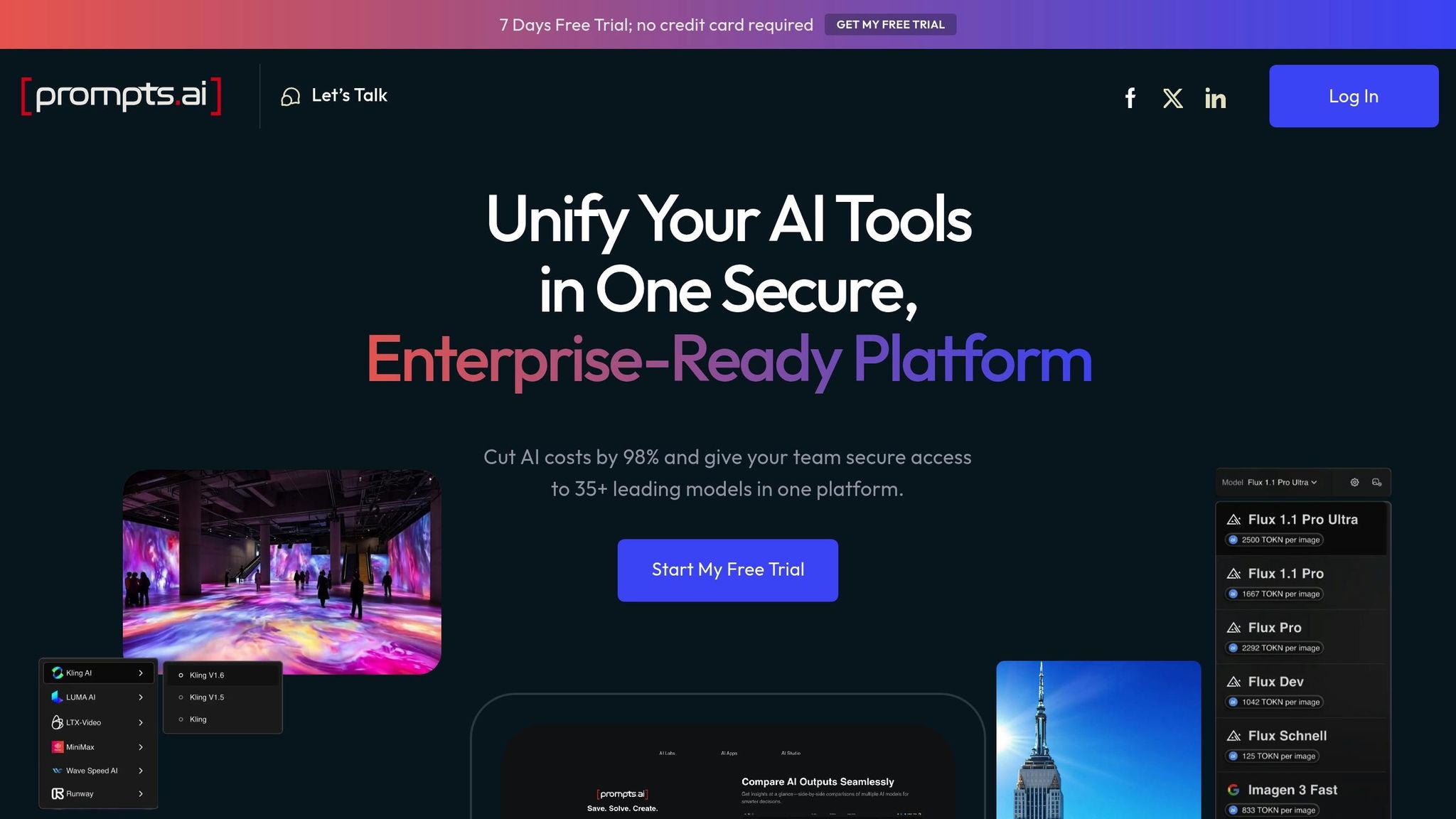

Las empresas se enfrentan a desafíos cada vez mayores para mantener la seguridad y, al mismo tiempo, escalar las operaciones de IA. Prompts.ai aborda estos problemas al combinar medidas de seguridad de primer nivel con operaciones optimizadas, lo que permite a las organizaciones implementar los flujos de trabajo de inteligencia artificial con confianza sin sacrificar la protección de los datos. Este enfoque crea un marco unificado para administrar los flujos de trabajo de inteligencia artificial de manera eficiente.

La gestión de varios modelos de IA en varios equipos suele generar brechas de seguridad y problemas de cumplimiento. Prompts.ai simplifica esta tarea al reunir los principales modelos lingüísticos de gran tamaño en una plataforma única y segura que aplica políticas de gobierno coherentes.

Con este sistema centralizado, los equipos de seguridad ya no necesitan hacer malabares con múltiples herramientas y suscripciones. En cambio, obtienen una visibilidad total de todas las actividades de la IA a través de registros de auditoría detallados que supervisan el uso del modelo, el acceso a los datos y las acciones de los usuarios. Esta transparencia facilita la detección de comportamientos inusuales y la respuesta rápida a posibles amenazas.

Los controles de acceso basados en funciones añaden otra capa de protección al garantizar que los miembros del equipo solo interactúen con modelos y datos relevantes para sus funciones. Por ejemplo, los equipos de marketing pueden acceder a los modelos de análisis de clientes, mientras que los científicos de datos tienen permisos más amplios para la experimentación. Estos permisos personalizados ayudan a minimizar el riesgo de exposición accidental de los datos y, al mismo tiempo, mantienen la flexibilidad operativa.

Además, la plataforma aplica políticas coherentes en todos los flujos de trabajo para cumplir con normativas como el RGPD y la HIPAA. Esto no solo garantiza el cumplimiento, sino que también reduce la carga administrativa que supone gestionar varios requisitos reglamentarios.

Prompts.ai presenta un sistema de pago por uso que utiliza créditos TOKN, que ofrece una forma transparente y flexible de gestionar los costos. Al alinear los gastos directamente con el uso y eliminar las tarifas de suscripción recurrentes, las organizaciones pueden reducir los costos del software de inteligencia artificial hasta en un 98%. De este modo, se liberan recursos para otras prioridades, en lugar de verse limitados por los costes de las licencias.

Los equipos de finanzas y TI se benefician de los controles FinOps en tiempo real, que proporcionan información inmediata sobre los patrones de gasto. Estas herramientas les permiten establecer límites de gasto, monitorear las tendencias de uso e identificar oportunidades de ahorro de costos sin tener que esperar a que lleguen los ciclos de facturación de fin de mes. Este enfoque proactivo garantiza una mejor asignación de los recursos y ayuda a prevenir gastos inesperados.

El sistema de crédito también permite un escalamiento rápido durante los picos de carga de trabajo o proyectos especiales, lo que elimina la necesidad de largos procesos de adquisición. Al combinar la rentabilidad con la flexibilidad operativa, los equipos pueden escalar sus operaciones de IA de forma fluida y segura.

La implementación efectiva y segura de la IA requiere profesionales capacitados que comprendan tanto la tecnología como sus riesgos. Prompts.ai satisface esta necesidad a través de programas de formación y recursos comunitarios diseñados para promover prácticas de IA seguras.

El programa de certificación Prompt Engineer proporciona a los profesionales las habilidades necesarias para crear flujos de trabajo de IA seguros y efectivos. Los participantes aprenden a mitigar los riesgos, como la inyección inmediata, a gestionar los datos confidenciales de manera responsable y a diseñar flujos de trabajo que mantengan registros de auditoría exhaustivos.

Para agilizar la implementación, están disponibles flujos de trabajo rápidos diseñados por expertos. Estas plantillas probadas previamente incorporan medidas de seguridad desde el principio, lo que permite a los equipos iniciar flujos de trabajo rápidamente sin introducir vulnerabilidades.

Prompts.ai también fomenta una comunidad colaborativa en la que los ingenieros certificados pueden compartir conocimientos y trabajar juntos en proyectos. Esta experiencia compartida ayuda a integrar las prácticas centradas en la seguridad en las operaciones diarias, lo que garantiza un entorno de IA más seguro para todos los usuarios.

Al seleccionar una plataforma de IA, es crucial evaluar las opciones en función de la seguridad, el cumplimiento, el costo, la escalabilidad y la integración. La alineación de estos factores con las necesidades de su organización ayuda a evitar errores costosos y garantiza una implementación exitosa.

A continuación se detallan las áreas clave que debe tener en cuenta durante la evaluación.

Para identificar una plataforma que cumpla con sus objetivos operativos y de seguridad, concéntrese en estos factores críticos. Cada uno tiene un nivel de importancia diferente según las necesidades específicas de su organización y su tolerancia al riesgo.

Arquitectura de seguridad y protección de datos debe ser tu máxima prioridad. Una plataforma sólida utilizará un modelo de seguridad de confianza cero, que garantizará que los datos estén cifrados tanto en tránsito como en reposo. También debe proporcionar controles de acceso granulares para los usuarios, los equipos y los proyectos, junto con una detección avanzada de amenazas para monitorear los patrones inusuales o las posibles infracciones.

Capacidades de cumplimiento y gobierno son esenciales para cumplir con las exigencias reglamentarias. Busque plataformas con registros de auditoría exhaustivos que registren las actividades de los usuarios, modelen las interacciones y el acceso a los datos. La compatibilidad con los principales marcos, como el RGPD, la HIPAA y el SOC 2, así como con las normativas específicas de la industria, es imprescindible.

Administración de costos y transparencia desempeñan un papel importante en la planificación del presupuesto. Los modelos de precios de pago por uso suelen ofrecer una mayor flexibilidad a las organizaciones con cargas de trabajo fluctuantes. Funciones como la visibilidad de los gastos en tiempo real y los controles presupuestarios pueden ayudar a evitar costos inesperados y a optimizar la asignación de recursos.

Escalabilidad y rendimiento son clave para garantizar que la plataforma pueda crecer con su negocio. Evalúe su capacidad para gestionar el aumento de las cargas de trabajo (escalado horizontal) y gestionar tareas complejas de inteligencia artificial (escalado vertical) sin sacrificar el rendimiento a medida que aumenta el uso.

Capacidades de integración y flujo de trabajo determine qué tan bien se adapta la plataforma a sus sistemas actuales. Compruebe la compatibilidad sólida de las API, los conectores prediseñados para las herramientas empresariales más comunes y las funciones de automatización del flujo de trabajo que optimizan las operaciones.

La siguiente tabla resume estos criterios y proporciona preguntas para guiar su evaluación:

Recursos de soporte y capacitación son otro factor fundamental para garantizar una aplicación sin tropiezos. La documentación de alta calidad, los programas de capacitación sólidos y un soporte técnico receptivo pueden marcar la diferencia. Las plataformas que ofrecen programas de certificación pueden ayudar a su equipo a adquirir la experiencia necesaria para una implementación de la IA segura y eficaz.

Para tomar una decisión informada, involucre a las partes interesadas de departamentos como seguridad, TI, finanzas y operaciones comerciales. Desarrolle un sistema de puntuación que priorice las necesidades únicas de su organización y considere la posibilidad de ejecutar proyectos piloto con las plataformas preseleccionadas para probar sus capacidades.

En última instancia, la plataforma adecuada logrará el equilibrio perfecto entre seguridad, funcionalidad y costo, y se adaptará a su caso de uso específico.

Más allá de integrar las funciones de seguridad en los sistemas de IA, fomentar una cultura sólida centrada en la seguridad mejora significativamente la protección. Este enfoque requiere una formación constante, una gobernanza adaptable y una detección proactiva de amenazas. Al incorporar estas prácticas en las operaciones diarias, las organizaciones pueden crear un entorno en el que la seguridad pase a ser algo natural.

La seguridad eficaz de la IA comienza con empleados bien informados. La formación regular y específica para cada función permite a los equipos reconocer los riesgos y aplicar las medidas de seguridad adecuadas para evitar las infracciones.

Adapte los programas de capacitación a las diferentes funciones dentro de la organización. Por ejemplo:

Los talleres prácticos en entornos sandbox brindan experiencia práctica. Estas sesiones permiten a los empleados practicar la identificación de comportamientos sospechosos de la IA, realizar pruebas para detectar vulnerabilidades, como los ataques por inyección inmediata, e implementar protocolos de seguridad. Este enfoque práctico garantiza que los equipos estén mejor equipados para reconocer y abordar las amenazas en situaciones del mundo real.

Las sesiones informativas de seguridad mensuales pueden mantener a los empleados informados sobre los últimos incidentes de seguridad de la IA y los riesgos emergentes. La incorporación de estudios de casos de su sector hace que estas actualizaciones sean más relevantes y prácticas.

Para que la formación sea atractiva, considera la gamificación. Desarrolle desafíos para su equipo, como identificar las vulnerabilidades en los flujos de trabajo de la IA o crear plantillas de mensajes seguras. Esto no solo hace que el aprendizaje sea agradable, sino que también fomenta la colaboración y una comprensión más profunda de las prácticas de seguridad.

Las evaluaciones periódicas y los ataques simulados ayudan a medir la eficacia de los programas de formación. Por ejemplo, ponga a prueba a los empleados con simulaciones de suplantación de identidad dirigidas a sistemas de inteligencia artificial o con intentos de ingeniería social destinados a extraer información confidencial. Usa los resultados para identificar las brechas y perfeccionar las estrategias de capacitación.

Las tecnologías de inteligencia artificial evolucionan rápidamente y, a menudo, superan los marcos de gobierno tradicionales. La adopción de un modelo de gobierno flexible garantiza que sus medidas de seguridad sigan siendo eficaces y estén alineadas con las amenazas actuales.

Programa revisiones trimestrales para actualizar las políticas de seguridad de la IA. Estas revisiones deben incluir a las partes interesadas clave de los equipos de seguridad, legales, de cumplimiento y empresariales para garantizar que las políticas sean prácticas y aplicables.

Las auditorías externas proporcionan una evaluación imparcial de sus medidas de seguridad. Realice auditorías exhaustivas todos los años y realice un seguimiento con revisiones específicas después de cambios importantes en el sistema o incidentes de seguridad. Los auditores externos pueden ofrecer información nueva e identificar las vulnerabilidades que los equipos internos podrían pasar por alto.

Desarrolle marcos de políticas flexibles que se adapten a las nuevas herramientas y casos de uso de IA. En lugar de reglas rígidas y anticuadas, cree directrices basadas en principios. Por ejemplo, establezca estándares de clasificación de datos que se apliquen automáticamente a cualquier modelo de IA nuevo, independientemente de su tecnología específica.

Los sistemas de monitoreo en tiempo real pueden garantizar el cumplimiento de las políticas de seguridad. Estas herramientas detectan las actividades inusuales, el acceso no autorizado a los datos y las desviaciones del protocolo, lo que permite responder más rápidamente a las posibles amenazas y, al mismo tiempo, reduce la carga para los equipos de seguridad.

Mantenga una documentación detallada de los procesos de gobierno, incluidas las actualizaciones de políticas, las evaluaciones de riesgos y los incidentes de seguridad. Este mantenimiento de registros tiene un valor incalculable durante las auditorías y ayuda a identificar los problemas recurrentes que pueden requerir cambios sistémicos.

El panorama de la seguridad de la IA cambia constantemente, con nuevas amenazas y vulnerabilidades que surgen con regularidad. Mantenerse informado y proactivo es clave para mantener defensas sólidas.

Participe en las iniciativas de todo el sector para acceder a la inteligencia de amenazas de manera oportuna. Participe en consorcios de seguridad de la IA, grupos de trabajo y redes de intercambio de información. Estas colaboraciones permiten a las organizaciones aprender de las experiencias de las demás y fortalecer las defensas colectivas.

Suscríbase a los canales de inteligencia de amenazas especializados que se centran en la seguridad de la inteligencia artificial y el aprendizaje automático. Estos recursos ayudan a su equipo a mantenerse actualizado sobre las tendencias de ataque y a perfeccionar las estrategias defensivas en consecuencia.

Aproveche las redes de expertos y los recursos comunitarios. Plataformas como Prompts.ai conectan a las organizaciones con ingenieros rápidos y especialistas en seguridad certificados que pueden ofrecer consejos prácticos para mitigar las amenazas más recientes.

Colabore con instituciones académicas o empresas de seguridad para obtener información temprana sobre las vulnerabilidades emergentes. Estas asociaciones a menudo conducen al acceso a herramientas e investigaciones de vanguardia.

Aliente a su equipo de seguridad a dedicar tiempo a la investigación y el desarrollo. Bríndeles oportunidades para que exploren nuevas herramientas, asistan a conferencias y experimenten con tecnologías emergentes en entornos controlados. Esta inversión en el aprendizaje continuo garantiza que su equipo esté preparado para afrontar nuevos desafíos.

Realice ejercicios de planificación de escenarios para prepararse para posibles incidentes de seguridad. Las simulaciones de sobremesa de ataques o filtraciones de datos específicos de la IA pueden revelar lagunas en sus estrategias de respuesta y ayudar a los equipos a practicar acciones coordinadas bajo presión.

Por último, vigile de cerca las novedades normativas que podrían afectar a los requisitos de seguridad de la IA. Mantenerse a la vanguardia de las nuevas leyes y obligaciones de cumplimiento ayuda a evitar infracciones costosas y refuerza la confianza de las partes interesadas.

Adoptar la IA en el mundo empresarial no significa elegir entre innovación y seguridad, sino encontrar soluciones que combinen ambas a la perfección. En esta guía se muestra cómo las herramientas de inteligencia artificial seguras pueden convertir las vulnerabilidades en puntos fuertes, lo que permite a las organizaciones aprovechar todo el potencial de la IA y, al mismo tiempo, mantener unos estándares estrictos de protección de datos y cumplimiento. Una base segura no solo mitiga los riesgos, sino que contribuye directamente a obtener mejores resultados empresariales.

Las organizaciones que dan prioridad a la seguridad desde el principio obtienen mejores resultados que las que la consideran una idea de último momento. Al implementar medidas de seguridad sólidas desde el principio, las empresas no solo protegen la información confidencial, sino que también fomentan la innovación al fomentar la confianza entre las partes interesadas y evitar interrupciones costosas, como las violaciones de datos o los fallos de cumplimiento.

«Una cultura de seguridad de IA positiva replantea la seguridad como una ventaja estratégica, actuando como un catalizador para el crecimiento, la innovación y la mejora de la confianza de los clientes».

Cuando la seguridad pasa a formar parte de las operaciones diarias en lugar de convertirse en un obstáculo, los empleados pasan de ser posibles puntos débiles a convertirse en defensores proactivos contra las amenazas relacionadas con la IA. Este cambio cultural también ayuda a prevenir problemas como la «IA oculta», en la que el uso no autorizado y no gestionado de la IA crea riesgos ocultos.

Plataformas como Prompts.ai destacan cómo se puede lograr este equilibrio. Al combinar una seguridad de nivel empresarial con un importante ahorro de costes (por ejemplo, reducir los gastos en software de IA hasta en un 98% mediante créditos TOKN de pago por uso), las empresas pueden ampliar sus iniciativas de IA sin agobios financieros y, al mismo tiempo, mantener unos controles de seguridad sólidos.

La clave para una adopción exitosa de la IA radica en elegir herramientas que no obliguen a comprometer la funcionalidad y la protección. Las plataformas de IA modernas y seguras proporcionan una gestión de costes transparente, registros de auditoría detallados y marcos de gobierno adaptables, lo que permite a las empresas innovar con audacia sin dejar de cumplir con las normas.

A medida que la IA redefina las industrias, los líderes serán aquellos que vean la seguridad no como una limitación sino como la base de un crecimiento ambicioso. Las herramientas de IA seguras actúan como puente entre la experimentación cautelosa y una implementación segura y a gran escala, lo que permite a las empresas aprovechar el poder transformador de la IA y, al mismo tiempo, proteger los datos y la confianza que impulsan su éxito. Al integrar herramientas de IA seguras, las empresas pueden proteger sus operaciones e impulsar una innovación sostenida.

Prompts.ai permite a las empresas lograr el equilibrio perfecto entre protección de datos y progreso mediante la implementación de medidas de seguridad sólidas, incluido el cifrado de los datos tanto en tránsito como en reposo. Estas medidas de seguridad garantizan que la información confidencial permanezca segura en todas las etapas.

La plataforma también ofrece opciones de implementación en entornos seguros, como nubes privadas o redes periféricas, lo que minimiza las posibilidades de que se produzcan filtraciones de datos. Además, sus herramientas de cumplimiento automatizadas simplifican el cumplimiento de normativas como el RGPD y CCPA, lo que permite a las organizaciones avanzar con confianza y, al mismo tiempo, cumplir con los requisitos del sector.

Las empresas que se lanzan a la IA suelen enfrentarse a obstáculos como violaciones de datos, incumplimiento de la normativa, resultados sesgados o inexactos, y amenazas de actores malintencionados. Estos problemas pueden exponer información privada, interrumpir las operaciones y dañar la confianza de las partes interesadas.

Para hacer frente a estos desafíos, las empresas deben priorizar políticas sólidas de gobierno de datos, abraza un marco de seguridad de confianza cero, y manténgase alineado con las regulaciones aplicables. La formación de equipos interfuncionales para gestionar las iniciativas de inteligencia artificial puede mejorar aún más la seguridad y la responsabilidad. La integración directa de los protocolos de seguridad en los procesos de IA garantiza que los avances en la IA no pongan en peligro la seguridad de los datos confidenciales.

La arquitectura Zero Trust es un modelo de seguridad basado en la idea de «nunca confíes, verifica siempre». Funciona bajo el supuesto de que las amenazas potenciales pueden originarse tanto dentro como fuera de la red de una organización. Como resultado, exige una verificación continua para cada usuario, dispositivo y solicitud de acceso, sin dejar lugar a la confianza ciega.

Este enfoque es particularmente importante en los entornos empresariales impulsados por la IA, donde los datos confidenciales fluyen a través de numerosos puntos de acceso que cambian constantemente. Al adoptar la política de confianza cero, las organizaciones pueden reforzar la seguridad de los datos mediante rigurosos controles de identidad, reducir las posibles vulnerabilidades y responder a las amenazas en tiempo real. Estas prácticas ayudan a garantizar que, incluso si se produce una violación, sus daños estén contenidos, lo que permite a las empresas mantenerse seguras y eficientes mientras avanzan en sus iniciativas de inteligencia artificial.