AI उद्यमों को बदल रहा है, लेकिन यह गंभीर जोखिम भी पेश करता है। सुरक्षित रूप से नवाचार करने के लिए, व्यवसायों को संवेदनशील डेटा की सुरक्षा करनी चाहिए, उल्लंघनों को रोकना चाहिए और नियमों के अनुरूप रहना चाहिए। सुरक्षित AI प्लेटफ़ॉर्म, जैसे Prompts.ai, लागत प्रभावी स्केलिंग के साथ उन्नत सुरक्षा सुविधाओं को जोड़कर इसे संभव बनाएं।

सुरक्षित AI उपकरण न केवल जोखिमों को कम करते हैं - वे उद्यमों को अपनी सबसे महत्वपूर्ण संपत्ति: डेटा की सुरक्षा करते हुए आत्मविश्वास से नवाचार करने में सक्षम बनाते हैं।

एंटरप्राइज़ एआई ने व्यवसाय के संचालन के तरीके में क्रांति ला दी है, लेकिन यह अद्वितीय सुरक्षा बाधाएं भी लाता है जिन्हें संभालने के लिए पारंपरिक आईटी सिस्टम सुसज्जित नहीं हैं। प्रगति और नवाचार को सुरक्षित रखने के लिए, संगठनों को इन चुनौतियों का डटकर सामना करना चाहिए।

एंटरप्राइज़ एआई में प्राथमिक चिंताओं में से एक डेटा एक्सपोज़र की संभावना है। AI सिस्टम बड़ी मात्रा में डेटा पर पनपते हैं, जो अक्सर कई विभागों, डेटाबेस और यहां तक कि बाहरी स्रोतों से प्राप्त होते हैं। यह कमजोरियों का एक जाल बनाता है जहां संवेदनशील जानकारी खतरे में पड़ सकती है।

अनधिकृत पहुंच एक बड़ा खतरा है। जब AI टूल के पास व्यापक अनुमतियां होती हैं, तो वे अनजाने में शोषण के लिए अवसर प्रदान कर सकते हैं। एक सुरक्षा उल्लंघन ग्राहक रिकॉर्ड, वित्तीय डेटा और मालिकाना व्यावसायिक जानकारी को एक साथ उजागर कर सकता है, जिससे नुकसान बढ़ सकता है।

एक और मुद्दा यह है मॉडल आउटपुट के माध्यम से डेटा रिसाव। AI सिस्टम अनजाने में अपनी प्रतिक्रियाओं या भविष्यवाणियों में संवेदनशील जानकारी को प्रकट कर सकते हैं, खासकर जब गोपनीय डेटा पर प्रशिक्षित किया जाता है। यह उन वातावरणों में और भी जोखिम भरा हो जाता है, जहां आउटपुट उन उपयोगकर्ताओं को दिखाई देते हैं जिनके पास एक्सेस नहीं होना चाहिए।

खराब डेटा हैंडलिंग प्रथाएं इन जोखिमों को भी बढ़ाएँ। जैसे-जैसे संगठन अपनी AI परियोजनाओं को आगे बढ़ाते हैं, कई लोग मजबूत डेटा गवर्नेंस को लागू करने के लिए संघर्ष करते हैं। स्पष्ट डेटा वर्गीकरण, मजबूत पहुंच नियंत्रण और निरंतर निगरानी के बिना, संवेदनशील जानकारी AI पाइपलाइनों के माध्यम से अनियंत्रित रूप से प्रवाहित हो सकती है।

के साथ स्थिति और भी अनिश्चित हो जाती है तृतीय-पक्ष AI सेवाएँ। जब बाहरी प्रदाताओं द्वारा डेटा संसाधित किया जाता है, तो संगठन अक्सर दृश्यता और नियंत्रण खो देते हैं, जिससे अनुपालन उल्लंघन और सुरक्षा खामियों का खतरा बढ़ जाता है।

AI मॉडल स्वयं शोषण से प्रतिरक्षित नहीं हैं। हमलावर इन प्रणालियों को उन तरीकों से लक्षित कर सकते हैं जो AI के लिए अद्वितीय हैं, जिससे भेद्यता की नई परतें बनती हैं।

प्रतिकूल हमले गलत या हानिकारक आउटपुट को ट्रिगर करने के लिए एक मॉडल में हेरफेर किए गए इनपुट को फीड करना शामिल है। ये हमले ऑपरेशन को बाधित कर सकते हैं, डेटा को गलत तरीके से वर्गीकृत कर सकते हैं, या यहां तक कि संवेदनशील प्रशिक्षण जानकारी को उजागर कर सकते हैं।

एक और जोखिम है मॉडल विषाक्तता, जहां हमलावर किसी मॉडल के व्यवहार को सूक्ष्म रूप से बदलने के लिए प्रशिक्षण डेटा के साथ छेड़छाड़ करते हैं। इस प्रकार के हमले का लंबे समय तक पता नहीं चल सकता है, धीरे-धीरे प्रदर्शन को ख़राब कर सकता है या दुर्भावनापूर्ण क्षमताओं को एम्बेड किया जा सकता है।

अनुमान के हमले एक और चिंता का विषय हैं। किसी मॉडल के आउटपुट का विश्लेषण करके, हमलावर प्रशिक्षण डेटा के बारे में जानकारी निकाल सकते हैं, जिससे संभावित रूप से यह पता चल सकता है कि विशिष्ट व्यक्ति या डेटा बिंदु शामिल थे या नहीं। इससे गोपनीयता को गंभीर खतरा होता है।

मॉडल चोरी एक बढ़ता हुआ मुद्दा है, क्योंकि हमलावर मालिकाना एआई मॉडल को रिवर्स-इंजीनियर करने के लिए विभिन्न तकनीकों का उपयोग करते हैं। जिन कंपनियों ने कस्टम AI समाधानों में भारी निवेश किया है, उनके लिए इससे बौद्धिक संपदा का नुकसान हो सकता है और प्रतिस्पर्धात्मक लाभ हो सकते हैं।

आखिरकार, आपूर्ति श्रृंखला की कमजोरियाँ एआई विकास में जोखिम की एक और परत जोड़ें। पूर्व-प्रशिक्षित मॉडल, ओपन-सोर्स लाइब्रेरी, और डेवलपमेंट फ्रेमवर्क में छिपे हुए बैकडोर या खामियां हो सकती हैं जिनका सिस्टम तैनात होने के बाद हमलावर फायदा उठा सकते हैं।

मिश्रण में AI के साथ विनियामक अनुपालन को नेविगेट करना कहीं अधिक चुनौतीपूर्ण हो जाता है। मौजूदा फ़्रेमवर्क अक्सर AI सिस्टम की जटिलताओं को दूर करने के लिए संघर्ष करते हैं, जिससे संगठनों को अपने दम पर व्याख्या करने और उन्हें अनुकूलित करने के लिए छोड़ दिया जाता है।

उदाहरण के लिए, जीडीपीआर स्वचालित निर्णयों के लिए डेटा सुरक्षा, सहमति और “स्पष्टीकरण का अधिकार” के लिए सख्त आवश्यकताओं का परिचय देता है। कुशल परिणाम देते समय AI सिस्टम को इन अधिकारों का ध्यान रखना चाहिए।

स्वास्थ्य सेवा में, HIPAA अनुपालन चिकित्सा डेटा की कठोर सुरक्षा की मांग करता है। संरक्षित स्वास्थ्य जानकारी (PHI) को संसाधित करने वाले AI सिस्टम को पारंपरिक स्वास्थ्य देखभाल प्रणालियों के समान कड़े मानकों को पूरा करना चाहिए, जो AI वर्कफ़्लो की जटिलता को देखते हुए मुश्किल हो सकता है।

एसओसी 2 अनुपालन संगठनों को डेटा जीवनचक्र के दौरान डेटा सुरक्षा, उपलब्धता और गोपनीयता पर कड़ा नियंत्रण बनाए रखने की आवश्यकता होती है। AI सिस्टम, कई डेटासेट में अपने जटिल संचालन के साथ, इन नियंत्रणों को लागू करना कठिन बनाते हैं।

विभिन्न उद्योगों को भी अपनी अनूठी विनियामक बाधाओं का सामना करना पड़ता है। उदाहरण के लिए, वित्तीय संस्थानों को इसका पालन करना चाहिए पीसीआई डीएसएस भुगतान डेटा के लिए, जबकि सरकारी ठेकेदारों को इसका अनुपालन करना चाहिए फिस्मा। AI सिस्टम को इन विशिष्ट मानकों को पूरा करने के लिए डिज़ाइन किया जाना चाहिए, जो काफी भिन्न हो सकते हैं।

ऑडिट ट्रेल आवश्यकताएं एक और स्टिकिंग पॉइंट हैं। कई अनुपालन फ़्रेमवर्क के लिए डेटा एक्सेस और प्रोसेसिंग गतिविधियों के विस्तृत लॉग की आवश्यकता होती है। AI सिस्टम अक्सर विभिन्न प्लेटफार्मों पर जटिल कार्य करते हैं, जिससे इन नियमों को पूरा करने के लिए आवश्यक विस्तृत रिकॉर्ड बनाए रखना चुनौतीपूर्ण हो जाता है।

वैश्विक संगठनों को अतिरिक्त जटिलताओं का सामना करना पड़ता है सीमा पार डेटा अंतरण विनियम। देशों के बीच डेटा स्थानीयकरण और हस्तांतरण के लिए अलग-अलग आवश्यकताओं के कारण AI सिस्टम को लागू करना मुश्किल हो जाता है, जो अनुपालन करते हुए सभी अधिकार क्षेत्र में निर्बाध रूप से काम करते हैं।

जटिलता को जोड़ना यह है स्पष्ट एआई-विशिष्ट विनियामक मार्गदर्शन का अभाव कई उद्योगों में। स्पष्ट नियमों के बिना, संगठनों को मौजूदा नियमों की व्याख्या करनी चाहिए और एआई-संबंधित जोखिमों के प्रबंधन के लिए अपनी रणनीति विकसित करनी चाहिए, अक्सर शासी निकायों से स्पष्ट निर्देश के बिना।

सुरक्षित AI सिस्टम बनाने में परिसंपत्तियों की सुरक्षा और कुशल संचालन बनाए रखने के बीच सावधानीपूर्वक संतुलन बनाना शामिल है। संगठनों को ऐसी व्यावहारिक रणनीतियाँ अपनानी चाहिए जो आधुनिक खतरों का समाधान करती हैं और टीमों को आत्मविश्वास के साथ नवाचार करने के लिए सशक्त बनाती हैं।

जीरो ट्रस्ट इस सिद्धांत पर काम करता है कि कोई भी उपयोगकर्ता, डिवाइस या सिस्टम स्वाभाविक रूप से भरोसेमंद नहीं है। यह विशेष रूप से तब महत्वपूर्ण हो जाता है जब AI सिस्टम वितरित वातावरण में कई डेटा स्रोतों के साथ इंटरैक्ट करता है।

ये उपाय एक सुरक्षित ढांचा स्थापित करते हैं, जो एन्क्रिप्शन और अनामिकरण तकनीकों द्वारा और अधिक प्रबलित होता है।

एक बार मजबूत पहचान सत्यापन हो जाने के बाद, अपनी यात्रा के दौरान और आराम करते समय डेटा की सुरक्षा करना आवश्यक हो जाता है। एन्क्रिप्शन और अनामिकरण AI वर्कफ़्लो के हर चरण में संवेदनशील जानकारी को सुरक्षित रखते हैं।

पहुंच नियंत्रण और डेटा सुरक्षा के साथ, खतरे का पता लगाने के लिए AI का लाभ उठाने से उभरते हमलों के खिलाफ लचीलापन बढ़ता है। AI द्वारा संचालित सुरक्षा उपकरण अनुकूली और कुशल सुरक्षा प्रदान करते हैं।

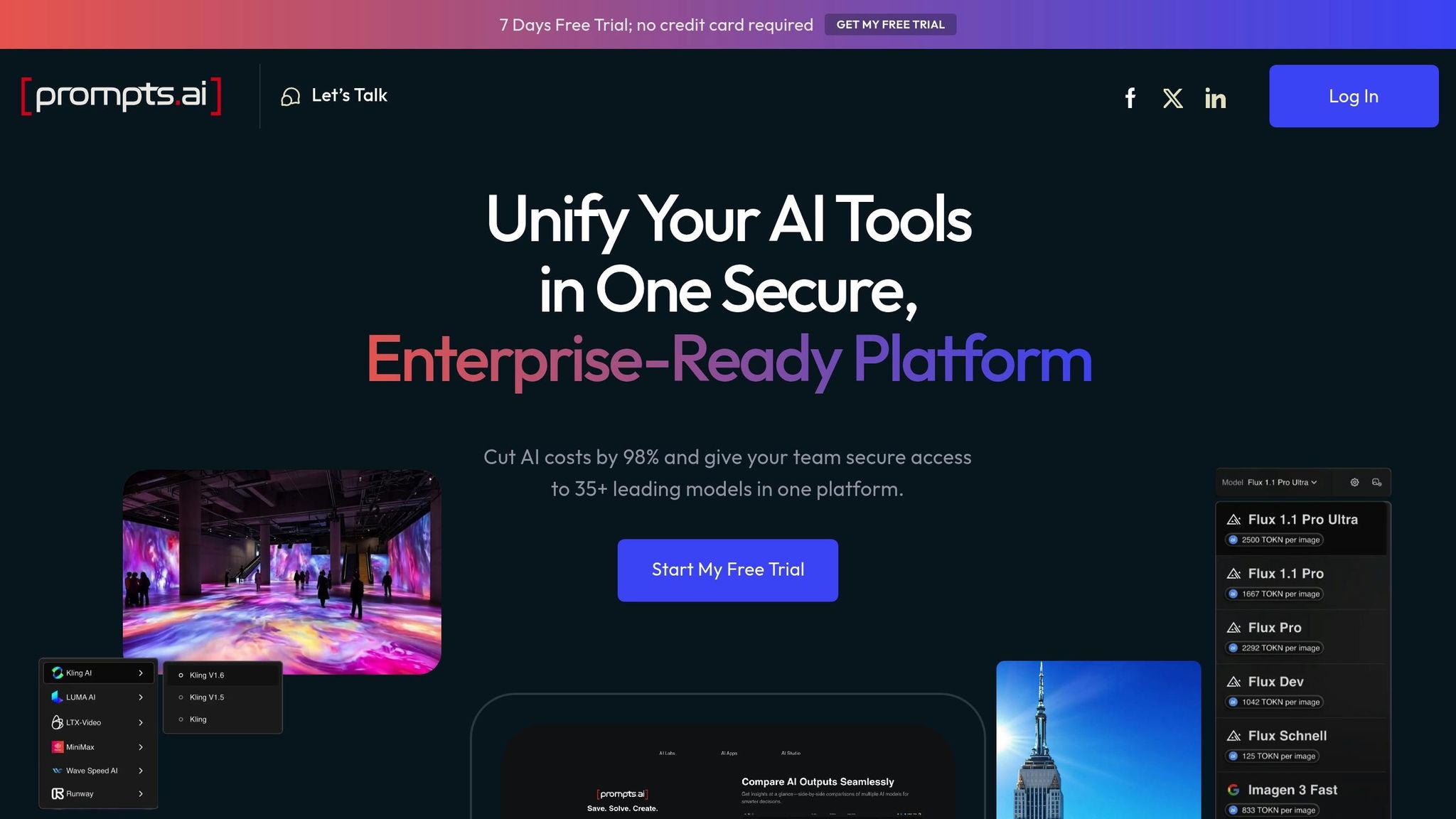

एआई परिचालन को बढ़ाने के दौरान सुरक्षा बनाए रखने में उद्यमों को बढ़ती चुनौतियों का सामना करना पड़ता है। Prompts.ai शीर्ष स्तरीय सुरक्षा उपायों को सुव्यवस्थित संचालन के साथ जोड़कर इन समस्याओं का समाधान करता है, जिससे संगठन डेटा सुरक्षा का त्याग किए बिना आत्मविश्वास से AI वर्कफ़्लो को लागू कर सकते हैं। यह दृष्टिकोण AI वर्कफ़्लो को कुशलतापूर्वक प्रबंधित करने के लिए एक एकीकृत ढांचा बनाता है।

विभिन्न टीमों में कई AI मॉडल को संभालने से अक्सर सुरक्षा खामियां और अनुपालन संबंधी सिरदर्द होते हैं। Prompts.ai प्रमुख बड़े भाषा मॉडल को एक एकल, सुरक्षित प्लेटफ़ॉर्म में लाकर इसे सरल बनाता है, जो सुसंगत शासन नीतियों को लागू करता है।

इस केंद्रीकृत प्रणाली के साथ, सुरक्षा टीमों को अब कई टूल और सब्सक्रिप्शन को हथकंडा करने की आवश्यकता नहीं है। इसके बजाय, वे विस्तृत ऑडिट ट्रेल्स के माध्यम से सभी AI गतिविधियों में पूरी दृश्यता प्राप्त करते हैं, जो मॉडल के उपयोग, डेटा एक्सेस और उपयोगकर्ता क्रियाओं की निगरानी करते हैं। इस पारदर्शिता से असामान्य व्यवहार का पता लगाना और संभावित खतरों का तुरंत जवाब देना आसान हो जाता है।

भूमिका-आधारित एक्सेस नियंत्रण यह सुनिश्चित करके सुरक्षा की एक और परत जोड़ते हैं कि टीम के सदस्य केवल अपनी भूमिकाओं से संबंधित मॉडल और डेटा के साथ इंटरैक्ट करें। उदाहरण के लिए, मार्केटिंग टीमें ग्राहक एनालिटिक्स मॉडल तक पहुंच सकती हैं, जबकि डेटा वैज्ञानिकों के पास प्रयोग के लिए व्यापक अनुमतियां हैं। ये अनुकूलित अनुमतियां परिचालन लचीलेपन को बनाए रखते हुए आकस्मिक डेटा जोखिम के जोखिम को कम करने में मदद करती हैं।

इसके अतिरिक्त, प्लेटफ़ॉर्म GDPR और HIPAA जैसे नियमों का अनुपालन करने के लिए सभी वर्कफ़्लो में सुसंगत नीतियां लागू करता है। यह न केवल अनुपालन सुनिश्चित करता है बल्कि कई विनियामक आवश्यकताओं के प्रबंधन के प्रशासनिक बोझ को भी कम करता है।

Prompts.ai TOKN क्रेडिट का उपयोग करके Pay-As-You-Go सिस्टम पेश करता है, जो लागतों को प्रबंधित करने के लिए एक पारदर्शी और लचीला तरीका प्रदान करता है। खर्चों को सीधे उपयोग के साथ जोड़कर और आवर्ती सदस्यता शुल्क को समाप्त करके, संगठन AI सॉफ़्टवेयर की लागत में 98% तक की कटौती कर सकते हैं। यह लाइसेंस की लागतों में बंधे रहने के बजाय अन्य प्राथमिकताओं के लिए संसाधनों को मुक्त करता है।

वित्त और आईटी टीमें रीयल-टाइम FinOps नियंत्रणों से लाभान्वित होती हैं, जो खर्च करने के पैटर्न में तत्काल जानकारी प्रदान करते हैं। ये उपकरण उन्हें महीने के अंत के बिलिंग चक्रों की प्रतीक्षा किए बिना खर्च सीमा निर्धारित करने, उपयोग के रुझानों की निगरानी करने और लागत-बचत के अवसरों की पहचान करने की अनुमति देते हैं। यह सक्रिय दृष्टिकोण बेहतर संसाधन आवंटन सुनिश्चित करता है और अप्रत्याशित खर्चों को रोकने में मदद करता है।

क्रेडिट सिस्टम पीक वर्कलोड या विशेष परियोजनाओं के दौरान तेजी से स्केलिंग का भी समर्थन करता है, जिससे लंबी खरीद प्रक्रियाओं की आवश्यकता दूर हो जाती है। परिचालन लचीलेपन के साथ लागत दक्षता को जोड़कर, टीमें अपने AI संचालन को सुचारू रूप से और सुरक्षित रूप से बढ़ा सकती हैं।

प्रभावी और सुरक्षित AI परिनियोजन के लिए कुशल पेशेवरों की आवश्यकता होती है जो प्रौद्योगिकी और इसके जोखिमों दोनों को समझते हैं। Prompts.ai सुरक्षित AI प्रथाओं को बढ़ावा देने के लिए डिज़ाइन किए गए प्रशिक्षण कार्यक्रमों और सामुदायिक संसाधनों के माध्यम से इस ज़रूरत को पूरा करता है।

प्रॉम्प्ट इंजीनियर सर्टिफिकेशन प्रोग्राम पेशेवरों को सुरक्षित और प्रभावी AI वर्कफ़्लो बनाने के कौशल से लैस करता है। प्रतिभागी सीखते हैं कि प्रॉम्प्ट इंजेक्शन जैसे जोखिमों को कैसे कम किया जाए, संवेदनशील डेटा को ज़िम्मेदारी से हैंडल किया जाए और ऐसे वर्कफ़्लो डिज़ाइन किए जाएं जो व्यापक ऑडिट ट्रेल्स को बनाए रखते हैं।

परिनियोजन को कारगर बनाने के लिए, विशेषज्ञ द्वारा डिज़ाइन किए गए प्रॉम्प्ट वर्कफ़्लो उपलब्ध हैं। इन पूर्व-परीक्षण किए गए टेम्प्लेट में शुरू से ही सुरक्षा उपाय शामिल होते हैं, जिससे टीमें कमजोरियों का सामना किए बिना जल्दी से वर्कफ़्लो लॉन्च कर सकती हैं।

Prompts.ai एक सहयोगी समुदाय को भी बढ़ावा देता है जहां प्रमाणित इंजीनियर ज्ञान साझा कर सकते हैं और परियोजनाओं पर एक साथ काम कर सकते हैं। यह साझा विशेषज्ञता सुरक्षा-केंद्रित प्रथाओं को रोज़मर्रा के कार्यों में एकीकृत करने में मदद करती है, जिससे सभी यूज़र के लिए सुरक्षित AI वातावरण सुनिश्चित होता है।

AI प्लेटफ़ॉर्म का चयन करते समय, सुरक्षा, अनुपालन, लागत, मापनीयता और एकीकरण के आधार पर विकल्पों का मूल्यांकन करना महत्वपूर्ण है। इन कारकों को अपने संगठन की ज़रूरतों के साथ संरेखित करने से महंगी गलतियों से बचने में मदद मिलती है और इसका सफल कार्यान्वयन सुनिश्चित होता है।

आपके मूल्यांकन के दौरान विचार करने के लिए प्रमुख क्षेत्र नीचे दिए गए हैं।

अपने सुरक्षा और परिचालन लक्ष्यों को पूरा करने वाले प्लेटफ़ॉर्म की पहचान करने के लिए, इन महत्वपूर्ण कारकों पर ध्यान दें। आपके संगठन की विशिष्ट ज़रूरतों और जोखिम सहनशीलता के आधार पर प्रत्येक का एक अलग स्तर का महत्व होता है।

सुरक्षा आर्किटेक्चर और डेटा सुरक्षा आपकी सर्वोच्च प्राथमिकता होनी चाहिए। एक मज़बूत प्लेटफ़ॉर्म ज़ीरो-ट्रस्ट सुरक्षा मॉडल का उपयोग करेगा, जिससे यह सुनिश्चित होगा कि डेटा ट्रांज़िट और आराम दोनों में एन्क्रिप्ट किया गया हो। इसे असामान्य पैटर्न या संभावित उल्लंघनों की निगरानी के लिए एडवांस थ्रेट डिटेक्शन के साथ-साथ यूज़र, टीमों और प्रोजेक्ट्स के लिए बारीक एक्सेस कंट्रोल भी प्रदान करना चाहिए।

अनुपालन और शासन क्षमताएं विनियामक मांगों को पूरा करने के लिए आवश्यक हैं। व्यापक ऑडिट ट्रेल्स वाले प्लेटफ़ॉर्म की तलाश करें, जो उपयोगकर्ता गतिविधियों, मॉडल इंटरैक्शन और डेटा एक्सेस को लॉग करते हैं। GDPR, HIPAA, और SOC 2 जैसे प्रमुख ढांचे के साथ-साथ उद्योग-विशिष्ट नियमों के लिए समर्थन आवश्यक है।

लागत प्रबंधन और पारदर्शिता बजट योजना में महत्वपूर्ण भूमिका निभाते हैं। पे-एज़-यू-गो प्राइसिंग मॉडल अक्सर वर्कलोड में उतार-चढ़ाव वाले संगठनों के लिए बेहतर लचीलापन प्रदान करते हैं। रीयल-टाइम खर्च करने की दृश्यता और बजट नियंत्रण जैसी सुविधाएँ अप्रत्याशित लागतों को रोकने और संसाधन आवंटन को अनुकूलित करने में मदद कर सकती हैं।

स्केलेबिलिटी और प्रदर्शन यह सुनिश्चित करने के लिए महत्वपूर्ण हैं कि प्लेटफ़ॉर्म आपके व्यवसाय के साथ बढ़ सके। उपयोग बढ़ने पर प्रदर्शन का त्याग किए बिना बढ़े हुए वर्कलोड (क्षैतिज स्केलिंग) को संभालने और जटिल AI कार्यों (वर्टिकल स्केलिंग) को प्रबंधित करने की इसकी क्षमता का मूल्यांकन करें।

एकीकरण और वर्कफ़्लो क्षमताएं यह निर्धारित करें कि प्लेटफ़ॉर्म आपके मौजूदा सिस्टम में कितनी अच्छी तरह फिट बैठता है। मज़बूत API समर्थन, सामान्य एंटरप्राइज़ टूल के लिए पूर्व-निर्मित कनेक्टर और ऑपरेशन को कारगर बनाने वाली वर्कफ़्लो ऑटोमेशन सुविधाओं की जांच करें।

नीचे दी गई तालिका इन मानदंडों को सारांशित करती है और आपके मूल्यांकन का मार्गदर्शन करने के लिए प्रश्न प्रदान करती है:

सहायता और प्रशिक्षण संसाधन सुचारू कार्यान्वयन सुनिश्चित करने के लिए एक और महत्वपूर्ण कारक हैं। उच्च गुणवत्ता वाले दस्तावेज़ीकरण, मजबूत प्रशिक्षण कार्यक्रम और उत्तरदायी तकनीकी सहायता से बहुत फर्क पड़ सकता है। प्रमाणन कार्यक्रमों की पेशकश करने वाले प्लेटफ़ॉर्म आपकी टीम को सुरक्षित और प्रभावी AI परिनियोजन के लिए आवश्यक विशेषज्ञता बनाने में मदद कर सकते हैं।

एक सूचित निर्णय लेने के लिए, सुरक्षा, आईटी, वित्त और व्यवसाय संचालन जैसे विभागों के हितधारकों को शामिल करें। एक ऐसा स्कोरिंग सिस्टम विकसित करें, जो आपके संगठन की विशिष्ट ज़रूरतों को प्राथमिकता दे, और उनकी क्षमताओं का परीक्षण करने के लिए शॉर्टलिस्ट किए गए प्लेटफ़ॉर्म के साथ पायलट प्रोजेक्ट चलाने पर विचार करें।

आखिरकार, सही प्लेटफ़ॉर्म आपके विशिष्ट उपयोग के मामले के अनुरूप सुरक्षा, कार्यक्षमता और लागत के बीच सही संतुलन बनाएगा।

AI सिस्टम में सुरक्षा सुविधाओं को एकीकृत करने के अलावा, एक मजबूत सुरक्षा-केंद्रित संस्कृति को बढ़ावा देने से सुरक्षा में काफी वृद्धि होती है। इस दृष्टिकोण के लिए निरंतर प्रशिक्षण, अनुकूलनीय शासन और सक्रिय खतरे का पता लगाने की आवश्यकता होती है। इन प्रथाओं को दैनिक कार्यों में शामिल करके, संगठन एक ऐसा वातावरण बना सकते हैं जहां सुरक्षा दूसरी प्रकृति बन जाए।

प्रभावी AI सुरक्षा अच्छी तरह से सूचित कर्मचारियों के साथ शुरू होती है। नियमित, भूमिका-विशिष्ट प्रशिक्षण टीमों को जोखिमों को पहचानने और उल्लंघनों को रोकने के लिए सही सुरक्षा उपायों को लागू करने का अधिकार देता है।

संगठन के भीतर विभिन्न भूमिकाओं के लिए तैयार प्रशिक्षण कार्यक्रम। उदाहरण के लिए:

सैंडबॉक्स वातावरण में व्यावहारिक कार्यशालाएं व्यावहारिक अनुभव प्रदान करती हैं। इन सत्रों से कर्मचारी संदिग्ध AI व्यवहार की पहचान करने, शीघ्र इंजेक्शन हमलों जैसी कमजोरियों का परीक्षण करने और सुरक्षा प्रोटोकॉल लागू करने का अभ्यास कर सकते हैं। यह व्यावहारिक दृष्टिकोण यह सुनिश्चित करता है कि वास्तविक दुनिया के परिदृश्यों में खतरों को पहचानने और उनका समाधान करने के लिए टीमें बेहतर तरीके से सुसज्जित हों।

मासिक सुरक्षा ब्रीफिंग कर्मचारियों को नवीनतम AI सुरक्षा घटनाओं और उभरते जोखिमों के बारे में सूचित रख सकती है। अपने उद्योग से केस स्टडी को शामिल करना इन अपडेट को अधिक प्रासंगिक और कार्रवाई योग्य बनाता है।

प्रशिक्षण को आकर्षक बनाने के लिए, गेमिफिकेशन पर विचार करें। टीम की चुनौतियां विकसित करें, जैसे कि AI वर्कफ़्लो में कमजोरियों की पहचान करना या सुरक्षित प्रॉम्प्ट टेम्पलेट बनाना। यह न केवल सीखने को सुखद बनाता है, बल्कि सहयोग और सुरक्षा प्रथाओं की गहरी समझ को भी बढ़ावा देता है।

नियमित आकलन और नकली हमले प्रशिक्षण कार्यक्रमों की प्रभावशीलता को मापने में मदद करते हैं। उदाहरण के लिए, AI सिस्टम को लक्षित करने वाले फ़िशिंग सिमुलेशन वाले कर्मचारियों का परीक्षण करें या संवेदनशील जानकारी निकालने के उद्देश्य से सोशल इंजीनियरिंग प्रयासों का परीक्षण करें। कमियों की पहचान करने और प्रशिक्षण रणनीतियों को परिष्कृत करने के लिए परिणामों का उपयोग करें।

AI प्रौद्योगिकियां तेजी से विकसित होती हैं, जो अक्सर पारंपरिक शासन ढांचे से आगे निकल जाती हैं। एक लचीला गवर्नेंस मॉडल अपनाने से यह सुनिश्चित होता है कि आपके सुरक्षा उपाय प्रभावी बने रहें और मौजूदा खतरों के अनुरूप रहें।

AI सुरक्षा नीतियों को अपडेट करने के लिए त्रैमासिक समीक्षाओं को शेड्यूल करें। इन समीक्षाओं में सुरक्षा, कानूनी, अनुपालन और व्यावसायिक टीमों के प्रमुख हितधारक शामिल होने चाहिए, ताकि यह सुनिश्चित किया जा सके कि नीतियां व्यावहारिक और लागू करने योग्य दोनों हैं।

बाहरी ऑडिट आपके सुरक्षा उपायों का निष्पक्ष मूल्यांकन प्रदान करते हैं। वार्षिक रूप से व्यापक ऑडिट करें, और सिस्टम में महत्वपूर्ण बदलाव या सुरक्षा घटनाओं के बाद केंद्रित समीक्षाओं के साथ आगे बढ़ें। तृतीय-पक्ष ऑडिटर नई जानकारी दे सकते हैं और उन कमजोरियों की पहचान कर सकते हैं जिन्हें आंतरिक टीमें नज़रअंदाज़ कर सकती हैं।

ऐसे लचीले नीतिगत ढाँचे विकसित करें जो नए AI टूल और उपयोग के मामलों के अनुकूल हों। कठोर, पुराने नियमों के बजाय, सिद्धांत-आधारित दिशानिर्देश बनाएं। उदाहरण के लिए, डेटा वर्गीकरण मानक स्थापित करें, जो किसी भी नए AI मॉडल पर स्वचालित रूप से लागू होते हैं, चाहे उसकी विशिष्ट तकनीक कुछ भी हो।

रियल-टाइम मॉनिटरिंग सिस्टम सुरक्षा नीतियों के अनुपालन को लागू कर सकते हैं। ये उपकरण असामान्य गतिविधियों, अनधिकृत डेटा एक्सेस और प्रोटोकॉल विचलन का पता लगाते हैं, जिससे सुरक्षा टीमों पर बोझ कम करते हुए संभावित खतरों के प्रति तेज़ी से प्रतिक्रिया मिलती है।

नीति अपडेट, जोखिम आकलन और सुरक्षा घटनाओं सहित शासन प्रक्रियाओं का विस्तृत दस्तावेजीकरण बनाए रखें। ऑडिट के दौरान यह रिकॉर्ड रखना अमूल्य है और बार-बार होने वाली समस्याओं की पहचान करने में मदद करता है जिनमें प्रणालीगत बदलावों की आवश्यकता हो सकती है।

AI सुरक्षा परिदृश्य लगातार बदल रहा है, नए खतरे और कमजोरियां नियमित रूप से उभर रही हैं। मजबूत सुरक्षा बनाए रखने के लिए सूचित और सक्रिय रहना महत्वपूर्ण है।

समय पर खतरे की जानकारी प्राप्त करने के लिए उद्योग-व्यापी पहलों के साथ जुड़ें। AI सुरक्षा कंसोर्टियम, कार्य समूहों और सूचना-साझाकरण नेटवर्क में भाग लें। इन सहयोगों से संगठन एक-दूसरे के अनुभवों से सीख सकते हैं और सामूहिक सुरक्षा को मजबूत कर सकते हैं।

AI और मशीन लर्निंग सुरक्षा पर केंद्रित विशेष खतरे के खुफिया फ़ीड्स की सदस्यता लें। ये संसाधन आपकी टीम को हमले के रुझानों पर अपडेट रहने और उसके अनुसार रक्षात्मक रणनीतियों को परिष्कृत करने में मदद करते हैं।

विशेषज्ञ नेटवर्क और सामुदायिक संसाधनों का लाभ उठाएं। Prompts.ai जैसे प्लेटफ़ॉर्म संगठनों को प्रमाणित प्रॉम्प्ट इंजीनियरों और सुरक्षा विशेषज्ञों से जोड़ते हैं जो नवीनतम खतरों को कम करने के लिए व्यावहारिक सलाह दे सकते हैं।

उभरती कमजोरियों के बारे में शुरुआती जानकारी हासिल करने के लिए शैक्षणिक संस्थानों या सुरक्षा फर्मों के साथ साझेदारी करें। इन साझेदारियों से अक्सर अत्याधुनिक शोध और उपकरणों तक पहुंच बनती है।

अनुसंधान और विकास के लिए समय समर्पित करने के लिए अपनी सुरक्षा टीम को प्रोत्साहित करें। उन्हें नए टूल खोजने, सम्मेलनों में भाग लेने और नियंत्रित सेटिंग में उभरती तकनीकों के साथ प्रयोग करने के अवसर प्रदान करें। निरंतर सीखने में यह निवेश सुनिश्चित करता है कि आपकी टीम नई चुनौतियों से निपटने के लिए तैयार है।

संभावित सुरक्षा घटनाओं की तैयारी के लिए परिदृश्य नियोजन अभ्यास आयोजित करें। एआई-विशिष्ट हमलों या डेटा उल्लंघनों के टेबलटॉप सिमुलेशन आपकी प्रतिक्रिया रणनीतियों में खामियों को प्रकट कर सकते हैं और टीमों को दबाव में समन्वित कार्रवाइयों का अभ्यास करने में मदद कर सकते हैं।

अंत में, विनियामक विकासों पर कड़ी नज़र रखें जो AI सुरक्षा आवश्यकताओं को प्रभावित कर सकते हैं। नए कानूनों और अनुपालन दायित्वों से आगे रहने से महंगे उल्लंघनों से बचने में मदद मिलती है और हितधारकों के साथ विश्वास मजबूत होता है।

उद्यम की दुनिया में AI को अपनाने का मतलब नवाचार और सुरक्षा के बीच चयन करना नहीं है - यह ऐसे समाधान खोजने के बारे में है जो दोनों को निर्बाध रूप से एक साथ लाते हैं। इस गाइड में दिखाया गया है कि कैसे सुरक्षित AI टूल कमजोरियों को ताकत में बदल सकते हैं, जिससे संगठन सख्त डेटा सुरक्षा और अनुपालन मानकों को बनाए रखते हुए AI की पूरी क्षमता को अनलॉक कर सकते हैं। एक सुरक्षित आधार सिर्फ़ जोखिमों को कम नहीं करता है; यह सीधे तौर पर बेहतर व्यावसायिक परिणामों में योगदान देता है।

जो संगठन शुरू से ही सुरक्षा को प्राथमिकता देते हैं, वे लगातार उन लोगों से बेहतर प्रदर्शन करते हैं जो इसे बाद के विचार के रूप में मानते हैं। मजबूत सुरक्षा उपायों को जल्दी लागू करके, व्यवसाय न केवल संवेदनशील जानकारी की सुरक्षा करते हैं, बल्कि हितधारकों के बीच विश्वास पैदा करके और डेटा उल्लंघनों या अनुपालन विफलताओं जैसे महंगे व्यवधानों से बचकर नवाचार को बढ़ावा देते हैं।

“एक सकारात्मक AI सुरक्षा संस्कृति सुरक्षा को रणनीतिक लाभ के रूप में बदल देती है, जो विकास, नवाचार और बेहतर ग्राहक विश्वास के लिए उत्प्रेरक के रूप में कार्य करती है"।

जब सुरक्षा एक बाधा के बजाय रोजमर्रा के कार्यों का हिस्सा बन जाती है, तो यह कर्मचारियों को संभावित कमजोर बिंदुओं से हटाकर एआई-संबंधित खतरों के खिलाफ सक्रिय रक्षक बनने में बदल देती है। यह सांस्कृतिक परिवर्तन “शैडो एआई” जैसे मुद्दों को रोकने में भी मदद करता है, जहां अप्रतिबंधित और अप्रबंधित AI का उपयोग छिपे हुए जोखिम पैदा करता है।

Prompts.ai जैसे प्लेटफ़ॉर्म इस बात पर प्रकाश डालते हैं कि यह संतुलन कैसे हासिल किया जा सकता है। एंटरप्राइज़-ग्रेड सुरक्षा को महत्वपूर्ण लागत बचत के साथ जोड़कर - जैसे कि पे-एज़-यू-गो TOKN क्रेडिट के माध्यम से AI सॉफ़्टवेयर खर्चों को 98% तक कम करना - बिज़नेस मज़बूत सुरक्षा नियंत्रण बनाए रखते हुए, वित्तीय तनाव के बिना अपने AI प्रयासों को बढ़ा सकते हैं।

AI को सफलतापूर्वक अपनाने की कुंजी उन उपकरणों को चुनने में निहित है जो कार्यक्षमता और सुरक्षा के बीच समझौता करने के लिए बाध्य नहीं करते हैं। आधुनिक सुरक्षित AI प्लेटफ़ॉर्म पारदर्शी लागत प्रबंधन, विस्तृत ऑडिट ट्रेल्स और अनुकूलनीय गवर्नेंस फ्रेमवर्क प्रदान करते हैं, जिससे उद्यमों को अनुपालन करते हुए साहसपूर्वक नवाचार करने के लिए सशक्त बनाया जाता है।

जैसे-जैसे AI उद्योगों को नया आकार देगा, ऐसे नेता वे होंगे जो सुरक्षा को एक सीमा के रूप में नहीं बल्कि महत्वाकांक्षी विकास की नींव के रूप में देखते हैं। सुरक्षित AI उपकरण सतर्क प्रयोग और आत्मविश्वास से भरे, बड़े पैमाने पर तैनाती के बीच सेतु का काम करते हैं, जो व्यवसायों को AI की परिवर्तनकारी शक्ति का उपयोग करने में सक्षम बनाते हैं, जबकि डेटा और विश्वास की रक्षा करते हैं जो उनकी सफलता को आगे बढ़ाते हैं। सुरक्षित AI टूल को एकीकृत करके, उद्यम अपने परिचालन को सुरक्षित रख सकते हैं और निरंतर नवाचार को बढ़ावा दे सकते हैं।

Prompts.ai व्यवसायों को बीच सही संतुलन बनाने में सक्षम बनाता है डेटा सुरक्षा और प्रगति ट्रांज़िट और रेस्ट दोनों में डेटा के लिए एन्क्रिप्शन सहित मजबूत सुरक्षा उपायों को लागू करके। इन सुरक्षा उपायों से यह सुनिश्चित होता है कि संवेदनशील जानकारी सभी चरणों में सुरक्षित रहे।

प्लेटफ़ॉर्म सुरक्षित वातावरण में परिनियोजन विकल्प भी प्रदान करता है, जैसे कि निजी क्लाउड या एज नेटवर्क, जिससे डेटा उल्लंघनों की संभावना कम हो जाती है। इसके अलावा, इसके स्वचालित अनुपालन उपकरण GDPR जैसे नियमों का पालन करना आसान बनाते हैं और सीसीपीए, उद्योग की आवश्यकताओं को पूरा करते हुए आत्मविश्वास के साथ आगे बढ़ने के लिए संगठनों को सशक्त बनाना।

AI में गोता लगाने वाले उद्यमों को अक्सर बाधाओं का सामना करना पड़ता है जैसे डेटा उल्लंघनों, विनियामक गैर-अनुपालन, पक्षपाती या गलत परिणाम, और दुर्भावनापूर्ण अभिनेताओं से धमकियां। ये समस्याएं निजी जानकारी को उजागर कर सकती हैं, संचालन में बाधा डाल सकती हैं और हितधारकों के साथ विश्वास को नुकसान पहुंचा सकती हैं।

इन चुनौतियों से निपटने के लिए, व्यवसायों को प्राथमिकता देनी चाहिए मजबूत डेटा गवर्नेंस नीतियां, एक को गले लगाओ जीरो-ट्रस्ट सिक्योरिटी फ्रेमवर्क, और लागू विनियमों के साथ गठबंधन में रहें। AI पहलों का प्रबंधन करने के लिए क्रॉस-फ़ंक्शनल टीम बनाने से सुरक्षा और जवाबदेही को और बढ़ाया जा सकता है। सुरक्षा प्रोटोकॉल को सीधे AI प्रक्रियाओं में एम्बेड करने से यह सुनिश्चित होता है कि AI में प्रगति संवेदनशील डेटा की सुरक्षा को खतरे में न डाले।

जीरो ट्रस्ट आर्किटेक्चर एक सुरक्षा मॉडल है जिसे “कभी भरोसा न करें, हमेशा सत्यापित करें” के विचार पर बनाया गया है। यह इस धारणा के तहत काम करता है कि संभावित खतरे किसी संगठन के नेटवर्क के अंदर और बाहर दोनों जगह से उत्पन्न हो सकते हैं। परिणामस्वरूप, यह प्रत्येक उपयोगकर्ता, डिवाइस और एक्सेस अनुरोध के लिए निरंतर सत्यापन की मांग करता है, जिससे अंधे विश्वास की कोई गुंजाइश नहीं रह जाती है।

यह दृष्टिकोण एआई-संचालित एंटरप्राइज़ सेटिंग्स में विशेष रूप से महत्वपूर्ण है, जहां संवेदनशील डेटा कई, लगातार बदलते पहुंच बिंदुओं के माध्यम से प्रवाहित होता है। जीरो ट्रस्ट अपनाकर, संगठन कठोर पहचान जांच के माध्यम से डेटा सुरक्षा को मजबूत कर सकते हैं, संभावित कमजोरियों को कम कर सकते हैं और वास्तविक समय में खतरों का जवाब दे सकते हैं। इन पद्धतियों से यह सुनिश्चित करने में मदद मिलती है कि अगर कोई उल्लंघन होता है, तो भी इसका नुकसान नियंत्रित रहता है, जिससे व्यवसाय अपनी AI पहलों को आगे बढ़ाते हुए सुरक्षित और कुशल बने रह सकते हैं।