La orquestación del aprendizaje automático es la columna vertebral de las operaciones de IA eficientes, ya que automatiza tareas como el procesamiento de datos, la implementación de modelos y la supervisión. Sin ella, las empresas se enfrentan a altos costos, riesgos de cumplimiento y desafíos de escalamiento. Plataformas como Prompts.ai simplifique la orquestación al unificar los flujos de trabajo, hacer cumplir la gobernanza y reducir los costos hasta 98%.

Esto es lo que necesita saber:

Este enfoque transforma el caos de la IA en claridad, lo que permite a las empresas gestionar los modelos de manera eficiente y, al mismo tiempo, ahorrar tiempo y recursos.

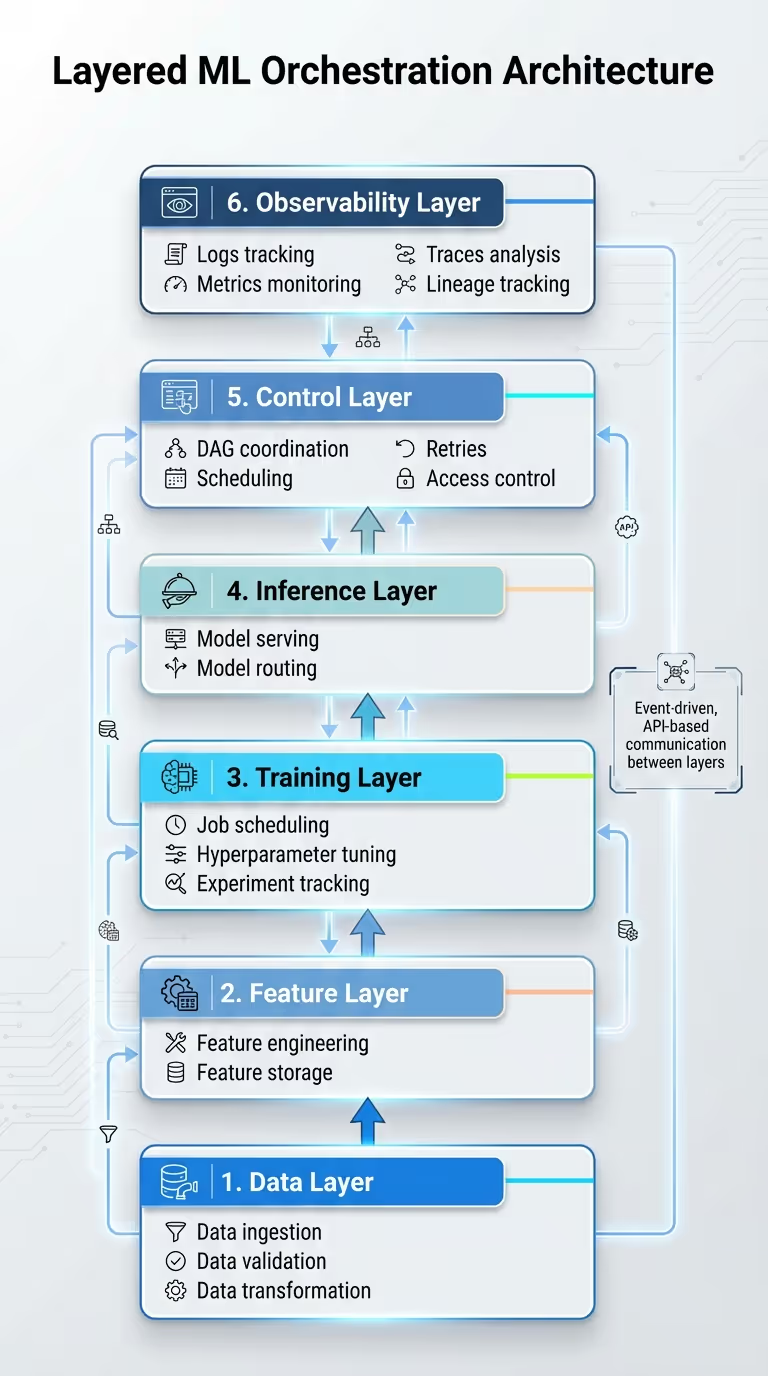

Orquestación del modelo de aprendizaje automático: marco de arquitectura de 6 capas

El sistema de orquestación organiza sus procesos en seis capas distintas: Datos (gestión de la ingestión, la validación y la transformación), Característica (ingeniería y almacenamiento), Entrenamiento (gestión de la programación de tareas, ajuste de hiperparámetros y seguimiento de experimentos), Inferencia (modelo de servicio y enrutamiento), Controlar (coordinación de los DAG, programación, reintentos y control de acceso) y Observabilidad (registros de seguimiento, métricas, trazas y linaje).

Esta estructura se basa en microservicios y en un diseño basado en eventos, lo que hace que cada capa sea modular y fácil de mantener. En lugar de crear un sistema único y masivo, la funcionalidad se divide en servicios más pequeños, como la validación de datos, la generación de funciones, el entrenamiento de modelos, la inferencia y la supervisión, que se comunican a través de API o sistemas de mensajería. Por ejemplo, en una empresa minorista de EE. UU., un proceso nocturno de ingesta de datos puede provocar el recálculo de las funciones y el readiestramiento automatizado mediante mensajes en cola. Esta configuración modular mejora la fiabilidad, es compatible con los entornos multinube habituales en las empresas estadounidenses y permite a los equipos implementar las actualizaciones de forma gradual con una interrupción mínima. Además, permite una gestión precisa de las dependencias del flujo de trabajo en estas capas.

Los gráficos acíclicos dirigidos (DAG) son clave para organizar los flujos de trabajo. Dividen las tareas (como la ingesta de datos, la validación, la creación de funciones, la formación, la evaluación y el despliegue) en pasos discretos, lo que garantiza que cada una de ellas solo comience cuando los resultados iniciales cumplan con los estándares de calidad predefinidos. Al hacer cumplir los contratos de datos y esquemas, los procesos posteriores solo se activan cuando los resultados iniciales se alinean con los requisitos establecidos. En lugar de basarse en un gráfico único y excesivamente complejo, los DAG más pequeños y específicos del dominio (para la capacitación, la inferencia o la supervisión), vinculados por desencadenantes de eventos, reducen los riesgos operativos y mejoran la capacidad de administración.

Para garantizar aún más la confiabilidad, la idempotencia se logra mediante el uso de artefactos versionados e inmutables con identificadores únicos. Las operaciones de Upsert evitan que se produzcan duplicados durante los reintentos o los rellenamientos, mientras que el seguimiento detallado de los metadatos y el linaje protegen contra las consecuencias imprevistas durante la ejecución.

Con una gestión de dependencias clara, la adopción de estándares de interoperabilidad simplifica la integración de modelos en varios sistemas. Estándares como las API REST con API abierta garantizar la claridad en la integración, gRPC admite una comunicación interna de alto rendimiento, y los sistemas de mensajería desvinculan a los productores de los consumidores para lograr flujos de trabajo más fluidos.

Estos estándares permiten a los equipos reemplazar o actualizar modelos detrás de API estables sin interrupciones, enrutar tareas de forma dinámica a modelos especializados e integrar soluciones internas o de terceros bajo contratos de API y protocolos de seguridad consistentes. Por ejemplo, Prompts.ai proporciona acceso unificado a más de 35 modelos de IA líderes a través de una única interfaz, lo que reduce la proliferación de herramientas y simplifica los flujos de trabajo. La plataforma también admite integraciones con aplicaciones externas, como Slack, Gmail, y Trello, lo que permite a los equipos automatizar las tareas en diferentes sistemas sin problemas.

Para que su arquitectura de orquestación sea realmente eficaz, es esencial contar con estrategias sólidas de implementación y escalado para que las operaciones funcionen sin problemas.

Contenerizar modelos con herramientas como Estibador y Kubernetes garantiza un rendimiento uniforme en diferentes entornos. Kubernetes se encarga de organizar estos contenedores y ofrece funciones como el equilibrio de carga, las actualizaciones continuas y la alta disponibilidad. Los modelos se pueden implementar de varias maneras: la puntuación por lotes para las tareas programadas, la inferencia en tiempo real mediante REST o gRPC para hacer predicciones rápidas y las versiones canarias permiten dirigir gradualmente el tráfico a las nuevas versiones y, al mismo tiempo, supervisar su rendimiento. Las organizaciones que adoptan prácticas exhaustivas de MLOps han informado de que implementan los modelos un 60% más rápido y experimentan un 40% menos de problemas de producción. Estas técnicas de implementación se integran a la perfección con su marco de orquestación, lo que proporciona eficiencia y confiabilidad.

El escalado automático horizontal es una estrategia clave para hacer coincidir los recursos con la demanda, escalando las réplicas de modelos en función de métricas como el volumen de solicitudes, el uso de CPU/GPU o los parámetros definidos a medida. Kubernetes automatiza este proceso, aumentando los pods cuando la latencia aumenta y reduciéndolos durante los períodos de menor actividad. Entre 2022 y 2024, el costo de la inferencia de la IA se redujo 280 veces, lo que hizo que la optimización continua fuera práctica y rentable. El enrutamiento basado en los costos es otro enfoque valioso, ya que dirige las tareas más simples a modelos livianos y reserva los modelos que consumen muchos recursos para necesidades más complejas. Además, la selección de los tipos de instancias correctos y el uso de instancias puntuales para las cargas de trabajo que pueden tolerar las interrupciones pueden reducir significativamente los costos. Sin embargo, deben existir medidas de seguridad para gestionar eficazmente las interrupciones de las instancias puntuales. Estas estrategias de escalamiento garantizan un equilibrio entre el rendimiento y la rentabilidad.

Mantener la confiabilidad del sistema requiere medidas proactivas. Los disyuntores pueden bloquear el tráfico que llega a los terminales defectuosos, mientras que la limitación de velocidad evita que un exceso de solicitudes sobrecargue el sistema. Las comprobaciones periódicas del estado ayudan a identificar y eliminar las instancias que no responden, y la lógica de reintentos con un retraso exponencial garantiza que las solicitudes fallidas se vuelvan a intentar sin sobrecargar el sistema. El registro detallado proporciona visibilidad del rendimiento del sistema, lo que ayuda a abordar rápidamente los problemas y a mantener la resiliencia. En conjunto, estas prácticas crean una base sólida para unas operaciones confiables.

Una vez que sus modelos estén en funcionamiento, es crucial mantener el control, garantizar un funcionamiento fluido y mantener los costos bajo control.

Controle todo su flujo de IA en tiempo real con paneles que rastrean métricas clave como los tiempos de respuesta, la precisión, el uso de los recursos, la actualización de los datos y la latencia. Herramientas como Flujo de aire Apache proporcione alertas en caso de caídas de rendimiento o problemas de calidad de los datos, para que pueda actuar con rapidez.

Por ejemplo, considere un sistema de recomendación de comercio electrónico. Los paneles supervisan los tiempos de respuesta en varios modelos y, si la latencia aumenta, el sistema ajusta la distribución de las tareas automáticamente para mantener el rendimiento. Existen funciones como los reintentos, los rellenamientos y los objetivos de nivel de servicio (SLO) para evitar errores en cascada. Esta supervisión en tiempo real no solo garantiza un rendimiento fluido, sino que también respalda los esfuerzos de gobierno para cumplir con los estándares de cumplimiento.

Los marcos de gobierno sólidos son esenciales para administrar el acceso, rastrear las versiones y mantener el cumplimiento de regulaciones como el SOC 2 y HIPAA. Al capturar los metadatos de los experimentos, los conjuntos de datos y las ejecuciones, se crean registros de auditoría claros. Herramientas como la integración con Open Lineage de Airflow ayudan a rastrear el linaje de datos en todos los flujos de trabajo, mientras que la contenedorización y la gestión segura de las credenciales mantienen segura la información confidencial. Este enfoque de gobierno se integra a la perfección con la arquitectura de orquestación descrita anteriormente.

Prompts.ai obtuvo la certificación SOC 2 de tipo 2 el 19 de junio de 2025, lo que demuestra su dedicación al cumplimiento y al monitoreo continuo. Las funciones de supervisión del cumplimiento y administración de la gobernanza de la plataforma ofrecen una visibilidad y un seguimiento completos de todas las actividades de inteligencia artificial. Todas las aprobaciones, anulaciones y actualizaciones de versiones se registran sistemáticamente, lo que garantiza el cumplimiento de los requisitos reglamentarios y, al mismo tiempo, fomenta la confianza. Este sólido modelo de gobierno también apoya la supervisión financiera, alineando el rendimiento operativo con la gestión de costos.

Comprender y gestionar los costes es tan importante como el rendimiento técnico. Al hacer un seguimiento de los gastos del modelo en USD, las organizaciones pueden vincular directamente los gastos en IA con los objetivos empresariales. Los paneles de control y las alertas presupuestarias en tiempo real brindan claridad, mientras que las rutas basadas en los costos identifican las ineficiencias, como el uso de modelos demasiado complejos para tareas simples. La capa FinOps de Prompts.ai, basada en créditos TOKN, permite a las empresas supervisar los patrones de uso y establecer presupuestos para evitar gastos excesivos.

Un ejemplo de esta eficiencia: las organizaciones han reducido los costos de IA hasta en un 98% al consolidar más de 35 herramientas de IA independientes en una sola plataforma. Este cambio transforma los costos fijos en soluciones escalables y bajo demanda. Las revisiones periódicas de la asignación de recursos garantizan que los modelos tengan el tamaño adecuado para sus tareas. En los proyectos de anotación geoespacial, la orquestación distribuye las cargas de trabajo entre los modelos para reducir tanto los costos de procesamiento como los errores. Al combinar la implementación modular con la integración en la nube para los modelos híbridos, las empresas se aseguran de que cada dólar gastado se traduzca en ganancias cuantificables, como un procesamiento de datos más rápido y una mayor eficiencia. Esta supervisión financiera continua refuerza los beneficios de ahorro de costes de la estrategia de orquestación de Prompts.ai.

La gestión eficaz de los modelos de aprendizaje automático (ML) es crucial para garantizar operaciones de IA fiables, rentables y que cumplan con las normas. Al emplear marcos de orquestación por capas, abordar las dependencias del flujo de trabajo y permitir una interoperabilidad perfecta de los sistemas, las organizaciones pueden administrar de manera eficiente múltiples modelos y flujos de datos de principio a fin.

Más allá de los aspectos técnicos, una gobernanza sólida y una supervisión exhaustiva son la columna vertebral de los sistemas de IA confiables. La observabilidad integral (el seguimiento de métricas como los tiempos de respuesta, la precisión, el consumo de recursos y los costos), combinada con el cumplimiento de estándares como el SOC 2 y la HIPAA, garantiza el cumplimiento de la normativa y simplifica la resolución de problemas. Estas medidas no solo cumplen con los requisitos legales, sino que también infunden confianza en que los sistemas de IA funcionan según lo previsto y aportan un valor cuantificable a la empresa.

La gestión de costes basada en los principios de FinOps reduce aún más los gastos relacionados con la IA. Escalar la infraestructura de forma dinámica en función de la demanda, usar modelos livianos para tareas más sencillas y monitorear los gastos en tiempo real puede reducir los costos de manera significativa. Las organizaciones que utilizan plataformas de orquestación unificadas han logrado ahorros notables gracias a la optimización de sus herramientas y procesos.

Prompts.ai lleva esto un paso más allá al integrar más de 35 modelos de IA líderes en una sola plataforma. Con herramientas de gobierno integradas, un seguimiento del cumplimiento y una capa de FinOps basada en créditos TOKN, la plataforma ofrece una visibilidad y auditabilidad completas para todas las actividades de inteligencia artificial. Esto permite a los equipos implementar, escalar y optimizar los modelos sin el caos de tener que hacer malabares con múltiples herramientas.

El camino a seguir es sencillo: implementar estrategias de orquestación que combinen la eficiencia técnica con una gobernanza sólida y una gestión de costes clara. Al tratar los modelos como componentes interconectados y orquestados en lugar de como herramientas aisladas, las empresas pueden cambiar su enfoque hacia la innovación y lograr resultados significativos, dejando atrás los desafíos de infraestructura.

La orquestación del aprendizaje automático brinda una serie de beneficios para refinar y optimizar sus flujos de trabajo de IA. Para empezar, mejora escalabilidad, lo que le permite administrar e implementar de manera eficiente varios modelos en diversos entornos. Esto garantiza que sus sistemas puedan crecer y adaptarse a medida que aumentan las demandas.

También mejora eficiencia automatizando las tareas repetitivas y agilizando los procesos, ahorrando tiempo y recursos valiosos. Más allá de eso, la orquestación promueve colaboración integrando sin problemas las herramientas y los flujos de trabajo, haciendo que el trabajo en equipo sea más fluido y eficaz.

La confiabilidad es otra ventaja: la supervisión y la optimización en tiempo real garantizan que sus modelos funcionen de manera uniforme. Además, se fortalece gobierno y cumplimiento al proporcionar una supervisión y un control claros, lo que le brinda la confianza necesaria para cumplir con los estándares regulatorios sin problemas.

Una arquitectura en capas divide los flujos de trabajo de aprendizaje automático en segmentos distintos y administrables, lo que garantiza una división clara de responsabilidades. Cada capa se centra en una tarea específica, ya sea el preprocesamiento de datos, el entrenamiento de modelos, la validación, el despliegue o la supervisión, lo que permite que estas funciones funcionen de forma independiente. Esta estructura no solo simplifica las actualizaciones, sino que también mejora escalabilidad y hace que la solución de problemas sea mucho más eficiente.

Al segmentar los flujos de trabajo en capas, los recursos se pueden asignar de forma más estratégica, lo que mejora la tolerancia a fallos y agiliza el control de versiones. Este método organizado fomenta una colaboración más fluida y apoya el desarrollo de sistemas de inteligencia artificial confiables que se alinean con sus objetivos.

Para que el escalado y la implementación de modelos de IA sean más fluidos y económicos, priorice automatización, gestión inteligente de recursos, y seguimiento en tiempo real. Incorpore herramientas como las canalizaciones automatizadas de CI/CD para simplificar los procesos de implementación y reducir las tareas manuales. La asignación dinámica de recursos garantiza que la potencia computacional se utilice solo cuando sea necesario, lo que ayuda a evitar costos adicionales.

Configure sistemas de monitoreo en tiempo real para controlar el rendimiento del modelo y el consumo de recursos. Esto permite realizar ajustes rápidos para optimizar la eficiencia y gestionar los gastos de forma eficaz. Al integrar estos enfoques, puede crear flujos de trabajo de IA que sean escalables, confiables y conscientes de los costos.

{» @context «:» https://schema.org","@type":"FAQPage","mainEntity":[{"@type":"Question","name":"What ¿son las principales ventajas de orquestar modelos de aprendizaje automático?» , "acceptedAnswer»: {» @type «:"Answer», "text»:» La <p>orquestación del aprendizaje automático aporta una serie de beneficios para refinar y optimizar los flujos de trabajo de la IA. Para empezar, mejora la <strong>escalabilidad</strong>, lo que le permite administrar e implementar de manera eficiente varios modelos en diversos entornos. Esto garantiza que sus sistemas puedan crecer y adaptarse a medida que aumentan las demandas</p>. <p>También mejora la <strong>eficiencia</strong> al automatizar las tareas repetitivas y agilizar los procesos, lo que ahorra tiempo y valiosos recursos. Además, la orquestación promueve la <strong>colaboración</strong> al integrar sin problemas las herramientas y los flujos de trabajo, lo que hace que el trabajo en equipo sea más fluido y eficaz</p>. <p>La confiabilidad es otra ventaja: la supervisión y la optimización en tiempo real garantizan que sus modelos funcionen de manera uniforme. Además, refuerza la <strong>gobernanza y el cumplimiento</strong> al proporcionar una supervisión y un control claros, lo que le brinda la confianza necesaria para cumplir las normas reglamentarias sin problemas</p>. «}}, {» @type «:"Question», "name» :"¿ Cuáles son las ventajas de usar una arquitectura en capas para orquestar los modelos de aprendizaje automático?» <strong>, "acceptedAnswer»: {» @type «:"Answer», "text»:» Una arquitectura en capas divide los flujos de trabajo del aprendizaje automático en segmentos distintos y fáciles de gestionar, lo que garantiza una división clara de las responsabilidades.</strong> <p> Cada capa se centra en una tarea específica (ya sea el preprocesamiento de datos, el entrenamiento de modelos, la validación, la implementación o la supervisión), lo que permite que estas funciones funcionen de forma independiente. Esta estructura no solo simplifica las actualizaciones, sino que también mejora la <strong>escalabilidad</strong> y hace que la solución de problemas sea mucho más eficiente</p>. <p>Al segmentar los flujos de trabajo en capas, los recursos se pueden asignar de forma más estratégica, lo que mejora la tolerancia a los fallos y agiliza el control de versiones. Este método organizado fomenta una colaboración más fluida y apoya el desarrollo de sistemas de inteligencia artificial confiables que</p> se alinean con sus objetivos. «}}, {» @type «:"Question», "name» :"¿ Cómo puedo escalar e implementar modelos de IA de manera eficiente y, al mismo tiempo, minimizar los costos?» <strong><strong><strong>, "acceptedAnswer»: {» @type «:"Answer», "text»:» Para que el escalado y la implementación de modelos de IA sean más sencillos y económicos, priorice la automatización, la gestión inteligente de los recursos y el seguimiento en tiempo real.</strong></strong></strong> <p> Incorpore herramientas como las canalizaciones automatizadas de CI/CD para simplificar los procesos de implementación y reducir las tareas manuales. La asignación dinámica de recursos garantiza que la potencia computacional se utilice solo cuando sea necesario, lo que ayuda a evitar costos adicionales</p>. <p>Configure sistemas de monitoreo en tiempo real para controlar el rendimiento del modelo y el consumo de recursos. Esto permite realizar ajustes rápidos para optimizar la eficiencia y gestionar los gastos de forma eficaz. Al integrar estos enfoques, puede crear flujos de trabajo de IA que sean escalables, confiables y conscientes de los costos</p>. «}}]}