L'orchestration de l'apprentissage automatique est l'épine dorsale d'opérations d'IA efficaces, automatisant des tâches telles que le traitement des données, le déploiement de modèles et la surveillance. Sans elle, les entreprises sont confrontées à des coûts élevés, à des risques de conformité et à des défis de mise à l'échelle. Des plateformes comme Prompts.ai simplifiez l'orchestration en unifiant les flux de travail, en appliquant la gouvernance et en réduisant les coûts jusqu'à 98 %.

Voici ce que vous devez savoir :

Cette approche transforme le chaos de l'IA en clarté, permettant aux entreprises de gérer leurs modèles de manière efficace tout en économisant du temps et des ressources.

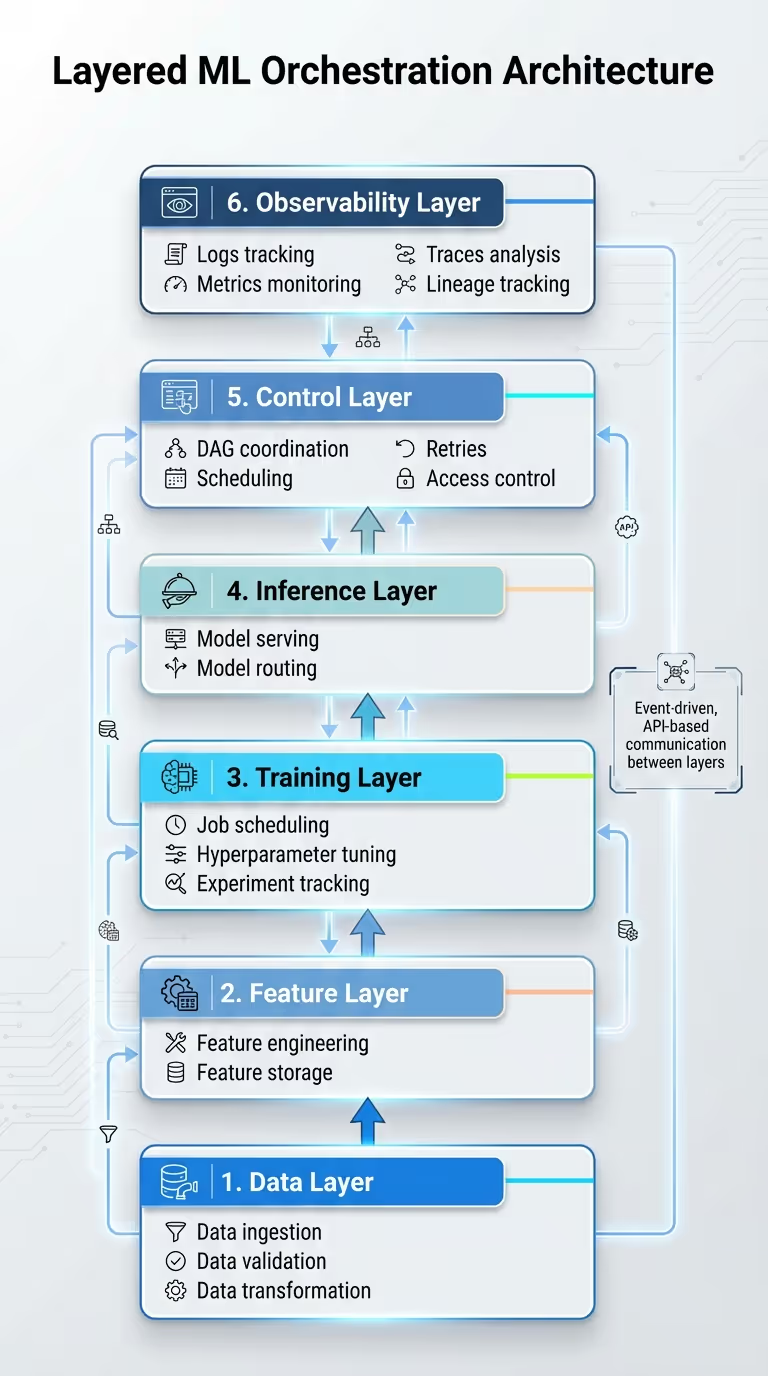

Orchestration de modèles d'apprentissage automatique : cadre d'architecture à 6 couches

Le système d'orchestration organise ses processus en six niveaux distincts : Données (gestion de l'ingestion, de la validation et de la transformation), Fonctionnalité (ingénierie et stockage), Entraînement (gestion de la planification des tâches, réglage des hyperparamètres et suivi des expériences), Inférence (distribution de modèles et routage), Contrôle (coordination des DAG, planification, nouvelles tentatives et contrôle d'accès), et Observabilité (journaux de suivi, métriques, traces et lignage).

Cette structure repose sur des microservices et une conception pilotée par les événements, ce qui rend chaque couche modulaire et facilite la maintenance. Au lieu de créer un système unique et massif, les fonctionnalités sont divisées en services plus petits, tels que la validation des données, la génération de fonctionnalités, la formation de modèles, l'inférence et la surveillance, qui communiquent via des API ou des systèmes de messagerie. Par exemple, dans une entreprise de vente au détail américaine, un processus d'ingestion de données nocturne peut déclencher des recalculs des fonctionnalités et une reconversion automatique à l'aide de messages en file d'attente. Cette configuration modulaire améliore la fiabilité, prend en charge les environnements multicloud courants dans les entreprises américaines et permet aux équipes de déployer des mises à jour progressivement avec un minimum de perturbations. En outre, il permet une gestion précise des dépendances du flux de travail entre ces couches.

Les graphes acycliques dirigés (DAG) sont essentiels à l'organisation des flux de travail. Ils répartissent les tâches, telles que l'ingestion de données, la validation, la construction de fonctionnalités, la formation, l'évaluation et le déploiement, en étapes distinctes, garantissant que chacune ne commence que lorsque les sorties en amont répondent à des normes de qualité prédéfinies. En appliquant les contrats de données et de schémas, les processus en aval ne sont déclenchés que lorsque les résultats en amont correspondent aux exigences définies. Au lieu de s'appuyer sur un graphique unique trop complexe, des DAG plus petits et spécifiques à un domaine (pour la formation, l'inférence ou la surveillance) liés par des déclencheurs d'événements réduisent les risques opérationnels et améliorent la gérabilité.

Pour garantir davantage la fiabilité, l'idempotence est obtenue en utilisant des artefacts immuables et versionnés dotés d'identifiants uniques. Les opérations Upsert empêchent les doublons lors des nouvelles tentatives ou des remblayages, tandis que les métadonnées détaillées et le suivi du lignage protègent contre les conséquences imprévues lors de l'exécution.

Grâce à la mise en place d'une gestion claire des dépendances, l'adoption de normes d'interopérabilité simplifie l'intégration des modèles entre les différents systèmes. Des normes telles que les API REST avec API ouverte garantir la clarté de l'intégration, grPC prend en charge une communication interne performante, et les systèmes de messagerie découplent les producteurs des consommateurs pour des flux de travail plus fluides.

Ces normes permettent aux équipes de remplacer ou de mettre à niveau des modèles basés sur des API stables sans interruption, d'acheminer dynamiquement les tâches vers des modèles spécialisés et d'intégrer des solutions tierces ou internes dans le cadre de contrats d'API et de protocoles de sécurité cohérents. Par exemple, Prompts.ai fournit un accès unifié à plus de 35 principaux modèles d'IA via une interface unique, réduisant ainsi la prolifération des outils et simplifiant les flux de travail. La plateforme prend également en charge les intégrations avec des applications externes telles que Slack, Gmail, et Trello, permettant aux équipes d'automatiser les tâches de manière fluide sur différents systèmes.

Pour que votre architecture d'orchestration soit réellement efficace, de solides stratégies de déploiement et de mise à l'échelle sont essentielles à la fluidité des opérations.

Modèles de conteneurisation à l'aide d'outils tels que Docker et Kubernetes garantit des performances constantes dans différents environnements. Kubernetes s'occupe de l'orchestration de ces conteneurs en proposant des fonctionnalités telles que l'équilibrage de charge, les mises à jour continues et la haute disponibilité. Les modèles peuvent être déployés de plusieurs manières : notation par lots pour les tâches planifiées, inférence en temps réel à l'aide de REST ou gRPC pour des prévisions rapides, et versions Canary pour diriger progressivement le trafic vers les nouvelles versions tout en surveillant leurs performances. Les entreprises qui adoptent des pratiques MLOps rigoureuses ont indiqué qu'elles déployaient leurs modèles 60 % plus rapidement et rencontraient 40 % de problèmes de production en moins. Ces techniques de déploiement s'intègrent parfaitement à votre infrastructure d'orchestration, offrant à la fois efficacité et fiabilité.

La mise à l'échelle automatique horizontale est une stratégie clé pour faire correspondre les ressources à la demande, en adaptant les répliques de modèles en fonction de mesures telles que le volume des demandes, l'utilisation du CPU/GPU ou des paramètres personnalisés. Kubernetes automatise ce processus en augmentant le nombre de pods lorsque la latence augmente et en diminuant pendant les périodes plus calmes. Entre 2022 et 2024, le coût de l'inférence de l'IA a été multiplié par 280, ce qui rend l'optimisation continue à la fois pratique et rentable. Le routage axé sur les coûts constitue une autre approche intéressante, car il permet d'orienter les tâches les plus simples vers des modèles légers tout en réservant les modèles gourmands en ressources à des besoins plus complexes. En outre, la sélection des types d'instances appropriés et l'utilisation d'instances ponctuelles pour les charges de travail qui peuvent tolérer des interruptions peuvent réduire les coûts de manière significative. Cependant, des garanties doivent être mises en place pour gérer efficacement les interruptions ponctuelles d'instances. Ces stratégies de dimensionnement garantissent un équilibre entre performances et rentabilité.

Le maintien de la fiabilité du système nécessite des mesures proactives. Les disjoncteurs peuvent bloquer le trafic vers les terminaux défaillants, tandis que la limitation du débit empêche les demandes excessives de surcharger le système. Des contrôles de santé réguliers permettent d'identifier et de supprimer les instances qui ne répondent pas, et une logique de nouvelle tentative avec retard exponentiel garantit que les demandes ayant échoué sont réessayées sans surcharger le système. La journalisation détaillée fournit une visibilité sur les performances du système, ce qui permet de résoudre rapidement les problèmes et de maintenir la résilience. Ensemble, ces pratiques constituent une base solide pour des opérations fiables.

Une fois que vos modèles sont opérationnels, il est essentiel de garder le contrôle, de garantir le bon fonctionnement et de maîtriser les coûts.

Gardez un œil sur l'ensemble de votre pipeline d'IA en temps réel grâce à des tableaux de bord qui suivent des indicateurs clés tels que les temps de réponse, la précision, l'utilisation des ressources, la fraîcheur des données et la latence. Des outils tels que Flux d'air Apache émettez des alertes en cas de baisse des performances ou de problèmes de qualité des données, afin que vous puissiez agir rapidement.

Prenons l'exemple d'un système de recommandation pour le commerce électronique. Les tableaux de bord surveillent les temps de réponse de plusieurs modèles et, en cas de pic de latence, le système ajuste automatiquement la répartition des tâches pour maintenir les performances. Des fonctionnalités telles que les nouvelles tentatives, les remblais et les objectifs de niveau de service (SLO) sont en place pour éviter les échecs en cascade. Cette surveillance en temps réel garantit non seulement des performances fluides, mais soutient également les efforts de gouvernance visant à respecter les normes de conformité.

Des cadres de gouvernance solides sont essentiels pour gérer l'accès, suivre les versions et maintenir la conformité aux réglementations telles que SOC 2 et HIPAA. En capturant les métadonnées relatives aux expériences, aux ensembles de données et aux essais, vous créez des pistes d'audit claires. Des outils tels que l'intégration Open Lineage d'Airflow permettent de suivre le lignage des données dans les flux de travail, tandis que la conteneurisation et la gestion sécurisée des informations d'identification protègent les informations sensibles. Cette approche de gouvernance s'intègre parfaitement à l'architecture d'orchestration évoquée précédemment.

Prompts.ai a obtenu la certification SOC 2 Type 2 le 19 juin 2025, ce qui témoigne de son engagement en matière de conformité et de surveillance continue. Les fonctionnalités de surveillance de la conformité et d'administration de la gouvernance de la plateforme offrent une visibilité et un suivi complets de toutes les activités liées à l'IA. Chaque approbation, chaque annulation et chaque mise à jour de version sont systématiquement enregistrées, ce qui garantit le respect des exigences réglementaires tout en favorisant la confiance. Ce modèle de gouvernance robuste soutient également la supervision financière, en alignant les performances opérationnelles sur la gestion des coûts.

La compréhension et la gestion des coûts sont tout aussi importantes que les performances techniques. En suivant les dépenses des modèles en dollars américains, les organisations peuvent directement lier les dépenses liées à l'IA aux objectifs commerciaux. Les tableaux de bord en temps réel et les alertes budgétaires apportent de la clarté, tandis que le routage axé sur les coûts permet d'identifier les problèmes d'efficacité, tels que l'utilisation de modèles trop complexes pour des tâches simples. La couche FinOps de Prompts.ai, alimentée par des crédits TOKN, permet aux entreprises de surveiller les habitudes d'utilisation et de définir des budgets pour éviter les dépenses excessives.

Un exemple de cette efficacité : les organisations ont réduit leurs coûts d'IA jusqu'à 98 % en consolidant plus de 35 outils d'IA distincts sur une seule plateforme. Cette évolution transforme les coûts fixes en solutions évolutives à la demande. Des examens réguliers de l'allocation des ressources garantissent que les modèles sont correctement dimensionnés pour leurs tâches. Dans les projets d'annotation géospatiale, l'orchestration répartit les charges de travail entre les modèles afin de réduire les coûts de traitement et les erreurs. En combinant le déploiement modulaire et l'intégration dans le cloud pour les modèles hybrides, les entreprises s'assurent que chaque dollar dépensé se traduit par des gains mesurables, tels qu'un traitement des données plus rapide et une efficacité accrue. Cette surveillance financière continue renforce les avantages économiques de la stratégie d'orchestration de Prompts.ai.

La gestion efficace des modèles d'apprentissage automatique (ML) est cruciale pour garantir des opérations d'IA fiables, rentables et conformes. En utilisant des structures d'orchestration en couches, en gérant les dépendances des flux de travail et en permettant une interopérabilité fluide des systèmes, les entreprises peuvent gérer efficacement plusieurs modèles et flux de données du début à la fin.

Au-delà des aspects techniques, une gouvernance solide et une surveillance approfondie constituent l'épine dorsale de systèmes d'IA fiables. Une observabilité complète, qui permet de suivre des indicateurs tels que les temps de réponse, la précision, la consommation de ressources et les coûts, associée au respect de normes telles que SOC 2 et HIPAA, garantit la conformité réglementaire tout en simplifiant la résolution des problèmes. Ces mesures répondent non seulement aux exigences légales, mais donnent également la certitude que les systèmes d'IA fonctionnent comme prévu et apportent une valeur mesurable à l'entreprise.

La gestion des coûts ancrée dans les principes FinOps permet de réduire davantage les dépenses liées à l'IA. La mise à l'échelle dynamique de l'infrastructure en fonction de la demande, l'utilisation de modèles légers pour des tâches plus simples et le suivi des dépenses en temps réel peuvent réduire considérablement les coûts. Les organisations qui utilisent des plateformes d'orchestration unifiées ont réalisé des économies considérables en rationalisant leurs outils et leurs processus.

Prompts.ai va encore plus loin en intégrant plus de 35 modèles d'IA de pointe sur une seule plateforme. Avec des outils de gouvernance intégrés, un suivi de la conformité et une couche FinOps alimentée par des crédits TOKN, la plateforme offre une visibilité et une auditabilité complètes pour toutes les activités d'IA. Cela permet aux équipes de déployer, de faire évoluer et d'optimiser des modèles sans avoir à jongler avec plusieurs outils.

La voie à suivre est simple : mettre en œuvre des stratégies d'orchestration qui allient efficacité technique, gouvernance solide et gestion claire des coûts. En traitant les modèles comme des composants interconnectés et orchestrés plutôt que comme des outils isolés, les entreprises peuvent se concentrer sur l'innovation et obtenir des résultats significatifs, en laissant de côté les défis liés à l'infrastructure.

L'orchestration de l'apprentissage automatique apporte de nombreux avantages pour affiner et optimiser vos flux de travail d'IA. Pour commencer, il améliore évolutivité, vous permettant de gérer et de déployer efficacement plusieurs modèles dans divers environnements. Cela garantit que vos systèmes peuvent évoluer et s'adapter à l'augmentation de la demande.

Il améliore également efficacité en automatisant les tâches répétitives et en rationalisant les processus, ce qui permet d'économiser du temps et des ressources précieuses. Au-delà de cela, l'orchestration favorise collaboration en intégrant de manière fluide les outils et les flux de travail, rendant le travail d'équipe plus fluide et plus efficace.

La fiabilité constitue un autre avantage : la surveillance et l'optimisation en temps réel garantissent des performances constantes de vos modèles. De plus, il renforce gouvernance et conformité en fournissant une supervision et un contrôle clairs, vous donnant la confiance nécessaire pour respecter les normes réglementaires sans tracas.

Une architecture en couches divise les flux de travail d'apprentissage automatique en segments distincts et gérables, garantissant ainsi répartition claire des responsabilités. Chaque couche se concentre sur une tâche spécifique, qu'il s'agisse du prétraitement des données, de la formation de modèles, de la validation, du déploiement ou de la surveillance, ce qui permet à ces fonctions de fonctionner indépendamment. Cette structure simplifie non seulement les mises à jour, mais améliore également évolutivité et rend le dépannage beaucoup plus efficace.

En segmentant les flux de travail en couches, les ressources peuvent être allouées de manière plus stratégique, ce qui améliore la tolérance aux pannes et rationalise le contrôle des versions. Cette méthode organisée favorise une collaboration plus fluide et soutient le développement de systèmes d'IA fiables qui correspondent à vos objectifs.

Pour rendre la mise à l'échelle et le déploiement de modèles d'IA plus fluides et plus économiques, priorisez automatisation, gestion intelligente des ressources, et suivi en temps réel. Intégrez des outils tels que des pipelines CI/CD automatisés pour simplifier les processus de déploiement et réduire les tâches manuelles. L'allocation dynamique des ressources garantit que la puissance de calcul n'est utilisée que lorsque cela est nécessaire, ce qui permet d'éviter des coûts supplémentaires.

Configurez des systèmes de surveillance en temps réel pour garder un œil sur les performances des modèles et la consommation de ressources. Cela permet des ajustements rapides pour optimiser l'efficacité et gérer les dépenses de manière efficace. En intégrant ces approches, vous pouvez créer des flux de travail d'IA évolutifs, fiables et respectueux des coûts.

{» @context « : » https://schema.org","@type":"FAQPage","mainEntity":[{"@type":"Question","name":"What Quels sont les principaux avantages de l'orchestration de modèles d'apprentissage automatique ? » , « AcceptedAnswer » : {» @type « :"Answer », "text » : » L'<p>orchestration de l'apprentissage automatique apporte de nombreux avantages pour affiner et optimiser vos flux de travail d'IA. Tout d'abord, il améliore l'<strong>évolutivité</strong>, vous permettant de gérer et de déployer efficacement plusieurs modèles dans divers environnements. Cela garantit que vos systèmes peuvent évoluer et s'adapter à l'augmentation de la demande.</p> <p>Il améliore également <strong>l'efficacité</strong> en automatisant les tâches répétitives et en rationalisant les processus, ce qui permet d'économiser du temps et des ressources précieuses. Au-delà de cela, l'orchestration favorise la <strong>collaboration</strong> en intégrant de manière fluide les outils et les flux de travail, ce qui rend le travail d'équipe plus fluide et plus efficace</p>. <p>La fiabilité constitue un autre avantage : la surveillance et l'optimisation en temps réel garantissent des performances constantes de vos modèles. De plus, il renforce <strong>la gouvernance et la conformité</strong> en fournissant une supervision et un contrôle clairs, ce qui vous donne la confiance nécessaire pour respecter les normes réglementaires sans tracas</p>. «}}, {» @type « :"Question », "name » :"Quels sont les avantages de l'utilisation d'une architecture en couches pour orchestrer des modèles d'apprentissage automatique ? » <strong>, « AcceptedAnswer » : {» @type « :"Answer », "text » : » Une architecture en couches divise les flux de travail d'apprentissage automatique en segments distincts et gérables, garantissant une répartition claire des responsabilités.</strong> <p> Chaque couche se concentre sur une tâche spécifique, qu'il s'agisse du prétraitement des données, de la formation de modèles, de la validation, du déploiement ou de la surveillance, ce qui permet à ces fonctions de fonctionner indépendamment. Cette structure simplifie non seulement les mises à jour, mais améliore également l'<strong>évolutivité</strong> et rend le dépannage beaucoup plus efficace</p>. <p>En segmentant les flux de travail en couches, les ressources peuvent être allouées de manière plus stratégique, ce qui améliore la tolérance aux pannes et rationalise le contrôle des versions. Cette méthode organisée favorise une collaboration plus fluide et soutient le développement de systèmes d'IA fiables qui correspondent à vos objectifs</p>. «}}, {» @type « :"Question », "name » :"Comment puis-je faire évoluer et déployer des modèles d'IA de manière efficace tout en minimisant les coûts ? » <strong>, « AcceptedAnswer » : {» @type « :"Answer », "text » : » Pour rendre la mise à l'échelle et le déploiement de modèles d'IA plus fluides et plus économiques, donnez la priorité à l'<strong>automatisation</strong>, à la gestion <strong>intelligente</strong> des ressources et au suivi en temps réel.</strong> <p> Intégrez des outils tels que des pipelines CI/CD automatisés pour simplifier les processus de déploiement et réduire les tâches manuelles. L'allocation dynamique des ressources garantit que la puissance de calcul n'est utilisée que lorsque cela est nécessaire, ce qui permet d'éviter des coûts supplémentaires</p>. <p>Configurez des systèmes de surveillance en temps réel pour garder un œil sur les performances des modèles et la consommation de ressources. Cela permet des ajustements rapides pour optimiser l'efficacité et gérer les dépenses de manière efficace. En intégrant ces approches, vous pouvez créer des flux de travail d'IA évolutifs, fiables et respectueux des coûts</p>. «}}]}