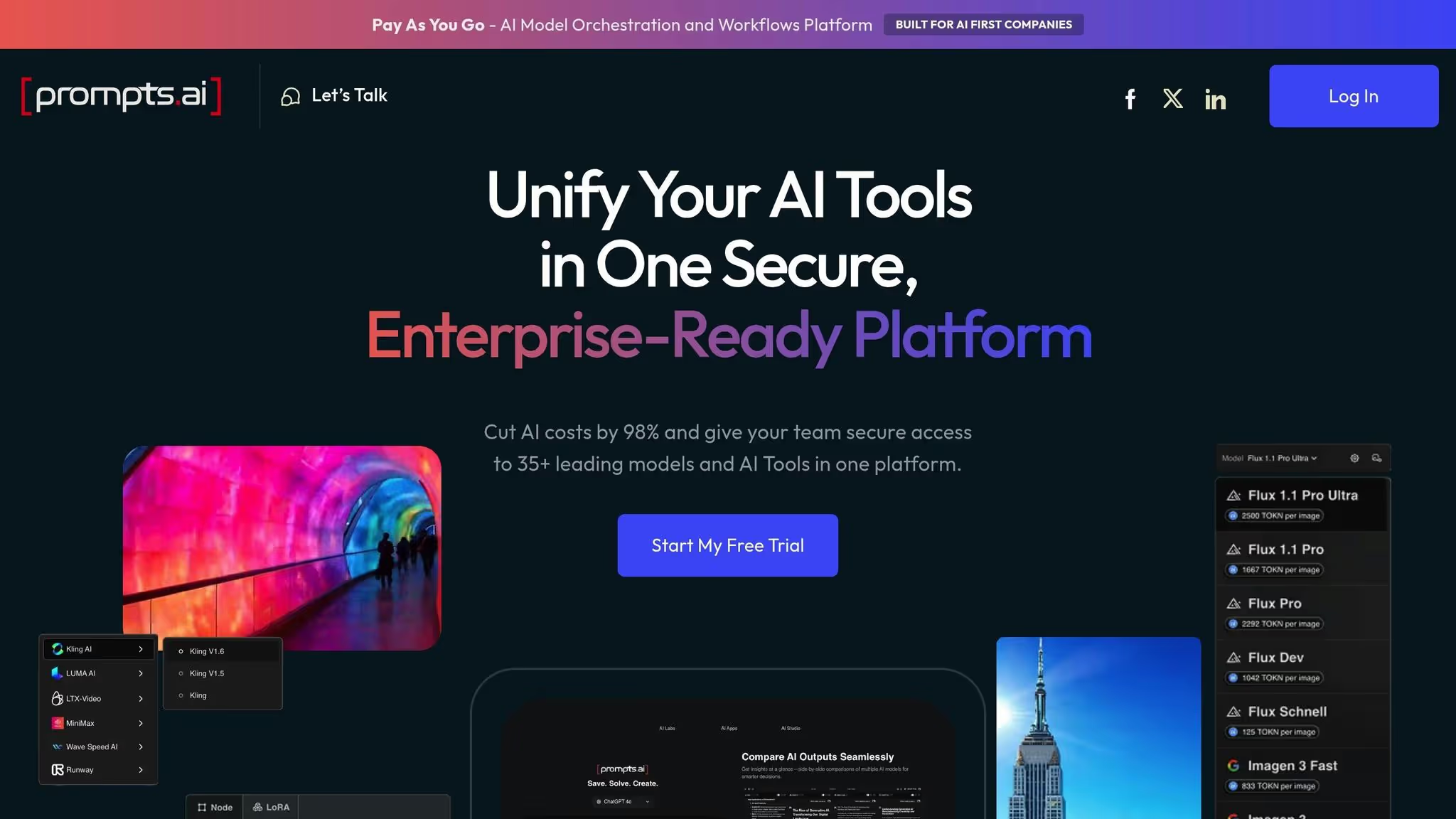

Quel modèle d'IA convient le mieux à votre entreprise ? Voici la réponse courte : cela dépend de vos priorités : rapidité, coût ou capacité. D'ici décembre 2025, les entreprises tireront parti stratégies multimodèles pour équilibrer les performances et les dépenses. Des outils tels que Prompts.ai simplifier ce processus en intégrant Plus de 35 modèles phares sur une plateforme unique, vous permettant de comparer, de gérer et d'optimiser l'utilisation en temps réel.

Avec Prompts.ai, vous faites un pas de plus vers des flux de travail d'IA plus intelligents, évolutifs et rentables.

Tableau comparatif LLM : performances, vitesse, coût et contexte Windows 2025

En décembre 2025, le paysage des grands modèles linguistiques (LLM) a évolué pour devenir un espace concurrentiel dominé par quatre modèles remarquables, chacun excellant dans des applications d'entreprise spécifiques. GPT-5.2 est à la pointe en termes de rapidité, traitant 187 jetons par seconde, soit 3,8 fois plus vite que Claude, ce qui en fait le choix idéal pour les interactions en temps réel avec les clients et les agents conversationnels. Il a également obtenu un score impressionnant de 70,9 % sur le PIB Val, égalant pour la première fois la performance des experts humains dans 44 professions. D'autre part, Claude Opus 4.5 a placé la barre très haut en matière de capacités de codage, obtenant un score de 80,9 % sur SWE-Bench Verified. Gémeaux 3 Pro a battu des records avec un score Elo de 1 501 au classement LMArena et se distingue par sa capacité à traiter le texte, les images, la vidéo et l'audio au sein d'une architecture unique. Enfin, Lama 4 Scout offre des fonctionnalités contextuelles inégalées, avec une fenêtre contenant jusqu'à 10 millions de jetons, permettant aux entreprises de gérer de vastes bases de code ou des archives de documents en un seul passage.

L'écart entre les modèles open source et les modèles propriétaires s'est presque réduit, passant de 17,5 % à seulement 0,3 point de pourcentage par rapport à l'indice de référence MMLU en un an. Ce changement a des implications financières majeures : alors que Claude Opus 4.5 coûte 5 dollars par million de jetons d'entrée, DeepSeek V3.2 offre des performances de classification similaires pour seulement 0,28 dollar, soit une réduction de 94 %. Prompts.ai intègre ces modèles dans une plateforme unique, permettant aux équipes d'attribuer les tâches de manière stratégique, en utilisant des options économiques pour des tâches plus simples et en réservant des modèles haut de gamme pour des raisonnements complexes. Cette approche permet généralement aux entreprises d'économiser de 40 à 60 % sur les dépenses liées à l'IA.

« Le choix entre ChatGPT, Claude et Gemini en décembre 2025 reflète un marché mûr avec des spécialisations claires. » - Rapport de comparaison d'Aloa AI

Ces distinctions ouvrent la voie à un examen plus approfondi des points forts et des applications spécialisées de chaque modèle.

Le GPT-5.2 est conçu pour les tâches nécessitant à la fois rapidité et précision, grâce à ses capacités de raisonnement dynamique qui s'adaptent à la complexité des tâches. Comparé au GPT-4, il réduit les erreurs factuelles jusqu'à 80 %, ce qui en fait un outil fiable pour les applications destinées aux clients où la précision est essentielle. Avec un prix de 1,75$ par million de jetons d'entrée et de 14 dollars pour les jetons de sortie, plus une réduction de 90 % sur les entrées mises en cache, il offre une rentabilité pour les flux de travail répétitifs tels que la synthèse de documents ou l'automatisation des FAQ. Grâce à l'API unifiée de Prompts.ai, les équipes peuvent facilement intégrer GPT-5.2 à leurs flux de travail, en accédant à ses fonctionnalités sans avoir à gérer des comptes ou des systèmes de facturation distincts.

Claude Opus 4.5 brille dans les secteurs soumis à des exigences réglementaires strictes, tels que la santé, la finance et les services juridiques, grâce à ses directives éthiques intégrées. Au-delà de son expertise en matière de codage, elle peut exécuter des tâches de manière autonome pendant plus de 30 heures, en gérant des processus complexes tels que la création de pipelines de données ou la réalisation d'audits de conformité. Sa fenêtre contextuelle couvre 200 000 jetons en mode standard et jusqu'à 1 million de jetons en version bêta, ce qui la rend idéale pour analyser de longs documents tels que des contrats ou des articles de recherche. Avec une politique de conservation zéro des données et une réduction de 90 % sur les entrées mises en cache, Claude est également rentable pour les flux de travail qui accordent la priorité à la confidentialité. Prompts.ai offre un accès direct aux fonctionnalités d'entreprise de Claude, notamment la surveillance des jetons en temps réel et des outils de conformité conformes aux normes GDPR et SOC 2.

La conception flexible de LLama 4 permet aux entreprises d'héberger elles-mêmes le modèle, garantissant ainsi une confidentialité totale des données et éliminant les frais par jeton. Les coûts sont limités aux ressources de calcul. Cela en fait un excellent choix pour les tâches à volume élevé telles que la classification par lots ou pour les environnements nécessitant des déploiements isolés. La fenêtre contextuelle de 10 millions de jetons de la variante Scout surpasse ses concurrents propriétaires, ce qui la rend idéale pour les flux de travail de génération augmentée par extraction (RAG) qui exploitent de vastes bases de connaissances internes sans avoir besoin de découpage ou de résumé. Prompts.ai simplifie le déploiement de LLama, permettant aux équipes de tester des modèles open source parallèlement à des modèles propriétaires et de basculer de manière fluide en fonction des demandes de charge de travail.

Gemini 3 Pro propose une architecture de transformateur unifiée capable de traiter simultanément du texte, des images, du son, de la vidéo et du code, éliminant ainsi le besoin d'étapes de prétraitement distinctes. Avec une fenêtre contextuelle allant de 1 million à 2 millions de jetons (selon le niveau de l'entreprise), il excelle dans les tâches nécessitant beaucoup de recherche, telles que l'analyse de bibliothèques vidéo étendues ou la gestion de campagnes marketing multimédia. Au prix de 2 dollars par million de jetons d'entrée et de 12 dollars pour les jetons de sortie, Gemini équilibre performance et rentabilité et s'intègre parfaitement à Espace de travail Google. Prompts.ai permet aux utilisateurs de comparer Gemini directement avec GPT-5.2 et Claude en utilisant des instructions identiques, ce qui permet aux entreprises d'évaluer les performances multimodales et de sélectionner le modèle le mieux adapté à leurs besoins sans dépendre d'un fournisseur.

Lors de l'évaluation des principaux modèles linguistiques, quatre indicateurs essentiels entrent en jeu : compétence en matière de codage (Vérifié par SWE-Bench), profondeur de raisonnement (GPQA Diamond et ARC-AGI-2), vitesse d'inférence (jetons par seconde), et capacité contextuelle. Chaque modèle a ses points forts, ce qui les rend adaptés à différentes tâches. Pour les benchmarks de codage, Claude Opus 4.5 est en tête avec un score de 80,9 %, légèrement devant GPT-5.2 à 80,0 %, tandis que Gémeaux 3 Pro suit à 76,8 %. En ce qui concerne les tâches de raisonnement nécessitant une expertise avancée, GPT-5.2 surpasse avec un score de 92,4 % sur GPQA Diamond, avec Gémeaux 3 Pro se situe juste derrière à 91,9 %.

La vitesse est un autre facteur de différenciation. GPT-5.2 traite 187 jetons par seconde, soit 3,8 fois plus vite que les 49 jetons par seconde de Claude Opus 4.5. Cet avantage de rapidité fait du GPT-5.2 un excellent choix pour les applications telles que les chatbots orientés vers les clients, où des temps de réponse rapides sont essentiels.

Il est intéressant de noter que l'écart de performance entre les modèles open source et les modèles propriétaires a presque disparu selon l'indice de référence MMLU, passant de 17,5 points de pourcentage à seulement 0,3 en un an. Grâce à ces progrès, les entreprises peuvent désormais déployer en toute confiance des modèles auto-hébergés tels que Lama 4 pour les tâches où la confidentialité est primordiale, tout en réservant les modèles haut de gamme au raisonnement avancé ou aux applications multimodales. Ces indicateurs mettent en évidence la manière dont chaque modèle s'aligne sur les besoins spécifiques de l'entreprise.

Le choix d'un modèle linguistique dépend fortement de la tâche à accomplir. Pour support client en temps réel, GPT-5.2 est l'option la plus remarquable, délivrant 500 jetons en seulement 2,7 secondes, contre 10,2 secondes pour Claude Opus 4.5. Quand il s'agit de développement de code de production, Claude Opus 4.5 excelle avec son meilleur score sur SWE-Bench Verified, démontrant ainsi sa capacité à résoudre des problèmes réels liés à GitHub. Pour recherche et analyse de documents, Gémeaux 3 Pro se distingue par sa vaste fenêtre contextuelle de 1 million à 2 millions de jetons, permettant aux utilisateurs de traiter des bases de code entières ou plusieurs articles de recherche en une seule requête, offrant ainsi une capacité 2,5 fois supérieure aux 400 000 jetons de GPT-5.2.

« La stratégie optimale n'est plus « quel modèle unique devons-nous utiliser ? » mais « quels modèles pour quelles tâches ? » - Numérique appliqué

En adoptant une approche multimodèle, les entreprises peuvent économiser de 40 % à 60 % sur leurs coûts. Par exemple, des tâches plus simples telles que la classification peuvent tirer parti de modèles rentables tels que DeepSeek V3.2, tandis que les tâches de raisonnement complexes conviennent mieux à Claude Opus 4.5 ou GPT-5.2. Cette approche personnalisée garantit que les ressources sont allouées de manière judicieuse, en équilibrant performance et rentabilité.

Le coût d'utilisation des modèles linguistiques varie considérablement, les prix étant influencés par des facteurs tels que les taux d'API, la correction des erreurs et les efforts d'intégration. Des fournisseurs tels que Anthropique et IA ouverte offrir mise en cache rapide et traitement par lots pour réduire les dépenses. Les jetons d'entrée mis en cache peuvent réduire les coûts jusqu'à 90 %, tandis que les tâches d'API par lots en temps réel, telles que la génération de rapports du jour au lendemain, bénéficient de remises allant jusqu'à 50 %. Des outils tels que Prompts.ai simplifient ces optimisations en proposant un tableau de bord unifié qui suit l'utilisation des jetons, automatise le routage des tâches en fonction de seuils de performance et fournit des contrôles FinOps en temps réel. Ces fonctionnalités aident les équipes à surveiller les dépenses, à définir des alertes budgétaires et à appliquer les politiques d'utilisation sans supervision manuelle.

La gouvernance joue également un rôle crucial dans la sélection des modèles. Alors que la plupart des fournisseurs répondent à des normes telles que le SOC 2 Type II et le RGPD, seuls Claude Opus 4.5 et GPT-5.2 proposent des accords de partenariat commercial HIPAA, les rendant adaptés aux applications de santé. La résidence des données est un autre facteur clé ; par exemple, DeepSeek traite les données relatives aux infrastructures basées en Chine, qui peuvent entrer en conflit avec les réglementations dans des secteurs tels que la finance ou le gouvernement. Prompts.ai répond à ces défis en proposant des comparaisons et des pistes d'audit côte à côte, garantissant ainsi que les exigences de conformité sont systématiquement respectées sur tous les modèles.

Pour sélectionner le bon modèle linguistique, il faut trouver un équilibre entre intelligence et rentabilité. Des modèles très performants tels que Gémeaux 3 Pro et GPT-5.2 excellent dans la gestion de tâches complexes telles que le raisonnement en plusieurs étapes, le codage avancé et l'analyse stratégique, même si elles entraînent des coûts symboliques plus élevés. Par exemple, des tâches plus simples peuvent être orientées vers des options rentables telles que DeepSeek V3.2, qui ne coûte que 0,28$ par million de jetons d'entrée, tout en réservant les modèles haut de gamme aux tâches les plus exigeantes.

La vitesse est un autre facteur essentiel, en particulier pour les applications en temps réel telles que les chatbots du service client ou les assistants vocaux en direct. GPT-5.2 les processus 187 jetons par seconde, ce qui le rend 3,8 fois plus rapide que Claude Opus 4.5, qui gère uniquement 49 jetons par seconde. Toutefois, pour le traitement par lots ou l'analyse de données à grande échelle où aucune réponse immédiate n'est requise, vous pouvez donner la priorité à d'autres facteurs, tels que la profondeur du raisonnement ou le coût, par rapport à la vitesse.

Lorsque vous travaillez avec de grands ensembles de données ou de longs documents, taille de la fenêtre contextuelle devient indispensable. Des modèles comme Lama 4 Scout proposer une fenêtre contextuelle pouvant aller jusqu'à 10 millions de jetons, permettant une analyse complète de bases de code complètes, de documents de recherche ou de documents juridiques en une seule requête. Cette fonctionnalité est particulièrement utile dans Génération augmentée par récupération (RAG) les flux de travail, dans lesquels de grands volumes de connaissances doivent être intégrés sans devoir reformer le modèle. Pour les tâches standard, des fenêtres contextuelles plus petites sont généralement suffisantes et plus économiques.

Le choix entre un modèle axé sur le raisonnement et un modèle conversationnel dépend de la nature de vos tâches. GPT-5.2 est idéal pour les activités nécessitant beaucoup de logique, telles que le codage, les calculs mathématiques et la résolution de problèmes complexes, tandis que Claude Opus 4.5 se distingue par ses dialogues nuancés, son adaptation du ton et sa création de contenu, ce qui en fait un outil idéal pour le support client ou les tâches nécessitant une touche personnelle. En outre, déterminez si vous avez besoin de modèles propriétaires pour faciliter l'accès aux API ou de modèles libres tels que Lama 4 pour un déploiement privé, des ajustements et un contrôle renforcé des données sensibles. Avec Prompts.ai, vous pouvez affiner votre sélection grâce à des comparaisons côte à côte en temps réel de ces critères.

Prompts.ai simplifie le processus d'évaluation des modèles de langage en activant comparaisons côte à côte en temps réel. Au lieu de vous limiter à un seul fournisseur, vous pouvez tester la même invite sur plusieurs modèles tels que GPT-5.2, Claude Opus 4.5, et Gémeaux 3 Pro pour déterminer laquelle offre les meilleurs résultats pour vos besoins spécifiques. Cette approche indépendante du fournisseur garantit la flexibilité, vous permettant de passer facilement d'un modèle à l'autre, par exemple en utilisant GPT-5.2 pour les tâches nécessitant beaucoup de logique et Claude pour du contenu créatif, sans perturber les flux de travail.

La plateforme fonctionne sur système de crédit TOKN à paiement à l'utilisation, vous ne payez que ce que vous consommez, évitant ainsi des abonnements mensuels coûteux. Cela est particulièrement utile compte tenu du rythme rapide des progrès de l'IA. Prompts.ai propose également Contrôles FinOps via un tableau de bord unifié, permettant de suivre facilement l'utilisation des jetons, de surveiller les dépenses et de définir des alertes budgétaires. Vous pouvez même automatiser le routage des tâches en fonction de seuils de performance, en dirigeant les tâches simples vers des modèles économiques tout en réservant des options premium pour des raisonnements complexes. Cette approche multimodèle peut entraîner d'importantes économies de coûts.

Outre la gestion des coûts, Prompts.ai fournit flux de travail prédéfinis appelés « Time Savers », qui sont des modèles prêts à l'emploi pour les tâches liées aux ventes, au marketing et aux opérations. Ces modèles normalisent l'ingénierie rapide au sein de votre équipe, garantissant ainsi des résultats cohérents lors du passage d'un modèle à l'autre. La plateforme prend également en charge flux de travail personnalisés en utilisant les LoRas (Low-Rank Adaptations), réduisant ainsi le temps nécessaire aux tâches exigeantes telles que le rendu et la création de propositions. Avec accès à plus de 35 LLM de premier plan grâce à une interface unique, vous pouvez vous adapter rapidement aux nouveaux modèles au fur et à mesure de leur apparition sans devoir remanier votre infrastructure.

L'interopérabilité commence par la standardisation de la structure des instructions sur les différents modèles. En définissant des éléments tels que le rôle, la tâche, l'exemple de sortie et les exclusions, vous pouvez obtenir des résultats cohérents, que vous utilisiez GPT-5.2, Claude Opus 4.5, ou des modèles à poids ouvert tels que Lama 4. Prompts.ai y contribue en gérant une bibliothèque d'invites centralisée, en rendant les invites raffinées facilement accessibles à votre équipe et en simplifiant l'intégration dans les flux de travail.

« Reconnaissez le potentiel de l'IA et considérez-la comme un jeune employé inexpérimenté mais brillant capable d'améliorer de manière significative, voire de remplacer l'ensemble de votre équipe. » - Fedor Pak, PDG de Chatfuel

Les exigences de conformité varient en fonction du secteur et de la région. Alors que de nombreux fournisseurs adhèrent à des normes telles que SOC 2 Type II et GDPR, seules quelques offres Contrats de partenariat commercial HIPAA pour les applications de santé. Prompts.ai garantit une sécurité de niveau professionnel grâce à des pistes d'audit complètes, vous permettant de suivre chaque interaction avec l'IA pour les examens réglementaires. La plateforme vous permet également d'appliquer des politiques d'utilisation, de répondre aux exigences de résidence des données et de protéger les informations sensibles, en particulier lors du déploiement de modèles open weight sur une infrastructure privée.

Pour les organisations qui gèrent des données propriétaires, Génération augmentée par récupération (RAG) offre un moyen sécurisé d'intégrer des connaissances dans des modèles sans exposer d'informations sensibles. Prompts.ai prend en charge les flux de travail RAG, vous donnant un contrôle total sur vos données tout en tirant parti des fonctionnalités LLM de premier plan. De plus, la plateforme comprend caractéristiques d'alignement délibératif, qui vérifient les décisions par rapport aux directives de sécurité avant leur exécution, ce qui constitue une garantie essentielle pour les secteurs à enjeux élevés tels que la finance, la santé ou les services juridiques. En combinant des outils de conformité robustes avec la flexibilité de passer d'un modèle à l'autre, Prompts.ai vous permet de respecter les normes réglementaires sans compromettre les performances ou l'efficacité.

Choisir le bon modèle de langage étendu (LLM) revient à trouver un équilibre entre performances, coûts et conformité. Il n'existe plus de modèle unique capable de répondre à tous les besoins des entreprises. Au lieu de cela, les entreprises adoptent stratégies multimodèles, en attribuant des tâches spécifiques aux modèles qui leur conviennent le mieux, qu'il s'agisse de vitesse, de capacités de codage ou de gestion de données contextuelles longues. Cette approche ciblée améliore non seulement les performances, mais simplifie également les flux de travail.

Les différences de coûts entre les modèles sont frappantes, certaines options budgétaires étant 94 % moins cher par rapport à ceux haut de gamme. Les entreprises peuvent économiser 40 à 60 % sur les frais en utilisant des modèles abordables pour des tâches simples et en réservant des modèles plus coûteux à des opérations plus complexes. En outre, garantir la conformité à des normes telles que SOC 2, HIPAA, et GDPR est essentiel pour des déploiements sécurisés, en particulier dans les secteurs réglementés.

Prompts.ai simplifie la gestion et l'intégration de plusieurs LLM. Avec accès à plus de 35 modèles phares via une interface unique et un système de crédit TOKN à paiement à l'utilisation, vous ne payez que ce que vous consommez. De plus, vous pouvez commencer à expérimenter avec 100 000 jetons gratuits, vous permettant de comparer les modèles côte à côte et d'identifier celui qui convient le mieux à vos flux de travail professionnels.

La plateforme outils de comparaison en temps réel vous permettent d'évaluer des modèles en fonction de tâches réelles, tout en étant intégrés Contrôles FinOps suivez l'utilisation des jetons, définissez des limites budgétaires et automatisez la répartition des tâches. Pré-conçu Gains de temps les modèles et les flux de travail personnalisés simplifient l'ingénierie rapide, garantissant des résultats cohérents au sein de votre équipe. Qu'il s'agisse de gérer les robots du service client, de traiter des documents complexes ou d'écrire du code avancé, Prompts.ai vous offre la flexibilité et le contrôle nécessaires pour faire évoluer l'IA sans devoir faire appel à un seul fournisseur.

L'utilisation de différents modèles de langage vous permet d'aligner chaque tâche sur le modèle qui répond le mieux à ses besoins en termes de complexité et de coût. Par exemple, des modèles performants tels que GPT-4 sont idéales pour les tâches exigeantes telles que le raisonnement avancé ou la génération de code, tandis que les tâches plus simples telles que la synthèse ou la classification peuvent être gérées par des modèles plus rapides et plus économiques. Cette approche vous permet d'obtenir les résultats dont vous avez besoin sans dépenses inutiles.

En réservant des modèles haut de gamme pour les tâches critiques et en utilisant des modèles moins coûteux pour les tâches de routine, les organisations peuvent souvent réaliser des économies 40 à 60 % sur les coûts sans compromettre la qualité. Les systèmes automatisés peuvent aller encore plus loin en choisissant dynamiquement le modèle le mieux adapté à chaque demande, en optimisant la vitesse, les coûts et la précision de tous les flux de travail.

GPT-5.2 et Claude Opus 4.5 chacun apporte des atouts distincts, ce qui les rend parfaitement adaptés à des besoins différents.

Claude Opus 4.5 brille dans les tâches de codage, offrant une précision d'environ 80 % sur les benchmarks de génie logiciel. Il met l'accent sur la sécurité, un raisonnement réfléchi et une défense solide contre les attaques par injection rapide. Ces qualités en font un choix fiable pour les tâches délicates ou l'écriture complexe qui exige précision et soin.

Entre-temps, GPT-5.2 excelle dans le raisonnement abstrait, les mathématiques et les connaissances professionnelles. Il obtient des résultats de premier ordre en matière de raisonnement et de mathématiques et traite le texte environ 3,8 fois plus rapidement que Claude Opus 4.5. Cet avantage de vitesse en fait une option remarquable pour les scénarios en temps réel ou à faible latence.

Si vous vous concentrez sur la précision du codage et les tâches critiques pour la sécurité, Claude Opus 4.5 c'est la voie à suivre. Pour les tâches nécessitant un traitement rapide, la résolution de problèmes complexes en mathématiques ou une expertise professionnelle, GPT-5.2 est la meilleure solution.

Prompts.ai met fortement l'accent sur confidentialité des données en incorporant des protocoles de sécurité de haut niveau et des mesures de conformité complètes. En centralisant les flux de travail d'IA au sein d'une couche d'orchestration sécurisée, la plateforme garantit la protection des données des utilisateurs et évite toute exposition à des terminaux tiers non gérés.

La protection des données est renforcée avec chiffrement en transit et au repos, tandis que l'accès est étroitement contrôlé par autorisations basées sur les rôles et des journaux d'audit détaillés. Cette configuration protège non seulement les informations sensibles, mais assure également une transparence totale pour les audits réglementaires. Le suivi en temps réel des coûts et de l'utilisation de la plateforme sert également de journal d'activité, permettant aux entreprises de s'aligner sur les réglementations telles que le CCPA, le RGPD et d'autres exigences spécifiques au secteur. Ces fonctionnalités font de Prompts.ai une solution fiable pour les entreprises américaines qui accordent la priorité à la sécurité et à la conformité réglementaire.