Réduisez la complexité de l'IA en toute simplicité. La gestion efficace des flux de travail liés à l'IA n'est plus seulement un défi, c'est une nécessité pour les entreprises qui souhaitent rester compétitives. De l'intégration des outils à la mise à l'échelle des opérations, la bonne plateforme permet de gagner du temps, de réduire les coûts et de garantir la conformité. Cet article passe en revue dix plateformes qui excellent dans Orchestration de l'IA, mettant en avant leurs points forts dans interopérabilité, évolutivité, gestion des coûts, gouvernance, et collaboration.

Le choix de la bonne plateforme dépend des besoins de votre organisation, qu'il s'agisse rentabilité, conformité ou évolutivité. Commencez par évaluer vos outils et vos défis actuels, puis associez-les à une plateforme qui fournit des résultats mesurables.

Prompts.ai regroupe plus de 35 modèles linguistiques de premier plan sur une seule plateforme sécurisée et centralisée. En résolvant le problème croissant de la prolifération des outils d'IA, il offre une gouvernance de niveau entreprise et aide les organisations à réduire leurs coûts jusqu'à 98 % lors de la consolidation de plusieurs abonnements AI en une seule solution.

La plateforme se connecte sans effort à divers systèmes d'entreprise grâce à de robustes intégrations d'API et à des formats de données standard. Il prend en charge nativement les API JSON, CSV et RESTful, permettant ainsi des flux de travail fluides sur plusieurs systèmes. Par exemple, une entreprise de vente au détail a utilisé Prompts.ai pour rationaliser le support client. En intégrant leur CRM, leurs chatbots alimentés par LLM et leur système de gestion des commandes, ils ont atteint résolution des requêtes en temps réel et l'acheminement automatique des billets.

L'architecture des connecteurs de Prompts.ai prend en charge les principaux fournisseurs de cloud tels qu'AWS, Azureet GCP, tout en prenant en charge les configurations sur site. Cette flexibilité permet aux entreprises de tirer parti de leur infrastructure actuelle tout en étendant progressivement les capacités d'orchestration de l'IA dans les environnements hybrides. Ce type d'adaptabilité permet une évolutivité dynamique.

Conçu pour une mise à l'échelle horizontale, Prompts.ai gère les demandes à volume élevé grâce à la conteneurisation et à l'allocation automatique des ressources. Son architecture est conçue pour évoluer avec les entreprises, leur permettant d'ajouter des modèles, des utilisateurs et des équipes en quelques minutes au lieu de devoir passer des mois à configurer.

Le système de crédit TOKN pay-as-you-go de la plateforme supprime les contraintes des abonnements traditionnels. Les entreprises peuvent adapter l'utilisation en fonction de la demande réelle, ce qui en fait la solution idéale pour les entreprises dont les charges de travail liées à l'IA fluctuent. Cette flexibilité garantit une allocation efficace des ressources sans surprovisionnement.

Prompts.ai répond à des normes strictes telles que HIPAA et GDPR grâce au cryptage AES-256, à la journalisation des audits et au contrôle d'accès basé sur les rôles (RBAC). Il suit également les versions et les modifications des flux de travail, offrant ainsi la transparence requise pour les secteurs réglementés.

Les tableaux de bord de surveillance en temps réel fournissent une vue claire de chaque interaction avec l'IA, aidant les équipes chargées de la conformité à suivre l'utilisation des données, les performances des modèles et l'activité des utilisateurs sur l'ensemble des flux de travail. Cela garantit que les organisations restent conformes tout en maintenant leur efficacité opérationnelle.

La plateforme comprend une couche FinOps qui suit les dépenses au niveau des jetons, offrant des analyses d'utilisation détaillées. Des fonctionnalités telles que les alertes budgétaires et les recommandations d'optimisation des ressources aident les organisations à aligner les dépenses liées à l'IA sur leurs objectifs commerciaux.

Les utilisateurs peuvent surveiller les coûts d'exécution des flux de travail en temps réel, définir des limites de dépenses pour des départements ou des projets spécifiques et recevoir des suggestions automatisées pour sélectionner des modèles en fonction des ratios performances/coûts. Ce niveau de contrôle permet d'éviter les dépassements budgétaires tout en permettant une croissance durable des capacités d'IA.

Prompts.ai favorise le travail d'équipe grâce à des espaces de travail partagés et à une édition collaborative en temps réel. Les équipes peuvent concevoir conjointement des flux d'orchestration, laisser des commentaires contextuels sur la logique d'invite et configurer des flux de travail d'approbation pour les processus sensibles.

La plateforme propose également un Programme de certification Prompt Engineer et accès à des modèles « Time Savers » conçus par des experts. Ces ressources créent un environnement collaboratif de partage des connaissances qui stimule la productivité des équipes. Grâce à des fonctionnalités telles que le contrôle des versions et le suivi des activités, plusieurs membres de l'équipe peuvent contribuer à des flux de travail complexes tout en restant responsables.

LLamaIndex fait le lien entre les grands modèles de langage (LLM) et les données externes, rationalisant ainsi la génération augmentée par extraction afin d'intégrer des bases de données propriétaires dans des flux de travail fluides.

LLamaIndex simplifie la connexion à diverses sources de données grâce à sa large gamme de connecteurs. Il fonctionne parfaitement avec les bases de données, les plateformes de stockage dans le cloud et les applications d'entreprise, permettant aux équipes de créer des pipelines de données unifiés sans avoir besoin de codage personnalisé. Grâce à sa structure modulaire, il s'intègre facilement aux bibliothèques d'apprentissage automatique et aux bases de données vectorielles les plus populaires. De plus, sa prise en charge du traitement multimodal lui permet de gérer du texte, des images et des données structurées au sein d'un flux de travail unique.

Le traitement des données à grande échelle est rendu efficace grâce à l'indexation hiérarchique et au traitement distribué de LLamaIndex. En divisant les charges de travail en tâches plus petites sur plusieurs nœuds, il garantit des requêtes rapides et des mises à jour en temps réel. Ses fonctionnalités de streaming permettent également un traitement continu des données et des mises à jour régulières des bases de connaissances, afin de maintenir les informations à jour.

LLamaIndex est conçu pour optimiser les coûts en gérant efficacement l'utilisation des jetons. Des fonctionnalités telles que le découpage intelligent et la mise en cache sémantique réduisent les appels d'API inutiles, tandis que le routage des requêtes garantit le choix du modèle le plus rentable en fonction de la complexité de chaque requête. Pour les entreprises qui cherchent à minimiser leurs dépenses, le framework prend également en charge des options de déploiement locales, réduisant ainsi la dépendance à l'égard des modèles basés sur le cloud.

La plateforme prend en charge la gestion partagée des index et le contrôle des versions, garantissant ainsi des mises à jour cohérentes entre les équipes. Il favorise la collaboration en permettant le partage de modèles de flux de travail prédéfinis. Les outils de débogage et de surveillance intégrés fournissent des informations claires sur l'exécution des requêtes et les performances du système, aidant ainsi les équipes à identifier et à corriger les inefficacités. Ces fonctionnalités soulignent le rôle de LLamaIndex dans la création de flux de travail d'IA efficaces et évolutifs.

Microsoft AutoGen présente un système multi-agents unique pour gérer les flux de travail d'IA. En orchestrant des agents d'IA autonomes dotés de rôles définis et en s'intégrant parfaitement à divers outils d'IA, AutoGen simplifie l'exécution de flux de travail complexes au sein de divers écosystèmes.

AutoGen est conçu pour fonctionner sur toutes les plateformes, en s'intégrant à des outils d'IA largement utilisés tels que Chaîne Lang, LlamaIndex et IA ouverte Assistante. Cette flexibilité permet aux équipes d'utiliser les outils existants sans avoir à remanier leur infrastructure. Sa conception modulaire prend en charge plusieurs grands modèles de langage, y compris ceux d'Azure IA ouverte et IA ouverte, ainsi que d'autres fournisseurs, en proposant des points de terminaison et des paramètres configurables. Les développeurs peuvent également étendre ses fonctionnalités en enregistrant des outils externes en tant que fonctions dans les définitions d'agents.

Cette configuration permet aux agents d'appeler des API tierces, de traiter et d'interpréter les résultats, et d'inclure ces sorties dans leurs réponses, le tout sans avoir besoin de code personnalisé. AutoGen prend également en charge Python et .NET, et prévoit de l'étendre à d'autres langages de programmation.

Le module d'extensions de la plateforme améliore encore ses fonctionnalités en donnant accès à des clients modèles, à des agents, à des équipes multi-agents et à des outils fournis par la communauté. Cette structure permet aux équipes de s'appuyer sur les composants existants tout en conservant un contrôle total de personnalisation. Ces fonctionnalités font d'AutoGen un outil puissant pour gérer des opérations d'IA évolutives, en adéquation avec les besoins des entreprises en matière d'efficacité et d'adaptabilité.

La structure centrée sur les agents d'AutoGen est optimisée pour les déploiements à l'échelle de l'entreprise. Sa conception simplifie la communication entre les agents et décompose les tâches en composants gérables. Le système de délégation planificateur-travailleur répartit les tâches de manière dynamique, garantissant une utilisation efficace des ressources. Cette approche permet un traitement parallèle et une prise de décision en temps réel entre plusieurs agents d'IA.

AutoGen met l'accent sur la gouvernance et la conformité, en intégrant des outils d'observabilité et de surveillance pour répondre aux exigences réglementaires. Comme indiqué dans sa documentation :

« L'observabilité n'est pas simplement une commodité de développement, c'est une nécessité de conformité, en particulier dans les secteurs réglementés. »

La plateforme fournit des informations détaillées sur les processus de prise de décision liés à l'IA, renforçant ainsi la confiance dans les systèmes automatisés. Les options de journalisation incluent SQLite et File Logger, avec un support supplémentaire pour les outils partenaires tels que AgentOps pour suivre les opérations multi-agents et surveiller les mesures de performance.

Ces fonctionnalités de gouvernance aident les entreprises à détecter et à corriger rapidement les anomalies ou les comportements imprévus, à réduire les risques et à garantir la conformité aux normes de confidentialité des données. Par exemple, une institution financière multinationale s'est associée à Agency, une société de conseil en IA, pour mettre en œuvre AutoGen pour la gestion des risques. Le système a amélioré la conformité réglementaire grâce à des rapports et à une documentation automatisés, identifiant les risques que les méthodes traditionnelles n'ont pas respectées. Cela a donné lieu à une Augmentation de 40 % de la précision des prévisions de risques.

AutoGen est conçu pour favoriser une collaboration efficace entre les agents d'IA en définissant des rôles clairs et en permettant le partage du contexte et la gestion de la mémoire. Cela garantit que les agents peuvent travailler ensemble de manière fluide tout en maintenant la continuité du flux de travail.

La plateforme répond aux besoins des entreprises en matière de sécurité, d'évolutivité et d'intégration. Comme l'explique Agency AI :

« L'agence utilise une méthodologie complète de sécurité et de conformité qui aborde la protection des données, les contrôles d'accès, les pistes d'audit et les exigences réglementaires. Nos implémentations sont conformes aux normes du secteur et peuvent être personnalisées pour répondre à des besoins de conformité spécifiques. »

AutoGen inclut également des outils de débogage et de surveillance, offrant une visibilité sur les interactions entre les agents et les performances du système. Cela aide les équipes à identifier les goulots d'étranglement et à optimiser les flux de travail, garantissant ainsi l'efficacité des environnements d'IA collaboratifs.

Orby AI se distingue en tant que plateforme conçue pour rationaliser les flux de travail complexes grâce à son approche unique indépendante des applications et à son modèle propriétaire Large Action Model (LAM) ACtio. En tirant parti de l'IA neurosymbolique, il automatise les processus en plusieurs étapes à travers les API, les interfaces graphiques et les documents avec une précision remarquable.

L'une des caractéristiques les plus impressionnantes d'Orby AI est sa capacité à fonctionner sans effort sur différentes interfaces logicielles et API sans nécessiter d'intégrations personnalisées. Cette flexibilité repose sur des fonctionnalités multidomaines, des systèmes de repli symboliques et des agents experts réutilisables qui s'adaptent parfaitement à n'importe quelle interface utilisateur, API ou interface de document. Par exemple, il s'intègre à des plateformes telles que Guidewire, Salesforce, et Duck Creek pour gérer des tâches telles que les rapports de temps et les journaux de travail.

En outre, Orby AI fournit un accès étendu à l'API, permettant aux utilisateurs d'étendre ses fonctionnalités et de les connecter à d'autres applications. Sa base dans le cloud Uniphore Business AI améliore sa capacité d'adaptation, offrant une architecture composable qui s'intègre à n'importe quelle source de données, modèle ou application d'IA, garantissant ainsi aux utilisateurs d'éviter toute dépendance vis-à-vis d'un fournisseur. Grâce à sa couche de modèle, Orby AI orchestre un mélange de grands modèles de langage fermés et open source, fournissant un support flexible et interopérable.

Orby AI est conçu pour gérer facilement la croissance et la complexité. Ses flux de travail pilotés par les agents s'intègrent parfaitement aux différents systèmes et s'améliorent continuellement grâce à l'apprentissage automatique. L'approche d'IA neurosymbolique de la plateforme gère efficacement la complexité croissante en utilisant des mécanismes de repli, garantissant des performances constantes. En outre, ses agents experts réutilisables permettent d'appliquer un apprentissage spécifique à des tâches dans des scénarios similaires, améliorant ainsi l'efficacité au sein de l'organisation.

SuperAGI se distingue en tant que framework open source fiable pour la gestion des agents d'IA autonomes. Conçu pour gérer des flux de travail complexes en plusieurs étapes, il permet de créer agents intelligents capable de raisonner, de planifier et d'exécuter des tâches dans différents domaines, tout en garantissant des performances et une évolutivité constantes.

SuperAgi s'intègre sans effort aux outils de développement, aux services cloud et aux applications d'entreprise largement utilisés grâce à des connecteurs prédéfinis et à des intégrations personnalisables. Son infrastructure d'agents peut interagir avec les bases de données, les services Web, les systèmes de fichiers et les API tierces avec une configuration minimale.

La plateforme écosystème d'outils permet aux agents d'utiliser des ressources externes telles que des navigateurs Web, des environnements de codage et des outils de traitement des données. Cette capacité d'adaptation permet aux entreprises d'intégrer SuperAGI à leurs configurations technologiques existantes sans avoir à remanier l'infrastructure. Prenant en charge plusieurs langages de programmation, il peut fonctionner de manière fluide avec les systèmes basés sur le cloud et sur site.

Grâce à ses architecture pilotée par les événements, SuperAgi assure une communication fluide entre les différents composants, ce qui en fait la solution idéale pour les environnements hybrides. Il orchestre les flux de travail qui couvrent des applications telles que les systèmes CRM et les entrepôts de données, créant ainsi des processus d'automatisation unifiés. Cette intégration ouvre la voie à des opérations d'IA évolutives, sécurisées et efficaces.

SuperAgi architecture d'agent distribuée est conçu pour évoluer horizontalement entre les serveurs et les instances cloud. Le système de gestion des ressources de la plateforme alloue dynamiquement les ressources de calcul en fonction des demandes de charge de travail, tout en maintenant des performances constantes même lorsque l'utilisation augmente.

Avec parallélisation des agents, les tâches peuvent être exécutées simultanément, ce qui augmente considérablement le débit pour les organisations qui gèrent des charges de travail importantes ou plusieurs flux de travail à la fois.

Pour améliorer encore les performances, SuperAgi utilise un système de gestion de la mémoire qui permet de suivre efficacement les états des agents et les informations contextuelles. Cela permet à la plateforme de prendre en charge des milliers d'agents actifs tout en préservant leurs contextes d'apprentissage et d'exécution individuels, ce qui en fait un choix judicieux pour les déploiements au niveau de l'entreprise.

SuperAgi donne la priorité à la transparence et au contrôle grâce à son surveillance et journalisation fonctionnalités, qui documentent les actions et les décisions des agents. Cela est particulièrement important pour les organisations des secteurs réglementés qui ont besoin de pistes d'audit détaillées et de dossiers de conformité.

La plateforme applique contrôles d'accès basés sur les rôles, garantissant que seuls les utilisateurs autorisés peuvent déployer, modifier ou surveiller des agents spécifiques. En outre, contraintes liées au comportement des agents peut être configuré pour permettre aux agents autonomes de fonctionner dans le respect des limites éthiques et réglementaires, en les protégeant contre les actions qui pourraient enfreindre les politiques de l'entreprise ou les normes de conformité.

Le moteur d'optimisation des ressources de SuperAgi ajuste dynamiquement l'allocation des ressources en fonction de l'utilisation, ce qui permet de réduire les coûts sans compromettre les performances. Sa nature open source élimine les frais de licence et sa conception modulaire permet aux entreprises de ne dimensionner que les composants dont elles ont besoin, tout en maîtrisant les coûts d'infrastructure.

L'analyse de l'utilisation en temps réel et les outils de planification efficaces fournissent aux organisations des informations précises sur leurs dépenses liées à l'IA. Ces fonctionnalités aident les entreprises à gérer efficacement leurs budgets et à prévoir les coûts avec une plus grande précision, garantissant ainsi un équilibre entre efficacité opérationnelle et contrôle financier.

Kubeflow est une plateforme d'apprentissage automatique basée sur Kubernetes, conçue pour gérer les flux de travail d'IA dans les environnements cloud et sur site. Il prend en charge l'ensemble du cycle de vie de l'apprentissage automatique, de la préparation des données à la formation des modèles, en passant par le déploiement et la surveillance, ce qui en fait un outil clé pour les entreprises qui souhaitent rationaliser leurs opérations d'IA.

Kubeflow fonctionne sans effort sur des plateformes telles qu'AWS, Google Cloud, Azure et les clusters Kubernetes sur site. Il s'intègre aux frameworks d'apprentissage automatique populaires tels que TensorFlow, PyTorch, et XGBoost à l'aide de composants de pipeline standardisés.

La plateforme propose des serveurs portables compatibles avec Jupyter, offrant aux data scientists un espace de travail familier pour les expériences tout en garantissant un accès cohérent aux ensembles de données et aux ressources partagés. Son composant KFServing se connecte parfaitement à l'infrastructure de service de modèles existante et s'intègre aux systèmes d'entreprise, notamment aux bases de données, aux lacs de données et aux plateformes de streaming.

Le SDK de pipeline de Kubeflow permet aux développeurs de définir des flux de travail à l'aide de Python, ce qui le rend accessible aux équipes déjà à l'aise avec le langage. Les API REST étendent les capacités d'intégration avec des systèmes externes, tandis que son magasin de métadonnées permet de suivre les expériences, les modèles et les ensembles de données, garantissant ainsi la cohérence entre les outils et les environnements.

Grâce à la mise à l'échelle automatique des pods horizontaux de Kubernetes, Kubeflow ajuste dynamiquement les ressources de calcul en fonction des besoins de charge de travail. Il permet de passer d'expériences à nœud unique à des sessions de formation distribuées à nœuds multiples pour des frameworks tels que TensorFlow, PyTorch et MPI, tout en étant efficace gestion des ressources et planification.

La plateforme peut gérer plusieurs tâches de formation simultanées entre les équipes, en tirant parti des quotas de ressources et de la planification des priorités de Kubernetes pour partager efficacement les ressources du cluster. Pour les tâches d'inférence, KFServing adapte automatiquement les points de terminaison de service des modèles pour gérer les pics de volume de demandes, tout en maintenant des temps de réponse constants. Son moteur de pipeline peut exécuter de nombreuses étapes parallèles, ce qui le rend idéal pour le traitement par lots à grande échelle et le réglage des hyperparamètres.

Kubeflow utilise le RBAC (Role-Based Access Control) natif de Kubernetes pour appliquer des autorisations détaillées aux utilisateurs et aux espaces de noms. Il conserve des journaux d'audit des actions des utilisateurs, des déploiements de modèles et des modifications du système, qui sont essentiels à la conformité dans les secteurs réglementés.

Le système de suivi des métadonnées capture les informations de lignage pour les ensembles de données, les expériences et les modèles, créant ainsi une piste d'audit claire. Cela est inestimable pour les organisations qui ont besoin d'une IA explicable et d'une documentation réglementaire. Les fonctionnalités multi-locataires garantissent une isolation sécurisée entre les équipes et les projets, en appliquant les limites de ressources, les contrôles d'accès et les politiques de gouvernance des données au niveau de l'espace de noms.

Kubeflow permet de contrôler les coûts en arrêtant automatiquement les ressources inactives et en optimisant la taille des instances de calcul. Son intégration à la mise à l'échelle automatique des clusters de Kubernetes garantit la réduction de l'infrastructure pendant les périodes de faible activité.

En prenant en charge les instances ponctuelles, Kubeflow permet aux entreprises de tirer parti de ressources cloud à prix réduit pour des tâches de formation non critiques, réduisant ainsi les dépenses. Sa fonction de mise en cache du pipeline évite les calculs redondants en réutilisant les résultats précédents lorsque les données et les paramètres d'entrée restent inchangés.

Les quotas de ressources et les outils de suivi fournissent des informations détaillées sur l'utilisation des ressources par les équipes et les projets, ce qui permet un suivi précis des coûts et une gestion budgétaire. Le partage efficace des ressources permet d'exécuter plusieurs expériences sur la même infrastructure, optimisant ainsi l'utilisation du matériel.

Kubeflow favorise le travail d'équipe en proposant un espace de travail partagé où les équipes de science des données peuvent accéder collectivement à des ensembles de données, à des modèles et à des ressources informatiques. Les membres de l'équipe peuvent partager des sessions de bloc-notes et les résultats des expériences tout en conservant leur propre environnement de développement.

La plateforme prend en charge le partage du pipeline, permettant aux équipes de réutiliser les flux de travail, ce qui permet de standardiser les processus et de réduire le temps de développement. Il suit également les versions et les performances des modèles entraînés, ce qui permet aux équipes de comparer les résultats, de partager des informations et de tirer parti du travail des autres. L'intégration avec les systèmes de contrôle de version garantit un suivi approprié des modifications apportées au code, aux données et aux modèles, ce qui rend les flux de travail reproductibles.

Cet environnement collaboratif renforce la capacité de Kubeflow à fournir des flux de travail d'IA fiables et prêts à l'emploi, conformément à l'accent mis sur l'interopérabilité et l'évolutivité.

Metaflow se distingue en tant que bibliothèque Python conçue pour simplifier les flux de travail de science des données, dans le but de créer des processus d'orchestration d'IA fiables. Développé à l'origine par Netflix pour améliorer les algorithmes de recommandation et les tests A/B, il aide les data scientists à se concentrer sur la résolution des problèmes plutôt que sur la gestion de flux de travail complexes.

Metaflow s'intègre parfaitement à l'écosystème de science des données Python, en collaborant avec des bibliothèques populaires telles que pandas, scikit-learn, TensorFlow, et PyTorch. En utilisant des décorateurs, il transforme les scripts Python locaux en flux de travail distribués, en prenant en charge des détails tels que la sérialisation des données et le stockage des artefacts. Cela complète les lacs de données et les entrepôts existants sans perturber les outils existants.

La bibliothèque fournit également une API client qui permet à des systèmes externes de déclencher des flux de travail et de récupérer les résultats par programmation. Sa compatibilité avec les blocs-notes Jupyter facilite le développement interactif. En outre, Metaflow suit l'historique des versions en enregistrant les informations provenant des systèmes de contrôle des sources, garantissant ainsi un enregistrement clair des modifications. Sa conception garantit que les flux de travail peuvent évoluer efficacement pour répondre à des demandes croissantes.

Metaflow est conçu pour évoluer sans effort à l'aide des backends d'exécution dans le cloud. Il provisionne les ressources de manière dynamique et exécute les tâches simultanément, garantissant ainsi l'efficacité des flux de travail. Des fonctionnalités telles que les fonctionnalités de point de contrôle et de reprise permettent une reprise fluide des flux de travail longs, ce qui la rend fiable pour les opérations à grande échelle.

Pour maintenir la rentabilité des opérations, Metaflow sélectionne des ressources de calcul abordables, telles que Instances AWS Spot, pour chaque étape d'un flux de travail. Son mécanisme de mise en cache des artefacts réutilise les résultats précédents, réduisant ainsi les calculs redondants, tandis que le nettoyage automatique évite les dépenses inutiles liées à la persistance des ressources.

Metaflow améliore la collaboration en capturant les métadonnées, les paramètres et les résultats, ce qui facilite le suivi des expériences et garantit la reproductibilité. En enregistrant le lignage des données et l'historique des versions, il favorise la transparence, la responsabilité et le travail d'équipe entre les projets.

Prefect répond aux exigences de gouvernance et de conformité grâce à des fonctionnalités telles que la journalisation des audits et le suivi du lignage, qui documentent les paramètres d'entrée, les chemins d'exécution et les résultats. Il utilise également un contrôle d'accès basé sur les rôles pour limiter efficacement les opérations sensibles. La plateforme modifie automatiquement les entrées et les sorties des flux de travail tout en garantissant la sécurité des opérations, en créant un enregistrement immuable des activités. Cette approche répond non seulement aux exigences réglementaires, mais favorise également l'efficacité opérationnelle. Ces outils de gouvernance améliorent la fiabilité des flux de travail, en garantissant la traçabilité et la conformité des processus d'orchestration de l'IA. Grâce à ces atouts, Prefect est prêt à être comparé aux autres principales plateformes d'orchestration des flux de travail.

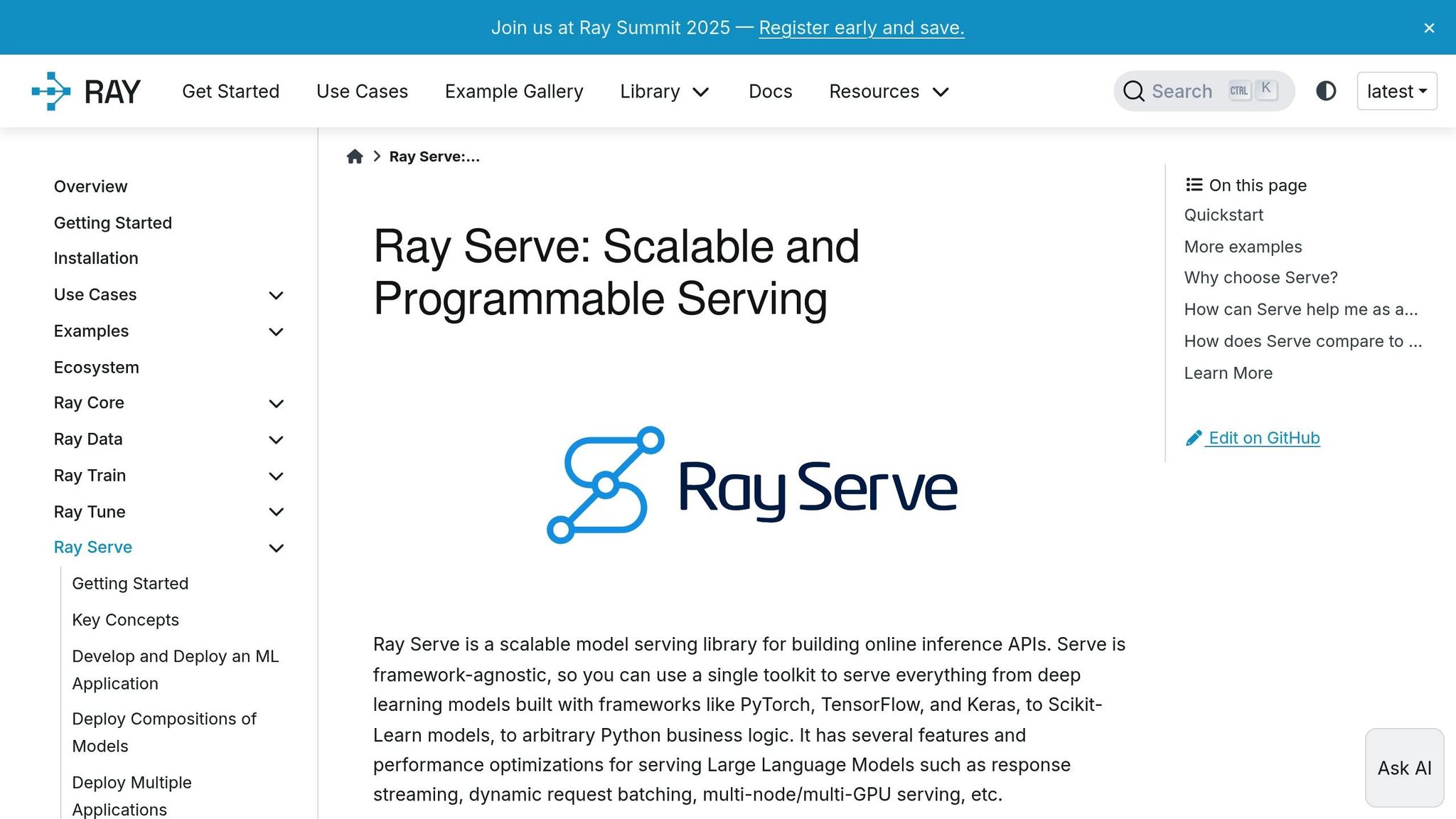

Ray Serve est une puissante solution distribuée conçue pour déployer et gérer des modèles d'IA de manière fluide, prenant en charge à la fois le traitement par lots et l'inférence en temps réel. En unifiant ces tâches au sein d'une infrastructure unique, elle simplifie les opérations d'IA, même dans les déploiements les plus complexes. Sa conception se concentre sur quatre aspects clés : l'évolutivité, l'intégration, la rentabilité et la gouvernance.

Ray Serve ajuste les ressources de manière dynamique pour répondre aux exigences de la charge de travail, garantissant ainsi des performances efficaces. Il prend en charge le déploiement simultané de plusieurs modèles et garantit une distribution fluide du trafic entre les répliques, ce qui le rend hautement adaptable aux différents scénarios d'utilisation.

La plate-forme est conçue pour fonctionner sans effort avec les frameworks d'apprentissage automatique les plus courants et comprend une API REST pour gérer les demandes d'inférence de modèles. Cette flexibilité lui permet de s'intégrer parfaitement aux applications et aux systèmes d'orchestration de conteneurs existants, améliorant ainsi sa facilité d'utilisation dans divers environnements.

Ray Serve optimise l'utilisation du matériel en regroupant les ressources de manière intelligente et en tirant parti des options cloud à prix réduit pour les charges de travail qui ne sont pas sensibles au facteur temps. En outre, il utilise des techniques visant à réduire l'utilisation de la mémoire, réduisant ainsi davantage les dépenses opérationnelles.

Pour garantir la sécurité et la conformité des opérations, Ray Serve tient à jour des journaux détaillés à des fins d'audit et de traçabilité. Il prend également en charge le contrôle des versions et les contrôles d'accès des modèles, fournissant ainsi un cadre sécurisé pour gérer les déploiements en toute confiance.

SynapseML se distingue comme un outil puissant pour les entreprises confrontées aux défis des flux de travail d'IA à grande échelle. Construite sur Apache Spark, cette bibliothèque d'apprentissage automatique distribuée associe le traitement traditionnel du Big Data à des techniques d'apprentissage automatique de pointe. Il est conçu pour aider les entreprises à gérer efficacement des ensembles de données volumineux et à rationaliser leurs besoins d'orchestration complexes.

L'une des forces de SynapseML est sa capacité à connecter divers frameworks d'IA et sources de données au sein d'un écosystème unique. Il s'intègre parfaitement à des plateformes telles qu'Azure Synapse Analytics et Apache Spark, permettant aux organisations de maximiser la valeur de leur infrastructure existante. Prenant en charge une gamme de bibliothèques établies, il simplifie le processus d'intégration des modèles. De plus, sa compatibilité avec des modèles externes en fait la solution idéale pour les architectures d'IA hybrides, garantissant flexibilité et adaptabilité à l'évolution des besoins des entreprises.

SynapseML est conçu pour répondre aux exigences des charges de travail à l'échelle de l'entreprise. Tirant parti des capacités informatiques distribuées d'Apache Spark, il traite de grands ensembles de données sur plusieurs nœuds sans compromettre les performances. Dans les environnements qui prennent en charge la mise à l'échelle automatique, il ajuste dynamiquement les ressources de calcul en fonction des exigences de la charge de travail. Cela garantit des performances efficaces pendant les périodes de pointe de traitement tout en optimisant l'utilisation des ressources.

Pour les déploiements basés sur le cloud, SynapseML offre la possibilité de réaliser d'importantes économies. En utilisant des fonctionnalités telles qu'Azure Spot Instances, les entreprises peuvent planifier des tâches non critiques pendant les heures creuses et regrouper leurs ressources de manière efficace. Ces stratégies permettent de réduire les dépenses opérationnelles sans sacrifier les performances.

SynapseML prend également en charge la collaboration dans les environnements de développement basés sur des ordinateurs portables, ce qui permet aux data scientists, aux ingénieurs en apprentissage automatique et aux analystes commerciaux de travailler ensemble plus facilement. Les équipes peuvent facilement partager du code, des visualisations et des informations. Associé à des systèmes de contrôle de version et à des outils de suivi des expériences, il permet aux organisations de surveiller les performances des modèles, de gérer les modifications de code et de maintenir des flux de travail transparents et vérifiables au fil du temps.

Prompts.ai constitue une plate-forme robuste d'orchestration de l'IA au niveau de l'entreprise, conçue pour rationaliser et faire évoluer les opérations d'IA. Il regroupe l'accès à plus de 35 grands modèles linguistiques de premier plan, tels que GPT-4, Claude, LLama et Gemini, au sein d'une interface sécurisée et unifiée, simplifiant ainsi la gestion multimodèle pour les entreprises.

Les principaux atouts de Prompts.ai sont les suivants :

D'un autre côté, la plateforme architecture axée sur le cloud peut présenter des défis pour les entreprises ayant des besoins locaux très spécifiques. De plus, les petites équipes peuvent avoir besoin de temps et d'efforts supplémentaires pour exploiter pleinement ses nombreuses fonctionnalités.

Si ces atouts font de Prompts.ai un puissant outil d'orchestration, ses limites mettent en évidence des domaines qui peuvent nécessiter une prise en compte en fonction des besoins organisationnels spécifiques et de l'ensemble du marché.

L'évaluation du paysage de l'orchestration de l'IA met en évidence la manière dont les différentes plateformes répondent aux divers besoins des entreprises. Prompts.ai se distingue par sa capacité à unifier la gestion multimodèle et à fournir des informations claires sur les coûts, ce qui en fait un favori des équipes d'entreprise. En revanche, Kubeflow et Ray Serve sont préférés par les équipes de science des données pour leur évolutivité dans les pipelines d'apprentissage automatique. Les organismes de recherche se tournent fréquemment vers Indice de lama pour ses capacités de traitement de documents, tandis que AutoGen attire les entreprises centrées sur Microsoft en raison de sa compatibilité parfaite avec l'infrastructure existante.

Pour choisir le bon flux de travail d'IA, vous devez aligner l'expertise technique, les exigences de conformité et le budget de votre organisation sur les fonctionnalités de la plateforme. Pour les équipes qui découvrent l'IA, les plateformes dotées de solides ressources d'intégration et d'un soutien communautaire actif constituent un point d'entrée plus fluide. Les secteurs réglementés devraient donner la priorité aux solutions qui offrent des fonctionnalités de gouvernance et d'audit strictes. Dans le même temps, les équipes dont les habitudes d'utilisation varient bénéficient de structures tarifaires flexibles.

Commencez par évaluer vos outils d'IA actuels et identifier les défis d'intégration. Ensuite, évaluez les plateformes en fonction de leur capacité à simplifier les flux de travail tout en laissant de la place à une expansion future. Le meilleur choix répondra à vos besoins techniques immédiats tout en s'alignant sur vos objectifs stratégiques à long terme.

Les fichiers Prompts.ai système de crédit TOKN à paiement à l'utilisation permet aux entreprises de gérer leurs dépenses en matière d'IA en ne facturant que les jetons qu'elles consomment. Cela permet d'éliminer les abonnements coûteux et les frais récurrents, offrant aux entreprises la possibilité de réduire les coûts liés à l'IA jusqu'à 98 %.

Ce modèle adaptable permet aux entreprises d'ajuster leur utilisation de l'IA en fonction de la demande, évitant ainsi des dépenses supplémentaires. Il s'agit d'une solution intelligente et efficace qui convient aux organisations de toutes tailles.

Prompts.ai offre des avantages exceptionnels aux entreprises qui gèrent des flux de travail d'IA complexes. En réunissant différents outils d'IA sur une seule plateforme unifiée, il simplifie les opérations et améliore l'efficacité. Soutenir plus de 35 modèles, il garantit une intégration harmonieuse et une supervision complète, en mettant l'accent sur la conformité et la rationalisation des processus.

Les principaux points forts incluent jusqu'à 98 % d'économies grâce à une gestion intelligente des ressources, à une automatisation en temps réel qui améliore l'évolutivité et à des outils de surveillance avancés conçus pour minimiser les risques tout en améliorant la prise de décision. Ces fonctionnalités font de Prompts.ai une solution incontournable pour les organisations qui cherchent à améliorer les performances de leurs systèmes d'IA.

Prompts.ai donne la priorité à la sécurité et à la conformité, en respectant les normes industrielles établies telles que HIPAA et GDPR. Avec des fonctionnalités telles que la détection des menaces en temps réel, la prévention des fuites de données et des pistes d'audit détaillées, la plateforme est conçue pour protéger les informations sensibles tout en respectant les exigences réglementaires.

La plateforme détient également des certifications telles que SOC 2 Type II et NORME ISO 27001, en intégrant de solides mesures de confidentialité et de sécurité dans son cadre. Ces protocoles permettent aux organisations de gérer les flux de travail d'IA en toute sécurité tout en garantissant la protection des données et la conformité aux réglementations.