تخلص من تعقيدات الذكاء الاصطناعي بسهولة. لم تعد إدارة تدفقات عمل الذكاء الاصطناعي بفعالية مجرد تحدٍ - إنها ضرورة للشركات التي تهدف إلى الحفاظ على قدرتها التنافسية. من دمج الأدوات إلى عمليات التوسع، المنصة الصحيحة يمكن توفير الوقت وخفض التكاليف وضمان الامتثال. تستعرض هذه المقالة عشر منصات تتفوق فيها تنسيق الذكاء الاصطناعي، مع تسليط الضوء على نقاط قوتهم في قابلية التشغيل البيني، القابلية للتطوير، إدارة التكاليف، الحكم، و تعاون.

يعتمد اختيار النظام الأساسي المناسب على احتياجات مؤسستك - سواء كانت كفاءة التكلفةأو الامتثال أو قابلية التوسع. ابدأ بتقييم أدواتك وتحدياتك الحالية، ثم قم بمطابقتها مع منصة تحقق نتائج قابلة للقياس.

يجمع Prompts.ai أكثر من 35 نموذجًا لغويًا رائدًا في منصة واحدة آمنة ومركزية. من خلال معالجة المشكلة المتزايدة المتمثلة في انتشار أدوات الذكاء الاصطناعي، فإنها توفر حوكمة على مستوى المؤسسات وتساعد المؤسسات على خفض التكاليف بنسبة تصل إلى 98% عند دمج اشتراكات AI المتعددة في حل واحد.

تتصل المنصة بسهولة بأنظمة المؤسسات المختلفة من خلال عمليات تكامل API القوية وتنسيقات البيانات القياسية. وهو يدعم في الأصل واجهات برمجة تطبيقات JSON و CSV و RESTful، مما يتيح سير العمل السلس عبر أنظمة متعددة. على سبيل المثال، استخدمت شركة بيع بالتجزئة Prompts.ai لتبسيط دعم العملاء. من خلال دمج CRM وروبوتات الدردشة التي تعمل بنظام LLM ونظام إدارة الطلبات، حققوا حل الاستعلام في الوقت الفعلي والتوجيه الآلي للتذاكر.

تدعم بنية موصل Prompts.ai موفري السحابة الرئيسيين مثل AWS، أزرق سماويو GCP، مع استيعاب الإعدادات المحلية أيضًا. تضمن هذه المرونة قدرة المؤسسات على الاستفادة من بنيتها التحتية الحالية مع توسيع قدرات تنسيق الذكاء الاصطناعي تدريجيًا عبر البيئات المختلطة. يتيح هذا النوع من القدرة على التكيف قابلية التوسع الديناميكي.

تم تصميم Prompts.ai للتحجيم الأفقي، ويدير الطلبات ذات الحجم الكبير من خلال النقل بالحاويات والتخصيص الآلي للموارد. تم تصميم بنيته للنمو مع المؤسسات، مما يسمح لها بإضافة النماذج والمستخدمين والفرق في غضون دقائق بدلاً من تحمل أشهر من وقت الإعداد.

يزيل نظام ائتمان TOKN للدفع أولاً بأول للمنصة قيود الاشتراكات التقليدية. يمكن للمؤسسات توسيع نطاق الاستخدام بناءً على الطلب الفعلي، مما يجعلها مثالية للشركات ذات أعباء العمل المتقلبة للذكاء الاصطناعي. تضمن هذه المرونة تخصيص الموارد بكفاءة دون الإفراط في التزويد.

يفي Prompts.ai بالمعايير الصارمة مثل HIPAA و GDPR من خلال تشفير AES-256 وتسجيل التدقيق والتحكم في الوصول المستند إلى الأدوار (RBAC). كما أنه يتتبع إصدارات سير العمل والتغييرات، مما يوفر الشفافية المطلوبة للصناعات المنظمة.

توفر لوحات معلومات المراقبة في الوقت الفعلي رؤية واضحة لكل تفاعل للذكاء الاصطناعي، مما يساعد فرق الامتثال على تتبع استخدام البيانات وأداء النموذج ونشاط المستخدم عبر عمليات سير العمل. وهذا يضمن بقاء المؤسسات متوافقة مع الحفاظ على الكفاءة التشغيلية.

تتضمن المنصة طبقة FinOps التي تتعقب الإنفاق على مستوى الرمز المميز، وتقدم تحليلات مفصلة للاستخدام. تساعد الميزات مثل تنبيهات الميزانية وتوصيات تحسين الموارد المؤسسات على مواءمة إنفاق الذكاء الاصطناعي مع أهداف الأعمال.

يمكن للمستخدمين مراقبة تكاليف تنفيذ سير العمل في الوقت الفعلي، وتعيين حدود الإنفاق لأقسام أو مشاريع محددة، وتلقي اقتراحات تلقائية لاختيار النماذج استنادًا إلى نسب الأداء إلى التكلفة. يساعد هذا المستوى من التحكم في منع تجاوزات الميزانية مع تمكين النمو المستدام في قدرات الذكاء الاصطناعي.

يعزز Prompts.ai العمل الجماعي من خلال مساحات العمل المشتركة والتحرير التعاوني في الوقت الفعلي. يمكن للفرق المشاركة في تصميم تدفقات التنسيق وترك التعليقات السياقية على المنطق الفوري وإعداد عمليات سير عمل الموافقة للعمليات الحساسة.

تقدم المنصة أيضًا برنامج شهادة المهندس الفوري والوصول إلى قوالب «توفير الوقت» المصممة من قبل الخبراء. تخلق هذه الموارد بيئة تعاونية لتبادل المعرفة تعزز إنتاجية الفريق. من خلال ميزات مثل التحكم في الإصدار وتتبع النشاط، يمكن للعديد من أعضاء الفريق المساهمة في عمليات سير العمل المعقدة مع الحفاظ على المساءلة.

يعمل LLAmaIndex على ربط نماذج اللغات الكبيرة (LLMs) بالبيانات الخارجية، مما يبسط التوليد المعزز للاسترجاع لدمج قواعد البيانات الخاصة في عمليات سير العمل السلسة.

يبسط LlamaIndex الاتصال بمصادر البيانات المختلفة من خلال مجموعة واسعة من الموصلات. وهي تعمل بسلاسة مع قواعد البيانات ومنصات التخزين السحابية وتطبيقات المؤسسات، مما يسمح للفرق بإنشاء خطوط بيانات موحدة دون الحاجة إلى ترميز مخصص. بفضل هيكله المعياري، فإنه يتكامل بسهولة مع مكتبات التعلم الآلي الشائعة وقواعد بيانات المتجهات. بالإضافة إلى ذلك، فإن دعمها للمعالجة متعددة الوسائط يعني أنها تستطيع التعامل مع النصوص والصور والبيانات المنظمة ضمن سير عمل واحد.

تتم معالجة البيانات واسعة النطاق بكفاءة باستخدام الفهرسة الهرمية والمعالجة الموزعة لـ LLAmaIndex. من خلال تقسيم أعباء العمل إلى مهام أصغر عبر عقد متعددة، فإنه يضمن الاستعلام السريع والتحديثات في الوقت الفعلي. كما تسمح قدرات البث الخاصة به بمعالجة البيانات المستمرة والتحديثات المنتظمة لقواعد المعرفة، مع الحفاظ على تحديث المعلومات.

تم تصميم LlamaIndex لتحسين التكاليف من خلال إدارة استخدام الرمز المميز بشكل فعال. تعمل ميزات مثل التقسيم الذكي والتخزين المؤقت الدلالي على تقليل مكالمات API غير الضرورية، بينما يضمن توجيه الاستعلام اختيار النموذج الأكثر فعالية من حيث التكلفة بناءً على تعقيد كل استعلام. بالنسبة للشركات التي تتطلع إلى تقليل النفقات، يدعم الإطار أيضًا خيارات النشر المحلية، مما يقلل الاعتماد على النماذج المستندة إلى السحابة.

تدعم المنصة إدارة الفهرس المشتركة والتحكم في الإصدار، مما يضمن تحديثات متسقة عبر الفرق. إنه يعزز التعاون من خلال تمكين مشاركة قوالب سير العمل المبنية مسبقًا. توفر أدوات التصحيح والمراقبة المضمنة رؤى واضحة حول تنفيذ الاستعلام وأداء النظام، مما يساعد الفرق على تحديد أوجه القصور ومعالجتها. تؤكد هذه الميزات دور LLAmaIndex في إنشاء تدفقات عمل فعالة وقابلة للتطوير للذكاء الاصطناعي.

تقدم Microsoft AutoGen نظامًا فريدًا متعدد الوكلاء لإدارة عمليات سير عمل الذكاء الاصطناعي. من خلال تنظيم وكلاء الذكاء الاصطناعي المستقلين بأدوار محددة والتكامل بسلاسة عبر أدوات الذكاء الاصطناعي المختلفة، يبسط AutoGen تنفيذ تدفقات العمل المعقدة داخل النظم البيئية المتنوعة.

تم تصميم AutoGen للعمل عبر الأنظمة الأساسية، والتكامل مع أدوات الذكاء الاصطناعي المستخدمة على نطاق واسع مثل لانج تشين، فهرس LLAA، و أوبن إيه آي مساعد. تسمح هذه المرونة للفرق باستخدام الأدوات الموجودة دون الحاجة إلى إصلاح البنية التحتية الخاصة بهم. يدعم تصميمه المعياري العديد من نماذج اللغات الكبيرة، بما في ذلك تلك من Azure أوبن إيه آي و أوبن إيه آي، بالإضافة إلى مقدمي الخدمات الآخرين، من خلال تقديم نقاط نهاية ومعلمات قابلة للتكوين. يمكن للمطورين أيضًا توسيع قدراته من خلال تسجيل الأدوات الخارجية كوظيفة ضمن تعريفات الوكيل.

يمكّن هذا الإعداد الوكلاء من استدعاء واجهات برمجة التطبيقات التابعة لجهات خارجية ومعالجة النتائج وتفسيرها وإدراج هذه المخرجات في ردودهم - كل ذلك دون الحاجة إلى تعليمات برمجية مخصصة. بالإضافة إلى ذلك، يدعم AutoGen Python و.NET، مع خطط للتوسع في لغات البرمجة الأخرى.

تعمل وحدة الإضافات الخاصة بالمنصة على تعزيز وظائفها، مما يوفر الوصول إلى العملاء النموذجيين والوكلاء والفرق متعددة الوكلاء والأدوات التي يساهم بها المجتمع. تسمح هذه البنية للفرق بالبناء على المكونات الموجودة مع الاحتفاظ بالتحكم الكامل في التخصيص. هذه الميزات تجعل AutoGen أداة قوية لإدارة عمليات الذكاء الاصطناعي القابلة للتطوير، بما يتماشى مع احتياجات المؤسسة من حيث الكفاءة والقدرة على التكيف.

تم تحسين إطار AutoGen المرتكز على الوكيل لعمليات النشر على مستوى المؤسسة. يعمل تصميمه على تبسيط التواصل بين الوكلاء وتقسيم المهام إلى مكونات يمكن التحكم فيها. يقوم نظام تفويض المخطط-العامل بتوزيع المهام بشكل ديناميكي، مما يضمن الاستخدام الفعال للموارد. يتيح هذا النهج المعالجة المتوازية واتخاذ القرار في الوقت الفعلي عبر العديد من وكلاء الذكاء الاصطناعي.

تركز AutoGen بشدة على الحوكمة والامتثال، حيث تدمج أدوات المراقبة والمراقبة لتلبية المتطلبات التنظيمية. كما هو موضح في وثائقها:

«قابلية الملاحظة ليست مجرد وسيلة ملائمة للتطوير - إنها ضرورة للامتثال، خاصة في الصناعات المنظمة.»

توفر المنصة رؤى مفصلة حول عمليات صنع القرار بالذكاء الاصطناعي، مما يعزز الثقة في الأنظمة الآلية. تتضمن خيارات التسجيل SQLite و File Logger، مع دعم إضافي لأدوات الشركاء مثل AgentOps لتتبع العمليات متعددة الوكلاء ومراقبة مقاييس الأداء.

تساعد ميزات الحوكمة هذه المؤسسات على اكتشاف الحالات الشاذة أو السلوكيات غير المقصودة ومعالجتها بسرعة، مما يقلل المخاطر ويضمن الامتثال لمعايير خصوصية البيانات. على سبيل المثال، دخلت مؤسسة مالية متعددة الجنسيات في شراكة مع الوكالة، وهي شركة استشارية للذكاء الاصطناعي، لتنفيذ AutoGen لإدارة المخاطر. قام النظام بتحسين الامتثال التنظيمي من خلال التقارير الآلية والتوثيق، وتحديد المخاطر التي لم يتم تفويتها بالطرق التقليدية. نتج عن ذلك زيادة بنسبة 40% في دقة التنبؤ بالمخاطر.

تم تصميم AutoGen لدعم التعاون الفعال بين وكلاء الذكاء الاصطناعي من خلال تحديد أدوار واضحة وتمكين مشاركة السياق وإدارة الذاكرة. هذا يضمن للوكلاء العمل معًا بسلاسة مع الحفاظ على استمرارية سير العمل.

تعالج المنصة احتياجات المؤسسة للأمان وقابلية التوسع والتكامل. كما توضح وكالة الذكاء الاصطناعي:

«تستخدم الوكالة منهجية شاملة للأمان والامتثال تتناول حماية البيانات وضوابط الوصول ومسارات التدقيق والمتطلبات التنظيمية. تلتزم تطبيقاتنا بمعايير الصناعة ويمكن تخصيصها لتلبية احتياجات الامتثال المحددة.»

يتضمن AutoGen أيضًا أدوات تصحيح الأخطاء والمراقبة، مما يوفر رؤية لتفاعلات الوكلاء وأداء النظام. يساعد ذلك الفرق على تحديد الاختناقات وتحسين سير العمل، مما يضمن الكفاءة في بيئات الذكاء الاصطناعي التعاونية.

تبرز Orby AI كمنصة مصممة لتبسيط عمليات سير العمل المعقدة باستخدام نهجها الفريد الذي لا يعتمد على التطبيقات ونموذج العمل الكبير (LAM) ActIO الخاص. من خلال الاستفادة من الذكاء الاصطناعي الرمزي العصبي، فإنه يعمل على أتمتة العمليات متعددة الخطوات عبر واجهات برمجة التطبيقات وواجهة المستخدم الرسومية والمستندات بدقة ملحوظة.

واحدة من أكثر ميزات Orby AI إثارة للإعجاب هي قدرتها على العمل دون عناء عبر واجهات البرامج المختلفة وواجهات برمجة التطبيقات دون الحاجة إلى عمليات تكامل مخصصة. يتم دعم هذه المرونة من خلال إمكانات المجالات المتعددة والأنظمة الاحتياطية الرمزية ووكلاء الخبراء الذين يمكن إعادة استخدامهم والذين يتكيفون مع أي واجهة مستخدم أو واجهة برمجة تطبيقات أو واجهة مستندات بسلاسة. على سبيل المثال، يتكامل مع منصات مثل Guidewire، سالسفورس، و Duck Creek للتعامل مع مهام مثل إعداد تقارير الوقت وسجلات العمل.

بالإضافة إلى ذلك، توفر Orby AI وصولاً واسعًا إلى واجهة برمجة التطبيقات، مما يتيح للمستخدمين توسيع وظائفها وربطها بتطبيقات أخرى. يعمل تأسيسها في Uniphore Business AI Cloud على تعزيز قدرتها على التكيف، حيث تقدم بنية قابلة للتكوين تتكامل مع أي مصدر أو نموذج أو تطبيق لبيانات الذكاء الاصطناعي - مما يضمن للمستخدمين تجنب تقييد البائع. من خلال الطبقة النموذجية الخاصة بها، تنظم Orby AI مزيجًا من نماذج اللغات الكبيرة المغلقة والمفتوحة المصدر، مما يوفر دعمًا مرنًا وقابلًا للتشغيل المتبادل.

تم تصميم Orby AI للتعامل مع النمو والتعقيد بسهولة. تتكامل عمليات سير العمل التي يحركها الوكيل بسلاسة عبر الأنظمة المختلفة، وتتحسن باستمرار من خلال التعلم الآلي. يعمل نهج الذكاء الاصطناعي الرمزي العصبي للمنصة على إدارة التعقيد المتزايد بشكل فعال من خلال استخدام آليات احتياطية، مما يضمن الأداء المتسق. علاوة على ذلك، يتيح وكلاؤها الخبراء الذين يمكن إعادة استخدامهم تطبيق التعلم الخاص بالمهام عبر سيناريوهات مماثلة، مما يعزز الكفاءة في جميع أنحاء المؤسسة.

تبرز SuperAGI كإطار موثوق مفتوح المصدر لإدارة وكلاء الذكاء الاصطناعي المستقلين. تم تصميمه للتعامل مع عمليات سير العمل المعقدة والمتعددة الخطوات، مما يتيح إنشاء وكلاء أذكياء يمكنه التفكير في المهام وتخطيطها وتنفيذها عبر مختلف المجالات، كل ذلك مع ضمان الأداء المتسق وقابلية التوسع.

يتكامل SuperAgi بسهولة مع أدوات التطوير المستخدمة على نطاق واسع والخدمات السحابية وتطبيقات المؤسسات من خلال الموصلات المبنية مسبقًا والتكاملات القابلة للتخصيص. يمكن أن يتفاعل إطار الوكيل الخاص به مع قواعد البيانات وخدمات الويب وأنظمة الملفات وواجهات برمجة التطبيقات التابعة لجهات خارجية بأقل قدر من التكوين.

المنصة النظام البيئي للأدوات يمكّن الوكلاء من الاستفادة من الموارد الخارجية مثل متصفحات الويب وبيئات الترميز وأدوات معالجة البيانات. تسمح هذه القدرة على التكيف للشركات بدمج SuperAGI في إعدادات التكنولوجيا الحالية دون إصلاح البنية التحتية. من خلال دعم لغات البرمجة المتعددة، يمكن أن تعمل بسلاسة مع كل من الأنظمة المستندة إلى السحابة والأنظمة المحلية.

بفضل ITS بنية تعتمد على الأحداث، تضمن SuperAgi التواصل السلس بين المكونات المختلفة، مما يجعلها مثالية للبيئات الهجينة. وهي تنظم عمليات سير العمل التي تغطي تطبيقات مثل أنظمة CRM ومستودعات البيانات، مما يؤدي إلى إنشاء عمليات أتمتة موحدة. يمهد هذا التكامل الطريق لعمليات الذكاء الاصطناعي القابلة للتطوير والآمنة والفعالة.

أجهزة سوبر آجي بنية الوكيل الموزع تم تصميمه للتوسع أفقيًا عبر الخوادم ومثيلات السحابة. يقوم نظام إدارة موارد المنصة بتخصيص الموارد الحسابية ديناميكيًا بناءً على متطلبات عبء العمل، مع الحفاظ على الأداء المتسق حتى مع نمو الاستخدام.

مع موازاة الوكيل، يمكن تنفيذ المهام في وقت واحد، مما يعزز بشكل كبير الإنتاجية للمؤسسات التي تتعامل مع أعباء العمل الكبيرة أو عمليات سير العمل المتعددة في وقت واحد.

لتعزيز الأداء بشكل أكبر، تستخدم SuperAgi نظام إدارة الذاكرة يتتبع بكفاءة حالات الوكيل ومعلومات السياق. وهذا يسمح للمنصة بدعم الآلاف من الوكلاء النشطين مع الحفاظ على سياقات التعلم والتنفيذ الفردية الخاصة بهم، مما يجعلها خيارًا قويًا لعمليات النشر على مستوى المؤسسة.

تعطي SuperAgi الأولوية للشفافية والتحكم من خلال المراقبة والتسجيل الميزات، التي توثق إجراءات الوكيل وقراراته. هذا مهم بشكل خاص للمؤسسات في الصناعات المنظمة التي تتطلب مسارات تدقيق مفصلة وسجلات الامتثال.

تفرض المنصة عناصر التحكم في الوصول المستندة إلى الأدوار، مما يضمن أن المستخدمين المصرح لهم فقط يمكنهم نشر وكلاء محددين أو تعديلهم أو مراقبتهم. بالإضافة إلى ذلك، قيود سلوك الوكيل يمكن تهيئتها للحفاظ على الوكلاء المستقلين الذين يعملون ضمن الحدود الأخلاقية والتنظيمية، والحماية من الإجراءات التي قد تنتهك سياسات الشركة أو معايير الامتثال.

يعمل محرك تحسين موارد SuperAgi على ضبط تخصيص الموارد بشكل ديناميكي بناءً على الاستخدام، مما يساعد على تقليل التكاليف دون المساس بالأداء. إن طبيعته مفتوحة المصدر تلغي رسوم الترخيص، ويسمح التصميم المعياري للشركات بتوسيع نطاق المكونات التي تحتاجها فقط، مع الحفاظ على تكاليف البنية التحتية تحت السيطرة.

توفر تحليلات الاستخدام في الوقت الفعلي وأدوات الجدولة الفعالة للمؤسسات رؤى دقيقة حول نفقاتها المتعلقة بالذكاء الاصطناعي. تساعد هذه الميزات الشركات على إدارة الميزانيات بفعالية والتنبؤ بالتكاليف بدقة أكبر، مما يضمن التوازن بين الكفاءة التشغيلية والرقابة المالية.

Kubeflow عبارة عن منصة للتعلم الآلي مبنية على Kubernetes، وهي مصممة لإدارة تدفقات عمل الذكاء الاصطناعي عبر كل من البيئات السحابية والمحلية. وهي تدعم دورة حياة التعلم الآلي بأكملها، من إعداد البيانات والتدريب النموذجي إلى النشر والمراقبة، مما يجعلها أداة رئيسية للمؤسسات التي تهدف إلى تبسيط عمليات الذكاء الاصطناعي الخاصة بها.

يعمل Kubeflow دون عناء عبر منصات مثل AWS وGoogle Cloud وAzure ومجموعات Kubernetes المحلية. يتكامل مع أطر التعلم الآلي الشائعة مثل تينسورفلو، PyTorch، و XGBoost باستخدام مكونات خطوط الأنابيب القياسية.

توفر المنصة خوادم محمولة متوافقة مع Jupyter، مما يمنح علماء البيانات مساحة عمل مألوفة للتجربة مع ضمان الوصول المتسق إلى مجموعات البيانات والموارد المشتركة. ويتصل مكون KFServing الخاص به بسلاسة مع البنية التحتية الحالية لخدمة النماذج ويتكامل مع أنظمة المؤسسات، بما في ذلك قواعد البيانات وبحيرات البيانات ومنصات البث.

يسمح Pipeline SDK الخاص بـ Kubeflow للمطورين بتحديد سير العمل باستخدام Python، مما يجعله في متناول الفرق التي تشعر بالفعل بالراحة مع اللغة. تعمل واجهات برمجة تطبيقات REST على توسيع إمكانات التكامل مع الأنظمة الخارجية، بينما يتتبع مخزن البيانات الوصفية التجارب والنماذج ومجموعات البيانات، مما يضمن الاتساق عبر الأدوات والبيئات.

باستخدام القياس التلقائي لجراب Kubernetes الأفقي، يقوم Kubeflow بضبط الموارد الحسابية ديناميكيًا بناءً على احتياجات عبء العمل. وهو يدعم التوسع من تجارب العقدة الواحدة إلى جلسات التدريب الموزعة متعددة العقد لأطر مثل TensorFlow و PyTorch و MPI، مع الكفاءة إدارة الموارد والجدولة.

يمكن للمنصة التعامل مع العديد من وظائف التدريب المتزامنة عبر الفرق، والاستفادة من حصص موارد Kubernetes وجدولة الأولوية لمشاركة موارد المجموعة بشكل فعال. بالنسبة لمهام الاستدلال، يقوم KFServing تلقائيًا بقياس نقاط النهاية التي تخدم النموذج للتعامل مع الزيادات في حجم الطلب، مع الحفاظ على أوقات استجابة ثابتة. يمكن لمحرك خط الأنابيب الخاص به تنفيذ العديد من الخطوات المتوازية، مما يجعله مثاليًا لمعالجة الدفعات على نطاق واسع وضبط المعلمات الفائقة.

يستخدم Kubeflow RBAC الأصلي لـ Kubernetes (التحكم في الوصول المستند إلى الأدوار) لفرض أذونات مفصلة للمستخدم ومساحة الاسم. وهي تحتفظ بسجلات تدقيق لإجراءات المستخدم وعمليات نشر النماذج وتغييرات النظام، والتي تعتبر ضرورية للامتثال في الصناعات المنظمة.

يلتقط نظام تتبع البيانات الوصفية معلومات النسب لمجموعات البيانات والتجارب والنماذج، مما يؤدي إلى إنشاء مسار تدقيق واضح. هذا أمر لا يقدر بثمن بالنسبة للمؤسسات التي تتطلب الذكاء الاصطناعي والوثائق التنظيمية القابلة للتفسير. تضمن ميزات الإيجار المتعدد عزلًا آمنًا بين الفرق والمشاريع، وفرض حدود الموارد، وضوابط الوصول، وسياسات إدارة البيانات على مستوى مساحة الاسم.

يساعد Kubeflow في التحكم في التكاليف عن طريق إيقاف تشغيل الموارد الخاملة تلقائيًا وتحسين أحجام مثيلات الحوسبة. يضمن تكاملها مع القياس التلقائي لمجموعة Kubernetes تقليص البنية التحتية خلال فترات النشاط المنخفض.

من خلال دعم المثيلات الموضعية، يسمح Kubeflow للمؤسسات بالاستفادة من الموارد السحابية المخفضة لمهام التدريب غير الحرجة، مما يقلل النفقات. تتجنب ميزة التخزين المؤقت لخطوط الأنابيب الخاصة بها الحسابات الزائدة عن طريق إعادة استخدام النتائج السابقة عندما تظل بيانات الإدخال والمعلمات دون تغيير.

توفر حصص الموارد وأدوات المراقبة رؤى تفصيلية حول استخدام الموارد عبر الفرق والمشاريع، مما يتيح التتبع الدقيق للتكاليف وإدارة الميزانية. تتيح المشاركة الفعالة للموارد تشغيل تجارب متعددة على نفس البنية التحتية، مما يزيد من استخدام الأجهزة.

يعزز Kubeflow العمل الجماعي من خلال تقديم مساحة عمل مشتركة حيث يمكن لفرق علوم البيانات الوصول إلى مجموعات البيانات والنماذج والموارد الحسابية بشكل جماعي. يمكن لأعضاء الفريق مشاركة جلسات دفتر الملاحظات ونتائج التجربة مع الحفاظ على بيئات التطوير الخاصة بهم.

تدعم المنصة مشاركة خطوط الأنابيب، مما يمكّن الفرق من إعادة استخدام تدفقات العمل، مما يساعد على توحيد العمليات وتقليل وقت التطوير. كما يتتبع إصدارات وأداء النماذج المدربة، مما يسمح للفرق بمقارنة النتائج ومشاركة الأفكار والبناء على عمل بعضهم البعض. يضمن التكامل مع أنظمة التحكم في الإصدار التتبع الصحيح للكود والبيانات وتغييرات النموذج، مما يجعل عمليات سير العمل قابلة للتكرار.

تعمل هذه البيئة التعاونية على تعزيز قدرة Kubeflow على تقديم تدفقات عمل AI موثوقة وجاهزة للمؤسسات، بما يتماشى مع تركيزها على قابلية التشغيل البيني وقابلية التوسع.

تبرز Metaflow كمكتبة Python مصممة لتبسيط سير عمل علوم البيانات، بما يتماشى مع هدف إنشاء عمليات تنسيق موثوقة للذكاء الاصطناعي. تم تطويره في الأصل بواسطة نيتفليكس لتحسين خوارزميات التوصية واختبار A/B، فإنه يساعد علماء البيانات على التركيز على حل المشكلات بدلاً من إدارة عمليات سير العمل المعقدة.

يتكامل Metaflow بسلاسة مع النظام البيئي لعلوم البيانات في Python، ويعمل جنبًا إلى جنب مع المكتبات الشهيرة مثل الباندا، سايكيت-ليرن، تينسورفلو، و PyTorch. باستخدام أدوات الديكور، فإنه يحول نصوص Python المحلية إلى تدفقات عمل موزعة، مع الاهتمام بالتفاصيل مثل تسلسل البيانات وتخزين القطع الأثرية. هذا يكمل بحيرات البيانات والمستودعات الحالية دون تعطيل الأدوات القائمة.

توفر المكتبة أيضًا واجهة برمجة تطبيقات للعميل تسمح للأنظمة الخارجية بتشغيل سير العمل واسترداد النتائج برمجيًا. إن توافقه مع أجهزة الكمبيوتر المحمولة Jupyter يجعل التطوير التفاعلي أمرًا سهلاً. بالإضافة إلى ذلك، يتتبع Metaflow سجل الإصدارات من خلال تسجيل المعلومات من أنظمة التحكم في المصدر، مما يضمن سجلاً واضحًا للتغييرات. يضمن تصميمها إمكانية توسيع تدفقات العمل بكفاءة لتلبية الطلبات المتزايدة.

تم تصميم Metaflow للتوسع بسهولة باستخدام الخلفيات الخلفية للتنفيذ السحابي. فهي توفر الموارد بشكل ديناميكي وتدير المهام بشكل متزامن، مما يضمن بقاء سير العمل فعالاً. توفر ميزات مثل وظيفة التدقيق والسيرة الذاتية استردادًا سلسًا لعمليات سير العمل الطويلة، مما يجعلها موثوقة للعمليات واسعة النطاق.

للحفاظ على فعالية العمليات من حيث التكلفة، تختار Metaflow موارد الحوسبة ذات الأسعار المعقولة، مثل مثيلات AWS Spot، لكل خطوة من خطوات سير العمل. تعمل آلية التخزين المؤقت للقطع الأثرية على إعادة استخدام النتائج السابقة، مما يقلل من الحسابات الزائدة عن الحاجة، بينما يمنع التنظيف الآلي النفقات غير الضرورية من الموارد المتبقية.

يعزز Metaflow التعاون من خلال التقاط البيانات الوصفية والمعلمات والنتائج، مما يدعم تتبع التجربة ويضمن إمكانية التكرار. من خلال تسجيل نسب البيانات وسجل الإصدار، فإنه يعزز الشفافية والمساءلة والعمل الجماعي عبر المشاريع.

يعالج Prefect متطلبات الحوكمة والامتثال بميزات مثل تسجيل التدقيق وتتبع النسب، والتي توثق معايير الإدخال ومسارات التنفيذ والنتائج. كما أنها تستخدم التحكم في الوصول القائم على الأدوار للحد من العمليات الحساسة بشكل فعال. تقوم المنصة تلقائيًا بإصدار مدخلات ومخرجات سير العمل مع ضمان العمليات الآمنة وإنشاء سجل غير قابل للتغيير للأنشطة. لا يلبي هذا النهج المتطلبات التنظيمية فحسب، بل يدعم أيضًا الكفاءة التشغيلية. تعمل أدوات الحوكمة هذه على تحسين موثوقية سير العمل، مما يجعل عمليات تنسيق الذكاء الاصطناعي قابلة للتتبع ومتوافقة. بفضل نقاط القوة هذه، تكون Prefect جاهزة للمقارنة مع أفضل منصات تنسيق سير العمل الأخرى.

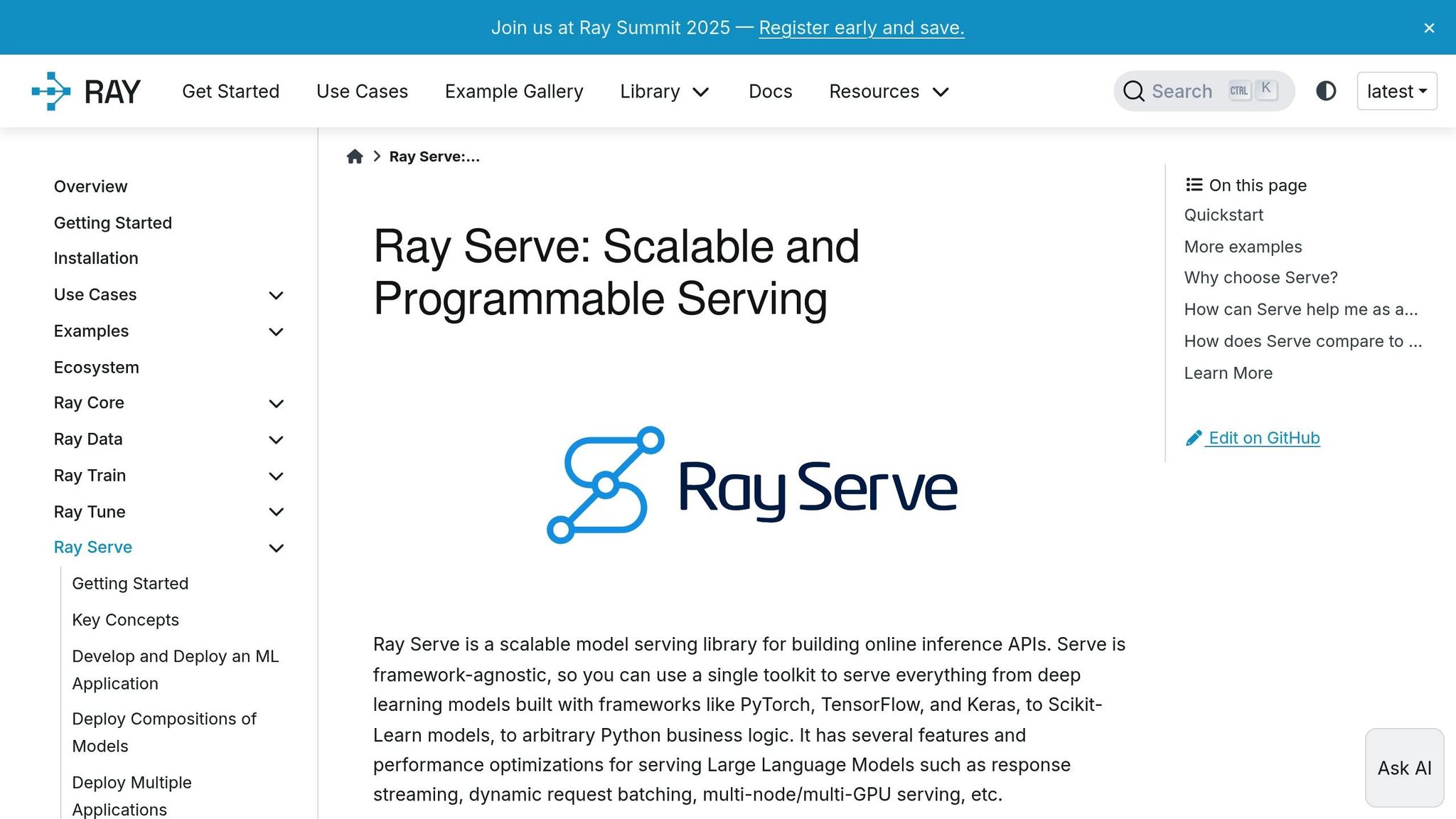

يُعد Ray Serve حلاً موزعًا قويًا مصممًا لنشر وإدارة نماذج الذكاء الاصطناعي بسلاسة، ويلبي كلاً من المعالجة المجمعة والاستدلال في الوقت الفعلي. ومن خلال توحيد هذه المهام ضمن بنية تحتية واحدة، فإنها تبسط عمليات الذكاء الاصطناعي، حتى في أكثر عمليات النشر تعقيدًا. يركز تصميمها على أربعة جوانب رئيسية: قابلية التوسع والتكامل وكفاءة التكلفة والحوكمة.

يقوم Ray Serve بضبط الموارد ديناميكيًا لتتناسب مع متطلبات عبء العمل، مما يضمن الأداء الفعال. وهو يدعم النشر المتزامن لنماذج متعددة ويضمن التوزيع السلس لحركة المرور عبر النسخ المتماثلة، مما يجعله قابلاً للتكيف بدرجة كبيرة مع سيناريوهات الاستخدام المختلفة.

تم تصميم المنصة للعمل دون عناء مع أطر التعلم الآلي الشائعة وتتضمن واجهة برمجة تطبيقات REST للتعامل مع طلبات الاستدلال النموذجية. تسمح هذه المرونة لها بالتناسب بدقة مع التطبيقات الحالية وأنظمة تنسيق الحاويات، مما يعزز قابليتها للاستخدام عبر بيئات متنوعة.

يعمل Ray Serve على تحسين استخدام الأجهزة من خلال تجميع الموارد بذكاء والاستفادة من خيارات السحابة المخفضة لأحمال العمل غير الحساسة للوقت. بالإضافة إلى ذلك، فإنه يستخدم تقنيات لتقليل استخدام الذاكرة، مما يؤدي إلى خفض النفقات التشغيلية.

لضمان عمليات آمنة ومتوافقة، تحتفظ Ray Serve بسجلات مفصلة للتدقيق والتتبع. كما أنه يدعم إصدار النماذج وعناصر التحكم في الوصول، مما يوفر إطارًا آمنًا لإدارة عمليات النشر بثقة.

تبرز SynapseML كأداة قوية للمؤسسات التي تواجه تحديات تدفقات عمل الذكاء الاصطناعي واسعة النطاق. تجمع مكتبة التعلم الآلي الموزعة هذه المبنية على Apache Spark بين معالجة البيانات الضخمة التقليدية وتقنيات التعلم الآلي المتطورة. تم تصميمه لمساعدة الشركات على إدارة مجموعات البيانات الضخمة بكفاءة وتبسيط احتياجات التنسيق المعقدة.

تتمثل إحدى نقاط قوة SynapseML في قدرتها على ربط أطر الذكاء الاصطناعي المتنوعة ومصادر البيانات داخل نظام بيئي واحد. إنه يتكامل بسلاسة مع منصات مثل Azure Synapse Analytics و Apache Spark، مما يسمح للمؤسسات بتعظيم قيمة البنية التحتية الحالية. ومن خلال دعم مجموعة من المكتبات القائمة، فإنها تبسط عملية دمج النماذج. بالإضافة إلى ذلك، فإن توافقه مع النماذج الخارجية يجعله مثاليًا لهياكل الذكاء الاصطناعي الهجينة، مما يضمن المرونة والقدرة على التكيف مع احتياجات المؤسسة المتطورة.

تم تصميم SynapseML للتعامل مع متطلبات أعباء العمل على مستوى المؤسسة. من خلال الاستفادة من إمكانات الحوسبة الموزعة لـ Apache Spark، فإنها تعالج مجموعات البيانات الكبيرة عبر العقد المتعددة دون المساس بالأداء. في البيئات التي تدعم التحجيم التلقائي، تقوم بضبط الموارد الحسابية ديناميكيًا استنادًا إلى متطلبات عبء العمل. وهذا يضمن الأداء الفعال خلال أوقات المعالجة القصوى مع تحسين استخدام الموارد.

بالنسبة لعمليات النشر المستندة إلى السحابة، توفر SynapseML فرصًا لتحقيق وفورات كبيرة في التكاليف. من خلال استخدام ميزات مثل Azure Spot Instances، يمكن للمؤسسات جدولة المهام غير الحرجة خارج ساعات الذروة وتجميع الموارد بفعالية. تساعد هذه الاستراتيجيات على تقليل النفقات التشغيلية دون التضحية بالأداء.

تدعم SynapseML أيضًا التعاون في بيئات التطوير القائمة على أجهزة الكمبيوتر المحمولة، مما يسهل على علماء البيانات ومهندسي التعلم الآلي ومحللي الأعمال العمل معًا. يمكن للفرق مشاركة التعليمات البرمجية والتصورات والرؤى دون عناء. عند دمجها مع أنظمة التحكم في الإصدار وأدوات تتبع التجربة، فإنها تمكن المؤسسات من مراقبة أداء النموذج وإدارة تغييرات التعليمات البرمجية والحفاظ على عمليات سير عمل شفافة وقابلة للتدقيق بمرور الوقت.

تعمل Prompts.ai كمنصة قوية لتنسيق الذكاء الاصطناعي على مستوى المؤسسة، وهي مصممة لتبسيط عمليات الذكاء الاصطناعي وتوسيع نطاقها. فهو يجمع بين الوصول إلى أكثر من 35 نموذجًا للغات الكبيرة من الدرجة الأولى - مثل GPT-4 و Claude و LLama و Gemini - ضمن واجهة واحدة آمنة وموحدة، مما يبسط الإدارة متعددة النماذج للشركات.

تشمل نقاط القوة الرئيسية لـ Prompts.ai ما يلي:

على الجانب الآخر، فإن المنصة بنية تعتمد على السحابة أولاً قد تشكل تحديات للشركات ذات الاحتياجات المحلية المحددة للغاية. بالإضافة إلى ذلك، قد تتطلب الفرق الصغيرة مزيدًا من الوقت والجهد لتسخير ميزاتها الشاملة بشكل كامل.

في حين أن نقاط القوة هذه تعزز Prompts.ai كأداة تنسيق قوية، فإن قيودها تسلط الضوء على المجالات التي قد تحتاج إلى النظر فيها اعتمادًا على الاحتياجات التنظيمية المحددة ومشهد السوق الأوسع.

يسلط تقييم مشهد تنسيق الذكاء الاصطناعي الضوء على كيفية تلبية المنصات المختلفة لاحتياجات المؤسسة المتنوعة. Prompts.ai تتميز بقدرتها على توحيد الإدارة متعددة النماذج وتقديم رؤى واضحة للتكلفة، مما يجعلها المفضلة لدى فرق المؤسسة. في المقابل، كيوبيفلو و راي سيرف يتم تفضيلها من قبل فرق علوم البيانات لقابليتها للتطوير في خطوط أنابيب التعلم الآلي. كثيرًا ما تلجأ المنظمات البحثية إلى مؤشر لاما لإمكانيات معالجة المستندات الخاصة به، بينما أوتوجين تناشد المؤسسات التي تركز على Microsoft نظرًا لتوافقها السلس مع البنية التحتية الحالية.

يتطلب اختيار سير عمل الذكاء الاصطناعي المناسب مواءمة الخبرة الفنية لمؤسستك ومتطلبات الامتثال والميزانية مع إمكانات النظام الأساسي. بالنسبة للفرق الجديدة في مجال الذكاء الاصطناعي، توفر المنصات ذات موارد الإعداد القوية والدعم المجتمعي النشط نقطة دخول أكثر سلاسة. يجب على الصناعات الخاضعة للتنظيم إعطاء الأولوية للحلول التي تقدم ميزات صارمة للحوكمة والتدقيق. وفي الوقت نفسه، تستفيد الفرق ذات أنماط الاستخدام المتغيرة من هياكل التسعير المرنة.

ابدأ بتقييم أدوات الذكاء الاصطناعي الحالية وتحديد تحديات التكامل. بعد ذلك، قم بتقييم المنصات استنادًا إلى قدرتها على تبسيط سير العمل مع ترك مساحة للتوسع في المستقبل. سوف يلبي الخيار الأفضل احتياجاتك الفنية الفورية مع التوافق مع أهدافك الاستراتيجية طويلة المدى.

ملفات Prompts.ai نظام ائتمان TOKN للدفع أولاً بأول يضع الشركات مسؤولة عن إنفاقها على الذكاء الاصطناعي عن طريق إصدار الفواتير فقط مقابل الرموز التي تستهلكها. يؤدي هذا إلى التخلص من الاشتراكات باهظة الثمن والرسوم المتكررة، مما يتيح للشركات فرصة خفض تكاليف الذكاء الاصطناعي بنسبة تصل إلى 98٪.

يسمح هذا النموذج القابل للتكيف للشركات بتعديل استخدام الذكاء الاصطناعي بناءً على الطلب، وتجنب النفقات الإضافية. إنه حل ذكي وفعال يناسب المؤسسات من أي حجم.

يوفر Prompts.ai مزايا استثنائية للمؤسسات التي تدير تدفقات عمل الذكاء الاصطناعي المعقدة. من خلال الجمع بين أدوات الذكاء الاصطناعي المختلفة على منصة واحدة وموحدة، فإنها تبسط العمليات وتعزز الكفاءة. دعم أكثر 35 نموذجًا، فهي تضمن التكامل السلس والرقابة الشاملة، مع التركيز القوي على الامتثال وتبسيط العمليات.

تشمل النقاط البارزة ما يصل إلى توفير التكاليف بنسبة 98% من خلال إدارة الموارد الذكية والأتمتة في الوقت الفعلي التي تعزز قابلية التوسع وأدوات المراقبة المتقدمة المصممة لتقليل المخاطر مع تحسين عملية صنع القرار. تضع هذه القدرات Prompts.ai كحل مناسب للمؤسسات التي تتطلع إلى رفع أداء أنظمة الذكاء الاصطناعي الخاصة بها.

يعطي Prompts.ai الأولوية للأمان والامتثال، مع الالتزام بمعايير الصناعة المعمول بها مثل هيبا و GDPR. بفضل ميزات مثل اكتشاف التهديدات في الوقت الفعلي ومنع تسرب البيانات ومسارات التدقيق التفصيلية، تم تصميم النظام الأساسي لحماية المعلومات الحساسة مع الحفاظ على المتطلبات التنظيمية.

تحمل المنصة أيضًا شهادات مثل SOC 2 من النوع الثاني و أيزو 27001، ودمج تدابير الخصوصية والأمن القوية في إطارها. تعمل هذه البروتوكولات على تمكين المؤسسات من إدارة تدفقات عمل الذكاء الاصطناعي بأمان مع ضمان حماية البيانات والامتثال للوائح.