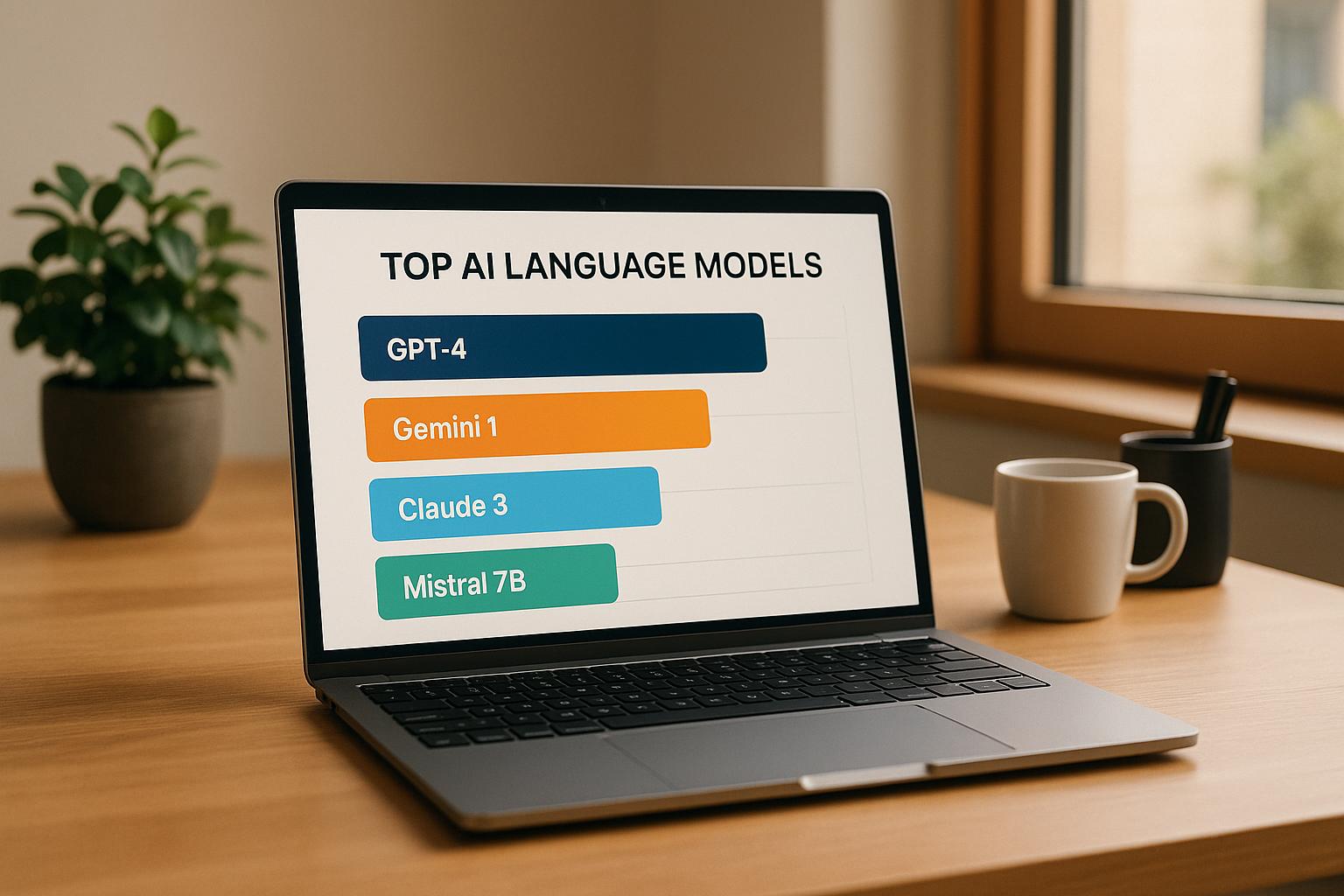

Les modèles de langage d'IA transforment les secteurs, mais le choix du bon dépend de vos objectifs, de votre budget et de vos besoins techniques. Voici un aperçu de sept modèles phares et de leurs domaines d'intérêt :

Chaque modèle présente des points forts dans des domaines tels que le traitement du langage, le support multilingue, le codage et l'intégration en entreprise. Vous trouverez ci-dessous une comparaison rapide pour plus de clarté.

Sélectionnez un modèle en fonction de vos priorités spécifiques, qu'il s'agisse du support multilingue, du codage ou de l'automatisation de l'entreprise. Consultez toujours les mises à jour et les benchmarks officiels pour obtenir les dernières informations.

Les informations sur le GPT-5 d'OpenAI sont encore spéculatives, aucun détail confirmé n'étant disponible. Bien que les avancées potentielles suscitent beaucoup d'intérêt, telles qu'un raisonnement amélioré, de meilleures performances ou des capacités multimodales, aucune de ces affirmations n'a été officiellement validée. Il est important d'aborder les premières rumeurs avec prudence et de s'appuyer sur les mises à jour officielles d'OpenAI pour obtenir des informations précises. Jetons maintenant un coup d'œil à un autre modèle important.

Les informations accessibles au public sur les derniers modèles linguistiques de DeepSeek sont rares, ce qui rend difficile l'évaluation complète de leurs capacités. Les informations disponibles suggèrent que l'entreprise se concentre sur les tâches standard de traitement du langage naturel (NLP) telles que la génération de texte, la compréhension et le raisonnement.

DeepSeek semble se concentrer sur les fonctionnalités de base de la PNL, notamment la génération de texte, la compréhension du langage et le raisonnement logique. Cependant, le manque de détails techniques, tels que les spécifications, les repères de performance ou la définition de caractéristiques, limite la capacité de comparer ces modèles aux leaders du secteur ou d'identifier leurs cas d'utilisation les plus efficaces.

Les avantages spécifiques ou les éléments de conception uniques des modèles de DeepSeek restent flous. L'entreprise n'a pas fourni d'informations substantielles sur les avancées architecturales ou les caractéristiques distinctives qui distinguent ses modèles.

Étant donné que les critères de performance n'ont pas été partagés, il est difficile de mesurer la position des modèles de DeepSeek par rapport à leurs concurrents ou aux normes établies dans le domaine.

Sur la base des données limitées, ces modèles semblent cibler les besoins commerciaux généraux et les scénarios de développement. Cependant, l'absence de documentation détaillée laisse leurs applications pratiques sujettes à interprétation.

Pour fournir un meilleur contexte, les sections suivantes compareront les systèmes d'IA dotés de fonctionnalités mieux documentées, offrant ainsi un aperçu de la manière dont les offres de DeepSeek pourraient s'intégrer dans le paysage plus large de l'IA.

Le Qwen3 d'Alibaba représente la dernière étape de l'évolution des modèles linguistiques d'IA d'Alibaba, en mettant l'accent sur les fonctionnalités multilingues et l'intégration au sein de l'écosystème de services cloud et commerciaux d'Alibaba. Bien que les détails spécifiques concernant son architecture restent rares, ses applications potentielles sont claires.

Qwen3 est conçu pour gérer le traitement de texte multilingue, excellant particulièrement en chinois et en anglais. Il prend en charge des tâches telles que la génération de texte, la synthèse, la réponse à des questions et même la génération de code dans des langages tels que Python, JavaScript et Java. Bien que les données de référence complètes soient limitées, le modèle est optimisé pour interpréter efficacement le contexte dans des scénarios d'écriture conversationnelle et formelle.

Ces bases techniques ouvrent la voie à des fonctionnalités qui répondent aux besoins des entreprises.

L'un des aspects les plus remarquables de Qwen3 est sa intégration étroite avec les services Alibaba Cloud, ce qui en fait une option intéressante pour les entreprises déjà intégrées à l'écosystème d'Alibaba. Cette compatibilité parfaite permet aux entreprises d'intégrer le modèle directement dans leurs flux de travail et applications sans obstacles importants.

Le modèle montre également une accent mis sur la compréhension des nuances linguistiques locales, particulièrement utile pour les entreprises opérant dans des régions où l'exactitude culturelle et contextuelle de la communication est essentielle.

De plus, Qwen3 semble donner la priorité sécurité de l'entreprise, bien que des informations détaillées sur ses protocoles de traitement des données et de confidentialité n'aient pas été détaillées dans les documents publics.

Ensemble, ces fonctionnalités font de Qwen3 un outil précieux pour l'automatisation des entreprises et la gestion de contenu localisé.

Bien que les mesures de performance détaillées pour Qwen3 soient rares, les données disponibles suggèrent qu'il fonctionne bien par rapport aux benchmarks linguistiques standard. Les premiers commentaires mettent en évidence ses force dans les tâches en chinois, où il pourrait surpasser les modèles développés en Occident. Cependant, des tests et des évaluations plus approfondis sont nécessaires pour bien comprendre sa position concurrentielle.

Les capacités de Qwen3 le rendent particulièrement attrayant pour entreprises ciblant les marchés asiatiques ou ceux qui ont besoin d'une solide prise en charge de la langue chinoise. Son intégration approfondie à l'infrastructure d'Alibaba Cloud renforce encore son attrait pour les entreprises qui utilisent déjà les services d'Alibaba.

Le modèle est particulièrement adapté pour efforts de localisation du contenu, par exemple en adaptant des supports pour un public sinophone ou en gérant un support client multilingue. Sa capacité à saisir les nuances régionales et contextuelles en fait un candidat idéal pour les tâches de marketing et de communication.

De plus, Qwen3 est bien positionné pour automatisation d'entreprise, en particulier pour les organisations qui ont déjà investi dans l'écosystème commercial plus large d'Alibaba. Sa combinaison de fonctionnalités multilingues et de fonctionnalités destinées aux entreprises lui permet de répondre à un large éventail de besoins opérationnels.

Grok by xAi se distingue par l'accent mis sur l'interaction conversationnelle et sa capacité à accéder à des données en temps réel.

Grok est équipé pour gérer une variété de tâches, notamment la génération de texte, la rédaction de code, la résolution de problèmes mathématiques et le dialogue. Sa formation donne la priorité aux échanges conversationnels naturels, ce qui la rend capable d'interactions informelles mais productives.

L'un des points forts de Grok est sa capacité à fournir des informations actualisées, répondant ainsi aux limites communes des connaissances fixes dans de nombreux modèles d'IA. Il associe cela à un style de conversation engageant et accessible, améliorant ainsi l'expérience utilisateur pour différentes tâches.

Bien que Grok présente un fort potentiel et affiche de bonnes performances dans divers domaines, des évaluations indépendantes de ses capacités par des tiers sont toujours en attente. Par conséquent, ses performances complètes dans diverses applications n'ont pas encore été pleinement comprises.

Grok convient particulièrement aux utilisateurs qui recherchent des interactions d'IA flexibles et moins formelles. Il brille dans des tâches telles que l'écriture créative, le remue-méninges et les conversations exploratoires, où un style de dialogue décontracté et dynamique est préféré. Son approche ajoute une dimension unique au paysage concurrentiel de l'IA, en complétant les capacités d'autres modèles sur le terrain.

Meta Llama 4 poursuit l'engagement de Meta en faveur de l'IA open source en fournissant un modèle de langage hautement adaptable adapté aux développeurs et aux chercheurs.

Meta Llama 4 excelle dans la gestion des tâches multilingues et la génération de code. Il traite efficacement les textes longs, ce qui en fait un excellent choix pour des tâches telles que la synthèse de documents, l'assistance à la recherche et la rédaction technique. Le modèle est conçu en mettant l'accent sur le raisonnement séquentiel, ce qui lui permet de décomposer des problèmes complexes en étapes plus petites et plus faciles à gérer, ce qui est parfait à des fins pédagogiques et analytiques. Ces atouts en font un outil polyvalent pour un large éventail d'industries.

L'une des caractéristiques les plus remarquables de Meta Llama 4 est son framework open source, qui permet aux utilisateurs de personnaliser librement le modèle sans restrictions de licence. Il comprend également des mesures de sécurité intégrées et une conception modulaire, ce qui le rend adaptable à des tâches telles que la rédaction créative et la documentation technique.

Meta Llama 4 est optimisé pour diverses tâches linguistiques, offrant des performances cohérentes et efficaces. Sa conception établit un équilibre entre efficacité informatique et fiabilité de sortie, le rendant accessible même aux organisations dont les capacités matérielles sont limitées.

Meta Llama 4 convient parfaitement à des applications telles que les chatbots internes, le traitement de documents, les flux de travail automatisés et la recherche pédagogique. Les équipes de développement logiciel peuvent tirer parti de ses atouts pour des tâches telles que la génération de code et le débogage, répondant ainsi à divers besoins spécifiques du secteur.

À l'heure actuelle, il n'existe aucun détail confirmé sur les capacités, les fonctionnalités, les performances ou les cas d'utilisation potentiels d'Anthropic Claude 4. Au fur et à mesure que de plus amples informations seront disponibles, cette section sera mise à jour pour refléter les dernières informations.

À l'heure actuelle, aucune information officielle n'est disponible concernant les capacités, les fonctionnalités, les performances ou les applications potentielles de Google Gemini 2.5. Des mises à jour seront fournies dès que de nouveaux détails seront publiés, reflétant la nature évolutive des modèles émergents du secteur.

Lors de l'évaluation de modèles de langage d'IA, il est essentiel de peser leurs forces et leurs limites. Ces modèles comportent des compromis inhérents et leurs performances dépendent souvent du cas d'utilisation spécifique. Bien que les spécifications techniques et les révisions soient régulièrement mises à jour, voici quelques facteurs communs à garder à l'esprit :

À mesure que la technologie de l'IA évolue, il est toujours judicieux de consulter la documentation officielle la plus récente et des évaluations fiables des performances pour prendre des décisions éclairées sur la base des informations les plus récentes.

Le choix du bon modèle de langage d'IA dépend de l'adéquation de ses fonctionnalités à vos objectifs et exigences spécifiques. Chaque modèle présente des avantages distincts, il est donc essentiel de bien évaluer vos priorités.

Pour automatisation d'entreprise, Claude anthropique 4 et Grok par Xai présentent un potentiel en matière de rationalisation des flux de travail commerciaux, bien que leurs capacités complètes soient encore en cours d'évaluation. Si support multilingue est une priorité, Alibaba Qwen 3 se distingue par son expertise en matière de performance de la langue chinoise et d'applications régionales.

Quand il s'agit de création de contenu, OpenAI GPT-5 - une fois publié - peut proposer des outils de pointe, tandis que Lama en métal 4 fournit une option flexible et open source idéale pour les développeurs et les chercheurs à la recherche de personnalisation. Le Série DeepSeek couvre les tâches standard de la PNL, bien que davantage de données sur ses performances apporteraient une plus grande clarté.

Pour les tâches nécessitant accès aux informations en temps réel, Grok par Xai excelle grâce à ses capacités conversationnelles et à son intégration de données actualisée. Entre-temps, Google Gémeaux 2.5 reste un choix très attendu, et de plus amples détails sont attendus lors de sa sortie officielle.

Si les contraintes budgétaires sont une source de préoccupation, Lama en métal 4Le framework open source offre un contrôle étendu sans frais de licence. De même, Alibaba Qwen 3 offre un excellent rapport qualité-prix aux entreprises qui utilisent déjà les services Alibaba Cloud.

En fin de compte, votre sélection doit refléter vos besoins spécifiques, qu'il s'agisse de vitesse de traitement, de capacités linguistiques, de compatibilité de l'infrastructure ou d'évolutivité. Alignez ces facteurs avec les points forts documentés de chaque modèle et tenez compte de vos objectifs à long terme et de vos ressources pour prendre une décision éclairée.

Pour choisir le modèle de langage d'IA adapté à votre entreprise, plusieurs facteurs doivent être soigneusement pris en compte. Commencez par identifier vos besoins spécifiques, que vous souhaitiez améliorer la création de contenu, le support client, rationaliser le codage ou effectuer des tâches avancées en langage naturel. Une fois que vous avez défini vos priorités, évaluez les modèles en fonction de leurs capacités, tels que la gestion de défis complexes, le traitement d'entrées multimodales (comme la combinaison de texte et d'images) ou l'offre de fonctionnalités spécialisées adaptées à votre secteur d'activité.

Le budget est un autre facteur clé. Pesez le coût du modèle par rapport à vos contraintes financières et décidez si vous préférez l'adaptabilité des plateformes open source ou les hautes performances des options propriétaires. Pour les entreprises axées sur une intégration fluide, assurez-vous que le modèle offre Accès à l'API, ce qui facilite son intégration dans vos flux de travail existants. En alignant ces éléments sur vos objectifs commerciaux, vous serez mieux équipé pour choisir la solution d'IA qui fournit les résultats dont vous avez besoin.

Lors du choix d'un modèle de langage d'IA, il est essentiel de prendre en compte plusieurs facteurs clés. Commencez par examiner ses capacités, par exemple dans quelle mesure il gère la précision, le raisonnement et s'il prend en charge les entrées multimodales telles que le texte et les images. Le taille de la fenêtre contextuelle est un autre élément essentiel, car il détermine la quantité de données que le modèle peut traiter simultanément. En outre, explorez ses options d'intégration, y compris des API et des outils de personnalisation adaptés à votre flux de travail.

Portez une attention particulière à indicateurs de performance comme la vitesse et la latence, car elles peuvent avoir un impact sur l'efficacité, en particulier lors de tâches complexes ou longues. Considérez le modèle rentabilité pour vous assurer qu'il correspond à votre budget. Tout aussi importants sont ses caractéristiques de sécurité et des garanties éthiques, en particulier pour les applications sensibles ou à enjeux élevés. En évaluant ces aspects, vous pouvez sélectionner un modèle adapté à vos besoins, que vous vous concentriez sur la création de contenu, l'automatisation ou la compréhension avancée du langage naturel.

Il n'y a pas encore grand-chose de disponible sur des modèles tels que GPT-5 et Google Gemini 2.5. Cela est probablement dû au fait qu'ils sont encore en développement, qu'ils sont étroitement protégés par des accords de confidentialité ou qu'ils n'ont pas été largement diffusés. Les entreprises gardent souvent ces informations secrètes pour protéger leur propriété intellectuelle et façonner stratégiquement la perception du public.

Pour l'instant, il est plus judicieux de s'en tenir à des modèles qui ont fait leurs preuves et qui disposent d'une documentation complète, en particulier pour les tâches importantes. Bien qu'il soit utile de rester au courant des avancées, concentrez-vous sur des outils déjà testés et fiables pour vos besoins actuels.