Prompt engineering is now a core skill for leveraging AI effectively. In 2025, tools like Prompts.ai, Agenta, and LangChain lead the way by simplifying workflows, offering cost transparency, and enabling secure, large-scale AI operations. These platforms cater to diverse needs, including multimodal capabilities, real-time optimization, and advanced compliance features. Here's a quick breakdown of the top tools:

Each tool addresses specific challenges in AI workflows, from managing costs to ensuring regulatory compliance. Below is a Quick Comparison to help you choose the right one for your needs.

| Tool | Key Features | Best For | Limitations |

|---|---|---|---|

| Prompts.ai | Access to 35+ LLMs, cost tracking, enterprise security | Large-scale AI operations | Complex setup for small teams |

| Agenta | Code-first workflows, compliance tools | Flexible and secure AI workflows | Limited scalability for large enterprises |

| LangChain | Multi-step workflows, deep customization | Developers building AI apps | Requires technical expertise |

| PromptLayer | Logging, analytics, and optimization | Teams needing detailed insights | Narrow focus, lacks broader features |

| Lilypad | Security-first design, streamlined workflows | Sensitive data handling | Limited advanced features |

| OpenPrompt | Open-source, modular workflows | Developers seeking affordability | Lacks enterprise-level tools |

| LangSmith | Real-time monitoring, collaboration tools | Teams prioritizing transparency | Tied closely to LangChain ecosystem |

These tools empower teams to streamline AI workflows, optimize costs, and maintain secure, compliant operations. Choose based on your organization’s size, technical expertise, and specific requirements.

Prompts.ai is an enterprise-grade AI orchestration platform designed to simplify and unify access to over 35 leading large language models within a single, secure interface. It addresses the growing complexity of managing multiple AI tools, reducing costs while maintaining strict governance. By integrating models such as GPT-5, Claude, LLaMA, and Gemini, Prompts.ai eliminates the hassle of juggling various interfaces, making vendor management seamless.

This platform takes a practical approach to prompt engineering by combining model selection, workflow automation, and cost management into one streamlined process. Teams can concentrate on creating effective prompts without worrying about the underlying technical infrastructure. With the potential to cut AI software costs by up to 98%, Prompts.ai is an appealing solution for Fortune 500 companies managing extensive AI budgets.

Prompts.ai provides access to over 35 large language models, including well-known names like GPT-5, Grok-4, Claude, LLaMA, Gemini, Flux Pro, and Kling. This expansive library empowers prompt engineers to experiment with various models and compare their performance side by side, all within a single platform - no need to juggle multiple API keys or platforms.

The platform goes beyond simple API integration. Each model retains its full capabilities while benefiting from Prompts.ai's governance and cost tracking features. This setup allows users to leverage the unique strengths of different models - whether it's GPT-5's advanced reasoning, Claude's emphasis on safety, or Gemini's multimodal capabilities - without compromising on security or cost control.

Prompts.ai tackles the issue of cost transparency with its built-in FinOps layer, which tracks every token used and links spending directly to outcomes. This feature is increasingly vital as AI budgets grow; for instance, the average monthly AI spend jumped from $63,000 in 2024 to $85,500 in 2025, with nearly half of organizations spending over $100,000 per month on AI infrastructure or services.

The platform introduces a pay-as-you-go TOKN credits system, which eliminates the need for recurring subscription fees by aligning costs with actual usage. This approach is especially valuable when compared to industry norms, where 15% of companies lack formal AI cost tracking, and 57% rely on manual methods. With Prompts.ai, organizations benefit from automated budget alerts and cost optimization, joining the 90% of companies using third-party tools that report confidence in their cost tracking.

Prompts.ai incorporates enterprise-grade governance and audit trails into its workflows, addressing the security concerns that often deter large organizations from fully adopting AI tools. Sensitive data remains under the organization's control, providing the level of security required by regulated industries and Fortune 500 companies.

The platform ensures compliance by logging all AI interactions, enabling detailed record-keeping for regulatory purposes. This feature is particularly critical for industries with strict data governance requirements, where every AI interaction must be fully traceable and accountable.

Prompts.ai fosters collaboration through a global community and shareable, expert-created "Time Savers." This social component sets it apart from basic model aggregation services, creating an ecosystem where best practices naturally spread across teams and organizations.

The platform also offers a Prompt Engineer Certification program, equipping organizations with internal experts who can drive AI adoption strategies. This ensures that teams not only have access to powerful tools but also the skills to use them effectively. Adding new models, users, or teams takes just minutes, making scaling a smooth process without the typical chaos of managing multiple AI tools.

Team workspace features further enhance collaboration, allowing multiple users to work together on prompt development. With version control and sharing options, knowledge is easily shared across teams, avoiding silos and accelerating the creation of effective prompts. This collaborative environment helps organizations build institutional expertise around AI best practices.

Next, we’ll explore Agenta's approach to prompt engineering.

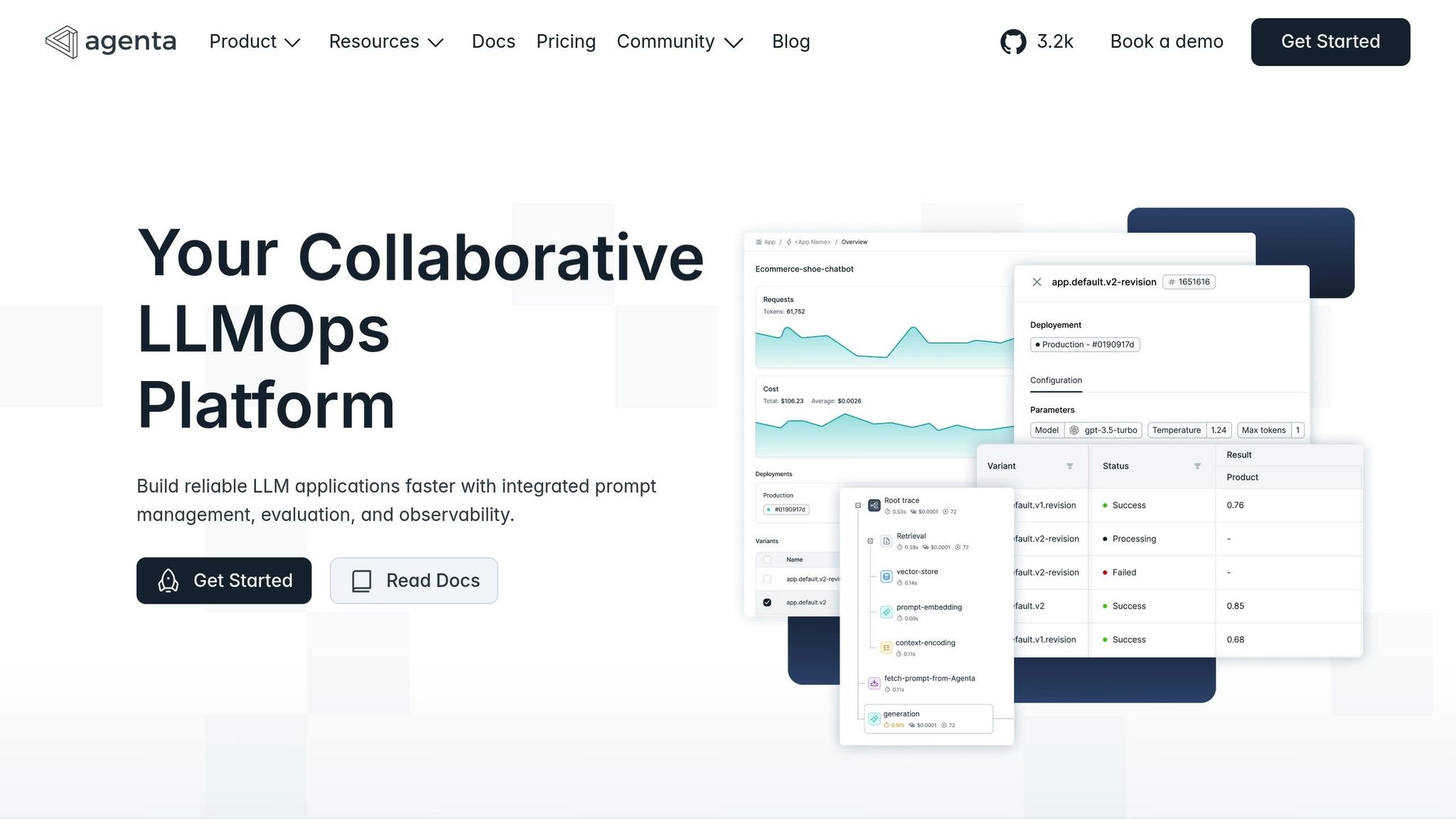

Agenta is an open-source LLMOps platform designed with a code-first mindset, bringing software engineering principles to the world of prompt engineering. This approach combines robust evaluation tools with enterprise-level security, making it especially appealing to organizations that prioritize both adaptability and compliance in their AI workflows.

The platform's key strength lies in its integrated development environment for large language model (LLM) applications. It enables teams to seamlessly build, test, and deploy AI solutions while adhering to familiar development practices. By offering a unified workspace, Agenta simplifies the often-complex process of managing multiple AI tools, covering everything from prompt creation to production deployment.

Agenta works with leading model providers like OpenAI, Anthropic, and Cohere, ensuring teams have the freedom to choose the best model for specific tasks without being tied to a single vendor. This flexibility allows organizations to adapt their AI strategies based on cost, performance, or unique project requirements.

The platform's OpenTelemetry-native and vendor-neutral design makes it easy for teams to switch between LLM providers or send traces to multiple backends simultaneously. This adaptability is crucial for optimizing workflows across various projects.

Additionally, Agenta integrates seamlessly with frameworks such as LangChain, LangGraph, and PydanticAI. These integrations allow teams to maximize their existing investments while leveraging Agenta's powerful evaluation and management tools. Together, these features create a cohesive and efficient development experience.

Agenta revolutionizes prompt engineering by treating prompts as code, enabling version control to track changes and manage multiple prompt iterations. This approach brings structure and clarity to what is often a chaotic process.

The platform's Prompt Playground allows users to compare outputs across more than 50 LLMs simultaneously, eliminating the need for tedious manual testing. This feature accelerates optimization, helping teams quickly identify the best-performing models for specific tasks.

With pre-built templates and systematic evaluation tools that combine automated metrics with human feedback, teams can deploy LLM applications in just minutes. This streamlined process is particularly valuable for organizations working under tight deadlines.

On January 15, 2024, Agenta achieved SOC2 Type I certification, underscoring its commitment to rigorous security standards. This certification covers all aspects of the platform, including prompt management, evaluation tools, observability features, and workflow deployments.

"We're thrilled to announce that Agenta has achieved SOC2 Type I certification, validating our commitment to protecting your LLM development data with enterprise-grade security controls." - Mahmoud Mabrouk, Agenta

Agenta’s security measures include data encryption (both in transit and at rest), access control and authentication, security monitoring, incident response, backup and disaster recovery, and regular security assessments. These controls ensure the platform meets the strict compliance requirements of enterprise teams.

The platform is also working towards SOC2 Type II certification, which will further validate the operational effectiveness of its security measures over time. This ongoing commitment highlights Agenta’s dedication to providing robust data protection throughout every stage of AI development.

LangChain is a framework designed to help developers build fully functional AI applications. It provides the essential tools and components needed to create robust, AI-driven solutions ready for real-world use.

The framework’s modular setup allows developers to link multiple components together, enabling advanced reasoning, data retrieval, and multi-step workflows. This makes it especially useful for teams transitioning from experimentation to production-ready applications.

LangChain’s model-agnostic approach supports seamless integration with a range of language model providers. Developers can work with models from OpenAI, Anthropic, Google, Cohere, and various open-source options. Additionally, LangChain supports local deployments through tools like Hugging Face Transformers and other inference engines. This flexibility is ideal for organizations prioritizing data privacy or looking to manage API costs effectively.

LangChain simplifies the creation of multi-step AI workflows through its chain abstraction. Developers can link together prompt templates, model calls, data processing steps, and external tools. Its memory management ensures context is preserved across interactions, while built-in connectors for services like web search, databases, APIs, and file systems significantly enhance its functionality. These features make it easier to transition from prototyping to fully operational systems.

While LangChain offers powerful automation capabilities, it falls short in areas like enterprise-grade security and auditability. For instance, the framework lacks built-in audit tools, posing challenges for organizations in regulated sectors like healthcare and finance. Enterprises with strict compliance needs often opt for custom workflows instead of relying solely on LangChain. Additionally, its "black box" nature can complicate debugging, making it harder to trace errors, recover quickly, and ensure reliability in high-stakes environments.

These challenges highlight that while LangChain is an excellent tool for rapid prototyping, organizations with strict compliance demands may need to implement additional governance measures to meet their requirements.

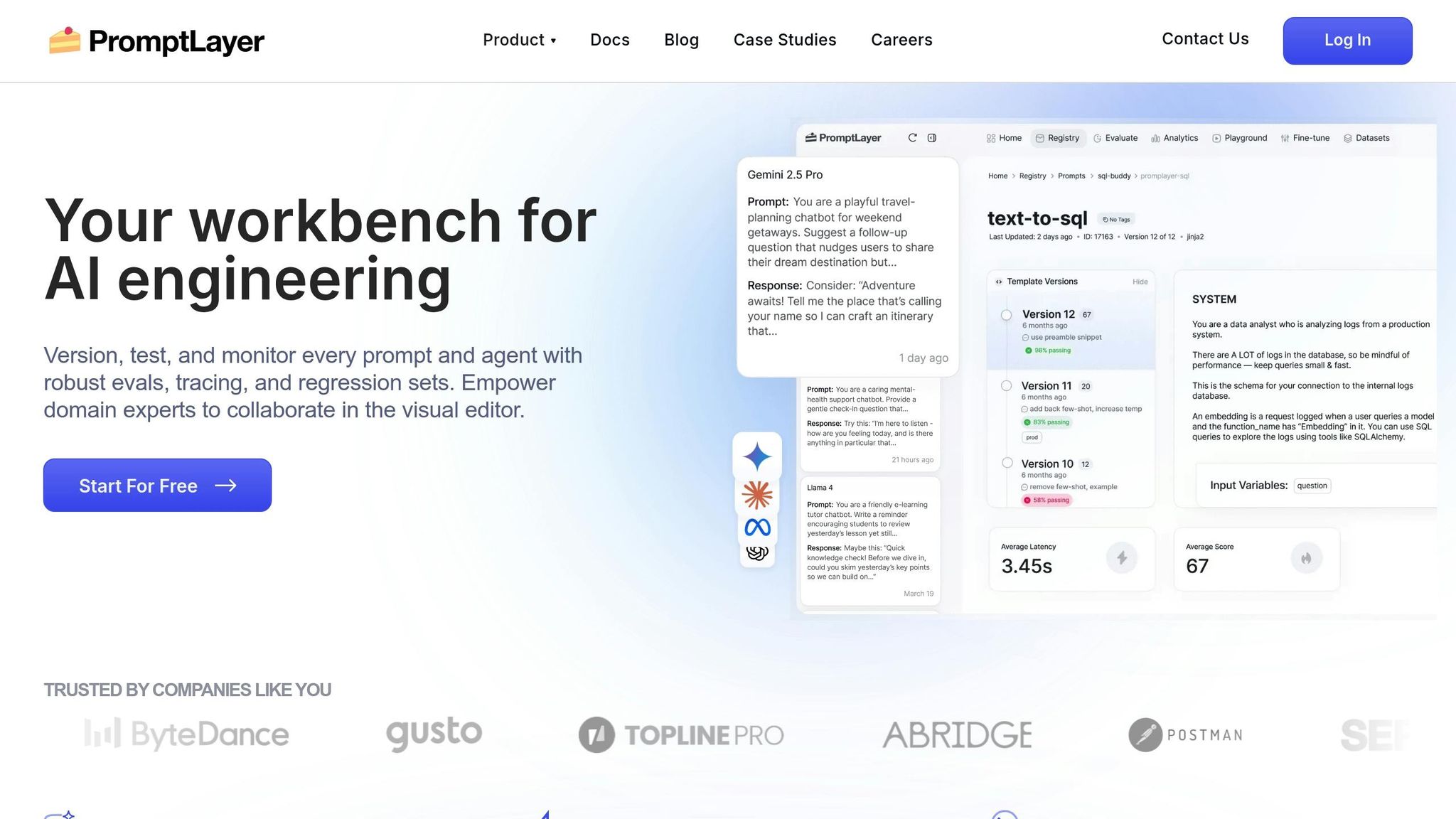

PromptLayer stands out for its focus on security and compliance, making it an excellent choice for handling sensitive data. By logging every API request and response, it creates a comprehensive audit trail, enabling detailed usage analysis and improving prompt performance.

Built on this secure framework, the platform also facilitates smooth and effective team collaboration.

With tools designed to enhance teamwork while maintaining compliance, PromptLayer is particularly advantageous for organizations operating under strict regulatory requirements or prioritizing data transparency in their AI workflows.

In today’s world, where security and efficiency are non-negotiable, Lilypad stands out by prioritizing security-first principles in prompt engineering. It’s a platform tailored for organizations that manage sensitive data and operate under strict compliance requirements. By adopting an "assume-breach" mindset, Lilypad layers multiple defenses to protect both its infrastructure and customer data.

Lilypad’s security measures address the increasing need for data protection in AI workflows. It enforces two-factor or passkey authentication for external services like Google Workspace and GitHub, ensuring only authorized users gain access. The platform also employs zero-trust tools and Privileged Access Management to tightly control data access.

Sensitive data, such as client passwords, is encrypted, and firewalls are deployed across all systems to filter incoming traffic. Internal services and administrative access are further secured through Virtual Private Networks (VPNs), adding an additional barrier for unauthorized users.

To safeguard data during transmission, Lilypad employs universal TLS/SSL certificates, including ECC TLS for Cloudflare communications, and enforces HSTS across all domains. Additionally, DNS records are authenticated using DNSSEC, ensuring a secure communication environment.

Lilypad’s infrastructure is built for reliability, featuring automatic monitoring, load balancing, and database replication to maintain seamless workflow automation and minimize downtime. Its DDoS protection, powered by providers like Cloudflare and DataPacket, is designed to handle terabit-scale attacks across multiple vectors. This ensures that even during security threats, prompt engineering workflows remain uninterrupted.

OpenPrompt is a Python-based open-source library designed for prompt engineering, offering developers a high degree of flexibility and control. It allows users to build strong workflows within the comfort of familiar Python environments, making it a natural fit for developers while complementing enterprise-level strategies.

One of OpenPrompt's standout features is its support for a variety of large language models. It integrates effortlessly with Hugging Face models, granting access to thousands of community-driven, pre-trained models. Additionally, it supports GPT-3 and GPT-4 via OpenAI's API. This compatibility makes it easy for developers to test multiple models for the same prompt, simplifying the process of assessing both performance and cost efficiency.

The library's modular design provides developers with precise control over prompt engineering workflows, making it possible to create structured, scalable processes. Its advanced template system includes dynamic variables, conditional logic, and pre-built templates, all of which speed up development and improve context management. This ensures prompts are interpreted accurately and effectively.

OpenPrompt includes a built-in evaluation framework that simplifies the process of testing and refining prompts. By enabling developers to fine-tune prompts before deployment, the library helps cut down on computational costs and reduces ongoing operational expenses. This not only shortens development cycles but also ensures resources are used more efficiently.

LangSmith builds on the foundation set by OpenPrompt, offering a suite of tools specifically designed to enhance LLM application workflows. It combines advanced development features, real-time performance monitoring, and collaboration tools to simplify and strengthen AI dialogue management.

What sets LangSmith apart is its end-to-end observability and debugging tools, which allow teams to oversee their LLM applications from development to production. This transparency is essential for understanding model behavior and ensuring consistent, reliable outputs.

LangSmith integrates effortlessly with leading LLM providers like OpenAI, Anthropic, and Google, while also supporting custom models through a flexible API setup. Its workflow automation is centered around real-time tracing and evaluation, enabling developers to monitor every stage of their applications and quickly address any issues.

With prompt versioning and A/B testing, teams can systematically refine their prompts. This feature allows developers to compare performance metrics, document changes, and confidently deploy the most effective prompts for various models and use cases.

LangSmith offers detailed usage analytics and cost tracking tools, helping organizations make smarter decisions about their AI expenditures. By identifying costly operations, the platform suggests ways to optimize processes and reduce computational expenses.

In terms of security, LangSmith includes audit logging and access controls to ensure all activities are traceable and meet enterprise governance standards. These features provide the necessary oversight for regulated environments while safeguarding data privacy.

Collaboration is a key focus, with features like shared workspaces and annotation tools that allow team members to collectively review and enhance prompts. Integration with widely used development tools ensures LangSmith blends seamlessly into existing workflows, making it easier for teams to adopt advanced prompt engineering practices without disrupting their processes.

LangSmith delivers a comprehensive solution for organizations aiming to establish structured and scalable prompt engineering workflows while maintaining complete oversight of their AI operations. Its blend of robust features and user-friendly tools makes it an ideal choice for teams looking to optimize their LLM applications.

Every tool comes with its own set of strengths and challenges, which can significantly impact workflow efficiency and costs. Recognizing these trade-offs is crucial to making decisions that align with your team’s needs and organizational goals. Below, we provide a clear comparison of the key benefits and limitations of each tool.

Prompts.ai stands out for its extensive AI orchestration capabilities, offering access to 35+ LLMs, real-time FinOps, and enterprise-level security. These features make it a powerful option for large-scale operations, but its complexity might be overwhelming for smaller teams or simpler use cases.

Agenta is known for its easy-to-use interface and quick deployment, making it a great choice for teams seeking a straightforward approach to prompt management. However, its scalability and integration options may fall short for larger enterprises with more intricate needs.

LangChain offers unparalleled flexibility and deep customization due to its open-source nature. While this makes it highly adaptable, it also requires significant technical expertise, which can extend development timelines.

PromptLayer excels in providing detailed logging and analytics, enabling teams to optimize and debug prompts effectively. Its focus on data-driven insights is a strong advantage, but its narrower scope may necessitate additional tools for managing broader AI workflows.

Lilypad delivers excellent performance for specific use cases, thanks to its streamlined workflows and strong integration options. While its simplicity is a benefit for targeted applications, it may not offer the advanced features needed for complex enterprise scenarios.

OpenPrompt provides reliable foundational features and broad model compatibility at a reasonable price point. This makes it a practical choice for teams seeking basic functionality without added complexity. However, it lacks advanced enterprise capabilities and robust cost-management tools.

LangSmith is tailored for teams that prioritize transparency and monitoring, with features like end-to-end observability, collaboration tools, and A/B testing. While it excels in these areas, its close integration with the LangChain ecosystem could limit flexibility for teams looking for broader compatibility.

| Tool | Key Advantages | Main Disadvantages |

|---|---|---|

| Prompts.ai | Access to 35+ LLMs, enterprise security, real-time cost tracking | Complex setup, steep learning curve for small teams |

| Agenta | Intuitive interface, quick deployment, user-friendly workflows | Limited scalability and fewer integration options |

| LangChain | Highly flexible, supports deep customization, open-source | Requires technical expertise, longer development cycles |

| PromptLayer | Strong analytics and logging, data-driven optimization | Narrow focus, may need supplementary tools |

| Lilypad | Streamlined workflows, solid integration, simple to use | Limited versatility, lacks advanced features |

| OpenPrompt | Basic functionality, good compatibility, affordable | No advanced enterprise tools or cost management |

| LangSmith | Comprehensive monitoring, A/B testing, collaboration tools | Limited flexibility due to LangChain ecosystem ties |

These differences also extend to pricing models, security features, and team collaboration capabilities. While subscription-based pricing can lead to higher ongoing costs, usage-based models often provide more predictable and scalable expenses. Security and compliance features vary widely, with enterprise-focused tools typically offering stronger audit trails and governance. Collaboration features range from basic sharing to fully integrated workspace management, with the ideal choice depending on your team’s size and workflow complexity. Evaluating these factors carefully will help ensure your tool selection aligns with your AI project’s goals and requirements.

To align your choice with your organization's goals, consider the following recommendations based on the comparisons discussed earlier.

Choose a prompt engineering tool that matches your specific needs, team size, and technical requirements. For enterprises managing large-scale AI operations, Prompts.ai stands out as a versatile solution. It combines integrated governance, transparent cost management, and access to over 35 advanced language models. With real-time FinOps tracking and a pay-as-you-go TOKN system, it can cut AI software costs by up to 98%, offering a streamlined way to oversee AI workflows. While initial training is required, the long-term advantages of centralized control and cost clarity make it a worthwhile investment.

Carefully assess pricing models to ensure they align with your operational demands. Prompts.ai’s usage-based model adjusts costs to actual consumption, making it an ideal choice for scalability. Additionally, its robust security and compliance features are particularly valuable for organizations in regulated industries.

To implement effectively, consider starting with a pilot project. This allows you to evaluate performance, team adoption, and system integration within your existing environment. By transitioning from one-off experiments to structured, compliant processes, you can create a tailored AI strategy that meets your organization’s unique needs.

Prompts.ai is making waves in 2025 by bringing together more than 35 AI models, including heavyweights like GPT-4 and Claude, into a single, unified platform. This approach slashes costs by up to 98% while also simplifying even the most intricate AI workflows through real-time automation and seamless model compatibility.

Designed with scalability and efficiency in mind, Prompts.ai enables enterprises to refine their operations, make smarter use of resources, and fully harness the power of their AI initiatives.

Prompts.ai offers complete cost clarity through its TOKN credits system, a straightforward pay-as-you-go approach that removes the burden of recurring fees. With this model, users can monitor token usage in detail, ensuring they only pay for what they actually use.

This system has the potential to reduce AI-related costs by as much as 98%, providing an efficient solution for managing budgets. By streamlining expense tracking, it allows teams to concentrate on refining their AI workflows without the stress of surprise charges.

Prompts.ai places a strong emphasis on security and compliance, offering robust safeguards designed specifically for industries with stringent regulatory needs. These measures include detailed audit logs, well-structured governance frameworks, and strict alignment with key standards like GDPR, NIST, HIPAA, and PCI DSS.

By adhering to these established regulations, Prompts.ai not only protects sensitive data but also helps organizations maintain compliance effortlessly. This makes it a dependable solution for sectors such as healthcare, finance, and other fields that manage critical information.