Un enrutamiento rápido y eficiente puede salvar a las empresas hasta un 40% en los costos de IA al tiempo que mejora el rendimiento del sistema. En lugar de depender de un modelo único y caro para todas las tareas, el enrutamiento dirige las solicitudes al modelo de IA más adecuado en función de la complejidad y el contexto. Esto reduce el uso de tokens, reduce los gastos y acelera las respuestas.

Conclusiones clave:

La gestión eficiente de las solicitudes en los sistemas de IA requiere un enfoque cuidadoso que equilibre los costos y el rendimiento. Al centrarse en tres estrategias clave, las empresas pueden ir más allá de las soluciones genéricas y crear sistemas más inteligentes que optimicen los recursos y mantengan resultados de alta calidad.

El enrutamiento dinámico evalúa cada solicitud y la asigna al modelo más adecuado para el trabajo. Este enfoque tiene en cuenta las variaciones de la carga de trabajo y las condiciones de la red, y garantiza que los recursos se utilicen de manera eficaz.

Para determinar la mejor ruta, herramientas como los modelos de clasificación, la búsqueda semántica o los métodos híbridos analizan las solicitudes entrantes. Por ejemplo, las tareas sencillas, como las consultas básicas del servicio de atención al cliente, se dirigen a modelos más pequeños y rápidos, mientras que las tareas analíticas más exigentes se gestionan mediante sistemas avanzados y de alta potencia. Esto garantiza que los recursos computacionales se asignen en función de las necesidades reales, evitando la dependencia innecesaria de modelos caros y de alto rendimiento. Los estudios muestran que este tipo de enrutamiento inteligente puede reducir los costos hasta en un 30%, y algunos sistemas logran el doble de ahorros en comparación con las configuraciones que se basan únicamente en modelos de primer nivel. Estos ajustes también proporcionan una base sólida para gestionar las interrupciones inesperadas.

Los sistemas de respaldo son fundamentales para mantener un funcionamiento fluido cuando los modelos principales encuentran problemas, como fallas, sobrecargas o interrupciones del servicio. Estos mecanismos se basan en estrategias como las configuraciones con varios proveedores, los reintentos automáticos con retrasos exponenciales, los estrictos controles de tiempo de espera y las pruebas canarias. En conjunto, estas medidas garantizan que las tareas se redirijan de manera adecuada, manteniendo los servicios funcionando sin problemas.

Por ejemplo, los reintentos automáticos con un retraso exponencial solucionan problemas temporales, como los límites de velocidad o los fallos de red, mientras que los umbrales de tiempo de espera evitan que las aplicaciones se congelen. Las pruebas en Canarias permiten introducir nuevos modelos de forma gradual y monitorizar su rendimiento en condiciones reales. Al combinar estos protocolos alternativos con una supervisión constante, las organizaciones pueden ajustar sus sistemas para gestionar las interrupciones de forma eficaz.

La optimización basada en el uso se basa en estrategias dinámicas de enrutamiento y respaldo mediante el análisis continuo de cómo las solicitudes interactúan con los modelos. Este enfoque va más allá del seguimiento básico de los costos para evaluar los patrones de respuesta, la latencia y el uso de los recursos, y permite realizar ajustes automatizados que mejoran el rendimiento y reducen los gastos.

Es fundamental supervisar métricas como el uso de la CPU/GPU, la carga de memoria y la latencia durante el procesamiento rápido. Estos datos ayudan a identificar las ineficiencias y a refinar las decisiones de enrutamiento para alinearlas con las necesidades empresariales actuales. Las revisiones periódicas de estas métricas permiten a las organizaciones detectar tendencias, optimizar la selección de modelos y adaptar las estrategias antes de que las pequeñas ineficiencias se conviertan en problemas mayores. Al combinar la supervisión en tiempo real con las evaluaciones periódicas, las empresas pueden mantener un marco de IA ágil y rentable que evoluciona a la par de sus objetivos.

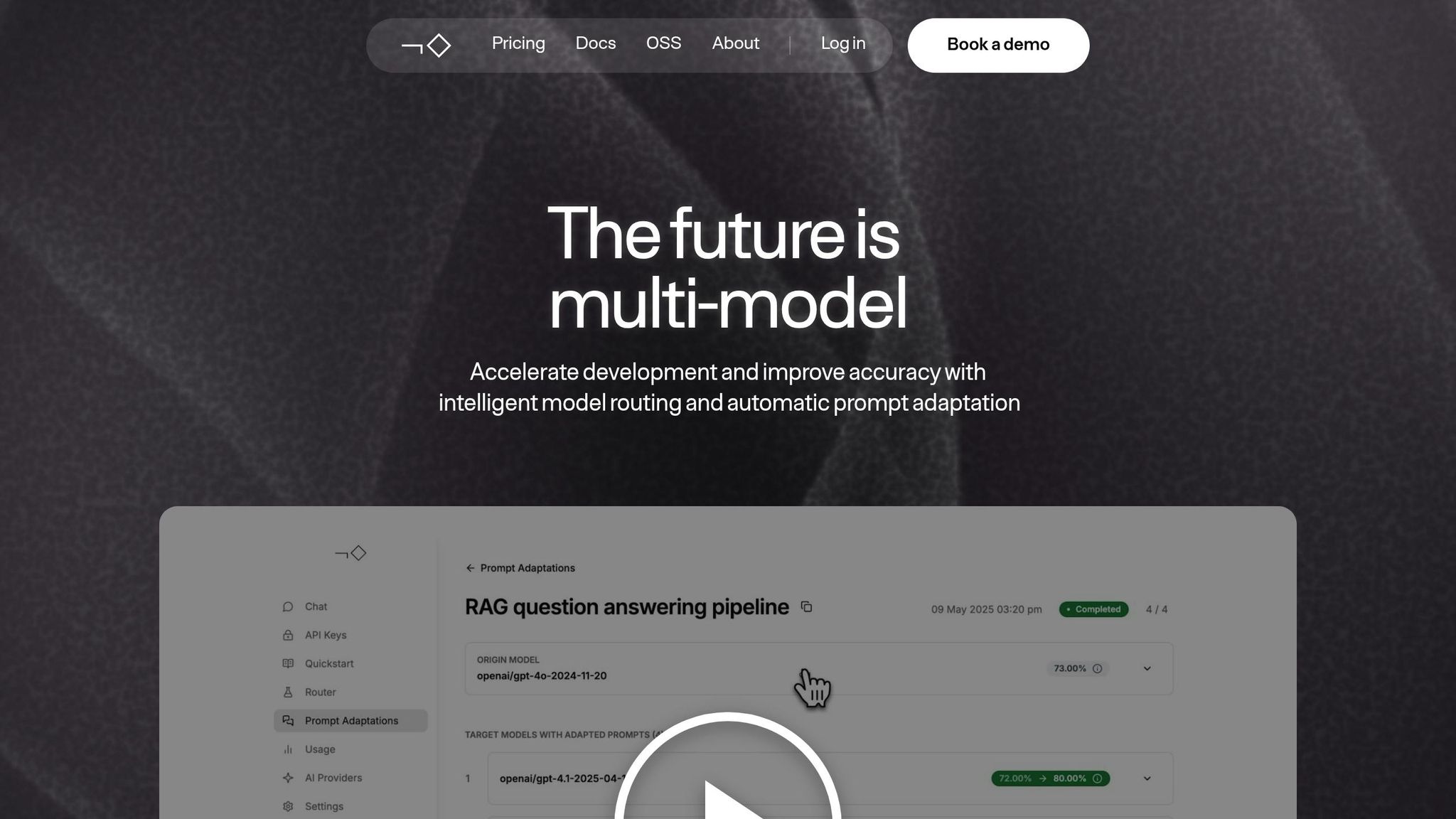

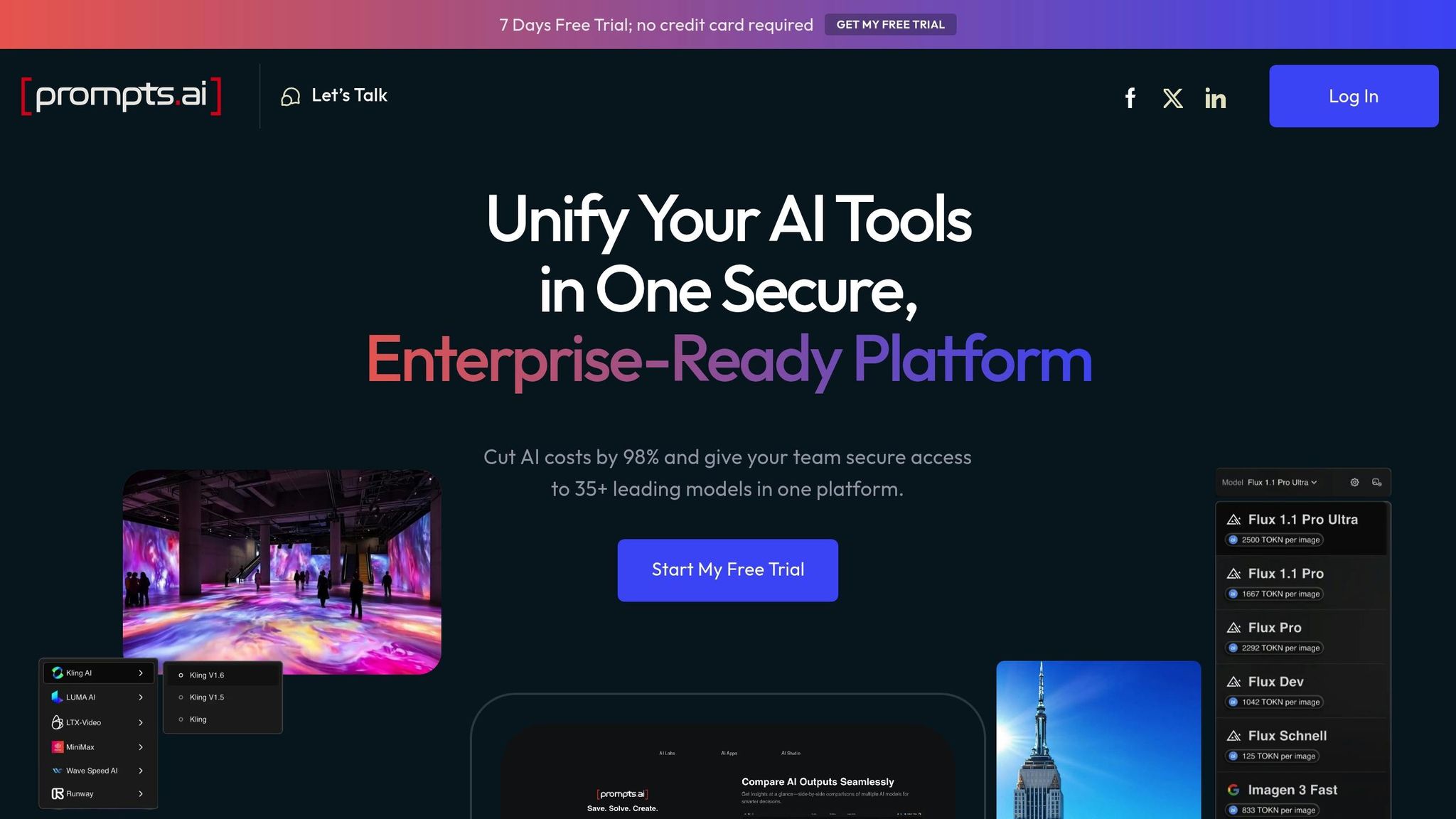

Prompts.ai lleva la administración rápida al siguiente nivel al incorporar estrategias avanzadas de enrutamiento y respaldo. Al unificar varios modelos lingüísticos en una plataforma única y segura, elimina la molestia de tener que hacer malabares con distintas herramientas y suscripciones. Este sistema optimizado reduce la fragmentación de las herramientas, lo que brinda a los equipos una forma centralizada de acceder y administrar varios modelos.

Uno de los desafíos clave en la adopción de la IA es la proliferación de herramientas, y Prompts.ai aborda este problema de manera efectiva. La plataforma consolida las suscripciones, las claves de API y las interfaces en un único entorno. Esto no solo permite a los equipos comparar los principales modelos lingüísticos en paralelo, sino que también se integra perfectamente con herramientas como Slack, Gmail, y Trello. Su arquitectura está diseñada para soportar un escalado rápido, lo que facilita a los equipos ampliar sus capacidades de IA según sea necesario.

Esta configuración unificada también sirve como base para la selección de modelos automatizada y basada en la lógica, lo que garantiza operaciones más fluidas y una mayor eficiencia.

El motor de flujo de trabajo inteligente de la plataforma añade otro nivel de eficiencia al automatizar la selección de modelos. Mediante controles de costos y enrutamiento basados en la lógica, evalúa las solicitudes en función de factores como la complejidad y la carga de trabajo, y las dirige automáticamente al modelo más adecuado. Los equipos también pueden personalizar este proceso especificando el modelo de lenguaje que van a utilizar en situaciones específicas. Además, la plataforma admite las opciones de «traiga su propio modelo» (BYOM), que se adaptan a necesidades especializadas.

Prompts.ai incluye un generador de mensajes que ayuda a refinar las plantillas para obtener respuestas óptimas. Los administradores pueden obtener una vista previa de los resultados generados en el espacio de trabajo de plantillas de mensajes y evaluarlos en función de criterios como el estilo, la coherencia, la relevancia, el sesgo, la precisión de los hechos, etc. Este proceso iterativo cuenta con el respaldo de un entorno sandbox, que permite realizar pruebas seguras y mejorar continuamente.

Como Antrópico puntos destacados en su guía de optimización:

«Siempre es mejor diseñar primero un indicador que funcione bien sin restricciones de modelo o aviso, y luego probar estrategias de reducción de la latencia. Intentar reducir la latencia de forma prematura puede impedir que descubras lo que significa un rendimiento óptimo».

Este enfoque garantiza que las rutas de enrutamiento sean eficientes y de alta calidad.

Prompts.ai funciona como una puerta de enlace de IA y ofrece funciones esenciales como la autenticación, el control de acceso, el seguimiento de costos y el registro. Esto es especialmente importante dado que casi el 90% del uso de la IA empresarial se produce sin supervisión formal. Los paneles compartidos proporcionan a los equipos una visibilidad clara de los costos, lo que fomenta la colaboración entre los equipos de FinOps y de ingeniería.

Las herramientas de aplicación de políticas mejoran aún más la gobernanza. Por ejemplo, la plataforma puede bloquear modelos caros en entornos de ensayo o requerir que se etiqueten cada mensaje. Estas medidas abordan el problema del gasto descontrolado y el uso no autorizado de herramientas. Los estudios muestran que más del 40% de los empleados utilizan herramientas de inteligencia artificial generativa sin la aprobación del empleador. Al ofrecer una visibilidad y una auditabilidad totales, Prompts.ai elimina la proliferación excesiva de claves de API y, al mismo tiempo, mantiene la flexibilidad necesaria para la innovación.

Dan Frydman, fundador de El negocio de la IA, subraya las ventajas prácticas de la plataforma:

«Fundador de El negocio de la IA, ve a las empresas esforzarse por implementar la IA de manera eficiente. En lugar de perder tiempo configurándola, usa Time Savers para automatizar las ventas, el marketing y las operaciones, lo que ayuda a las empresas a generar clientes potenciales, aumentar la productividad y crecer más rápido con estrategias impulsadas por la inteligencia artificial».

Esta combinación de supervisión de costos, gobernanza y flexibilidad garantiza que los equipos puedan aprovechar la IA de manera efectiva sin comprometer el control o la innovación.

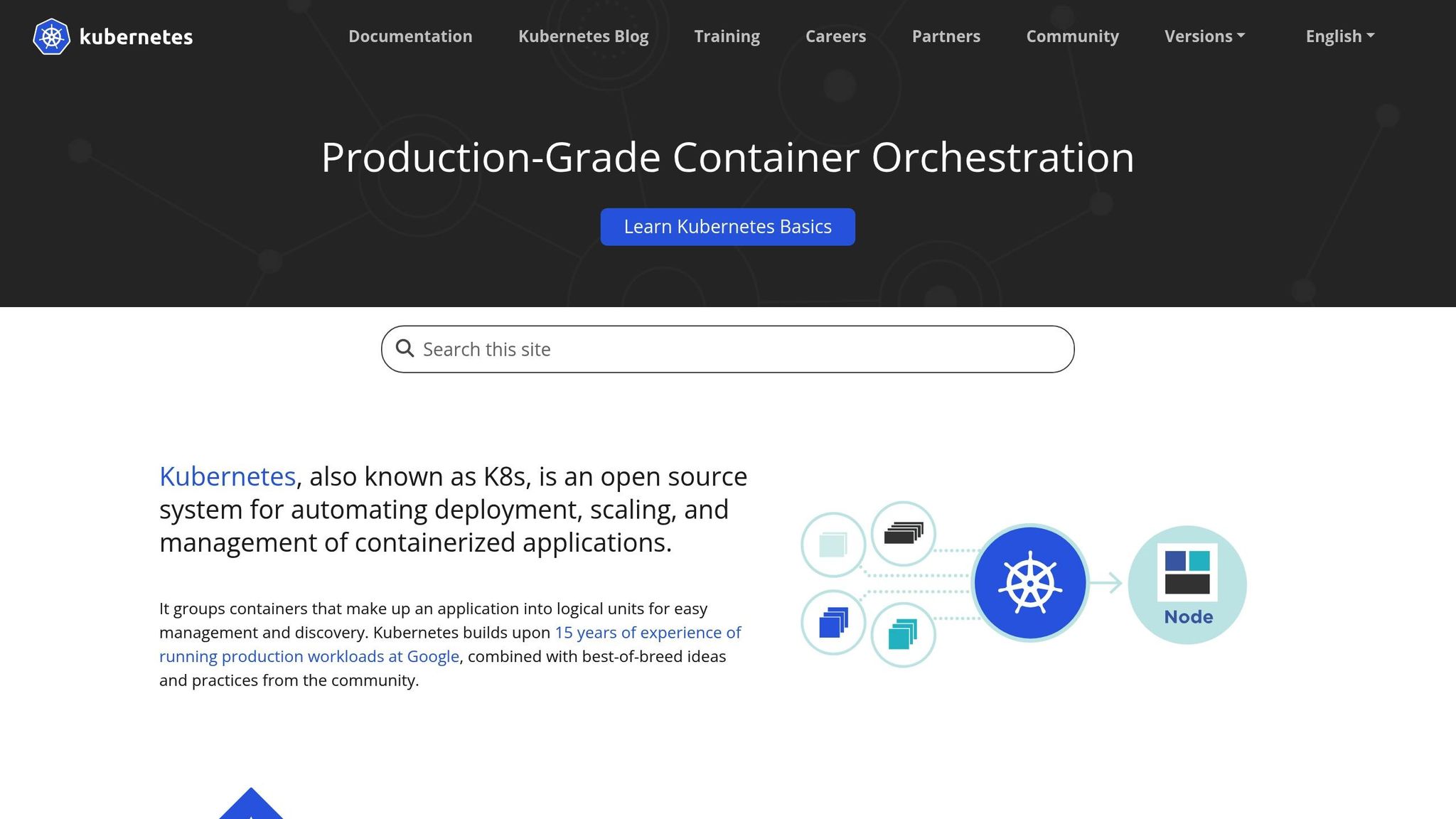

Para las empresas que administran sistemas de IA, tener una infraestructura sólida no es negociable. Kubernetes se ha convertido en la solución ideal para implementar y escalar sistemas de enrutamiento rápido, gracias a su capacidad para gestionar las cargas de trabajo en contenedores con flexibilidad y confiabilidad. Esto es particularmente importante cuando se combinan modelos de varios idiomas y procesos de enrutamiento intrincados.

Kubernetes revoluciona la implementación y la administración de los modelos de IA al proporcionar un marco nativo de la nube que es ideal para poner en funcionamiento las aplicaciones de IA. Su punto fuerte reside en la gestión de las cargas de trabajo en contenedores, lo que la convierte en una herramienta esencial para las organizaciones que desean ampliar las soluciones de IA sin comprometer el rendimiento.

Una de las características más destacadas de Kubernetes es su capacidad para optimizar los recursos, especialmente para las tareas que requieren mucha GPU. Utiliza técnicas como la división del tiempo, el particionamiento MIG, las GPU virtuales y MAPAS NVIDIA para aprovechar al máximo los recursos de la GPU. Esto es fundamental para los sistemas de enrutamiento rápido, donde los diferentes modelos pueden tener diferentes necesidades computacionales. Estas optimizaciones garantizan un funcionamiento fluido incluso con cargas de trabajo fluctuantes.

Para escalar el enrutamiento rápido, Kubernetes emplea patrones de implementación como el escalador automático de módulos horizontales (HPA), que ajusta automáticamente la cantidad de módulos en función del uso de la CPU o la memoria. Cuando aumenta el tráfico rápido, Kubernetes activa más pods para mantener tiempos de respuesta rápidos.

La plataforma también simplifica las tareas de mantenimiento rutinarias. Kubernetes Jobs puede gestionar experimentos únicos, mientras que CronJobs automatiza las tareas recurrentes, como el reentrenamiento nocturno de modelos. Por ejemplo, una empresa de servicios financieros puede usar CronJobs para actualizar sus modelos de detección de fraudes a diario con datos de transacciones nuevos, a fin de garantizar que sigan siendo eficaces.

Además, Kubernetes permite una asignación precisa de los recursos, lo que permite a los equipos controlar las GPU, las CPU y la memoria para satisfacer las demandas de la carga de trabajo. Al establecer las solicitudes y los límites de los recursos, las organizaciones pueden garantizar que sus sistemas funcionen de manera eficiente sin correr el riesgo de conflictos de recursos. Esta capacidad se vuelve aún más vital a medida que las empresas amplían sus operaciones de inteligencia artificial.

La seguridad es una de las principales prioridades de los sistemas de IA empresariales, y Kubernetes proporciona herramientas sólidas para proteger la infraestructura de enrutamiento rápido.

El control de acceso basado en roles (RBAC) es la piedra angular de la seguridad de Kubernetes. Permite a los equipos definir permisos detallados, garantizando que solo los usuarios autorizados puedan acceder a los modelos, las configuraciones de enrutamiento o los datos confidenciales. Esto es especialmente importante cuando diferentes departamentos operan en el mismo entorno de IA, pero requieren un aislamiento estricto de los datos.

Las políticas de red añaden otra capa de protección al limitar la comunicación entre los pods y los espacios de nombres. Esto ayuda a crear límites seguros en torno a las cargas de trabajo de la IA, lo que reduce el riesgo de acceso no autorizado.

La importancia de la seguridad de Kubernetes se destacó en mayo de 2024, cuando los atacantes atacaron Cara abrazadade la plataforma de alojamiento de modelos de IA. Este incidente puso de relieve cómo la infraestructura de inteligencia artificial puede convertirse en un objetivo principal de los ciberataques.

Para proteger aún más los sistemas, las organizaciones deben centrarse en la seguridad de las imágenes de los contenedores. Las canalizaciones automatizadas pueden escanear los contenedores de modelos de IA y sus dependencias en busca de vulnerabilidades antes de la implementación, lo que garantiza que los componentes comprometidos no lleguen a la fase de producción.

La administración de secretos es igualmente crítica cuando se trata de claves de API, pesos de modelos y otros datos confidenciales. Si bien Kubernetes ofrece una gestión de secretos integrada, los equipos deberían mejorar estas capacidades con políticas de cifrado en reposo y de rotación regular. Las herramientas de inteligencia artificial también pueden ayudar a analizar los entornos de Kubernetes para identificar y clasificar la información confidencial.

Las herramientas de seguridad emergentes impulsadas por la inteligencia artificial añaden una capa adicional de defensa. Estos sistemas utilizan el aprendizaje automático para automatizar los protocolos de seguridad, aplicar controles de acceso dinámicos y detectar anomalías en tiempo real. Para lograr un enrutamiento rápido, esto significa identificar los patrones de tráfico inusuales o los intentos de acceso no autorizado antes de que se agraven.

Por último, la supervisión y el registro exhaustivos son esenciales. Herramientas como Prometeo y Grafana permiten a los equipos realizar un seguimiento de las métricas de rendimiento y los eventos de seguridad, lo que permite una detección y resolución rápidas de los problemas. Esta visibilidad garantiza que los sistemas de enrutamiento rápido sigan siendo eficientes y seguros.

Cuando se trata de ajustar la ejecución rápida, la selección de la estrategia de enrutamiento correcta puede influir de manera significativa en la eficiencia, el costo y el rendimiento. Cada método tiene su propio conjunto de ventajas y desventajas, que afectan a la velocidad de implementación, la complejidad operativa y la calidad de los resultados. Comprender estas diferencias es esencial para alinear su enfoque con los objetivos de su organización.

Las consideraciones de costos desempeñan un papel importante. Por ejemplo, las implementaciones en el mundo real han arrojado resultados impresionantes: SciForce logró una reducción del 37 al 46% en el uso de LLM con tiempos de respuesta entre un 32 y un 38% más rápidos, mientras Arcee-Blitz registró un asombroso ahorro de costos del 99,38%. Estos casos muestran cómo el enrutamiento inteligente puede reducir los gastos hasta en un 30%.

«Es posible que el futuro de la IA no consista en tener el modelo más potente, sino en aprovechar de forma inteligente el modelo correcto en el momento adecuado». - Sam Selvanathan

A continuación se muestra una comparación en paralelo de varias metodologías de enrutamiento, que muestra su complejidad, adaptabilidad y aplicaciones ideales.

Cada enfoque responde a necesidades diferentes. El enrutamiento determinista, por ejemplo, es sencillo y predecible, lo que lo hace ideal para aplicaciones con flujos de trabajo bien definidos. Sin embargo, carece de flexibilidad, lo que puede convertirse en una limitación a medida que evolucionan las necesidades de los usuarios.

Por otro lado, el enrutamiento semántico basado en ML utiliza una clasificación basada en modelos para dirigir las solicitudes en función de su dominio, lo que lo convierte en una opción sólida para aplicaciones con numerosas categorías. Un enfoque híbrido, que combina la búsqueda semántica con el enrutamiento basado en clasificadores, ofrece un punto medio eficaz. Por ejemplo, Arcee-Blitz logró una reducción de costos del 99,67% en las tareas de análisis financiero con este método.

Comenzar de manera simple y refinar con el tiempo es a menudo el mejor curso de acción. Las herramientas de monitoreo pueden proporcionar información valiosa y ayudarlo a ajustar las reglas de enrutamiento a medida que cambian sus requisitos.

«La IA eficiente incluye todos los temas y tácticas para lograr la rentabilidad, la eficiencia de los modelos, la optimización de la computación, la selección de modelos y la latencia». - Katherine Walther, vicepresidenta de innovación de Trace3

El objetivo final de todas las estrategias es minimizar el desperdicio y maximizar el rendimiento. Al utilizar el modelo más adecuado para cada tarea, puede lograr el equilibrio adecuado entre costo y calidad, garantizando que sus usuarios obtengan la experiencia que esperan.

El enrutamiento rápido efectivo es un punto de inflexión para la IA empresarial, ya que impulsa la rentabilidad y mejora el rendimiento. Se ha demostrado que el enrutamiento con modelos dinámicos reduce los costos de inferencia entre un 40 y un 85%. Por ejemplo, una empresa de tecnología legal logró una reducción de costos del 35% y mejoró los tiempos de respuesta en un 20% en solo dos meses.

Confiar en un modelo único para todas las tareas no es práctico ni eficiente. La clave está en la asignación estratégica de las tareas: las consultas más sencillas se destinan a modelos más pequeños y rápidos, mientras que las tareas complejas son gestionadas por modelos más potentes. Investigación de IBM destaca este enfoque y demuestra que el uso de un router LLM para dirigir las consultas a modelos más pequeños puede reducir los costos hasta en un 85% en comparación con usar siempre el modelo más grande de forma predeterminada.

Los líderes de la industria se hacen eco de este sentimiento:

«La próxima ventaja competitiva de la IA no provendrá de modelos más grandes, sino de una orquestación más inteligente». - Dario Amodei, CEO de Anthropic

Prompts.ai lleva este concepto más allá al simplificar la orquestación de los modelos de IA. A través de su plataforma, las empresas pueden enviar las indicaciones de manera eficiente a más de 35 modelos líderes. El motor de flujo de trabajo inteligente de la plataforma gestiona las complejidades de probar y optimizar las rutas de enrutamiento, mientras que sus controles FinOps integrados brindan la transparencia necesaria para monitorear y administrar los costos de manera efectiva.

Las innovaciones emergentes, como los enrutadores basados en el aprendizaje por refuerzo, prometen una mejora continua en las estrategias de enrutamiento. Además, la expansión de los centros de modelos facilita la integración de nuevos modelos, lo que permite un escalado automático sin problemas para los equipos de FinOps y DevOps.

Para las empresas que buscan ir más allá de las implementaciones de IA de prueba y error, la prioridad debe ser desarrollar estrategias de enrutamiento sólidas. Esto incluye la planificación de las opciones alternativas y la implementación de un monitoreo continuo. Las organizaciones que perfeccionen estos fundamentos en la actualidad estarán mejor posicionadas para crear sistemas de IA escalables y eficientes que ofrezcan resultados empresariales cuantificables, y no solo prototipos llamativos.

El paso del uso de un modelo único al enrutamiento inteligente marca un cambio fundamental en la IA empresarial. Se trata de maximizar el valor de las inversiones en IA y, al mismo tiempo, minimizar los costos y las interrupciones. Este enfoque sienta las bases para una infraestructura de IA resiliente y eficiente que impulse el éxito empresarial tangible.

El enrutamiento dinámico de avisos optimiza las operaciones de IA al hacer coincidir los avisos con los modelos más apropiados en función de factores como la complejidad, la carga de trabajo y el costo. Este enfoque específico ayuda a evitar el desperdicio de recursos y reduce el uso innecesario de tokens.

Al ajustar las decisiones de enrutamiento, los equipos pueden reducir los costos tanto como 40% sin sacrificar la calidad. Logra un equilibrio entre velocidad, precisión y presupuesto, lo que hace que los flujos de trabajo de IA sean más eficientes y rentables.

Kubernetes es fundamental para mejorar escalabilidad, ya que ajusta de forma dinámica la asignación de recursos y escala automáticamente para gestionar las cambiantes demandas de carga de trabajo. Esta capacidad garantiza que las tareas de inteligencia artificial se ejecuten sin problemas, incluso durante períodos de alta actividad.

Cuando se trata de seguridad, Kubernetes implementa políticas estrictas, monitorea continuamente las amenazas y protege la integridad de los datos en todos los clústeres. Estas características lo convierten en una base crucial para crear sistemas de enrutamiento rápido mediante IA escalables y seguros.

Para garantizar operaciones de IA ininterrumpidas, especialmente durante fallos o períodos de alta demanda, las empresas pueden implementar mecanismos de respaldo. Esto implica identificar las áreas en las que pueden producirse fallas y establecer planes de respaldo. Algunos ejemplos de estas estrategias son los reintentos automatizados, los disyuntores o la reorientación de las tareas a flujos de trabajo alternativos, todo ello con el objetivo de minimizar las interrupciones.

El fortalecimiento de estos procesos alternativos se puede lograr mediante ingeniería del caos. Al simular intencionalmente las fallas del sistema, los equipos pueden descubrir vulnerabilidades y refinar sus sistemas para mejorar la confiabilidad. Este enfoque ayuda a mantener un rendimiento constante, incluso cuando las condiciones no son las ideales.