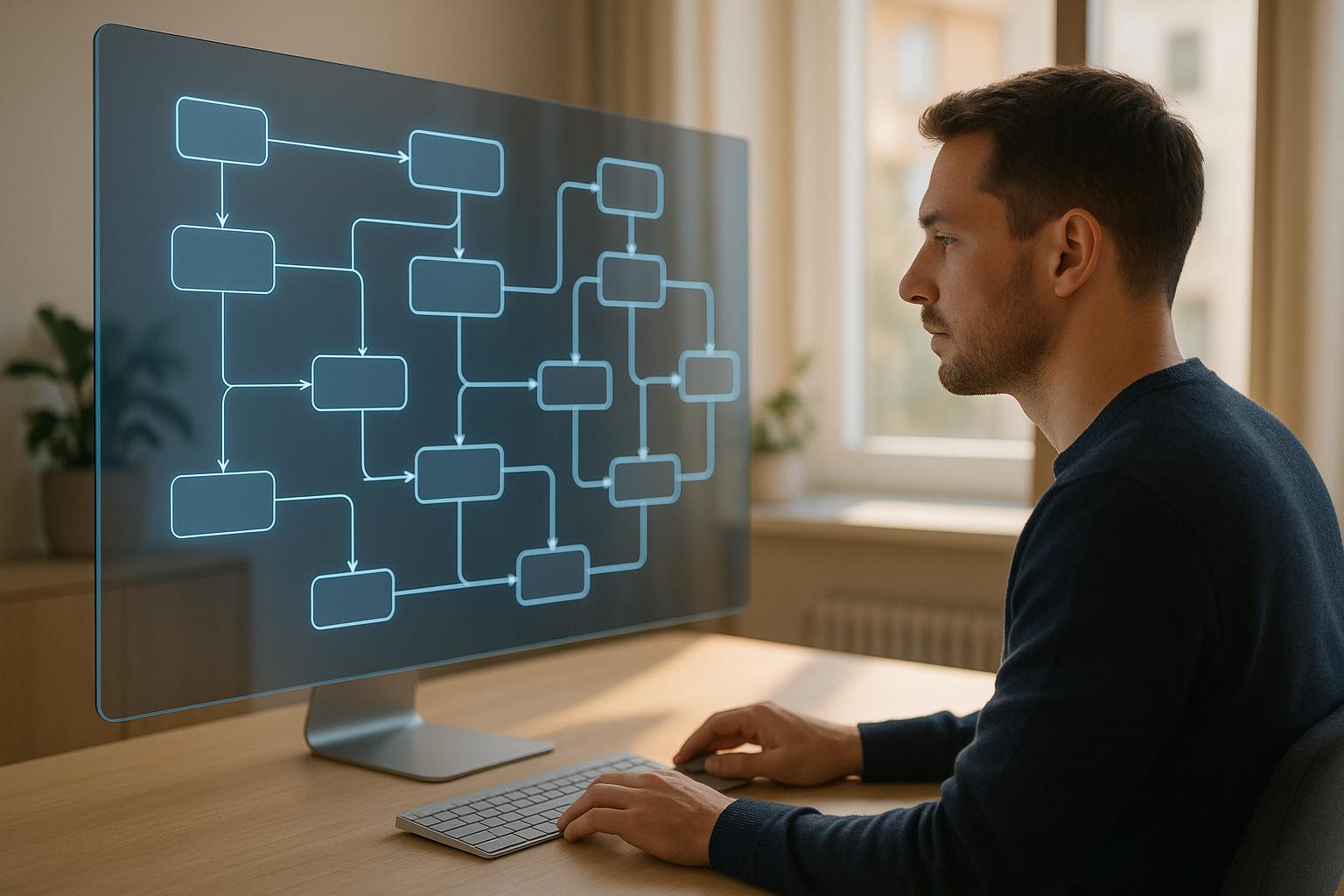

Los canales de toma de decisiones de LLM son sistemas que utilizan la inteligencia artificial para convertir los datos sin procesar en decisiones y acciones, automatizando los flujos de trabajo complejos. He aquí un desglose rápido:

Los procesos de LLM constan de tres etapas principales: la ingesta de datos, la gestión rápida y la validación de los resultados. Plataformas como prompts.ai simplifique su implementación con herramientas para la supervisión en tiempo real, las canalizaciones de RAG y la integración del cumplimiento. Estos sistemas están transformando sectores como el financiero, el sanitario y el servicio de atención al cliente al tomar decisiones de forma más rápida y escalable.

La creación de canales de toma de decisiones de LLM eficaces requiere una integración perfecta de tres etapas principales, desde la recopilación de datos sin procesar hasta la toma de decisiones informadas.

El primer paso en cualquier proceso de toma de decisiones de LLM es ingestión de datos - el proceso de recopilar información sin procesar de varias fuentes y convertirla en un formato que los LLM puedan procesar. Este paso es esencial para garantizar que el sistema tenga la base adecuada para ofrecer resultados significativos.

Comienza cargando documentos externos como PDF, archivos DOCX, texto sin formato o HTML y dividiéndolos en fragmentos manejables. Estos fragmentos están diseñados para ajustarse a los límites de procesamiento del LLM y, al mismo tiempo, mantener su contexto original.

bases de datos vectoriales son un punto de inflexión aquí. A diferencia de las bases de datos tradicionales que se basan en coincidencias exactas, las tiendas vectoriales utilizan la recuperación basada en la similitud, lo que facilita la búsqueda de información relevante incluso cuando la consulta no coincide perfectamente con el material de origen. Al elegir entre bases de datos vectoriales administradas localmente o basadas en la nube, las organizaciones se enfrentan a un dilema: las opciones en la nube son más fáciles de escalar, pero conllevan costes adicionales, mientras que las configuraciones locales ofrecen más control pero requieren un mayor mantenimiento.

Por ejemplo, en septiembre de 2024, un sistema RAG (Retrieval-Augmented Generation) que utilizaba LangChain demostró cómo se podían cargar diversas fuentes de datos, convertirlas en incrustaciones y almacenarlas en una base de datos vectorial. Esta configuración permitió al LLM extraer información relevante de las fuentes de conocimiento y generar respuestas enriquecidas con el contexto.

La ingesta adecuada de datos es la columna vertebral de las búsquedas eficientes, las recomendaciones precisas y los análisis detallados. Una vez que los datos estén listos, el siguiente objetivo es gestionar la forma en que el LLM interpreta y responde a las indicaciones.

Con los datos disponibles, gestión rápida se convierte en la clave para dirigir el comportamiento del LLM. Esta etapa determina cómo el sistema interpreta las consultas de los usuarios y genera respuestas que se alinean con las necesidades específicas.

Las instrucciones bien elaboradas logran un equilibrio entre ser claras y proporcionar suficiente contexto para guiar el LLM de manera efectiva. Por ejemplo, en junio de 2024, Salus AI mejoró la precisión del LLM para las tareas de cumplimiento de los exámenes médicos del 80% al 95-100% mediante el perfeccionamiento de las instrucciones. Un mensaje vago como «¿El agente de llamadas sugiere que la prueba es necesaria?» se modificó y pasó a ser «¿El agente de llamadas le dice al consumidor que la prueba es obligatoria?» - un cambio que aumentó la precisión de 69 a 99 puntos porcentuales. Además, se ha demostrado que las indicaciones optimizadas mejoran el rendimiento hasta en 68 puntos porcentuales, y las indicaciones de una sola pregunta añaden otro aumento de 15 puntos.

Las mejores prácticas en la administración de prontas incluyen el control de versiones y el mantenimiento de las solicitudes separadas del código para mejorar la seguridad y facilitar las actualizaciones. Las indicaciones modulares, creadas con componentes reutilizables y variables interpoladas, simplifican el mantenimiento. Las pruebas iterativas garantizan un perfeccionamiento continuo, mientras que la colaboración entre los equipos técnicos, los expertos en el campo y los usuarios mejora el diseño general.

Una vez que se optimizan las solicitudes, el proceso pasa a validar y refinar los resultados del LLM.

El último paso del proceso es procesamiento de salida, lo que garantiza que las respuestas del LLM cumplan con los estándares de calidad antes de que se utilicen para tomar decisiones. Este paso es fundamental para mantener la precisión y la fiabilidad.

«La validación de los resultados de los modelos es un paso crucial para garantizar la precisión y confiabilidad de los modelos de aprendizaje automático». — Nightfall AI

Dos métodos comunes para evaluar los resultados son la puntuación estadística y la puntuación basada en modelos. Los puntajes estadísticos ofrecen consistencia, pero pueden tener dificultades con razonamientos complejos, mientras que los puntuadores basados en modelos destacan por su precisión, pero pueden ser menos confiables. Muchas organizaciones combinan estos enfoques para lograr una evaluación más equilibrada.

Las métricas clave para la evaluación de los resultados incluyen la relevancia, la finalización de la tarea, la corrección, la detección de alucinaciones, la precisión de las herramientas y la adecuación contextual. Los expertos recomiendan limitar los procesos de evaluación a cinco métricas para mantener la eficiencia. Por ejemplo, en un caso de resumen de textos en un hospital, un evaluador del DAG se aseguró de que los resúmenes siguieran la estructura requerida, otorgando puntajes perfectos solo cuando se cumplían todos los criterios de formato.

«Garantizar la confiabilidad de los LLM es primordial, especialmente cuando se integran en aplicaciones del mundo real donde la precisión y la coherencia son esenciales». — AnteMatter.io

La supervisión continua es igual de importante. Los sistemas de telemetría rastrean el rendimiento del modelo, la interacción con los clientes y la satisfacción, lo que ayuda a identificar y abordar cualquier problema de rendimiento. La combinación de métricas automatizadas con la supervisión humana proporciona una comprensión más matizada del rendimiento del LLM.

Ahora que hemos analizado los componentes principales, analicemos cómo funcionan estos oleoductos en la práctica. El proceso se desarrolla en tres fases, cada una de las cuales se basa en la anterior para ofrecer decisiones confiables y automatizadas.

El viaje comienza con la recopilación de datos sin procesar de una variedad de fuentes y configurarlos en un formato que el LLM pueda procesar. Esta fase garantiza que los datos estén limpios, estructurados y listos para el análisis en tiempo real.

Toma IA no estructurada como ejemplo. Transforma documentos semiestructurados, como archivos PDF y DOCX, en salidas estructuradas. Esto incluye convertir tablas a formatos CSV o Excel, extraer caracteres con etiquetas semánticas, organizar el texto de forma lógica y almacenar las incrustaciones numéricas en una base de datos vectorial para recuperarlas rápidamente.

Un paso clave aquí es tokenización, donde el texto de entrada se divide en partes más pequeñas y manejables. De media, un símbolo representa unos cuatro caracteres en inglés.

Este paso se vuelve fundamental en las aplicaciones activas en las que el sistema debe gestionar diversas entradas, como tickets de servicio al cliente, informes financieros o datos de sensores, y convertirlas en un formato estandarizado. Esta coherencia garantiza que el LLM pueda procesar los datos con precisión, sin importar su forma original.

Una vez formateados los datos, el proceso pasa a la fase de procesamiento, donde el LLM hace su magia. En este caso, el modelo transforma los tokens de entrada en decisiones procesables, y aprovecha sus capacidades de inferencia en dos etapas: rellenar previamente y decodificar.

«La inferencia permite a un LLM razonar a partir de las pistas del contexto y los conocimientos básicos para sacar conclusiones. Sin ella, los LLM simplemente almacenarían patrones y no podrían aplicar sus conocimientos de manera significativa».

Durante el fase de prellenado, el sistema convierte la entrada del usuario en fichas y, a continuación, en valores numéricos que el modelo puede interpretar. El fase de decodificación sigue, donde el modelo genera incrustaciones vectoriales en función de la entrada y predice el siguiente token.

En esencia, este proceso gira en torno a una tarea fundamental: predecir la siguiente palabra. Pero la toma de decisiones va más allá. Los LLM combinan el razonamiento estadístico, la heurística basada en reglas y herramientas externas para filtrar las variables de decisión clave y proponer soluciones optimizadas [32, 34].

Un ejemplo del mundo real destaca este proceso. En un estudio de caso de planificación de infraestructura sostenible, los LLM proporcionaron información personalizada para diferentes públicos. Para los expertos en este campo, el modelo identificó que la Solución 404 aumentó el uso de energía renovable del 15% al 55%, lo que redujo la puntuación de impacto ambiental en más del 54%. Para el personal de nivel medio, demostró que la Solución 232 mejoró la rentabilidad a 46 unidades/$, lo que elevó la puntuación de impacto ambiental de 1,004 a 0,709. Para los responsables de la toma de decisiones, explicó cómo el aumento de la durabilidad de 25 a 35 años reducía los impactos ambientales y, al mismo tiempo, equilibraba los costos más altos con los beneficios a largo plazo.

Para gestionar solicitudes de gran volumen, las organizaciones suelen utilizar técnicas como compresión de modelos, cuantificación y administración eficiente de la memoria. Estas optimizaciones son esenciales para mantener el rendimiento en escenarios de tiempo real.

Una vez que el LLM ha procesado los datos y tomado decisiones, el sistema prepara los resultados para su uso inmediato.

La fase final se centra en la entrega de decisiones en formatos que sean procesables, transparentes y que cumplan con las necesidades de los usuarios y del sistema.

La entrega de productos debe dirigirse a varios públicos simultáneamente. Por ejemplo, es posible que sea necesario presentar una sola decisión en forma de un informe técnico detallado para los ingenieros, un panel resumido para los gerentes y una activación automática de acciones para los sistemas integrados. Los oleoductos modernos lo consiguen de la siguiente manera generación de salida multiformato, adaptando la información para que se ajuste a casos de uso específicos.

Los informes automatizados desempeñan un papel fundamental en este sentido, especialmente para industrias como la atención médica, las finanzas y los servicios legales, donde el cumplimiento no es negociable. El sistema registra los fundamentos de las decisiones, las puntuaciones de confianza y los datos de respaldo, creando un registro de auditoría que cumple con los requisitos reglamentarios.

En marzo de 2025, El pensamiento funciona hizo hincapié en la importancia de integrar las evaluaciones en los procesos de despliegue para garantizar un rendimiento uniforme. Estas evaluaciones validan la confiabilidad del modelo antes de la implementación y mantienen la calidad durante todo su ciclo de vida.

«No trate las evaluaciones como una idea de último momento: conviértalas en la piedra angular de su proceso de desarrollo para crear aplicaciones de IA sólidas y centradas en el usuario».

Antes de que las decisiones lleguen a los usuarios finales, los pasos de validación en tiempo real, como la moderación del contenido, las comprobaciones de precisión y las revisiones de cumplimiento, garantizan que los resultados cumplan con los estándares de calidad. Este enfoque por capas minimiza el riesgo de que se produzcan errores en la producción.

Plataformas como prompts.ai simplifican todo este flujo de trabajo. Ofrecen herramientas para el seguimiento de la tokenización, el procesamiento multimodal y la generación automática de informes, a la vez que mantienen un modelo de precios de pago por uso que se amplía con el uso.

Sin embargo, muchas organizaciones se enfrentan a desafíos a la hora de implementar estas canalizaciones. Una encuesta reveló que el 55% de las empresas aún no han implementado un modelo de aprendizaje automático, principalmente debido a la complejidad de la administración de los flujos de trabajo y la implementación de los datos. Sin embargo, las empresas que implementan con éxito estos procesos trifásicos suelen ver importantes mejoras en la velocidad, la coherencia y la escalabilidad de las decisiones.

La integración de las canalizaciones de toma de decisiones de LLM en sus flujos de trabajo requiere una planificación cuidadosa, especialmente a la hora de seleccionar herramientas de orquestación y estrategias de escalado que se alineen con el crecimiento de su negocio.

Los marcos modernos de orquestación de LLM ofrecen soluciones modulares adaptadas a diversas necesidades. Entre los más populares se encuentran Cadena LANG, con 83.800 estrellas de GitHub. Destaca por su diseño modular, sus plantillas rápidas y su perfecta integración con bases de datos vectoriales, lo que lo hace ideal para flujos de trabajo complejos de IA. Índice Llama, con 31 200 estrellas, se centra en la integración de datos y la generación aumentada de recuperación (RAG) y ofrece conectores para más de 160 fuentes de datos.

La elección del marco adecuado depende de su caso de uso específico. LangChain es perfecto para la integración dinámica de herramientas y el comportamiento de las agencias, mientras que LlamainDex se destaca en los flujos de trabajo que requieren una recuperación eficiente de datos de grandes conjuntos de documentos.

Cada marco tiene sus puntos fuertes. LangChain admite flujos de trabajo modulares, AutoGen se centra en la comunicación con los agentes, Llamaindex se especializa en aplicaciones RAG, CrewAI gestiona las tareas específicas de cada función y Haystack proporciona la búsqueda semántica y la recuperación de documentos.

Sin embargo, los expertos advierten contra la confianza excesiva en estos marcos en los entornos de producción. Richard Li, asesor de inteligencia artificial para agencias, señala:

«El valor que tienen es que es una experiencia más fácil: sigues un tutorial y listo, ya tienes una ejecución duradera y, boom, ya tienes memoria. Pero la pregunta es, ¿en qué momento vas a pensar: «Ahora lo estoy usando en producción y no funciona muy bien?» Esa es la cuestión».

Para abordar este problema, plataformas como prompts.ai tomar una ruta diferente. En lugar de encerrarlo en un marco, prompts.ai habilita flujos de trabajo de LLM interoperables que integran varios modelos sin esfuerzo. Sus capacidades multimodales se encargan de todo, desde el procesamiento de textos hasta la creación de prototipos desde bocetos a imágenes, mientras que la integración de bases de datos vectoriales admite aplicaciones RAG sin depender de un proveedor.

La rentabilidad es otro factor crítico. Dado que la tokenización afecta directamente a los costos (cada token representa aproximadamente cuatro caracteres en inglés), el seguimiento preciso de los tokens garantiza una mejor presupuestación y optimización del uso.

Para una aplicación práctica, Vincent Schmalbach, desarrollador web e ingeniero de inteligencia artificial, aconseja la simplicidad:

«La mayoría de las personas complican demasiado los flujos de trabajo de LLM. Trato cada modelo como una herramienta básica: entran datos y sale algo. Cuando necesito que varios LLM trabajen juntos, simplemente canalizo los resultados de uno a otro».

Un ejemplo notable de octubre de 2024 fue la integración de una acción de revisión del código de IA en una canalización de CI. Esta configuración comprobó la conformidad del estilo, las vulnerabilidades de seguridad, la optimización del rendimiento y la integridad de la documentación mediante un trabajo de revisión del código de IA configurado en Ubuntu con una clave de OpenAI. Esto demuestra cómo los LLM pueden mejorar los flujos de trabajo sin requerir una revisión completa del sistema.

UN arquitectura de microservicios es con frecuencia el mejor enfoque para la integración. Aísla el módulo LLM, lo que le permite escalar de forma independiente. Esto garantiza que las actualizaciones o los problemas con el componente de inteligencia artificial no afecten a todo el sistema.

Con los marcos de orquestación establecidos, el siguiente paso consiste en escalar y mantener estos flujos de trabajo de manera eficaz.

La ampliación de los procesos de toma de decisiones de LLM requiere una arquitectura cuidadosa y un mantenimiento proactivo. Un buen punto de partida es flujos de trabajo automatizados de LLMOps para gestionar tareas como el preprocesamiento y la implementación de datos.

Plataformas en la nube como AWS, Google Cloud, y Azure proporcionan una infraestructura escalable, pero es fundamental equilibrar el costo y el rendimiento. Implementar Canalizaciones de CI/CD diseñadas para LLM garantiza que las actualizaciones se prueben e implementen de manera eficiente al tiempo que optimiza el rendimiento del modelo.

Herramientas como Kubeflow, MLFlow, y Flujo de aire simplifique la organización de los componentes del ciclo de vida de LLM. Facilitan la resolución de problemas, mejoran la escalabilidad y se integran perfectamente con los sistemas existentes.

La optimización del rendimiento es imprescindible. Técnicas como la destilación de modelos, la presupuestación simbólica y la reducción de la longitud del contexto pueden mejorar la eficiencia. Para entornos de alto riesgo, la incorporación retroalimentación humana al día garantiza la validación y el refinamiento de los resultados del LLM.

Monitorización y observabilidad son imprescindibles. Las métricas clave, como los tiempos de respuesta, el uso de los tokens, las tasas de error y las tasas de alucinaciones, ayudan a identificar los problemas de forma temprana y a guiar la mejora continua.

La escalabilidad también conlleva mayores requisitos de seguridad. Las mejores prácticas incluyen la desinfección de las entradas, la protección de las claves de API y el cifrado de los registros de LLM. Muchos sectores también exigen medidas de cumplimiento, como filtrar la información personal o el contenido ofensivo y etiquetar las respuestas generadas por la IA.

Empezar poco a poco y escalar gradualmente es con frecuencia la estrategia más eficaz. Al centrarse en un caso de uso limitado, los equipos pueden implementar más rápido, aprender de los resultados iniciales y expandirse en función del rendimiento. La supervisión humana y las puertas de aprobación para los cambios críticos garantizan un proceso de escalamiento controlado.

La mejora continua es vital. Las pruebas A/B de las indicaciones y las diversas entradas de las pruebas, junto con los mecanismos de retroalimentación, ayudan a controlar la precisión y a medir el impacto en la velocidad de desarrollo. Esto garantiza que el sistema evolucione de forma positiva con el tiempo.

La administración de costos se vuelve cada vez más importante a medida que aumenta el uso. Las plataformas de pago por uso, como prompts.ai, alinean los costos con el uso real, lo que evita gastos generales innecesarios. Junto con el seguimiento de los tokens, este enfoque proporciona transparencia sobre los factores que impulsan los costos y destaca las áreas de optimización.

Por último, la decisión de utilizar modelos de código abierto como Mistral, Falcon o LLama frente a API comerciales como OpenAI, Anthropic o Cohere afecta a la latencia, el cumplimiento, la personalización y los costos. Cada opción tiene ventajas y desventajas que se hacen más pronunciadas a medida que los sistemas escalan.

Los procesos de toma de decisiones de LLM están remodelando las industrias al ofrecer soluciones prácticas donde la velocidad, la precisión y la escalabilidad son fundamentales. Analicemos algunas de las áreas clave en las que estos oleoductos están teniendo un impacto real.

Un asombroso 94% de las organizaciones considera que el análisis empresarial es esencial para el crecimiento, y el 57% aprovecha activamente el análisis de datos para dar forma a sus estrategias. Los procesos de LLM destacan por convertir los datos sin procesar en información útil, ya que procesan tanto las entradas no estructuradas, como los correos electrónicos y los tickets de soporte, como los datos estructurados de las bases de datos. Esto crea una visión integral que ayuda a las empresas a tomar decisiones más inteligentes.

Toma Fuerza de ventas, por ejemplo. Utilizan los LLM para predecir la pérdida de clientes mediante el análisis de los patrones históricos de compra y las interacciones con el servicio de atención al cliente. Esto les permite identificar a los clientes en riesgo y tomar medidas proactivas para retenerlos. Su GPT de Einstein integra varios LLM para abordar tareas de CRM, como la previsión y el análisis predictivo.

Lo que diferencia a los LLM en el análisis predictivo es su capacidad para detectar patrones, correlaciones y anomalías que los modelos tradicionales podrían pasar por alto. Por ejemplo, el GPT-4 ha demostrado una tasa de precisión del 60% en las previsiones financieras, superando a los analistas humanos.

«En esencia, una canalización de datos de IA es la forma en que se alimenta un modelo de IA, que proporciona los datos correctos, en el momento correcto y en el formato correcto para impulsar la toma de decisiones inteligentes». — David Lipowitz, director sénior de ingeniería de ventas de Matillion

Sin embargo, el éxito depende de mantener datos de alta calidad mediante rigurosos procesos de limpieza y validación. Las empresas también deben invertir en una infraestructura sólida, como el almacenamiento en la nube o la computación distribuida, para gestionar el procesamiento de datos a gran escala y en tiempo real. Las auditorías periódicas son cruciales para identificar y abordar los sesgos, garantizando que la supervisión humana mantenga los resultados justos y relevantes.

Los procesos de LLM no solo mejoran el análisis, sino que también revolucionan la atención al cliente.

En la atención al cliente, los procesos de toma de decisiones de LLM están generando ahorros de costos tangibles y eficiencias operativas. Por ejemplo, los minoristas que utilizan chatbots han registrado una reducción del 30% en los costos de servicio al cliente. El chatbot «Pregúntale a Delta» de Delta Airlines ayuda a los clientes a realizar tareas como el registro de vuelos y el seguimiento del equipaje, lo que ha permitido reducir un 20% el volumen de los centros de llamadas.

La implementación de estos sistemas requiere una planificación cuidadosa. Una emisora lanzó con éxito un chatbot con AWS para responder a las preguntas sobre los programas gubernamentales extrayendo información de documentos oficiales. Los sistemas multiagente, en los que los LLM individuales se encargan de tareas específicas, ayudan a reducir la latencia y a mejorar el rendimiento. Técnicas como la generación aumentada de recuperación (RAG) mejoran aún más la precisión al incorporar conocimientos externos en las respuestas.

Para garantizar la confiabilidad, las empresas deben monitorear continuamente estos sistemas y establecer circuitos de retroalimentación para abordar las anomalías rápidamente. Técnicas como los despliegues canarios y las pruebas clandestinas también son eficaces para mitigar los riesgos durante la implementación.

Más allá de la atención al cliente, los procesos de LLM están impulsando avances en la creación de contenido y la automatización del flujo de trabajo.

Las plataformas como prompts.ai permiten a las empresas optimizar las operaciones con flujos de trabajo multimodales que simplifican la integración y la gestión de costes. La generación de contenido es un área en la que los procesos de LLM están causando sensación. Según McKinsey, la IA generativa podría aportar entre 240 y 390 000 millones de dólares al año al sector minorista, con empresas como El Washington Post ya está utilizando los LLM para redactar artículos, sugerir titulares y mostrar información relevante.

Shopify utiliza un sistema basado en LLM para generar notas de versión a partir de cambios en el código, lo que acelera significativamente los procesos de implementación. Las encuestas muestran que los desarrolladores que utilizan herramientas de inteligencia artificial ven un aumento del 55% en la eficiencia de la codificación. Del mismo modo, CLAVE ha implementado su LLM privado, EYQ, para 400 000 empleados, lo que ha aumentado la productividad en un 40%.

Otras aplicaciones notables incluyen AmazonEl uso de LLM para analizar las opiniones a fin de medir la satisfacción de los clientes y el despliegue de LLM por parte de JPMorgan Chase para clasificar documentos como las solicitudes de préstamos y los estados financieros.

«Los LLM no solo generan texto, sino que integran la inteligencia básica en los sistemas empresariales». — Sciforce

También están surgiendo LLM específicos de la industria, como MedGPT para la atención médica y LegalGPT para la ley, que brindan información precisa y reducen las tasas de error. De cara al futuro, los sistemas del futuro procesarán sin problemas el texto, las imágenes, el vídeo y el audio, lo que permitirá realizar análisis más profundos e incluso incorporará herramientas de simulación.

Plataformas como prompts.ai siguen respaldando estos avances con flujos de trabajo flexibles que gestionan todo, desde el procesamiento de texto hasta la creación de prototipos desde bocetos hasta imágenes. Su modelo de precios de pago por uso y el seguimiento de los tokens brindan transparencia en los costos, lo que hace que estas herramientas sean accesibles a medida que las empresas crecen.

Estos ejemplos destacan cómo los procesos de LLM están redefiniendo la forma en que operan las industrias, allanando el camino para una innovación aún mayor.

Los procesos de toma de decisiones de LLM están transformando la forma en que operan las empresas al ofrecer soluciones rápidas y basadas en datos. Por ejemplo, el sistema de inteligencia artificial de JPMorgan gestiona más de 12 000 transacciones por segundo, lo que aumenta la precisión de la detección del fraude en casi un 50%. En el sector de la salud, los LLM pueden procesar la asombrosa cantidad de 200 millones de páginas de datos médicos en menos de tres segundos. Este tipo de velocidad y escala está revolucionando la toma de decisiones en todos los sectores.

Sin embargo, la integración de los LLM no es un paseo por el parque. Es un proceso complejo que abarca múltiples disciplinas. Como explica Pritesh Patel:

«La integración del LLM no es un proceso listo para usar, es un esfuerzo multidisciplinario que abarca la arquitectura, la seguridad, la ética, el diseño de productos y la estrategia empresarial. Si se hacen correctamente, los LLM pueden mejorar drásticamente la experiencia del usuario, reducir los costos y abrir nuevas oportunidades para la innovación».

Esta complejidad significa que las empresas necesitan un enfoque reflexivo y estratégico. Comenzar de a poco es clave: céntrese en los casos de uso que reduzcan los costos de soporte u organicen los datos no estructurados. La incorporación de la retroalimentación de las personas y el seguimiento de métricas, como el tiempo de respuesta, el uso de los tokens y la satisfacción de los usuarios, pueden ayudar a perfeccionar estos sistemas con el tiempo.

El impacto financiero de los oleoductos LLM es difícil de ignorar. El sistema de recomendaciones de Amazon, por ejemplo, genera casi el 35% de sus ventas totales. El mantenimiento predictivo basado en LLM puede reducir el tiempo de inactividad de los equipos hasta en un 50% y prolongar la vida útil de las máquinas entre un 20 y un 40%. AlexanderFish, de 4Degrees, destaca cómo las LLM ahorran tiempo y mejoran la eficiencia:

«Los LLM pueden automatizar la búsqueda de acuerdos, la selección inicial de las presentaciones, la investigación de mercado y de la competencia, el resumen de documentos, la redacción de memorandos de inversión y las tareas de diligencia debida, lo que ahorra a los analistas entre 5 y 10 horas a la semana y permite tomar decisiones más rápidas y basadas en datos».

Plataformas como prompts.ai facilitan a las empresas la adopción de canalizaciones impulsadas por LLM. Sus herramientas, como los flujos de trabajo multimodales, el seguimiento de los tokens para garantizar la transparencia de los costos y los precios de pago por uso, permiten a las empresas experimentar sin tener que realizar grandes inversiones iniciales.

Los canales de toma de decisiones impulsados por LLM brindan un nuevo nivel de velocidad y precisión al procesamiento de datos mediante el análisis de conjuntos de datos masivos en tiempo real. Esta capacidad permite a sectores como el financiero y el sanitario tomar decisiones más rápidas y bien informadas y, al mismo tiempo, reducir los errores humanos.

En el sector financiero, estos sistemas proporcionan información detallada para tareas como la previsión del mercado y la evaluación de riesgos. Mientras tanto, en el sector sanitario, ayudan a la toma de decisiones clínicas al proporcionar recomendaciones respaldadas por datos, lo que conduce a una mejor atención a los pacientes y a una gestión de los recursos más eficiente. Al reducir los sesgos y los errores, los procesos de LLM permiten tomar decisiones más inteligentes y confiables en estos campos críticos.

Cuando las organizaciones adoptan Canalizaciones de toma de decisiones de LLM, con frecuencia se enfrentan a una serie de desafíos. Estos pueden incluir los elevados costos de implementación, la garantía de la precisión y confiabilidad de los resultados, la gestión de los problemas de privacidad de los datos y la solución de problemas técnicos como la escalabilidad y los requisitos de hardware.

Para abordar estos obstáculos, las empresas pueden tomar varias medidas. Pueden trabajar para mejorar el rendimiento de los modelos a fin de reducir los costos, establecer procesos rigurosos de validación y prueba para aumentar la precisión e implementar medidas sólidas de seguridad de los datos para proteger la información confidencial. Además, invertir en una infraestructura escalable y mantener los modelos actualizados garantiza que la cartera siga siendo eficiente y esté alineada con las necesidades cambiantes.

La gestión rápida desempeña un papel clave en el mantenimiento coherencia y claridad al estructurar las instrucciones dentro de los flujos de trabajo de decisión de modelos de lenguaje grande (LLM). Al organizar y ajustar cuidadosamente las indicaciones, minimiza la variabilidad en las respuestas y garantiza que los resultados sean más predecibles y confiables.

Por otro lado, la validación de los resultados añade otro nivel de fiabilidad al evaluar la precisión, seguridad y relevancia del contenido generado. Este paso ayuda a detectar y abordar los errores, la información errónea o el material inapropiado antes de que afecten a los procesos de toma de decisiones.

Cuando se combinan, estas prácticas crean una base sólida de confianza en los sistemas impulsados por LLM, lo que garantiza que los resultados generados sean confiables y estén alineados con las necesidades de los usuarios.