Al evaluar modelos lingüísticos extensos (LLM) en entornos de equipo, a menudo surgen desafíos como definiciones de calidad subjetivas, resultados inconsistentes y costos elevados. Herramientas como Prompts.ai, LangSmith y Weights & Biases (W&B) simplifican este proceso al permitir la colaboración, el control rápido de versiones y la gobernanza. Esto es lo que necesita saber:

Cada plataforma satisface diferentes necesidades, desde equipos pequeños hasta grandes empresas, y ofrece herramientas para optimizar los flujos de trabajo, administrar los costos y mantener el cumplimiento.

Prompts.ai destaca por su enfoque empresarial, mientras que LangSmith y W&B ofrecen flexibilidad y funciones centradas en la experimentación. Elige en función del tamaño, el presupuesto y las prioridades de tu equipo.

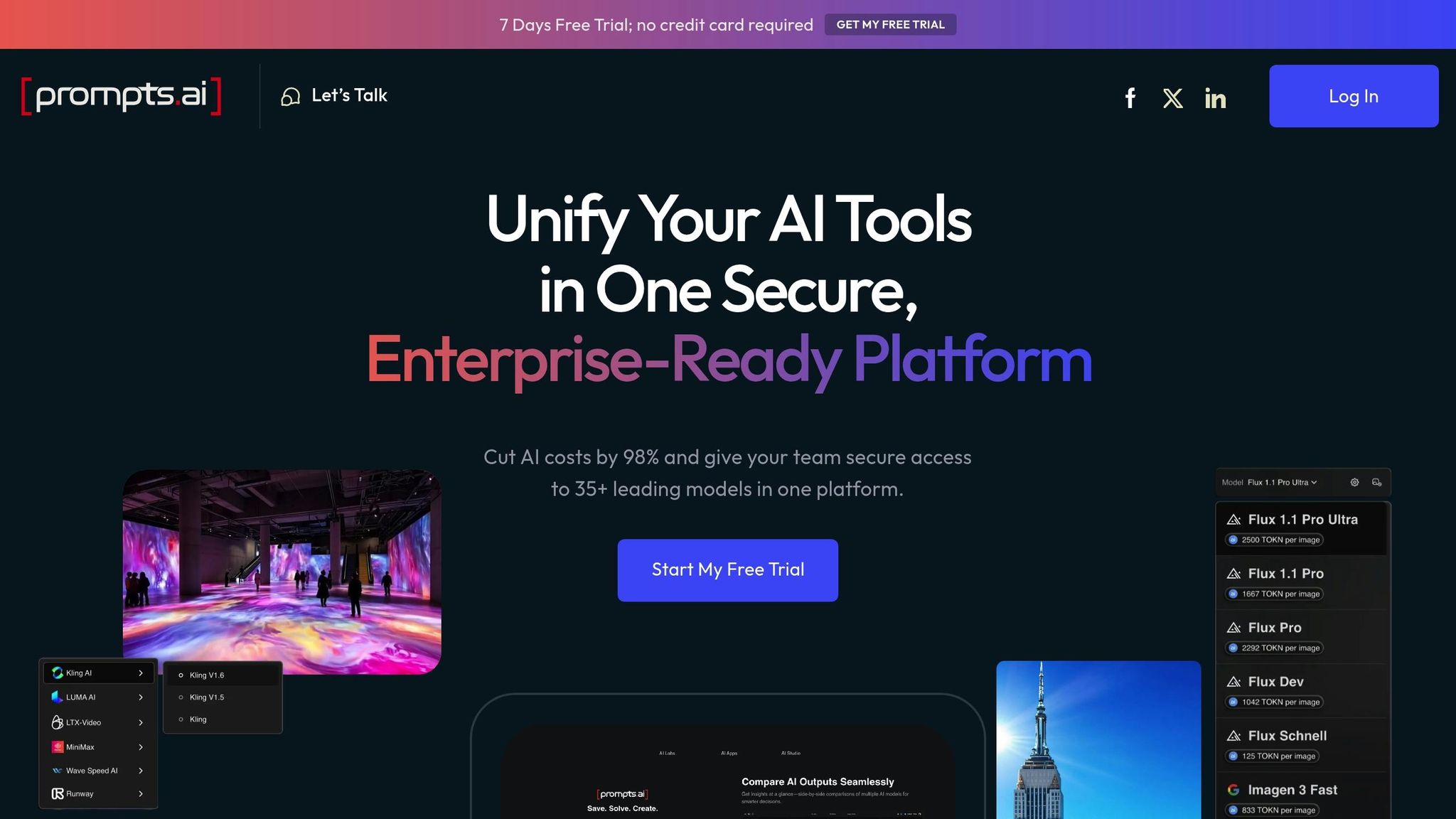

Prompts.ai sirve como potente plataforma de orquestación de IA de nivel empresarial, diseñado para abordar los desafíos a los que se enfrentan los equipos cuando trabajan juntos en las evaluaciones de los resultados del LLM. A diferencia de las soluciones heterogéneas que distribuyen los flujos de trabajo entre varias herramientas, Prompts.ai reúne más de 35 LLM en una única interfaz segura con sólidas funciones de gobierno. Este enfoque simplificado aborda directamente los obstáculos de colaboración que suelen surgir en el desarrollo de la IA.

La plataforma redefine la forma en que los equipos colaboran al permitir desarrollo y evaluación rápidos en tiempo real. Los equipos pueden probar simultáneamente las indicaciones en varios modelos, comparar los resultados al instante y proporcionar comentarios de forma inmediata. Esto elimina las demoras y los problemas de comunicación, creando una conexión perfecta entre los ingenieros que se centran en las métricas técnicas y los expertos en el campo, que priorizan la precisión del contenido.

Prompts.ai también permite a los equipos compartir bibliotecas rápidas en todos los departamentos, garantizando que las solicitudes exitosas no queden aisladas. Este repositorio compartido acelera el desarrollo en toda la organización, mientras que los controles de acceso a nivel de usuario protegen los datos confidenciales y equilibran la colaboración con la seguridad.

El control de versiones es otra piedra angular de Prompts.ai, ya que simplifica la mejora iterativa. El sistema de control visual de versiones de la plataforma rastrea los cambios sin necesidad de conocimientos de codificación. Esto facilita a los miembros del equipo que no tienen conocimientos técnicos contribuir a una evaluación rápida, lo que elimina las barreras tradicionales a la colaboración.

Cada iteración rápida se registra, lo que ofrece a los equipos un historial detallado de cómo evolucionan los resultados con actualizaciones del modelo o ajustes rápidos. Este seguimiento histórico tiene un valor incalculable para volver a versiones anteriores o analizar el impacto de cambios específicos. La capacidad de edite, evalúe e implemente las indicaciones rápidamente asegura un ciclo de desarrollo más rápido en comparación con los métodos convencionales.

Prompts.ai incluye flujos de trabajo de comentarios estructurados para captar las aportaciones del equipo de forma sistemática, evitando las dificultades de una comunicación desorganizada. Con Herramientas de pruebas A/B, los equipos pueden comparar modelos de manera objetiva y evaluar el desempeño, yendo más allá de las opiniones subjetivas que a menudo conducen a desacuerdos.

Estos sistemas de retroalimentación también crean un registro de auditoría de las decisiones, lo cual es fundamental en entornos empresariales con requisitos estrictos de cumplimiento y documentación. Los equipos pueden establecer criterios de evaluación coherentes, alineando las perspectivas de los diferentes roles y escenarios, lo que resuelve uno de los mayores desafíos de la evaluación colaborativa de la LLM.

La plataforma incorpora Herramientas FinOps que rastrean el uso de los tokens y vinculan los costos con los resultados, proporcionando visibilidad en tiempo real del gasto. Esto ayuda a los equipos a gestionar los presupuestos de forma eficaz, incluso durante las evaluaciones de gran volumen, a la vez que mantienen la calidad de sus evaluaciones.

Prompts.ai también ofrece funciones de gobierno sólidas para ayudar a las organizaciones que manejan datos confidenciales. Al mantener un registro de auditoría de todas las interacciones de la IA, la plataforma garantiza el cumplimiento de los requisitos reglamentarios y, al mismo tiempo, permite los flujos de trabajo colaborativos esenciales para un desarrollo y una evaluación rápidos y efectivos.

LangSmith aborda los desafíos de colaboración de manera frontal al ofrecer una plataforma que reúne la observabilidad, la depuración, las pruebas y la supervisión para lograr evaluaciones de equipo fluidas.

Con LangSmith, los equipos pueden supervisar las interacciones de LLM a medida que se producen y gestionar las indicaciones de forma colaborativa. Este espacio de trabajo compartido permite un rápido desarrollo y refinamiento de una manera que fomenta el trabajo en equipo y la eficiencia.

LangSmith combina evaluaciones automatizadas con jueces basados en LLM con comentarios humanos, creando un enfoque equilibrado para la evaluación de la calidad. Este método minimiza los sesgos subjetivos y garantiza una evaluación más precisa de los resultados.

La plataforma rastrea los costos, la latencia y la calidad de los resultados en tiempo real, para atender a las organizaciones con requisitos de gobierno estrictos. Con opciones para implementaciones híbridas y autohospedadas, LangSmith brinda flexibilidad y, al mismo tiempo, mantiene el control. Sus herramientas integradas mejoran las evaluaciones empresariales al ofrecer funciones especializadas de supervisión y gobierno.

Weights & Biases (W&B) simplifica el proceso de evaluación de modelos lingüísticos de gran tamaño (LLM) al combinar funciones como el seguimiento de experimentos, el rápido control de versiones y la recopilación de comentarios. Esta configuración es especialmente beneficiosa para los equipos distribuidos, ya que hace que la experimentación y las pruebas rápidas sean más eficientes.

W&B proporciona un espacio de trabajo compartido donde los miembros del equipo pueden supervisar los experimentos de LLM a medida que se realizan. Gracias a las herramientas de edición en tiempo real y a la comunicación integrada, los equipos pueden realizar pruebas y realizar ajustes de forma rápida y sincronizada. Estas funciones colaborativas se alinean perfectamente con las capacidades de control de versiones de la plataforma, lo que garantiza flujos de trabajo fluidos.

La plataforma utiliza un sistema de etiquetado inteligente (por ejemplo, {feature} - {purpose} - {version}) para gestionar los cambios rápidos, los metadatos relacionados y los resultados. Al integrar las indicaciones directamente con los sistemas de control de versiones, W&B permite flujos de trabajo de CI/CD fluidos y una fácil reversión cuando es necesario.

W&B mejora las evaluaciones de los equipos con sus herramientas de feedback integradas. Combina evaluaciones automatizadas, revisiones por pares y encuestas a los usuarios para recopilar información sobre las solicitudes. Al hacer un seguimiento de los indicadores clave de rendimiento, la plataforma ayuda a refinar las indicaciones para cumplir mejor las expectativas de los usuarios y alinearlas con los objetivos empresariales.

Al comparar plataformas diseñadas para la evaluación en equipo de los resultados de los modelos lingüísticos grandes (LLM), entran en juego varios factores clave. Estos incluyen las herramientas de colaboración, los sistemas de control de versiones, las funciones de gobierno, la rentabilidad y las capacidades de integración. Estos criterios ayudan a los equipos a elegir una solución que se adapte a sus necesidades y objetivos técnicos específicos.

Prompts.ai destaca en entornos en los que el trabajo en equipo en tiempo real es esencial. Funciones como las bibliotecas compartidas, los controles de acceso a nivel de usuario y los flujos de trabajo de comentarios estructurados permiten a varios miembros del equipo probar las instrucciones simultáneamente. Esta configuración garantiza la transparencia en la evolución de los resultados a medida que se ajustan los modelos o las instrucciones, lo que crea una base sólida para mejorar la productividad mediante un control de versiones, un gobierno y una gestión de costes eficaces.

Un control de versiones eficaz es fundamental para mejorar la precisión inmediata, ya que los equipos informan de una mejora de hasta un 20% en los resultados mediante flujos de trabajo estructurados. Prompts.ai simplifica este proceso al hacer un seguimiento de los cambios en los resultados a lo largo del tiempo y utilizar un sistema claro de control de versiones principales, secundarias y de parches para gestionar las actualizaciones. Este enfoque garantiza que los equipos puedan adaptar y refinar fácilmente sus flujos de trabajo sin perder la precisión y la coherencia.

A medida que crece la adopción de la IA (se espera que llegue al 78% de las organizaciones en 2025, en comparación con el 55% en 2023), la gobernanza adquiere cada vez más importancia. Sin embargo, solo el 13% de las organizaciones cuentan con especialistas dedicados al cumplimiento de la IA. Prompts.ai aborda esta brecha con controles de acceso de nivel empresarial y registros de auditoría detallados, lo que garantiza tanto la seguridad como el cumplimiento de las normas reglamentarias.

En la siguiente tabla se destacan las principales características que hacen de Prompts.ai un sólido competidor en estas áreas:

Los equipos suelen dedicar más del 85% de sus horas semanales a tareas colaborativas. Al consolidar estos flujos de trabajo, Prompts.ai no solo mejora la productividad, sino que también ofrece una importante rentabilidad, lo que lo convierte en una opción atractiva para los equipos que se preocupan por su presupuesto.

Prompts.ai simplifica la complejidad de administrar múltiples herramientas de inteligencia artificial al ofrecer una interfaz unificada que se integra con más de 35 modelos de lenguaje de gran tamaño líderes. Este enfoque simplificado reduce los desafíos de coordinación y aumenta la eficiencia del equipo, lo que permite a las organizaciones centrarse en lograr sus objetivos de inteligencia artificial.

La elección de la plataforma depende en última instancia de las necesidades únicas del equipo, sus requisitos técnicos y la preparación general de la organización para la integración de la IA. Con su énfasis en la colaboración de nivel empresarial, un control de versiones sólido, una gobernanza sólida y una integración perfecta, Prompts.ai proporciona una solución integral para los equipos que buscan mejorar sus flujos de trabajo de inteligencia artificial. Sus funciones están diseñadas para mejorar la productividad y garantizar resultados de alta calidad, lo que la convierte en una opción fiable para las organizaciones que desean optimizar sus procesos de IA.

Elegir la plataforma adecuada es crucial, ya que se prevé que el mercado de la IA empresarial alcance los 130 000 millones de dólares en 2030. A continuación, se muestran estrategias adaptadas a los diferentes tamaños y prioridades de los equipos, que muestran cómo Prompts.ai puede optimizar las operaciones y, al mismo tiempo, garantizar el cumplimiento.

Para equipos pequeños y medianos (de 5 a 50 miembros), Prompts.ai logra un equilibrio perfecto entre funcionalidad y presupuesto. Estos equipos suelen operar con recursos limitados, pero aun así necesitan soluciones escalables. Con servicio gratuito de pago por uso Créditos TOKN, los equipos pueden experimentar con herramientas de IA sin compromisos iniciales. Además, la capacidad de la plataforma para reducir los costos de inteligencia artificial hasta en un 98% la convierte en una excelente opción para acceder a más de 35 modelos lingüísticos líderes sin dejar de ser rentable.

Para equipos de grandes empresas (más de 50 miembros), los planes Core, Pro y Elite ofrecen funciones avanzadas de gobierno y seguridad. Dado que el 78% de las empresas utilizan ahora la IA en al menos una función empresarial, estos planes abordan la necesidad de flujos de trabajo estructurados y registros de auditoría detallados. Estas funciones garantizan una colaboración fluida entre los departamentos, lo que las hace indispensables para las organizaciones más grandes.

Organizaciones centradas en mejora continua encontrará valor en las herramientas de comentarios estructurados de Prompts.ai. Las investigaciones destacan que la incorporación de una retroalimentación sistemática puede generar ganancias de rendimiento espectaculares: una empresa de servicios financieros mejoró las tasas de precisión del 60 al 100%. Prompts.ai respalda este proceso con flujos de trabajo de retroalimentación integrados, que permiten a los equipos monitorear los resultados, identificar los problemas recurrentes y refinar los resultados a lo largo del tiempo. Esto se basa en las funciones de control y control de versiones de la plataforma, y ofrece una base sólida para la mejora iterativa.

Cuándo el presupuesto y los recursos son limitados, las empresas deben alinear su enfoque con requisitos específicos, como el cumplimiento, las necesidades técnicas y las restricciones financieras. La interfaz unificada de Prompts.ai, que administra más de 35 LLM, simplifica este proceso y permite a las organizaciones tomar decisiones informadas.

Para aquellos nuevo en la IA, el plan personal ofrece un punto de partida asequible con rutas de actualización claras a funciones de nivel empresarial. Los programas prácticos de incorporación y capacitación ayudan a los equipos a desarrollar rápidamente su experiencia interna, mientras que una próspera comunidad de ingenieros rápidos ofrece apoyo continuo y conocimientos compartidos.

En última instancia, es esencial alinear las capacidades de la plataforma con los flujos de trabajo, los objetivos de crecimiento y los requisitos de cumplimiento de su equipo. Dado que se espera que el mercado mundial de la PNL alcance los 61 000 millones de dólares en 2030, adoptar hoy una plataforma de evaluación colaborativa como Prompts.ai puede posicionar a su organización para lograr el éxito a largo plazo en el cambiante panorama de la IA.

Prompts.ai pone un gran énfasis en seguridad de datos y cumplimiento, integrando funciones sólidas como el cifrado, la anonimización y la redacción de datos en sus flujos de trabajo. Estas herramientas protegen la información confidencial y, al mismo tiempo, permiten a los equipos colaborar sin esfuerzo en tiempo real.

La plataforma está diseñada para cumplir con estándares rigurosos, que incluyen SOC 2 y GDPR, garantizando una protección de datos y privacidad de primer nivel. También proporciona pistas de auditoría y seguridad para los terminales, lo que permite supervisar y proteger los datos de forma continua durante las sesiones de colaboración. Este enfoque ayuda a los equipos a mantener el cumplimiento de las normativas del sector sin sacrificar la productividad.

Prompts.ai dota a los equipos de herramientas diseñadas para reducir los costos cuando se utilizan modelos lingüísticos de gran tamaño. Es análisis integrados permiten a los usuarios realizar un seguimiento de cómo se utilizan las indicaciones, evaluar la calidad de las respuestas del modelo y supervisar las métricas de rendimiento, lo que facilita la asignación inteligente de los recursos y las pruebas de forma más eficaz.

A través de funciones como control de versiones y los flujos de trabajo de pruebas estructurados, los equipos pueden ajustar las instrucciones para descubrir las opciones más eficaces, minimizando las ejecuciones de modelos redundantes y ahorrando costos. Al simplificar la administración rápida y aumentar la eficiencia, Prompts.ai ayuda a reducir los gastos generales de inferencia sin comprometer la calidad.

Los equipos pequeños y medianos pueden aumentar su productividad con Prompts.ai al reducir la molestia de administrar las solicitudes y automatizar las tareas tediosas. Esto significa dedicar menos tiempo al trabajo manual y dedicar más tiempo a mejorar los resultados y crear contenido significativo Soluciones impulsadas por IA.

Las funciones clave, como las revisiones rápidas colaborativas, las bibliotecas compartidas y los flujos de trabajo de comentarios organizados, permiten a los equipos trabajar de forma más fluida sin necesidad de grandes presupuestos ni conocimientos técnicos avanzados. Al simplificar los procesos y fomentar el trabajo en equipo, Prompts.ai ayuda a los equipos a ofrecer resultados de mayor calidad a la vez que ahorran tiempo y dinero.