Débloquez l'efficacité de l'IA avec les bons outils

L'ingénierie rapide a changé la donne en matière de flux de travail d'IA, en aidant les entreprises à obtenir des résultats cohérents et rentables. Qu'il s'agisse de gérer plusieurs modèles d'IA ou d'optimiser les instructions pour obtenir de meilleurs résultats, les plateformes actuelles proposent des solutions personnalisées aux entreprises, aux développeurs et aux petites équipes. Voici un bref aperçu de huit outils remarquables et de leurs avantages uniques :

Chaque plateforme cible des besoins spécifiques, de la gouvernance d'entreprise aux outils centrés sur les développeurs. Le choix de la bonne solution dépend de vos objectifs, de la taille de votre équipe et de votre expertise technique. Qu'il s'agisse de faire évoluer les opérations d'IA ou d'affiner les résultats, ces outils peuvent vous aider à gagner du temps, à réduire les coûts et à améliorer les résultats.

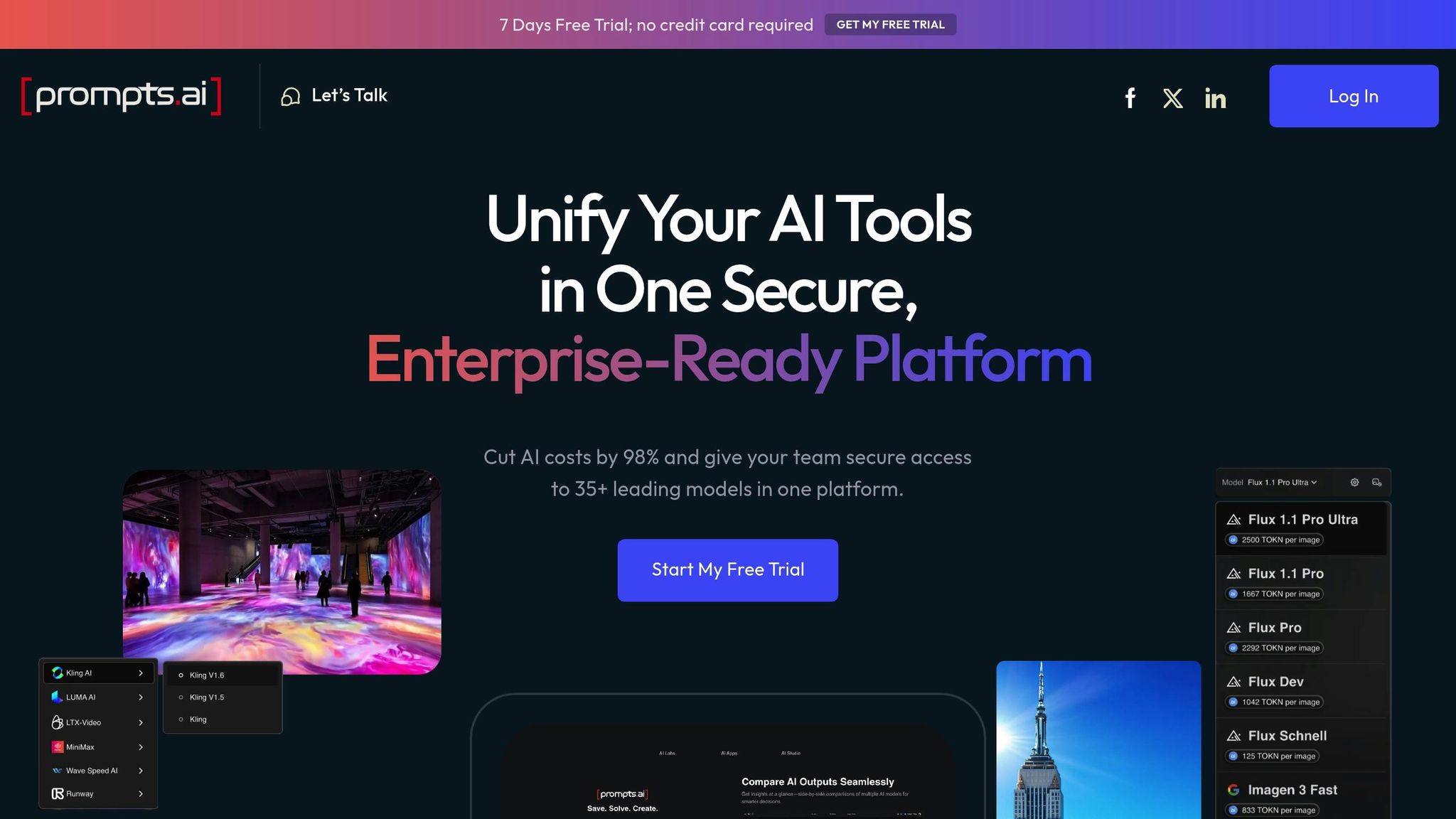

Prompts.ai constitue une plate-forme complète pour la gestion de l'IA en entreprise, réunissant plus de 35 grands modèles de langage de premier plan, notamment GPT-4, Claude, Lama, et Gémeaux, en une seule interface fluide. Cette consolidation élimine les tracas liés à la gestion de plusieurs abonnements tout en garantissant l'accès aux dernières avancées en matière de technologie d'IA.

Grâce à son tableau de bord intuitif, les équipes peuvent facilement choisir des modèles, tester les instructions et comparer les résultats côte à côte, le tout sans avoir à passer d'un outil à l'autre.

Prompts.ai est doté d'une fonction intégrée couche FinOps qui fournit un suivi détaillé de l'utilisation des jetons, offrant des informations en temps réel sur les dépenses par modèle, utilisateur, projet et période. Cette transparence aide les organisations à identifier les modèles les plus rentables pour des tâches spécifiques et à optimiser leurs budgets d'IA. La plateforme système de crédit TOKN à paiement à l'utilisation garantit que les coûts sont directement liés à l'utilisation réelle, ce qui peut permettre de réduire les dépenses jusqu'à 98 % par rapport au maintien de modèles d'abonnements individuels. Combinée à ses capacités d'automatisation, cette visibilité des coûts rend la gestion des flux de travail d'IA à la fois efficace et économique.

La plateforme transforme des expériences d'IA ponctuelles en flux de travail structurés et évolutifs. Les équipes peuvent concevoir des modèles standardisés, configurer des flux de travail d'approbation et appliquer des contrôles qualité pour garantir des résultats cohérents et fiables. En réduisant les tâches manuelles, Prompts.ai permet aux équipes de se concentrer sur des activités à plus forte valeur ajoutée tout en préservant la qualité des résultats.

Prompts.ai donne la priorité à la protection des données et à la conformité réglementaire, conformément aux normes industrielles les plus strictes. Il applique les politiques de gouvernance et garantit un environnement sécurisé pour toutes les interactions avec l'IA, ce qui en fait un choix fiable pour les entreprises qui traitent des informations sensibles.

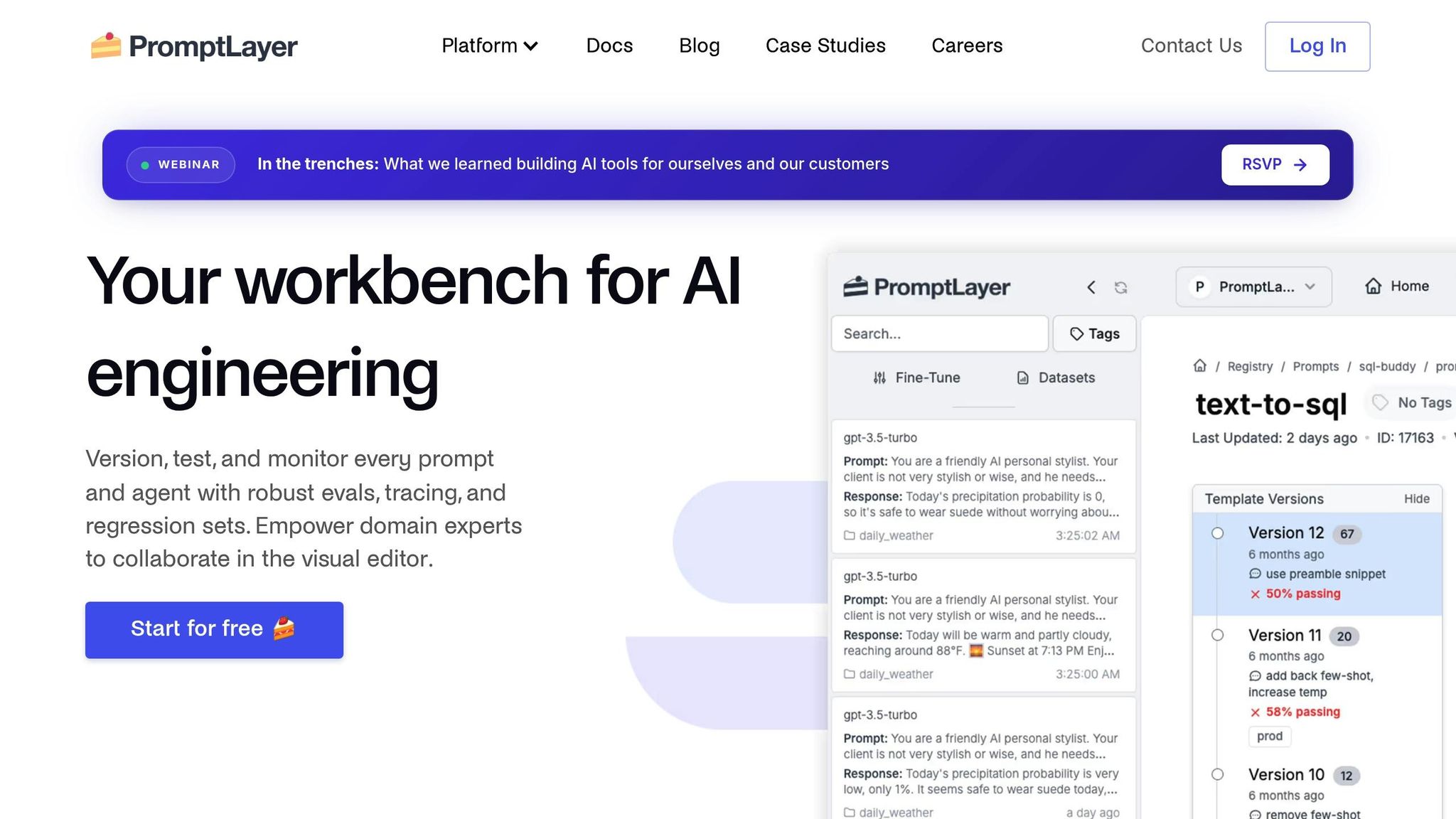

PromptLayer agit comme un pont entre vos applications et les modèles d'IA, capturant chaque demande et réponse d'API pour fournir une surveillance et une optimisation approfondies. En interceptant les appels d'API, il enregistre les interactions avec de grands modèles de langage, ainsi que les métadonnées clés et les indicateurs de performance. Cela crée une piste d'audit détaillée, ce qui facilite l'analyse des modèles d'utilisation et l'amélioration des performances rapides.

Le système de gestion rapide de la plateforme permet aux utilisateurs de tester et de comparer différentes variations d'invites grâce à des tests A/B. Cette approche permet d'affiner l'efficacité des réponses, ce qui peut réduire le nombre de requêtes nécessaires pour obtenir les résultats souhaités.

PromptLayer propose des analyses détaillées et un suivi des coûts, donnant aux utilisateurs une vision claire de leurs dépenses liées à l'IA. Il surveille des indicateurs de haut niveau, tels que les coûts d'utilisation et la latence, et fournit un tableau de bord unifié pour le suivi en temps réel de l'activité des API. La tarification commence à 35,00$ par utilisateur et par mois, avec une version gratuite et une période d'essai disponibles. Ces informations permettent d'identifier les opportunités de réduction des coûts et d'améliorer les flux de travail.

Outre le suivi des coûts, PromptLayer utilise ses fonctionnalités de journalisation complètes pour améliorer l'automatisation des flux de travail. En analysant les métadonnées enregistrées, la plateforme identifie les domaines à optimiser, ce qui permet aux équipes de rationaliser les processus d'ingénierie rapides. Cela garantit aux organisations une compréhension claire de la manière dont l'IA est utilisée dans leurs opérations.

PromptPerfect est conçu pour simplifier les flux de travail de l'IA en automatisant l'optimisation rapide et en garantissant une compatibilité fluide entre les différents modèles. Ses algorithmes pilotés par l'IA affinent les instructions pour les modèles de texte et d'image, améliorant ainsi la qualité des sorties sans intervention manuelle. La plateforme a obtenu une note globale impressionnante de 4,5/5, obtenant les meilleures notes en termes d'accessibilité, de compatibilité et de facilité d'utilisation.

À la base, PromptPerfect donne la priorité à l'optimisation automatisée par rapport aux ajustements manuels, ce qui rend la gestion rapide plus efficace. Il affine automatiquement les instructions existantes et fournit des comparaisons côte à côte avec les versions d'origine. Une caractéristique remarquable est sa capacité à rétroconcevoir les instructions : les utilisateurs peuvent télécharger des images pour améliorer les flux de travail liés au contenu visuel. En outre, il prend en charge les entrées multilingues, ce qui le rend adapté à une variété de besoins en matière de contenu.

PromptPerfect se distingue par sa compatibilité sur différentes plateformes. Son extension Chrome s'intègre à 10 des principales plateformes d'IA, notamment ChatGPT, Gemini, Claude, Copilot, DeepSeek, Sora, Grok, NotebookLM, AI Studio et Perplexity. Des fonctionnalités telles que le bouton « Parfait » en un clic, une barre latérale unifiée pour enregistrer les principales instructions et l'accès à l'API garantissent une intégration et une facilité d'utilisation fluides.

PromptPerfect propose des options de tarification claires et flexibles. Les forfaits gratuits incluent des limites quotidiennes, tandis que les forfaits pro sont disponibles à 9,50$ par mois ou 95$ par an, avec un essai de 3 jours inclus. Pour les utilisateurs ayant des besoins plus élevés, un forfait de milieu de gamme prend en charge environ 500 demandes quotidiennes à 19,99 $/mois, tandis que le niveau Pro Max prend en charge jusqu'à 1 500 demandes quotidiennes à 99,99 $/mois. La tarification d'entreprise est également disponible pour les besoins à plus grande échelle. Ces niveaux de tarification reflètent l'accent mis par PromptPerfect sur la fourniture d'une optimisation rapide accessible et de haute qualité.

LangSmith est une plateforme polyvalente axée sur les API, conçue pour fonctionner de manière fluide sur différents frameworks, ce qui en fait un ajout précieux aux configurations DevOps existantes. Il améliore les capacités d'ingénierie rapide pour les développeurs travaillant avec LangChain, ainsi que pour ceux qui utilisent d'autres frameworks ou des solutions personnalisées. Explorons comment les fonctionnalités de LangSmith favorisent l'interopérabilité et améliorent la rapidité de l'ingénierie.

L'interopérabilité est la pierre angulaire de l'efficacité des flux de travail d'IA, et LangSmith y parvient en respectant les normes industrielles largement reconnues. La conformité de la plateforme à OpenTelemetry (OTEL) garantit que ses fonctionnalités sont accessibles via plusieurs langages de programmation et frameworks. En prenant en charge la journalisation des traces via des clients OTEL standard, LangSmith permet aux développeurs d'utiliser le traçage, les évaluations et des outils d'ingénierie rapides, même lorsque leurs applications ne sont pas conçues en Python ou TypeScript.

LangSmith s'intègre également profondément à LangChain, offrant un environnement cohérent pour gérer plusieurs modèles et optimiser les performances au sein de cet écosystème. Cependant, certains utilisateurs ont noté que le fort alignement de la plateforme avec LangChain pourrait poser des défis aux équipes qui s'appuient sur des alternatives telles que Haystack ou des solutions personnalisées.

Langfuse se distingue comme une puissante plateforme open source conçue pour gérer et surveiller les applications LLM (Large Language Model). En mettant l'accent sur la flexibilité et le contrôle des développeurs, Langfuse fournit une excellente solution aux équipes qui recherchent une observabilité détaillée et une gestion rapide. Sa popularité est évidente, avec plus de 11,66 millions d'installations de SDK par mois et 15 931 étoiles sur GitHub. Cette plateforme pilotée par les événements et indépendante des modèles permet aux entreprises de conserver le contrôle total de leurs données et de leur infrastructure.

« Langfuse est une plateforme d'ingénierie LLM open source qui aide les équipes à déboguer, analyser et itérer de manière collaborative leurs applications LLM. Toutes les fonctionnalités de la plateforme sont intégrées de manière native pour accélérer le flux de développement. » - Présentation de Langfuse

Langfuse est conçu pour prendre en charge un large éventail d'écosystèmes d'IA grâce à son architecture indépendante des frameworks. Il s'intègre parfaitement aux bibliothèques LLM populaires telles que IA ouverte SDK, LangChain, LangGraph, Llama-Index, CrewAI, LiteLM, Haystack, Instructor, Semantic Kernel et dSpy. En outre, il travaille avec les principaux fournisseurs de modèles tels que IA ouverte, Amazon Bedrock, Google Vertex/Gemini et Ollama. Par exemple, en 2025, Samsara a intégré Langfuse à son infrastructure LLM pour surveiller l'assistant Samsara, garantissant ainsi des performances optimales dans les applications d'IA textuelles et multimodales.

Langfuse simplifie l'automatisation des flux de travail grâce à son API publique et à ses SDK, disponibles pour Python, Javascript/TypeScript et Java. Ces outils permettent aux développeurs d'automatiser les processus, de créer des tableaux de bord personnalisés et d'intégrer facilement Langfuse dans leurs pipelines d'applications.

La plateforme prend également en charge OpenTelemetry pour les données de trace, garantissant ainsi la compatibilité avec les normes d'observabilité du secteur. Il améliore la gestion rapide grâce à des webhooks et à un n8n Node, tandis que son API publique peut gérer des flux de travail d'évaluation complets, y compris la gestion des files d'annotations. Ces fonctionnalités font de Langfuse un outil précieux pour rationaliser la gestion rapide et optimiser les flux de développement.

En étant capable de traiter des dizaines de milliers d'événements par minute et de fournir des réponses à faible latence (50 à 100 ms), Langfuse garantit une gestion efficace des données. Sa nature open source permet aux organisations de déployer et de personnaliser la plateforme sans être liées à un fournisseur spécifique. Cette flexibilité est encore soulignée par sa 5,93 millions de commandes Docker. En outre, les utilisateurs peuvent gérer les exportations de données manuellement ou par le biais d'une automatisation planifiée, offrant ainsi une visibilité claire sur les coûts et les opérations.

Langfuse met l'accent sur la sécurité et la conformité, ce qui en fait un choix fiable pour les utilisateurs professionnels. Des entreprises comme Merck Group et Twilio font confiance à Langfuse pour une observabilité avancée et une gestion collaborative des rapides. Son architecture open source donne aux équipes un contrôle total sur les configurations des données, de l'infrastructure et de la journalisation. La conception pilotée par les événements permet aux utilisateurs de définir des schémas de journalisation et des structures d'événements personnalisés, garantissant ainsi la conformité et une gouvernance des données robuste. Ce niveau de contrôle rend Langfuse particulièrement attrayant pour les ingénieurs de plateformes et les entreprises qui accordent la priorité à des normes de sécurité et de gouvernance strictes.

Haystack est un framework d'IA open source conçu pour créer des applications prêtes pour la production avec une gestion avancée des commandes. Il comprend des composants et des pipelines adaptables qui répondent à de nombreux besoins, qu'il s'agisse d'applications RAG simples ou de flux de travail complexes pilotés par des agents.

Haystack se distingue par sa capacité à s'intégrer parfaitement à divers modèles et plateformes. Il prend en charge les connexions avec les meilleurs fournisseurs de LLM tels que OpenAI, Anthropiqueet Mistral, ainsi que des bases de données vectorielles telles que Weaviate et Pinecone. Cela garantit que les utilisateurs peuvent fonctionner sans être liés à un seul fournisseur. Comme le souligne un aperçu :

« Grâce à nos partenariats avec les principaux fournisseurs de LLM, de bases de données vectorielles et d'outils d'IA tels qu'OpenAI, Anthropic, Mistral, Weaviate, Pinecone et bien d'autres encore. »

Le framework comprend également une interface d'appel de fonctions standardisée pour ses générateurs LLM. Il prend en charge les fonctionnalités d'IA multimodales, permettant des tâches telles que la génération d'images, le sous-titrage d'images et la transcription audio. En outre, Haystack permet aux utilisateurs de créer des composants personnalisés, des magasins de documents et des intégrations de fournisseurs de modèles pour répondre à des besoins spécifiques.

Haystack simplifie le développement de l'IA conversationnelle grâce à son interface de discussion standardisée. Les utilisateurs peuvent améliorer ses fonctionnalités en incorporant des composants personnalisés et des magasins de documents, en adaptant le cadre pour répondre à des exigences d'automatisation uniques. Ces fonctionnalités en font un outil précieux pour optimiser les flux de production.

Pour répondre aux problèmes de sécurité et de conformité, Haystack inclut des intégrations de journalisation et de surveillance, garantissant ainsi la transparence des audits, ce qui est particulièrement crucial pour les organisations soumises à des exigences réglementaires strictes. Pour une assistance supplémentaire, Haystack Enterprise propose des fonctionnalités de sécurité améliorées, une assistance d'experts, des modèles de pipeline et des guides de déploiement pour les environnements cloud et sur site, aidant ainsi les organisations à maintenir leur conformité en toute simplicité.

Lilypad est une plateforme décentralisée et sans serveur conçue pour fournir un accès fluide aux modèles d'IA. Construit sur Bacalhau, il fournit aux développeurs les outils nécessaires pour créer des modules personnalisés et les intégrer sans effort dans divers flux de travail.

Lilypad s'intègre à n8n, permettant aux développeurs d'automatiser les flux de travail qui combinent des contributions humaines, du contenu généré par l'IA et des actions sur plusieurs plateformes. Il propose des terminaux compatibles OpenAI qui fournissent des fonctionnalités d'IA gratuites et prennent en charge diverses méthodes d'exécution, telles que la CLI, les API et les contrats intelligents, permettant aux développeurs de lancer directement des tâches de calcul vérifiables.

Le intégration n8n ouvre de nombreuses possibilités d'automatisation, notamment :

Lilypad excelle également dans la recherche et l'enrichissement de données provenant de plateformes telles que Notion, Airtable et Google Sheets. Il automatise la publication du contenu généré, des résumés ou des images modifiées sur des plateformes telles que Twitter, Discord et Slack, tout en suivant la progression du flux de travail. Ces fonctionnalités d'automatisation avancées ouvrent la voie à la forte interopérabilité des modèles de la plateforme.

Lilypad, construit sur Bacalhau, prend en charge l'orchestration de pipelines d'IA complexes. Son intégration avec Apache Airflow Bacalhau garantit un transfert fluide des sorties entre les étapes de traitement. La plate-forme comporte également une couche d'abstraction qui combine un calcul décentralisé hors chaîne avec des garanties en chaîne, offrant à la fois fiabilité et flexibilité.

Les développeurs peuvent étendre les fonctionnalités de Lilypad en créant des modules personnalisés, grâce à son framework ouvert. Des outils tels que Extension VS Code Helper et Cadre Farcaster simplifiez davantage le processus de prototypage, d'automatisation et de déploiement des tâches d'IA. Cette combinaison de modularité, d'outils conviviaux pour les développeurs et d'infrastructure robuste fait de Lilypad un choix puissant pour les flux de travail pilotés par l'IA.

Weave fait passer l'ingénierie rapide à un niveau supérieur en introduisant des outils de suivi et d'évaluation des expériences. Conçue par Weights & Biases, cette plateforme aide les équipes à surveiller, analyser et affiner systématiquement leurs applications d'IA grâce à des expériences structurées et à un suivi des performances.

Weave simplifie le processus de suivi et d'évaluation des interactions avec les grands modèles linguistiques (LLM). Il enregistre automatiquement les traces détaillées des appels LLM, offrant une vision claire du comportement du modèle sans nécessiter de modifications de code importantes. Les équipes peuvent expérimenter différentes instructions, modèles et ensembles de données, en utilisant le framework de Weave pour mesurer les performances par rapport à des benchmarks et à des métriques personnalisés. Cette approche structurée permet d'identifier plus facilement les instructions les plus efficaces et d'optimiser les résultats.

Grâce à une intégration fluide dans les principaux frameworks et outils d'IA, Weave prend en charge les applications créées à l'aide d'OpenAI, d'Anthropic, de LangChain et d'autres plateformes de premier plan. Son SDK léger, compatible avec plusieurs langages de programmation, permet aux équipes d'intégrer facilement le suivi et l'évaluation à leurs flux de travail. Cette adaptabilité permet d'améliorer l'ingénierie rapide sans perturber les processus de développement existants.

Weave simplifie le processus d'ingénierie rapide en automatisant la collecte de données et en générant des rapports comparatifs pour différentes expériences. Les équipes peuvent établir des pipelines d'évaluation automatisés pour suivre en permanence les performances rapides à mesure que les modèles et les ensembles de données évoluent. Le tableau de bord de la plateforme fournit des informations en temps réel sur le comportement des modèles, permettant des itérations et des améliorations plus rapides sur la base de commentaires basés sur des données plutôt que de se fier uniquement à des tests manuels.

Après avoir exploré les évaluations détaillées ci-dessus, analysons les avantages et les inconvénients de ces solutions. En évaluant ces compromis, les organisations peuvent identifier la plateforme qui correspond à leurs besoins et à leurs budgets spécifiques. Chaque solution d'ingénierie rapide possède ses propres forces et limites, ce qui la rend adaptée à différents cas d'utilisation et objectifs opérationnels.

Plateformes centrées sur l'entreprise, tels que Prompts.ai, brillent dans des environnements où la gouvernance, le contrôle des coûts et l'accès à divers modèles sont essentiels. Avec plus de 35 modèles linguistiques de pointe disponibles via une interface unifiée, ces plateformes réduisent la prolifération des outils tout en offrant des mesures de sécurité robustes. Cependant, leur nature globale peut submerger les petites équipes qui n'ont besoin que d'une optimisation rapide de base.

Outils centrés sur les développeurs, comme LangSmith et Langfuse, s'adressent aux équipes techniques qui développent des applications d'IA complexes. Ces plateformes proposent des outils de débogage avancés, des analyses de performances détaillées et des options d'intégration flexibles, ce qui en fait les préférées des équipes d'ingénierie. D'un autre côté, leur courbe d'apprentissage abrupte et leurs exigences techniques peuvent les rendre moins accessibles aux utilisateurs non techniques.

Plateformes d'optimisation spécialisées tels que PromptPerfect se concentrent exclusivement sur l'amélioration de la qualité rapide à l'aide de tests et d'affinements automatisés. Bien qu'ils excellent dans ce créneau, leur champ d'application restreint peut ne pas répondre aux besoins des équipes nécessitant une orchestration plus large de l'IA ou des flux de travail multimodèles.

Solutions orientées vers la recherche, notamment Haystack et Weave, sont conçus pour l'expérimentation et la recherche systématique en matière d'ingénierie rapide. Ces plateformes sont idéales pour les milieux universitaires et de R&D, car elles permettent un suivi détaillé des expériences et une reproductibilité. Cependant, leur concentration sur la recherche peut les rendre peu pratiques pour une utilisation en production, où des flux de travail rationalisés et des résultats immédiats sont essentiels.

Structures de coûts varient considérablement. Les modèles d'abonnement sont idéaux pour les équipes dont l'utilisation est régulière, mais ils peuvent devenir coûteux à mesure que l'utilisation augmente. Les plateformes dotées de modèles de paiement à l'utilisation, comme les crédits TOKN de Prompts.ai, offrent de la flexibilité pour faire face aux fluctuations des demandes.

Facilité de déploiement compte également. Des SDK légers et une prise en charge étendue des frameworks peuvent simplifier la mise en œuvre, tandis que les configurations plus complexes offrent souvent plus de puissance et de flexibilité une fois entièrement configurées.

Taille de l'équipe et expertise jouent un rôle crucial dans l'adéquation de la plateforme. Les grandes entreprises bénéficient souvent de plateformes dotées de fonctionnalités de gouvernance complètes et d'un accès multimodèle. Les petites équipes, en revanche, peuvent donner la priorité à des outils rationalisés qui réduisent les frais administratifs. De même, les équipes techniques peuvent être attirées par les outils avancés de débogage et d'analyse, tandis que les utilisateurs professionnels privilégient souvent les interfaces intuitives sans code.

Évolutivité est un autre facteur critique. Certaines plateformes s'adaptent parfaitement à la croissance, tandis que d'autres peuvent nécessiter des ajustements coûteux à mesure que la demande augmente. Les organisations doivent non seulement évaluer leurs besoins actuels, mais également prendre en compte leur trajectoire de croissance à long terme lorsqu'elles choisissent une solution d'ingénierie rapide.

Le choix de la bonne solution d'ingénierie rapide commence par une compréhension claire des besoins uniques, des capacités techniques et des aspirations futures de votre équipe. Plutôt que de rechercher une plateforme universelle, l'accent devrait être mis sur la recherche de la meilleure solution pour vos opérations actuelles et vos objectifs à long terme.

Pour les équipes d'entreprise, les plateformes combinant fonctionnalités étendues et rentabilité sont essentielles. Prompts.ai donne accès à plus de 35 modèles linguistiques via une interface unique et unifiée. C'est Contrôles FinOps peut réduire les coûts liés à l'IA jusqu'à 98 %, tandis que le paiement à l'utilisation Système de crédit TOKN élimine les frais d'abonnement récurrents, offrant une gestion prévisible des coûts, même en période de fluctuation de l'utilisation de l'IA.

Les équipes de développement travaillant sur des applications d'IA complexes ont besoin de solutions dotées d'outils de débogage avancés et d'analyses de performances granulaires. Bien que plusieurs plateformes proposent ces fonctionnalités, le processus d'intégration peut s'avérer complexe. Trouver le juste équilibre entre sophistication technique et facilité de mise en œuvre est crucial pour ces équipes.

Pour les petites équipes, la simplicité et la convivialité sont souvent les priorités absolues. Cependant, si des plateformes rationalisées peuvent répondre à des besoins immédiats, il est tout aussi important d'évaluer si la solution peut s'adapter aux demandes croissantes en matière d'IA.

La structure des coûts joue également un rôle central dans la prise de décisions. Les modèles d'abonnement fournissent des dépenses prévisibles mais peuvent avoir du mal à évoluer efficacement. D'autre part, les modèles de paiement à l'utilisation offrent une plus grande flexibilité mais nécessitent une surveillance attentive pour éviter des coûts imprévus. Les organisations doivent évaluer attentivement leur utilisation prévue de l'IA au cours des 12 à 18 prochains mois afin de prendre des décisions financières éclairées.

Les considérations d'évolutivité vont au-delà de la taille de l'équipe et devraient inclure la croissance prévue, les nouveaux cas d'utilisation et les éventuelles modifications réglementaires. La plateforme idéale devrait intégrer de manière fluide de nouveaux modèles, s'adapter aux flux de travail existants et respecter les normes de gouvernance à mesure que l'adoption de l'IA se développe dans l'ensemble de l'organisation.

Alors que le domaine de l'ingénierie rapide continue d'évoluer, il est essentiel de sélectionner une solution bénéficiant d'un solide soutien communautaire, de mises à jour régulières et de capacités d'intégration flexibles. Le bon investissement aujourd'hui améliore non seulement la productivité immédiate, mais permet également à votre organisation de réussir durablement dans un monde de plus en plus piloté par l'IA.

Une ingénierie rapide permet aux entreprises de réduire leurs coûts en affiner l'utilisation des jetons, ce qui réduit les dépenses liées aux appels d'API et à la puissance de calcul. L'élaboration d'instructions bien structurées et efficaces permet d'éviter les itérations inutiles, ce qui permet de réduire les coûts opérationnels et de simplifier les processus.

L'utilisation de stratégies rapides modulaires et réutilisables simplifie davantage les flux de travail, en fournissant des résultats cohérents et de haute qualité tout en minimisant les essais et les erreurs. Cette approche permet non seulement de réduire les dépenses, mais également d'augmenter le retour sur investissement (ROI) des systèmes d'IA, les rendant ainsi plus pratiques et plus efficaces pour les opérations à long terme.

Lorsque vous choisissez un outil d'ingénierie rapide, petites équipes devrait se concentrer sur des outils faciles à utiliser, rentables et simples à configurer. Ces équipes travaillent souvent avec des ressources limitées et ont besoin de solutions capables de s'adapter rapidement à leurs flux de travail rapides sans complexité inutile.

Pour grandes entreprises, les priorités se portent désormais sur l'évolutivité et les fonctionnalités avancées. Des fonctionnalités telles que la gestion centralisée, le contrôle des versions et des outils de collaboration améliorés sont cruciales. Les entreprises ont également besoin de solutions qui s'intègrent parfaitement à leurs systèmes existants et respectent les politiques organisationnelles, tout en gérant des flux de travail plus complexes.

Le meilleur choix dépendra de la taille, des objectifs et des exigences opérationnelles spécifiques de l'équipe, afin de garantir que l'outil soutient ses objectifs de manière efficace.

L'ingénierie rapide améliore la qualité et la précision des résultats générés par l'IA en élaborant des instructions claires et détaillées qui orientent le modèle vers la production de réponses pertinentes et précises. Des instructions bien conçues minimisent les erreurs, réduisent la nécessité d'un post-traitement approfondi et contribuent à garantir que l'IA répond efficacement aux attentes des utilisateurs.

En affinant la façon dont les instructions sont structurées, cette méthode permet non seulement d'économiser du temps et des ressources, mais améliore également l'efficacité et la fiabilité du flux de travail. Il permet aux utilisateurs d'obtenir des résultats fiables et constants, libérant ainsi toutes les capacités de leurs systèmes d'IA.