La tokenisation est l'épine dorsale de la façon dont les grands modèles linguistiques (LLM) traitent le texte, influençant directement les performances, les coûts et l'efficacité. Ce guide explore comment optimiser les stratégies de tokenisation pour améliorer les résultats des modèles, réduire les dépenses et garantir la conformité. Les principaux points à retenir sont les suivants :

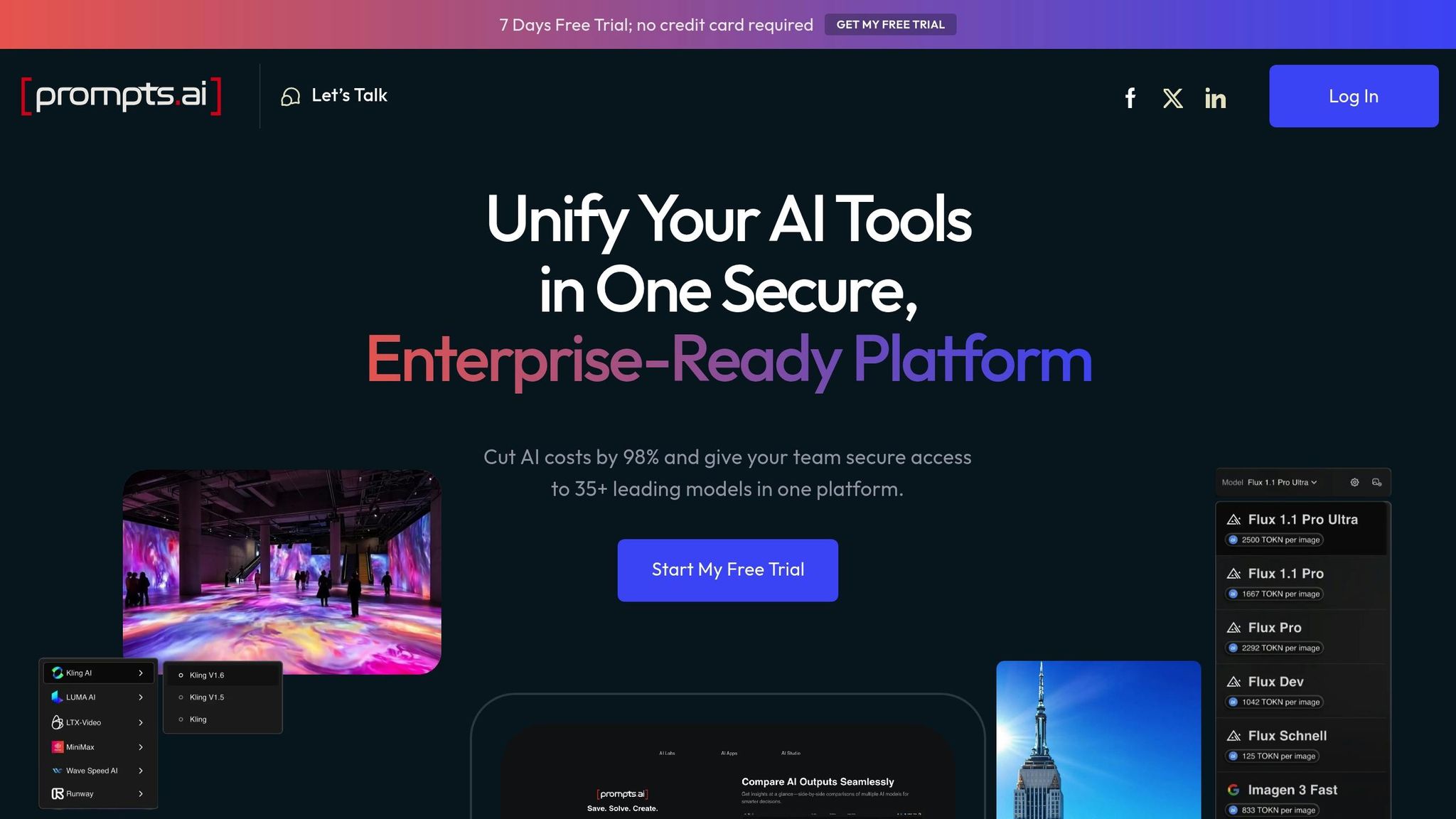

Pour les entreprises, des plateformes telles que prompts.ai simplifiez la gestion de la tokenisation en proposant un suivi des coûts en temps réel, des outils de gouvernance et des fonctionnalités collaboratives pour rationaliser les opérations. Qu'il s'agisse de peaufiner les instructions ou de les adapter à d'autres systèmes, ces pratiques garantissent que votre stratégie de tokenisation est efficace et fiable.

Lors de la sélection d'un tokenizer, plusieurs facteurs doivent guider votre décision, notamment la complexité de la langue, les besoins du domaine, la taille du vocabulaire et les exigences spécifiques de votre application. Caractéristiques de la langue constituent un point de départ essentiel. Pour les langues telles que l'allemand ou le finnois, qui ont des structures de mots complexes, la tokenisation au niveau des sous-mots ou des caractères est mieux adaptée pour gérer des formations de mots complexes. D'autre part, les langages plus simples peuvent donner de bons résultats avec la tokenisation au niveau des mots.

Spécificité du domaine est une autre considération essentielle. L'adaptation des tokeniseurs à des données d'entraînement spécialisées améliore les taux de compression et garantit de meilleures performances dans des contextes spécifiques. Cet alignement entre le tokenizer et le domaine peut avoir un impact significatif sur la qualité des résultats.

Quand il s'agit de taille du vocabulaire, il est essentiel de trouver le juste équilibre entre précision et efficacité informatique. Pour l'anglais, environ 33 000 jetons suffisent souvent. Cependant, les modèles multilingues, en particulier ceux qui prennent en charge cinq langues ou moins, peuvent nécessiter des vocabulaires trois fois plus volumineux pour maintenir des performances constantes dans toutes les langues. Gardez à l'esprit que des vocabulaires plus volumineux augmentent les demandes de calcul, alors évaluez ces coûts par rapport aux avantages potentiels.

Complexité des applications et exigences relatives au modèle jouent également un rôle important. La tokenisation des sous-mots, par exemple, permet de trouver un équilibre entre la taille du vocabulaire et la complexité de la langue, ce qui en fait un bon choix pour les applications nécessitant une solide compréhension sémantique. Modèles de transformateurs populaires tels que BERT et TPT s'appuient souvent sur des méthodes de sous-mots telles que le codage par paire d'octets (BPE) ou WordPiece. Par ailleurs, la tokenisation au niveau des caractères est mieux adaptée aux réseaux neuronaux récurrents (RNN) et aux tâches de synthèse vocale.

Une fois ces facteurs définis, l'étape suivante consiste à affiner les paramètres de tokenisation pour des performances optimales.

Pour optimiser les performances, concentrez-vous sur l'optimisation des paramètres de pré-tokenisation et d'entraînement. Commencez par configurer schémas de pré-tokenisation avec des expressions régulières. Ces modèles vous permettent de personnaliser la segmentation du texte en fonction de besoins spécifiques, offrant ainsi un moyen puissant de personnaliser le prétraitement.

Sélection des données d'entraînement est tout aussi important. Entraîner les utilisateurs de jetons sur des données qui ressemblent beaucoup à celles qu'ils rencontreront lors de l'inférence donne les meilleurs résultats. Par exemple, la formation au code améliore la compression pour les langages de programmation, tandis que les ensembles de données multilingues améliorent les performances dans plusieurs langues. Une combinaison équilibrée de types de données garantit des résultats cohérents dans tous les domaines.

Une attention particulière doit également être accordée à taille du vocabulaire et longueur de séquence. Des vocabulaires plus volumineux peuvent réduire l'utilisation de la mémoire mais augmenter les coûts de décodage. Cependant, une compression excessive peut raccourcir trop les séquences, ce qui peut nuire aux capacités de raisonnement. Dans les environnements aux ressources limitées, il est essentiel de trouver un équilibre entre la compression et le maintien d'un contexte suffisant pour un traitement efficace.

Une fois votre stratégie en place, il est temps d'évaluer les algorithmes de tokenisation afin de trouver la solution la mieux adaptée à vos besoins en matière de performances et d'évolutivité. Chaque algorithme a ses avantages et ses inconvénients.

Parmi celles-ci, Phrase se distingue par sa capacité à gérer efficacement diverses langues, ce qui en fait un choix de premier plan pour les applications mondiales. Pour les tâches nécessitant un traitement rapide, BPE est une option fiable, offrant un bon équilibre entre vitesse et performances. Word Piece est particulièrement efficace pour les tâches qui exigent une solide compréhension sémantique, c'est pourquoi il est largement utilisé dans les modèles de transformateurs. Entre-temps, Unigramme fournit un excellent support pour les tâches multilingues mais nécessite davantage de ressources de calcul, ce qui en fait un outil idéal lorsque la précision est prioritaire par rapport à la vitesse.

Les implémentations modernes de tokenizer, telles que Tokéniseur Hugging Face, font preuve d'une efficacité impressionnante en traitant environ 1 Go de données sur un processeur en moins de 20 secondes. Cette fonctionnalité garantit que même les charges de travail importantes peuvent être gérées efficacement, quel que soit l'algorithme choisi.

Pour ceux qui peaufinent les modèles existants, les tokeniseurs peuvent souvent être ajustés avec un impact minimal sur les performances en aval, à condition que l'ensemble de données d'entraînement comprenne au moins 50 milliards de jetons. Cette flexibilité permet une optimisation continue des stratégies de tokenisation, même après le développement d'un modèle.

Trouver le juste équilibre entre la taille du vocabulaire et la longueur des séquences joue un rôle crucial dans l'optimisation des performances des grands modèles linguistiques. Les vocabulaires plus petits ont tendance à diviser le texte en plusieurs éléments plus petits, tandis que les vocabulaires plus volumineux produisent des symboles plus petits et plus grands. Par exemple, GPT-4 utilise environ 100 000 jetons, Lama gère environ 128 000, et Mistral fonctionne avec environ 32 000 jetons, reflétant leurs objectifs d'optimisation uniques et leurs applications cibles.

Un vocabulaire plus large, comme celui de GPT-4, réduit le nombre de jetons nécessaires pour représenter le texte par rapport aux modèles précédents tels que GPT-2. Cela permet de doubler efficacement la quantité d'informations que le modèle peut traiter dans une fenêtre contextuelle donnée. Les modèles multilingues qui prennent en charge un nombre limité de langues peuvent nécessiter des vocabulaires jusqu'à trois fois plus volumineux pour maintenir des performances constantes dans toutes les langues. La sélection de la bonne taille de vocabulaire permet de minimiser la fragmentation des jetons tout en préservant l'efficacité du modèle. La tokenisation des sous-mots offre un équilibre entre la compression et la gestion des nouveaux mots, ce qui en fait un choix pratique pour de nombreuses applications.

Une fois le vocabulaire et la longueur des séquences optimisés, l'efficacité peut être encore améliorée grâce à la mise en cache et au traitement parallèle.

La mise en cache est un moyen efficace d'améliorer l'efficacité de la tokenisation en stockant les calculs en vue de leur réutilisation. La mise en cache clé-valeur (KV), par exemple, permet d'économiser les tenseurs de clé et de valeur des étapes d'inférence précédentes, réduisant ainsi les calculs redondants. Par exemple, Substrat rocheux d'Amazon a démontré des temps de réponse jusqu'à 85 % plus rapides pour le contenu mis en cache, les jetons mis en cache ne représentant qu'environ 10 % du coût des jetons d'entrée classiques. De même, activer la mise en cache KV dans Transformateurs Hugging Face peut accélérer la génération d'environ 5 fois pour une sortie de 300 jetons sur un GPU T4, réduisant ainsi considérablement le temps de traitement.

Pour optimiser les avantages de la mise en cache, structurez les invites de manière stratégique. Placez d'abord le contenu statique, puis un point de contrôle du cache, puis ajoutez du contenu dynamique. Par exemple, dans un système de réponse aux questions basé sur des documents, le positionnement du texte du document au début, l'insertion d'un point de contrôle dans le cache, puis l'ajout de la question de l'utilisateur peuvent rationaliser le traitement.

Le traitement parallèle améliore également les performances en répartissant les tâches de tokenisation sur plusieurs processeurs. Cette approche est particulièrement efficace pour la tokenisation par lots. Les tokeniseurs modernes, tels que le Hugging Face Tokenizer, peuvent traiter efficacement de grands ensembles de données, en gérant environ 1 Go de données sur un processeur en moins de 20 secondes.

Après avoir mis en œuvre ces techniques, il est essentiel de mesurer leur impact à l'aide de mesures de performance.

Le suivi des indicateurs de performance est essentiel pour garantir l'efficacité et la rentabilité de votre stratégie de tokenisation. Les principaux indicateurs à suivre incluent la longueur de séquence normalisée (NSL) et la fertilité des sous-mots, car un nombre inférieur de jetons indique généralement une fragmentation réduite et une efficacité améliorée.

Par exemple, le tokenizer SUTRA a affiché des performances exceptionnelles dans 14 langues sur la base des indicateurs NSL. De plus, des avancées telles que GPT-4o ont démontré une meilleure gestion de certaines langues indiennes par rapport au GPT-4. Au-delà de la NSL et de la fertilité des sous-mots, surveillez la latence, le débit et l'utilisation des ressources pour affiner votre approche de tokenisation pour une vitesse optimale et des économies de coûts.

L'évaluation régulière de ces indicateurs permet d'effectuer des ajustements basés sur les données, garantissant ainsi que votre stratégie de tokenisation reste alignée sur les demandes du monde réel tout en apportant des améliorations mesurables en termes de performances et d'efficacité.

Lorsqu'il s'agit de traiter d'énormes volumes de texte répartis sur des serveurs et des centres de données, les méthodes de tokenisation traditionnelles se heurtent souvent à des goulots d'étranglement en termes de performances. Pour surmonter ces défis, les stratégies distribuées jouent un rôle crucial dans le maintien de l'efficacité, le contrôle des coûts et la garantie de la cohérence. Ces approches reflètent un engagement plus large en faveur de l'optimisation des processus pour les applications à grande échelle.

La mise à l'échelle efficace de la tokenisation commence par une distribution intelligente des charges de travail. Cela implique l'utilisation d'outils tels que les équilibreurs de charge, les planificateurs et les moniteurs parallèlement à des stratégies telles que le Round-Robin, le moindre nombre de connexions, l'équilibrage de charge pondéré et l'équilibrage de charge dynamique. Cependant, les scénarios du monde réel présentent des complexités telles que des charges de travail fluctuantes, des capacités de ressources variables, des retards sur le réseau et la nécessité d'une tolérance aux pannes. Il est essentiel de prendre en compte ces facteurs pour garantir le bon fonctionnement des environnements distribués.

La surveillance des coûts de tokenisation dans les configurations distribuées devient de plus en plus importante à mesure que les investissements dans l'IA augmentent. Alors que les dépenses liées à l'IA devraient augmenter de 36 % d'ici 2025 et que seulement 51 % des entreprises sont confiantes dans l'évaluation du retour sur investissement de leur IA, la transparence des coûts est plus essentielle que jamais. Des outils tels que Lang Smith et Langfuse simplifiez le suivi des coûts des jetons, tandis que les fonctionnalités de marquage dans le cloud, telles que celles proposées par Amazon Bedrock, permettent de répartir les dépenses avec précision. En mettant en œuvre des cadres de gouvernance des données et en automatisant la collecte de données, les organisations peuvent améliorer la qualité des données et réduire les inefficacités.

Des plateformes comme prompts.ai vont encore plus loin en intégrant des fonctionnalités FinOps qui surveillent l'utilisation des jetons en temps réel. Grâce à son système de crédit TOKN pay-as-you-go, prompts.ai fournit des informations claires sur les coûts de tokenisation sur plusieurs modèles et nœuds. Cela permet aux organisations d'affiner leurs stratégies de tokenisation en fonction de l'utilisation réelle, garantissant ainsi une évolutivité rentable.

Au fur et à mesure que les charges de travail sont distribuées, le maintien de la cohérence des jetons entre les nœuds devient une priorité absolue. Les services ou bibliothèques de gestion de jetons centralisés peuvent normaliser la génération de jetons et garantir des mappages uniformes via un coffre-fort de jetons partagé. Des techniques telles que les algorithmes de consensus, les transactions ACID, les gestionnaires de verrous, le partitionnement des données et la réplication améliorent encore la cohérence. Pour les systèmes géographiquement dispersés, les solutions géo-sensibles aident à maintenir la conformité aux réglementations locales en matière de données, tandis que l'automatisation des politiques de tokenisation réduit le risque d'erreur humaine à mesure que les systèmes gagnent en complexité.

La tokenisation devenant la pierre angulaire des opérations d'IA des entreprises, elle entraîne des défis qui vont au-delà de l'efficacité technique. Les organisations doivent corriger les failles de sécurité potentielles, respecter des normes réglementaires strictes et gérer les considérations éthiques. Ces facteurs sont essentiels pour garantir une mise en œuvre responsable de l'IA sur divers marchés mondiaux.

La tokenisation introduit des vulnérabilités qui peuvent exposer les systèmes d'IA à des menaces telles que l'injection rapide, la reconstruction des données et le vol de modèles. Les attaquants exploitent les faiblesses du traitement des jetons pour manipuler les systèmes ou extraire des informations sensibles. Par exemple, les attaques de reconstruction de données peuvent rétroconcevoir des informations confidentielles à partir de modèles de jetons, tandis que le vol de modèles exploite les failles de tokenisation pour extraire des algorithmes propriétaires.

La racine de ces problèmes réside souvent dans la manière dont les algorithmes de tokenisation gèrent les entrées. Les erreurs de tokenisation peuvent entraîner une mauvaise interprétation par les grands modèles de langage (LLM), ce qui entraîne des résultats inexacts que les attaquants peuvent exploiter. Nombre de ces défauts sont dus aux limites des vocabulaires au niveau des sous-mots, qui sont confrontés à des structures linguistiques complexes.

Les langues ajoutent une couche de complexité supplémentaire, car chacune présente des risques uniques. Les organisations opérant dans des environnements multilingues doivent tenir compte de ces variations lors de la conception de mesures de sécurité.

Pour atténuer ces risques, les entreprises peuvent renforcer la tokenisation en diversifiant les méthodes de segmentation et en mettant en place des contrôles d'accès stricts. Les contrôles d'accès basés sur les rôles peuvent limiter l'accès non autorisé aux systèmes de tokenisation, tandis que la surveillance continue peut aider à détecter des modèles inhabituels signalant des violations potentielles. Ces défenses robustes jettent les bases du respect des normes de conformité et de gouvernance.

Au-delà de la sécurité, les organisations doivent s'assurer que leurs pratiques de tokenisation sont conformes aux cadres réglementaires. Des normes telles que PCI DSS, HIPAA, GDPR et FedRAMP recommandent toutes la tokenisation comme mesure de sécurité clé. Ces réglementations exigent souvent que les données sensibles restent dans des limites géographiques spécifiques, même lorsque des jetons sont utilisés pour le traitement dans le cloud.

Par exemple, Netflix a utilisé avec succès la tokenisation pour sécuriser les données des cartes de paiement, permettant ainsi de se conformer à des réglementations strictes tout en préservant la fluidité de l'expérience client.

La conformité exige également des audits réguliers pour valider l'intégrité de la tokenisation. Les organisations doivent régulièrement évaluer à la fois leurs systèmes internes et leurs fournisseurs externes pour garantir le respect des normes. Lors de l'externalisation de la tokenisation, les entreprises doivent confirmer que les fournisseurs de services répondent aux exigences de la norme PCI DSS et inclure des attestations de conformité dans leurs audits.

À mesure que les réglementations évoluent, les organisations doivent mettre à jour leurs politiques de tokenisation pour rester en phase avec les nouvelles exigences. Des politiques de conservation claires sont essentielles, car elles définissent la durée de stockage des données sous forme de jetons et décrivent les pratiques d'élimination sécurisées lorsqu'elles ne sont plus nécessaires.

Des plateformes telles que prompts.ai simplifient ces défis en proposant des fonctionnalités de gouvernance qui permettent de suivre l'utilisation de la tokenisation sur les systèmes distribués. Grâce à un suivi des coûts et à des pistes d'audit transparents, les organisations peuvent maintenir la conformité tout en optimisant les opérations dans différents modèles et régions d'IA.

La prise de décision éthique est tout aussi importante que la sécurité et la conformité en matière de tokenisation. Les choix opérés en matière de tokenisation peuvent avoir de lourdes conséquences, notamment en termes d'équité et de représentation. L'équité en matière de multilinguisme est l'une des principales préoccupations. Les systèmes de tokenisation qui ne représentent pas correctement les langues autres que l'anglais risquent de perpétuer des biais systémiques en créant des jetons mal entraînés. Cela peut entraîner des performances d'IA médiocres pour les locuteurs de ces langues.

La tokenisation peut également amplifier les biais de données existants. La sous-représentation des langues et des caractéristiques démographiques entraîne souvent une distorsion des performances des modèles, ce qui soulève des préoccupations éthiques dans des domaines tels que les soins de santé. Par exemple, des études montrent que les LLM peuvent utiliser 15 attributs démographiques seulement pour réidentifier presque toutes les données personnelles dans des ensembles de données anonymisés, ce qui présente de graves risques pour la confidentialité. Dans les applications de santé, des biais ont été observés dans des outils tels que ChatGPT-4, qui recourt parfois à des stéréotypes dans les suggestions de diagnostic, affectant de manière disproportionnée certaines races, ethnies et sexes.

Pour relever ces défis, les organisations devraient mettre en place des cadres de responsabilisation clairs. Les mesures de transparence peuvent aider à suivre la responsabilité des décisions en matière d'IA, tandis que les différentes équipes d'IA peuvent identifier les biais qui pourraient passer inaperçus au sein de groupes homogènes. Les systèmes d'évaluation continue sont également essentiels pour surveiller les résultats du LLM et faire face aux conséquences imprévues.

« Nous avons besoin de lignes directrices sur la paternité, les exigences de divulgation, l'utilisation pédagogique et la propriété intellectuelle, en nous appuyant sur les instruments normatifs existants et sur des débats pertinents similaires, tels que l'amélioration humaine. » — Julian Savulescu, auteur principal

La tokenisation soulève également des questions éthiques en matière de génération de contenu. Tout en permettant la création de contenu à grande échelle, cela ouvre également la porte à des conséquences néfastes, notamment à la désinformation et à la désinformation. Les organisations doivent mettre en œuvre de solides politiques de modération du contenu et donner la priorité à la formation des utilisateurs afin de minimiser ces risques. Trouver un équilibre entre innovation et responsabilité est essentiel pour garantir que les stratégies de tokenisation profitent à la société.

Dans le domaine de la santé, les enjeux éthiques sont particulièrement importants. La tokenisation doit tenir compte de la confidentialité des patients, de l'équité, de la sécurité, de la transparence et de l'intégration clinique. Des approches spécialisées sont nécessaires pour protéger les données de santé sensibles tout en garantissant l'efficacité des outils de diagnostic pour diverses populations.

La mise au point de la tokenisation pour les grands modèles de langage implique une approche réfléchie qui donne la priorité aux performances, à la gestion des coûts et à la responsabilité éthique. En suivant les stratégies décrites ici, les équipes de l'entreprise peuvent réduire leurs dépenses tout en garantissant des résultats d'IA cohérents et de haute qualité sur les différents systèmes. Vous trouverez ci-dessous un guide simplifié pour mettre ces pratiques en pratique.

Les méthodes suivantes sont conformes aux discussions précédentes sur l'amélioration des performances, la garantie de la sécurité et la résolution des problèmes éthiques :

Pour déployer une stratégie de tokenisation efficace, divisez le processus en trois phases clés :

Les plateformes conçues pour la gestion de l'IA à grande échelle, telles que prompts.ai, peuvent simplifier et accélérer le processus d'optimisation de la tokenisation sur les systèmes distribués. Grâce à son interface unifiée, prompts.ai prend en charge plusieurs grands modèles de langage, rationalisant ainsi la gestion des modèles dans un environnement sécurisé.

La couche FinOps intégrée à la plateforme permet un suivi des jetons en temps réel et une optimisation des coûts, aidant ainsi les organisations à éviter les surcharges dans les modèles de tarification de paiement par jeton. Ses fonctionnalités de gouvernance garantissent la conformité à des pistes d'audit transparentes et à la responsabilisation des coûts. En outre, les outils collaboratifs permettent aux équipes d'affiner plus facilement l'ingénierie rapide, en réduisant l'utilisation de jetons tout en maintenant, voire en améliorant, la qualité des résultats. Pour les entreprises qui adaptent leurs stratégies de tokenisation, prompts.ai élimine la complexité liée à la gestion des environnements multifournisseurs, permettant aux équipes de se concentrer sur l'innovation et la réalisation de leurs objectifs.

Le choix de la taille de vocabulaire adaptée à votre modèle linguistique dépend de la nature de votre jeu de données et des objectifs de votre projet. Commencez par examiner la distribution des fréquences des jetons dans votre ensemble de données afin de trouver un équilibre entre capture d'un large éventail de mots et maintien de l'efficacité du processus en évitant toute complexité inutile.

Pour les petits ensembles de données, il est souvent plus pratique d'opter pour une taille de vocabulaire plus petite. Cette approche minimise les exigences de calcul tout en offrant des performances solides. D'un autre côté, les ensembles de données plus volumineux bénéficient généralement d'un vocabulaire plus étendu, car cela permet une meilleure représentation des jetons et une précision accrue. Les meilleurs résultats sont souvent obtenus grâce à un processus d'essais, d'erreurs et de réglages.

À l'aide d'outils tels que prompts.ai peut simplifier cette tâche. Grâce aux fonctionnalités intégrées de suivi et d'optimisation de la tokenisation, vous pouvez gagner du temps et redimensionner vos efforts de manière plus efficace.

Pour protéger les données tokenisées et maintenir la conformité dans les environnements multilingues, il est essentiel de mettre en œuvre des outils adaptés à différents langages et jeux de caractères. Cela permet de minimiser les risques tels que la mauvaise interprétation des données ou une exposition involontaire. Employant contrôles d'accès stricts, dirigeant audits réguliers, et le respect de normes telles que la norme PCI DSS constitue une étape clé dans la protection des informations sensibles.

De plus, les jetons doivent être conçus pour être pertinents uniquement dans des contextes d'application spécifiques. L'utilisation cohérente de politiques de cryptage et de désidentification garantit en outre la sécurité et la conformité des données tokenisées, quelles que soient la langue ou la région où elles sont utilisées.

La mise en cache, en particulier mise en cache des valeurs clés, joue un rôle crucial dans l'amélioration de l'efficacité de la tokenisation. En stockant les représentations de jetons qui ont déjà été calculées, il élimine le besoin de calculs répétitifs. Cela accélère non seulement le processus de tokenisation, mais accélère également l'inférence dans les grands modèles de langage (LLM).

En outre, traitement parallèle améliore les performances en permettant la réalisation simultanée de plusieurs opérations. Cette approche permet de remplir les caches plus rapidement et de minimiser les délais, notamment le délai critique jusqu'au premier jeton (TTFT). Lorsqu'elles sont combinées, ces stratégies améliorent l'évolutivité, augmentent le débit et réduisent de manière significative les coûts opérationnels associés au déploiement de LLM.