Les systèmes d'IA sensibles au contexte redéfinissent le mode de fonctionnement des entreprises en utilisant des signaux du monde réel tels que la localisation, l'heure et le comportement des utilisateurs pour prendre des décisions adaptées à des situations spécifiques. Contrairement aux anciens modèles d'IA qui s'appuient sur des entrées statiques, ces systèmes mettent continuellement à jour leur compréhension, offrant des réponses plus précises et dynamiques. Alimentés par de grands modèles linguistiques (LLM), ils excellent dans le traitement du contexte grâce à des mécanismes tels que les couches d'attention, les fenêtres contextuelles et la génération augmentée par extraction (RAG).

Principaux points à retenir :

L'adoption de stratégies telles que le réglage fin, la génération augmentée par récupération et les systèmes de mémoire peut aider les entreprises à améliorer leurs processus de prise de décisions et à rationaliser les flux de travail. À mesure que le domaine évolue, l'ingénierie contextuelle et les systèmes multi-agents sont des tendances émergentes, offrant des solutions plus avancées et plus flexibles.

La création de systèmes d'IA sensibles au contexte efficaces nécessite un cadre sophistiqué qui va au-delà des configurations de base de réponse rapide. Ces systèmes doivent intégrer différents composants pour traiter et utiliser les informations contextuelles en temps réel. La compréhension de cette architecture est essentielle pour créer des solutions d'IA fiables.

Les systèmes de grands modèles linguistiques (LLM) sensibles au contexte s'appuient sur un ensemble de composants interconnectés pour générer des réponses intelligentes et adaptatives. Les éléments clés sont les suivants : fenêtres contextuelles, qui déterminent la quantité d'informations que le système peut traiter en une seule fois. Par exemple, Gémeaux 1.5 Pro prend en charge jusqu'à 2 millions de jetons, tandis que Claude 3,5 Sonnet gère 200 000 personnes, et GPT-4 Turbo gère 128 000 jetons.

Mécanismes de récupération extrait des données pertinentes pour la tâche à accomplir, tandis qu'un encodeur de contexte organise ces informations dans un format que le LLM peut traiter. Le modèle de génération utilise ensuite ce contexte structuré pour élaborer des réponses. Entre-temps, systèmes de mémoire dédiés stockez différents types d'informations, permettant à l'IA de tirer des leçons des interactions précédentes et d'appliquer ces connaissances à des scénarios futurs.

UNE routeur contextuel ou gestionnaire de mémoire garantit que les bonnes données sont acheminées vers les bons processus au bon moment. En outre, un générateur d'invites sensible à la mémoire intègre le contexte historique dans les instructions, et le interface de l'agent principal sert de point d'interaction principal pour l'utilisateur.

Il est intéressant de noter que les entreprises qui optimisent leurs systèmes de mémoire réduisent souvent les coûts des API LLM de 30 à 60 % en réduisant le traitement contextuel redondant.

Des plateformes comme Ko maximum combiner les LLM avec la recherche de connaissances externes à l'aide d'outils tels qu'une interface basée sur Vue.js et PostgreSQL avec pgvector pour le stockage intégré de documents. Ko maximum s'intègre à des fournisseurs tels que Lama 3, Reine 2, IA ouverte, et Claude. De même, Continuer, un assistant de codage pour Code VS, indexe les bases de code des projets dans des bases de données vectorielles, en enrichissant les instructions des utilisateurs avec des extraits de code pertinents.

Ces composants constituent l'épine dorsale d'une gestion efficace du contexte et ouvrent la voie à l'exploration de méthodes avancées permettant de gérer efficacement le contexte.

La gestion efficace du contexte consiste à trouver un équilibre entre le besoin d'informations pertinentes et les performances du système. Les entreprises doivent souvent trouver des compromis entre la conservation d'informations détaillées, la garantie de temps de réponse rapides et la gestion de la complexité des systèmes.

Certaines des techniques les plus efficaces incluent chaînage rapide et intégration de mémoire, qui permettent de conserver le contexte sans surcharger le système.

Réglage fin est une autre approche, dans laquelle les modèles pré-entraînés sont personnalisés pour des tâches spécifiques en les réentraînant à l'aide de nouvelles données. Bien que cette méthode soit très efficace pour les applications spécialisées, elle nécessite une nouvelle formation chaque fois que les données changent, ce qui la rend moins flexible pour les contextes dynamiques.

Génération augmentée par récupération (RAG) se distingue comme une stratégie qui améliore la précision et la pertinence en incorporant des connaissances externes au moment de l'inférence. Contrairement à la mise au point, RAG ne nécessite pas de réentraînement du modèle.

Parmi les autres stratégies pratiques, citons compression contextuelle, qui peut réduire l'utilisation des jetons de 40 à 60 %, et mise en mémoire tampon, qui met l'accent sur le contexte à court terme. Pour les documents volumineux, résumé hiérarchique est souvent utilisé, même s'il comporte un risque d'erreurs cumulatives.

Le choix de la bonne méthode dépend de l'application. Par exemple, les outils interactifs nécessitant des réponses rapides peuvent donner la priorité à une faible latence, tandis que les systèmes plus analytiques peuvent favoriser la conservation d'un contexte complet, même si cela augmente le temps de traitement.

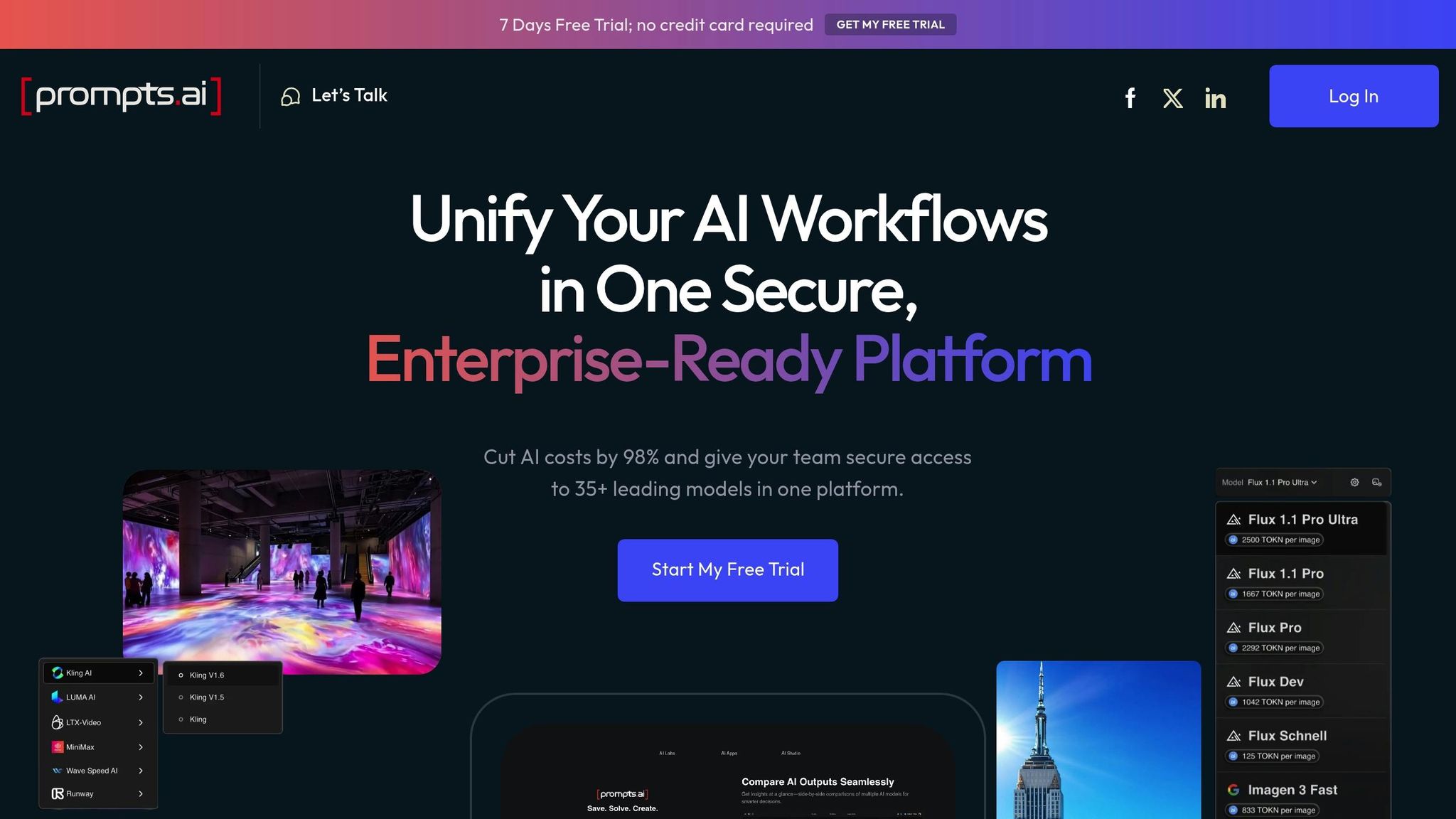

Des plateformes telles que prompts.ai intègrent ces stratégies dans des flux de travail rationalisés, garantissant à la fois efficacité et évolutivité.

En s'appuyant sur une architecture avancée et des stratégies de gestion du contexte, prompts.ai crée des flux de travail unifiés adaptés aux systèmes d'IA sensibles au contexte. La plateforme met l'accent sur la sécurité, l'évolutivité et la conformité, passant de l'ingénierie rapide traditionnelle à ingénierie du contexte.

« L'ingénierie du contexte est l'art et la science délicats qui consistent à remplir la fenêtre contextuelle avec les bonnes informations pour l'étape suivante. » — Andrej Karpathy

Ce concept implique l'assemblage de divers composants, tels que des instructions, des systèmes de mémoire, des sorties RAG, des résultats d'outils et des formats structurés, dans des solutions cohérentes.

Pour une utilisation en entreprise, prompts.ai prend en charge plus de 35 LLM de premier plan, dont GPT-4, Claude, LLama et Gemini. En centralisant ces outils, elle aide les organisations à réduire la prolifération des outils tout en maintenant la gouvernance et le contrôle des coûts.

L'architecture de la plateforme est conçue pour répondre à des besoins complexes en matière de gestion de la mémoire. Grâce à des API détaillées et à des options de configuration, les entreprises peuvent affiner le comportement de la mémoire afin d'optimiser la gestion du contexte tout en réduisant la charge de calcul et la latence.

Par exemple, un fournisseur de soins de santé du Fortune 100 a réduit le temps d'itération des propositions de 60 % en intégrant des métadonnées dans les instructions destinées à un assistant d'IA chargé de refactoriser le système. En outre, il a été démontré que les systèmes contextuels qui mémorisent les préférences des utilisateurs augmentaient les taux de rétention des utilisateurs de 40 à 70 %.

La transformation des données brutes en informations exploitables est au cœur d'un pipeline de décisions efficace. Ces pipelines constituent la base des systèmes d'IA capables de saisir le contexte, de gérer des scénarios complexes et de fournir des recommandations pertinentes.

Un pipeline de décisions bien structuré et tenant compte du contexte se déroule généralement en quatre étapes. Cela commence par collecte de contexte, où les données sont collectées à partir de sources telles que des bases de données, des documents, des interactions avec les utilisateurs et des flux en temps réel.

L'étape suivante, raisonnement, exploite de grands modèles linguistiques (LLM) pour traiter ces données, découvrir des modèles, identifier des relations et générer des conclusions logiques. Cette étape produit des recommandations réalisables, souvent accompagnées de scores de confiance.

Boucles de rétroaction jouent un rôle essentiel dans l'amélioration du système. En capturant les réponses des utilisateurs, les résultats et les mesures de performance, ces boucles aident le système à améliorer sa précision et son adaptabilité au fil du temps. Par exemple, une entreprise de taille moyenne développant un agent de support client basé sur l'IA peut traiter les tickets en extrayant le contenu via une API, en supprimant les signatures, en dédupliquant les données et en divisant les informations en segments sémantiques enrichis de métadonnées à des fins de surveillance.

Génération augmentée par récupération (RAG) les pipelines vont encore plus loin dans la prise de décision en reliant les LLM à des bases de connaissances externes pendant la phase de raisonnement. Cet accès dynamique aux informations pertinentes élimine le besoin de reformer les modèles, ce qui rend le processus plus flexible et plus efficace. Voyons maintenant comment plusieurs agents LLM collaborent pour affiner les décisions.

L'essor des systèmes multi-agents marque une transition des modèles d'IA autonomes vers des cadres collaboratifs. Dans ces systèmes, plusieurs agents alimentés par LLM travaillent ensemble pour résoudre des problèmes complexes. Ils se connectent, négocient, prennent des décisions, planifient et agissent collectivement, le tout guidé par des protocoles de collaboration clairement définis.

La collaboration peut se produire à différents niveaux :

Des exemples concrets mettent en évidence les avantages de ces systèmes collaboratifs. En avril 2024, Zendesk a intégré des agents LLM à sa plateforme de support client, permettant des réponses automatisées grâce à des partenariats avec Anthropique, AWS, et OpenAI, qui rend GPT-4o accessible aux utilisateurs. Copilote GitHub le montre en action en proposant des suggestions de code en temps réel, permettant aux ingénieurs de coder jusqu'à 55 % plus rapidement. En outre, McKinsey estime que l'IA générative pourrait apporter entre 2,6 et 4,4 billions de dollars à la valeur commerciale mondiale dans 63 cas d'utilisation. Des études montrent également que les flux de travail utilisant plusieurs agents avec GPT 3.5 sont souvent plus performants que les configurations à agent unique avec GPT 4. NVIDIALe framework de LLM démontre en outre comment les agents LLM peuvent interagir avec des bases de données structurées, extraire des données financières et gérer des analyses complexes.

Les cadres collaboratifs ne sont qu'une pièce du puzzle. L'optimisation de la gestion du contexte au sein des pipelines de décision est tout aussi importante. Les différentes stratégies ont leurs propres forces et limites, comme indiqué ci-dessous :

Parmi celles-ci, compression contextuelle se distingue par une réduction de l'utilisation des jetons de 40 à 60 % tout en maintenant la vitesse de traitement. Associé à RAG, il garantit des réponses précises et sourcées en récupérant dynamiquement le contexte pertinent. La mise en mémoire tampon est particulièrement utile pour les applications conversationnelles nécessitant un contexte à court terme, tandis que la synthèse hiérarchique excelle dans la gestion de longs documents malgré l'accumulation potentielle d'erreurs.

Le choix de la bonne stratégie dépend de votre application. Pour des réponses précises, RAG est idéal. Pour les longues conversations multisessions, c'est la mise en mémoire tampon qui fonctionne le mieux. La synthèse hiérarchique est particulièrement efficace lors du traitement de textes étendus, tandis que la compression contextuelle permet de réaliser des économies. Pour les scénarios où la vitesse est essentielle, il est judicieux de combiner RAG et compression. Des outils tels que LitellM et des plateformes comme Agenta vous permettent d'expérimenter plus facilement ces stratégies et de passer de l'une à l'autre, en vous aidant à trouver celle qui répond le mieux à vos besoins spécifiques.

Les systèmes d'IA sensibles au contexte, alimentés par de grands modèles linguistiques (LLM), remodèlent les industries en proposant des solutions intelligentes et adaptables. Ces applications mettent en évidence la façon dont les techniques avancées de gestion du contexte font une différence tangible.

L'architecture avancée de l'IA sensible au contexte stimule l'innovation dans divers secteurs et prouve sa valeur dans des scénarios concrets.

Soins de santé s'est imposé comme un leader dans l'adoption d'une IA sensible au contexte. Ces systèmes sont utilisés pour prédire la progression de la maladie et faciliter la prise de décisions cliniques. Par exemple, les LLM analysent les rapports de tomographie assistée par ordinateur pour prédire les métastases du cancer dans plusieurs organes. D'ici 2025, l'investissement indien dans les soins de santé liés à l'IA devrait atteindre 11,78 milliards de dollars, avec le potentiel de stimuler l'économie de 1 billion de dollars d'ici 2035.

Services financiers exploitent ces systèmes pour améliorer l'analyse des données, les prévisions, les calculs en temps réel et le service client. Les chatbots financiers sont désormais capables de traiter des requêtes complexes et multilingues, améliorant ainsi les expériences de support client. Le GPT-4 a notamment atteint un taux de précision de 60 % en matière de prévisions, surpassant ainsi les analystes humains et permettant de prendre des décisions d'investissement plus éclairées.

Service à la clientèle a connu une transformation avec Assistants alimentés par IA gérer des tâches telles que le traitement des demandes de renseignements, le traitement des retours et la réalisation de contrôles d'inventaire. Ces systèmes reconnaissent également l'intention des clients, ce qui permet des opportunités de vente incitative. Au Royaume-Uni, l'IA traite désormais jusqu'à 44 % des demandes des clients pour les fournisseurs d'énergie.

Commerce de détail et commerce électronique bénéficient d'expériences personnalisées pilotées par l'IA. McKinsey estime que l'IA générative pourrait ajouter de 240 à 390 milliards de dollars par an au secteur de la vente au détail, augmentant potentiellement les marges bénéficiaires de 1,9 point de pourcentage. En analysant le comportement et les préférences des clients, ces systèmes fournissent des recommandations personnalisées qui améliorent les expériences d'achat.

Traitement et analyse des documents est un autre domaine dans lequel l'IA a un impact. Dans tous les secteurs, les entreprises automatisent l'extraction, l'analyse et la synthèse de grands volumes de documents, tels que des contrats, des rapports et des e-mails. Cela réduit les tâches manuelles et accélère les flux de travail.

Éducation et formation adoptent l'IA en intégrant des pipelines d'IA génératifs avec des avatars virtuels. Ces outils créent des contenus d'apprentissage en temps réel accessibles à la fois sur le Web et dans des environnements de réalité virtuelle, rendant ainsi l'enseignement plus interactif et engageant.

L'augmentation de productivité des systèmes d'IA sensibles au contexte est frappante. Par exemple, CLÉ a investi 1,4 milliard de dollars dans une plateforme d'IA et a déployé un LLM privé (EYQ) auprès de 400 000 employés. Cela s'est traduit par une augmentation de 40 % de la productivité, qui devrait doubler en un an. Une enquête mondiale réalisée par McKinsey en 2024 a également révélé que 65 % des organisations utilisent activement l'IA, les taux d'adoption ayant doublé depuis 2023 en raison des progrès de l'IA générative.

L'automatisation rendue possible par ces systèmes permet aux employés de se concentrer sur des tâches à plus forte valeur ajoutée. Les équipes de support client constatent des temps de réponse plus rapides, le traitement des documents passe de quelques heures à quelques minutes et l'analyse financière devient plus précise et plus efficace. Cependant, comme le souligne Nigam Shah, PhD, MBBS, responsable des données chez Soins de santé de Stanford, souligne :

« Nous l'appelons « bingo LLM », où les gens cochent ce que ces modèles peuvent et ne peuvent pas faire. « Peut-il réussir les examens médicaux ? Vérifiez. Peut-il résumer les données et l'historique d'un patient ? Vérifiez. » Bien que la réponse soit oui à première vue, nous ne nous posons pas les questions les plus importantes : « Quelles sont ses performances ? Cela a-t-il un impact positif sur les soins aux patients ? Cela augmente-t-il l'efficacité ou réduit-il les coûts ? '»

Des plateformes telles que prompts.ai interviennent pour rationaliser l'intégration de l'IA contextuelle dans les flux de travail des entreprises. prompts.ai simplifie le processus en connectant les utilisateurs aux meilleurs modèles d'IA tels que GPT-4, Claude, LLama et Gemini via une interface unifiée, éliminant ainsi le besoin de jongler avec plusieurs outils. Cette approche permettrait de réduire les coûts liés à l'IA de 98 % et de décupler la productivité des équipes grâce à des comparaisons de modèles côte à côte.

Des exemples concrets mettent en évidence la polyvalence de la plateforme :

La plateforme propose également des fonctionnalités de niveau entreprise, notamment une visibilité et une auditabilité complètes des interactions avec l'IA, garantissant ainsi conformité et évolutivité. Dan Frydman, un leader d'opinion en matière d'IA, note que les « Time Savers » intégrés à prompts.ai aident les entreprises à automatiser les ventes, le marketing et les opérations, stimulant ainsi la croissance et la productivité grâce à l'IA.

Intégration avec des outils tels que Slack, Gmail, et Trello améliore encore sa facilité d'utilisation, permettant aux équipes d'intégrer l'IA de manière fluide dans leurs flux de travail existants. Avec une note moyenne des utilisateurs de 4,8/5, la plateforme est saluée pour sa capacité à rationaliser les opérations, à améliorer l'évolutivité et à centraliser la communication sur les projets.

Cette évolution de l'intégration de l'IA souligne le potentiel croissant des systèmes sensibles au contexte, ouvrant la voie aux avancées futures abordées dans les sections suivantes.

La mise en œuvre de systèmes d'IA sensibles au contexte comporte son lot de défis techniques et opérationnels. Il est essentiel de surmonter ces obstacles, d'adopter des stratégies efficaces et de garder une longueur d'avance sur les tendances émergentes pour tirer le meilleur parti des investissements dans l'IA. Examinons les obstacles, les meilleures pratiques et les développements futurs qui façonnent le domaine de l'IA sensible au contexte.

La gestion du contexte dans les systèmes d'IA, en particulier lors de la coordination de plusieurs agents d'IA, n'est pas une mince affaire. Cela nécessite une synchronisation précise, une communication claire et des protocoles robustes pour garantir le bon fonctionnement de tout. Lorsque plusieurs grands modèles linguistiques (LLM) sont impliqués, le maintien d'un contexte cohérent devient de plus en plus complexe.

L'un des principaux problèmes est surcharge d'informations. Ces systèmes doivent traiter de grandes quantités de données tout en équilibrant les interactions à court terme et la mémoire à long terme. En outre, ils doivent garantir une interprétation cohérente des informations partagées dans l'ensemble des flux de travail.

Un autre défi est le écart de contexte, ce qui se produit lorsque les systèmes d'IA ne sont pas correctement mis à la terre. Il est donc difficile de faire la distinction entre des points de données quasiment identiques ou de déterminer si des mesures spécifiques correspondent aux besoins de l'entreprise. Des obstacles spécifiques au domaine entrent également en jeu. Les LLM à usage général n'ont souvent pas les connaissances spécialisées requises pour les applications de niche. Par exemple, une étude de l'université de Stanford a révélé que les LLM produisaient des informations inexactes ou fausses dans 69 % à 88 % des cas lorsqu'ils étaient appliqués à des scénarios juridiques. Sans connaissances de domaine personnalisées, ces modèles peuvent halluciner ou fabriquer des réponses, ce qui entraîne des résultats peu fiables.

Pour relever ces défis, les organisations doivent se concentrer sur quelques stratégies clés :

Des exemples concrets illustrent l'impact de ces pratiques. Amazon, par exemple, utilise l'IA contextuelle pour analyser le comportement des utilisateurs, comme l'historique de navigation et les habitudes d'achat, afin de proposer des recommandations de produits personnalisées. De même, Woebot applique l'IA contextuelle pour fournir un soutien en temps réel en matière de santé mentale en analysant les entrées des utilisateurs et en proposant des stratégies d'adaptation personnalisées.

L'évolution de l'IA contextuelle redéfinit la manière dont les organisations mettent en œuvre et optimisent ces systèmes. L'un des changements les plus notables est la transition d'une ingénierie rapide à ingénierie du contexte. Cette approche vise à fournir les bonnes informations et les bons outils au bon moment, plutôt que de créer des instructions parfaites.

Tobi Lütke, PDG de Shopify, décrit l'ingénierie du contexte comme suit :

« C'est l'art de fournir tout le contexte nécessaire pour que la tâche puisse être résolue de manière plausible par le LLM. »

Andrej Karpathy, ancien Tesla Le directeur de l'IA partage ce sentiment en déclarant :

« +1 pour « ingénierie du contexte » par rapport à « ingénierie rapide ». »

La normalisation gagne également du terrain, avec des cadres tels que Protocole de contexte modèle (MCP) émergeant pour structurer plus efficacement les informations contextuelles. Ces normes améliorent l'interopérabilité entre les systèmes d'IA et simplifient l'intégration.

Parmi les autres développements intéressants, citons :

Des rôles spécialisés, tels que ingénieurs de contexte, prennent également de plus en plus d'importance. Christian Brown, technologue juridique, souligne leur importance :

« L'ingénierie contextuelle fait des LLM de véritables partenaires agentiques. »

La sécurité est une autre préoccupation croissante. Par exemple, les chercheurs du Université de Toronto a découvert des vulnérabilités dans les GPU NVIDIA en juillet 2025, soulignant la nécessité de renforcer les protections dans les systèmes sensibles au contexte.

Les normes d'interopérabilité évoluent pour permettre une intégration fluide entre les différentes plateformes d'IA. Des plateformes comme prompts.ai, qui permettent d'accéder à plusieurs LLM via une interface unique, démontrent l'intérêt d'unifier les flux de travail.

Ces tendances laissent présager un avenir où l'IA contextuelle sera plus automatisée, sécurisée et capable de gérer des scénarios complexes du monde réel avec une plus grande fiabilité.

Les systèmes d'IA sensibles au contexte, alimentés par de grands modèles linguistiques, redéfinissent la façon dont les entreprises abordent la prise de décision et l'automatisation. Contrairement aux robots traditionnels basés sur des règles, ces systèmes apportent une intelligence dynamique, s'adaptent à des scénarios complexes et réels et fournissent des résultats mesurables.

Le fondement de ces systèmes réside dans leur capacité à vraiment comprendre le contexte unique d'une entreprise. Comme le dit très justement Aakash Gupta :

« L'ingénierie du contexte représente la prochaine évolution du développement de l'IA, en allant au-delà des instructions statiques pour adopter des systèmes dynamiques et sensibles au contexte capables de comprendre et de répondre à toute la complexité des interactions du monde réel. »

Des secteurs tels que la santé et la finance connaissent déjà des gains de productivité et des réductions de coûts notables, ce qui met en évidence l'impact de ces systèmes avancés. En fait, plus de 67 % des organisations du monde entier utilisent désormais des outils d'IA génératifs alimentés par des LLM, les experts prédisant des contributions encore plus importantes dans divers secteurs.

Adopter ingénierie du contexte devient une nécessité pour les organisations qui souhaitent surmonter les problèmes de fiabilité et d'évolutivité qui affectent depuis longtemps l'IA traditionnelle. Cette approche permet de résoudre ces problèmes persistants, en garantissant des performances plus constantes et en réduisant les défaillances du système.

Pour transformer ces informations en stratégies exploitables, les entreprises devraient commencer par des projets pilotes qui mettent en valeur la valeur des fonctionnalités contextuelles. En se concentrant sur un aspect essentiel de l'ingénierie du contexte qui répond à leurs besoins les plus urgents, les entreprises peuvent créer des systèmes qui sont non seulement efficaces aujourd'hui, mais également suffisamment flexibles pour évoluer en fonction de l'évolution des besoins.

Les solutions centralisées sont essentielles pour gérer les complexités de l'IA contextuelle. Des plateformes telles que prompts.ai simplifient ce processus en donnant accès à plus de 35 LLM de premier plan via une interface unique. Ces plateformes incluent également des contrôles des coûts et des outils de gouvernance intégrés, aidant les organisations à éviter les inefficacités liées à la gestion de plusieurs outils. Grâce à un modèle de paiement à l'utilisation et à un suivi transparent des jetons, les entreprises peuvent contrôler leurs dépenses liées à l'IA tout en surveillant clairement les habitudes d'utilisation.

L'orientation du marché met en évidence l'importance stratégique d'une intégration fluide du contexte et de l'IA. Les systèmes d'IA sensibles au contexte ne sont plus facultatifs : ils deviennent une infrastructure essentielle pour les entreprises qui souhaitent garder une longueur d'avance. Investir dans une ingénierie contextuelle robuste permet désormais aux organisations de tirer pleinement parti du potentiel de l'IA et de s'assurer un avantage concurrentiel durable. Il ne s'agit pas simplement d'une mise à niveau technologique ; c'est la base des entreprises de demain.

Les systèmes d'IA sensibles au contexte utilisent des données en temps réel et une compréhension de situations spécifiques pour prendre des décisions plus intelligentes dans des domaines tels que la santé et la finance. En analysant des modèles de données complexes et en adaptant leurs réponses à des scénarios uniques, ces systèmes stimulent précision, efficacité, et personnalisation.

Prenons l'exemple des soins de santé. Ces outils d'IA peuvent aider à diagnostiquer les maladies, à élaborer des plans de traitement et à gérer la santé de l'ensemble de la population. Pour ce faire, ils prennent en compte des facteurs tels que les antécédents médicaux du patient, le cadre clinique et l'état de santé actuel. Dans le domaine de la finance, l'IA contextuelle joue un rôle clé dans la détection des fraudes, l'évaluation des risques et l'adaptation aux évolutions du marché, permettant ainsi des informations financières plus rapides et plus précises.

En dotant les professionnels de meilleurs outils pour prendre des décisions éclairées, ces systèmes permettent de gagner du temps, de minimiser les erreurs et d'améliorer les résultats tant pour les individus que pour les organisations.

Les entreprises sont confrontées à de nombreux obstacles lorsqu'elles tentent de mettre en œuvre des systèmes d'IA sensibles au contexte. Ces défis incluent le traitement d'informations contextuelles fragmentées ou incomplètes, la garantie de l'accès à des données pertinentes de haute qualité, la gestion des coûts souvent élevés liés au déploiement de technologies d'IA avancées, la résolution des pénuries d'expertise en IA et la résolution des complexités liées à l'intégration de ces systèmes aux infrastructures existantes.

Pour surmonter ces obstacles, les entreprises doivent se concentrer sur quelques stratégies clés. Commencez par construire des pratiques robustes de gestion des données pour garantir l'exactitude et l'accessibilité des informations. Investissez dans une infrastructure à la fois évolutive et adaptable pour répondre à l'évolution des besoins. Etablir des politiques de gouvernance claires pour guider la manière dont l'IA est utilisée de manière responsable. En plus de cela, mettez l'accent programmes de formation continue pour les employés pour combler les lacunes en matière de compétences et encourager la collaboration entre les départements. Ces étapes peuvent ouvrir la voie à une mise en œuvre plus fluide et à un succès durable.

L'ingénierie du contexte implique la création d'un environnement d'information complet pour un système d'IA. Cela implique de doter l'IA de toutes les connaissances de base et de toutes les ressources dont elle a besoin pour fonctionner efficacement. D'autre part, l'ingénierie rapide consiste à élaborer des instructions précises pour une seule interaction avec l'IA.

Pour les entreprises, l'ingénierie du contexte joue un rôle essentiel dans l'amélioration des performances de l'IA. Il aide à minimiser les erreurs, comme les hallucinations, et favorise une prise de décision plus précise et plus fiable. En créant un contexte plus riche et plus pertinent, les entreprises peuvent obtenir de meilleurs résultats et exploiter toutes les capacités des systèmes d'IA.