يعمل تنسيق نموذج الذكاء الاصطناعي على تبسيط إدارة عمليات سير العمل والأدوات والأتمتة، ولكن يمكن أن تتراكم التكاليف بسرعة. إليك كيفية توفير ما يصل إلى 98% على نفقات برامج الذكاء الاصطناعي مع ضمان قابلية التوسع والتوافق والأداء. لقد قمنا بمراجعة سبع منصات - Prompts.ai، فلايت، تدفق الهواء، حاكم، لانج تشين، رون بود، و كيوبيفلو - التركيز على التسعير والميزات وآليات توفير التكاليف.

الوجبات السريعة الرئيسية:

مقارنة سريعة:

الاستنتاج:

من أجل التوفير في التكاليف والبساطة، Prompts.ai تقدم قيمة لا مثيل لها من خلال أسعار الدفع أولاً بأول والميزات على مستوى المؤسسة. فلايت و كيوبيفلو يؤدي إلى مرونة المصدر المفتوح، بينما رون بود يتفوق في الوصول إلى GPU بأسعار معقولة. اختر النظام الأساسي الذي يتوافق مع خبرة فريقك واحتياجات المشروع.

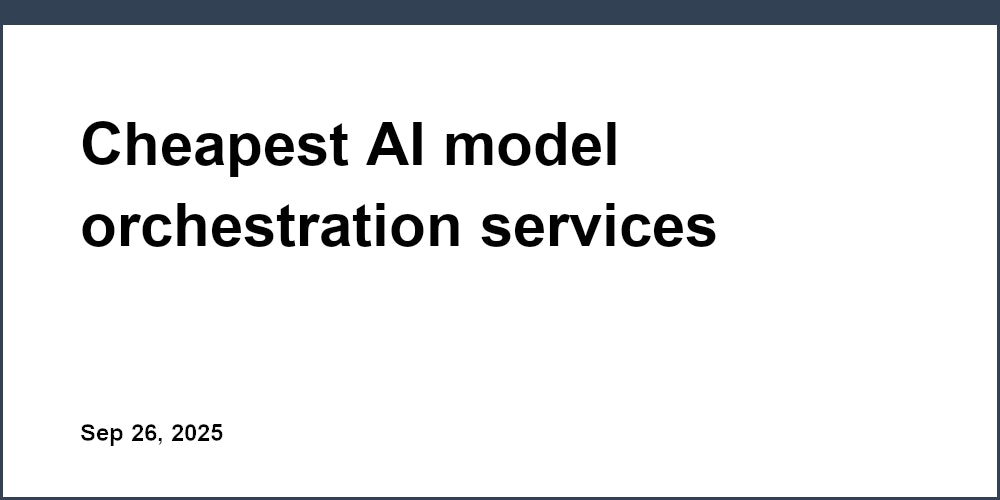

تبرز Prompts.ai كملف منصة تنسيق الذكاء الاصطناعي على مستوى المؤسسات، يجمع أكثر من 35 نموذجًا لغويًا رائدًا في نظام بيئي واحد آمن. تم تصميمه لمعالجة فوضى إدارة أدوات الذكاء الاصطناعي المتعددة من خلال توفير وصول موحد إلى نماذج مثل GPT-4 و Claude و LLama و Gemini، كل ذلك مع الالتزام ببروتوكولات الأمان والحوكمة الصارمة على مستوى المؤسسة.

يستخدم ملف Prompts.ai ملف نظام ائتمان TOKN للدفع أولاً بأول، وإلغاء الرسوم المتكررة والسماح للمستخدمين بالدفع فقط مقابل الرموز التي يستخدمونها. يحل هذا النهج محل تراخيص المقاعد الشهرية التقليدية ويبسط التكاليف التي يمكن توزيعها عبر العديد من اشتراكات الذكاء الاصطناعي.

بالنسبة للمستخدمين الفرديين، توفر المنصة خيارات مرنة:

بالنسبة للشركات، يتم تحديد مقاييس الأسعار لتلبية احتياجات الفريق:

يمكن لنظام الائتمان الموحد هذا تقليل نفقات برامج الذكاء الاصطناعي بنسبة تصل إلى 98٪، مقارنة بإدارة اشتراكات منفصلة متعددة.

يدمج Prompts.ai أكثر من 35 نموذجًا لغويًا رائدًا - مثل GPT-5 و Grok-4 و Claude و Llama و Gemini و Flux Pro و Kling - في منصة واحدة. هذا يزيل متاعب التوفيق بين أدوات متعددة أو الحفاظ على تكامل API الفردي لنماذج مختلفة.

تشمل الميزات الرئيسية ما يلي:

يقدم ملف Prompts.ai ملف النشر المستند إلى السحابة يعمل ذلك على تبسيط عملية الإعداد، مما يسمح للمؤسسات بدمج النماذج والمستخدمين والفرق الجديدة في غضون دقائق. تتعامل المنصة مع إدارة البنية التحتية وأتمتة تحديثات النماذج والتوسع دون عناء لتلبية الطلبات المتزايدة.

بالإضافة إلى ذلك، تدعم المنصة عمليات تكامل المؤسسة عبر واجهات برمجة التطبيقات وخطافات الويب، مما يجعل من السهل دمجها في عمليات سير العمل وأنظمة الأعمال الحالية دون الحاجة إلى تغييرات فنية كبيرة. تساهم خيارات النشر هذه بشكل مباشر في توفير التكاليف التشغيلية.

تم تصميم Prompts.ai مع وضع الكفاءة في الاعتبار، حيث يقدم عدة طرق لتقليل النفقات التشغيلية. إحدى ميزاته البارزة هي قدرته على القضاء على تمدد الأدوات. من خلال دمج اشتراكات الذكاء الاصطناعي المتعددة في منصة واحدة، يمكن للشركات تجنب التكاليف المرتبطة بالحفاظ على خدمات مثل ChatGPT Plus أو Claude Pro.

تشمل ميزات توفير التكاليف الأخرى ما يلي:

يضمن Prompts.ai الامتثال الصارم خلال عناصر التحكم في الوصول المستندة إلى الأدوار وأدوات المراقبة الشاملة. يمكن للمسؤولين تعيين الأذونات وتعيين حدود الإنفاق وتقييد الوصول إلى نماذج محددة وفرض سياسات الاستخدام - كل ذلك مع الحفاظ على المرونة التشغيلية. يوفر إطار الحوكمة هذا للمؤسسات الأدوات التي تحتاجها لإدارة الذكاء الاصطناعي بمسؤولية دون المساس بالإنتاجية.

يعمل فلايت بمثابة منصة تنسيق سير العمل مفتوحة المصدر مصممة خصيصًا لعلوم البيانات والتعلم الآلي وأعباء عمل الذكاء الاصطناعي. تم إنشاؤه في البداية بواسطة ليفت لمواجهة تحديات معالجة البيانات واسعة النطاق، تعمل Flyte على تمكين المؤسسات من تصميم ونشر وإدارة خطوط أنابيب الذكاء الاصطناعي المعقدة دون تكبد تكاليف البرامج الاحتكارية.

إن هيكل تسعير Flyte متجذر في طبيعة المصدر المفتوح. يتوفر كل من Flyte 1 الحالي و Flyte 2.0 القادم مجانًا، مما يوفر حلاً مناسبًا للميزانية لإنشاء خطوط أنابيب AI/ML يمكن الاعتماد عليها. يتم استكمال هذه القدرة على تحمل التكاليف من خلال تصميم قوي موجه نحو عمليات سير عمل الذكاء الاصطناعي القابلة للتطوير.

تم تصميم نظام Flyte لدعم عمليات سير العمل القابلة للتكرار والقابلة للتطوير. يعمل كل سير عمل كرسم بياني غير دوري موجه (DAG)، يتتبع بدقة المدخلات والمخرجات واستخدام الموارد - وهي عناصر أساسية لتطوير النموذج التكراري.

تعمل المنصة على تبسيط إدارة الموارد من خلال تخصيص الموارد تلقائيًا بناءً على احتياجات المهام. كما أنه يدعم خيارات السحابة الفعالة من حيث التكلفة، بما في ذلك AWS و Google Cloud Platform. من خلال عمليات الدمج الأصلية للأطر الشائعة مثل TensorFlow و PyTorch، يسمح Flyte لعلماء البيانات بالتركيز أكثر على تحسين النماذج وبدرجة أقل على مخاوف البنية التحتية.

يتميز Flyte بتعدد الاستخدامات العالية، حيث يدعم عمليات النشر متعددة السحابات والهجينة. يتم تشغيله بسلاسة على مجموعات Kubernetes عبر AWS ومنصة Google Cloud Platform و Microsoft Azure وحتى الإعدادات المحلية. تتيح هذه المرونة للمؤسسات اختيار موارد الحوسبة الأكثر تكلفة لتتناسب مع متطلبات عبء العمل.

يتم تنفيذ كل مهمة في Flyte داخل الحاوية المعزولة الخاصة بها، مما يضمن الأداء المتسق عبر البيئات المختلفة. يعمل التحجيم التلقائي لـ Kubernetes على تحسين الكفاءة من خلال تعديل استخدام الموارد ديناميكيًا حسب الحاجة.

يتضمن Flyte العديد من الاستراتيجيات لتقليل النفقات. يتيح تكامل المثيل الفوري استخدام موارد الحوسبة منخفضة التكلفة للمهام غير الحرجة، مع آليات مدمجة للتعامل مع الانقطاعات عن طريق التحقق من التقدم والاستئناف بسلاسة على الموارد البديلة.

يعمل التخزين المؤقت لسير العمل على التخلص من الحسابات الزائدة عن طريق إعادة استخدام النتائج السابقة، بينما يسمح تجميع الموارد لفرق متعددة بمشاركة البنية التحتية بكفاءة. بالإضافة إلى ذلك، تساعد أدوات المراقبة الخاصة بالمنصة الفرق على تحديد فرص التحسين، مما يضمن التحكم في التكاليف وإدارة الموارد بشكل أفضل.

تدفق هواء أباتشي تبرز باعتبارها أداة رائدة مفتوحة المصدر لتنظيم عمليات سير عمل الذكاء الاصطناعي المعقدة. تم تطويره بواسطة Airbnb في عام 2014 لتلبية احتياجات خطوط أنابيب البيانات المتزايدة، نمت Airflow منذ ذلك الحين لتصبح حلاً موثوقًا به على نطاق واسع عبر الصناعات. إن قدرتها على تحقيق التوازن بين الأداء القوي وكفاءة التكلفة تجعلها خيارًا مثاليًا للمؤسسات التي تدير تدفقات عمل نموذج الذكاء الاصطناعي بميزانية محدودة.

تدفق الهواء هو مجاني تمامًا ومفتوح المصدر، تعمل بموجب ترخيص Apache 2.0. وهذا يعني أن التكاليف الوحيدة المتضمنة هي تلك المرتبطة بالبنية التحتية التي تعمل عليها، مثل موارد الحوسبة السحابية والتخزين والشبكات. بالنسبة للمؤسسات التي تتطلع إلى تبسيط النفقات العامة والخدمات المُدارة مثل أمازون ماوا و غوغل كلاود كومبوسر تقديم تسعير بنظام الدفع أولاً بأول، مما يضمن نفقات يمكن التنبؤ بها مع التخلص من الحاجة إلى إدارة البنية التحتية بشكل مباشر.

تجمع Airflow بين القدرة على تحمل التكاليف ومجموعة من الميزات المصممة لتبسيط إدارة سير العمل. في جوهرها، تسمح للمستخدمين بما يلي: تعريف عمليات سير العمل ككود باستخدام بايثون. تقدم عمليات سير العمل هذه، والمعروفة باسم الرسوم البيانية غير الدورية الموجهة (DAGs)، تمثيلًا مرئيًا واضحًا لتبعيات المهام ومسارات التنفيذ - وهي ضرورية للتنقل في خطوط أنابيب الذكاء الاصطناعي المعقدة.

تتضمن المنصة أيضًا مكتبة واسعة من المشغلين والخطافات، مما يتيح التكامل السلس مع أدوات الذكاء الاصطناعي الشائعة والخدمات السحابية. إن الدعم المدمج لأطر العمل مثل TensorFlow و PyTorch و Scikit-Learn، بالإضافة إلى المنصات السحابية مثل AWS و Google Cloud و Azure، يلغي الحاجة إلى ترميز التكامل المخصص.

تدفق الهواء قدرات الجدولة هي ميزة بارزة أخرى. يمكن للفرق أتمتة العمليات الأساسية مثل التدريب النموذجي والتحقق والنشر. من خلال عمليات إعادة المحاولة التلقائية للمهام وإشعارات الفشل ومعالجة التبعية، يقلل Airflow من عبء العمل التشغيلي لفرق الذكاء الاصطناعي، مما يضمن تنفيذًا أكثر سلاسة.

يتسم تدفق الهواء بتعدد الاستخدامات عندما يتعلق الأمر بالنشر. يمكن تشغيله على جهاز واحد أو مجموعة أو داخل بيئات Kubernetes. تضمن ميزات مثل التحجيم التلقائي والنقل بالحاويات أن تكون عمليات النشر فعالة ومتسقة. تعمل الإعدادات المستندة إلى السحابة على تحسين إدارة التكلفة، مما يسمح للفرق بتعديل موارد الحوسبة ديناميكيًا، واستخدام مثيلات Spot للمهام الأقل أهمية، والنشر عبر مناطق متعددة للحصول على أداء وموثوقية أفضل.

المنصة تصميم حاويات يضمن بيئات موحدة، ويقلل من تصحيح الأخطاء الناتجة عن التناقضات. لا يوفر هذا الأسلوب الوقت فحسب، بل يقلل أيضًا من استخدام الموارد غير الضرورية، مما يحافظ على انخفاض التكاليف.

يوفر Airflow العديد من الأدوات لمساعدة المؤسسات على إدارة التكاليف وخفضها. إنشاء المهام الديناميكية يضمن تشغيل عمليات سير العمل فقط عندما تكون البيانات متاحة أو عند استيفاء الشروط الخارجية، مما يؤدي إلى تجنب إهدار الموارد على المدخلات غير المكتملة.

إنها نظام إدارة التجمع وقائمة الانتظار يحسن تخصيص الموارد. على سبيل المثال، يمكن للفرق تحديد مجموعات محددة للمهام التي تتطلب مثيلات GPU باهظة الثمن، مما يضمن استخدامها فقط عند الضرورة. وفي الوقت نفسه، يمكن للمهام الأخف استخدام موارد الحوسبة القياسية، مما يزيد من الكفاءة.

يوفر تدفق الهواء أيضًا أدوات مراقبة مفصلة عبر واجهة المستخدم المستندة إلى الويب. يمكن للفرق تتبع حالات المهام في الوقت الفعلي وأوقات التنفيذ واستخدام الموارد وتحديد الاختناقات ومجالات التحسين. تعمل ميزات مثل التجميع والموازاة على تحسين الكفاءة من خلال إعادة استخدام اتصالات قاعدة البيانات وتشغيل المهام المستقلة في وقت واحد، مما يقلل من وقت التنفيذ الإجمالي.

يوفر Prefect خيارين لتنسيق سير العمل: بريفكت كور، وهو عرض مفتوح المصدر ومجاني، و سحابة مثالية، وهو حل تجاري مستضاف على السحابة. يخدم هذا الإعداد كلاً من المطورين الفرديين والفرق التي تعمل بشكل تعاوني.

على الرغم من أن Prefect Core مجاني، إلا أنه لا يتضمن ميزات متقدمة موجهة نحو الفريق مثل إدارة المستخدم أو سجلات التدقيق. تقدم Prefect Cloud العديد من مستويات التسعير، بدءًا من خطة Hobby المجانية التي تدعم ما يصل إلى 2 مستخدم ومساحة عمل واحدة. تشمل الخطط المدفوعة مستويات المبتدئين والفريق والمحترفين والمؤسسة، مما يلبي الاحتياجات التنظيمية المختلفة. بالنسبة للسياق، تنفق بعض المؤسسات حوالي 30,000 دولار سنويًا لـ 5-10 مستخدمين، مما يجعل من الضروري للفرق الموازنة بين فوائد الخدمة المستضافة وتكلفتها.

تقدم LangChain مزيجًا فريدًا من إمكانية الملاحظة وتنسيق سير العمل، مما يوفر حلاً مبسطًا لإدارة نماذج الذكاء الاصطناعي. باستخدام أدوات مثل لانج سميث من أجل الملاحظة و لانغ غراف لتنسيق سير العمل، فإنه يركز على تقديم حلول فعالة من حيث التكلفة لسير عمل الذكاء الاصطناعي.

تستخدم LangChain هيكل تسعير متدرج لاستيعاب احتياجات المستخدمين المختلفة:

توفر هذه الخيارات المرونة للمطورين والمؤسسات، مما يجعل LangChain قابلاً للتكيف مع أحجام وميزانيات المشاريع المختلفة.

تجمع منصة LangChain بين أدوات التطوير والإشراف التشغيلي لإنشاء حل شامل:

من خلال دمج إمكانية الملاحظة مع إدارة سير العمل، توفر LangChain بيئة سلسة للفرق لتطوير نماذج الذكاء الاصطناعي واختبارها ونشرها بكفاءة.

تم تصميم هيكل تسعير LangChain لتقليل التكاليف مع زيادة المرونة إلى أقصى حد:

يضمن نهج LangChain أن كل من الأفراد والمؤسسات يمكنهم الوصول إلى أدوات قوية دون زيادة الإنفاق، بما يتماشى مع هدفها المتمثل في تقديم حلول ذكاء اصطناعي فعالة وقابلة للتطوير.

يوفر RunPod منصة GPU القائمة على السحابة مع نموذج تسعير مباشر يدفع أولاً بأول. يتيح هذا الإعداد للمستخدمين توسيع نطاق الموارد وفقًا لاحتياجاتهم، مما يضمن تحصيل الرسوم فقط مقابل ما يستخدمونه بالفعل. من خلال إزالة متطلبات الالتزامات طويلة الأجل، يصبح RunPod حلاً ميسور التكلفة للتعامل مع أعباء عمل الذكاء الاصطناعي المكثفة. إن هيكل التسعير والمرونة الخاص بها يجعلها منافسًا قويًا في مجال تنسيق الذكاء الاصطناعي، مما يمهد الطريق لمقارنة أعمق مع Kubeflow لتقييم ميزات التنسيق وإدارة التكاليف.

Kubeflow عبارة عن منصة مفتوحة المصدر مصممة لإدارة تدفقات عمل التعلم الآلي (ML) مع الحفاظ على التكاليف تحت السيطرة. تم تطويره في البداية بواسطة Google، وهو يوفر أدوات قوية لتنظيم تدفقات عمل الذكاء الاصطناعي، والاستفادة من نموذج النشر المرن والميزات الموفرة للموارد لتقليل النفقات التشغيلية.

تعمل Kubeflow ضمن إطار مفتوح المصدر تمامًا، مما يعني عدم وجود رسوم ترخيص. بدلاً من ذلك، ترتبط التكاليف بالبنية التحتية الأساسية. عند النشر على الأنظمة الأساسية السحابية مثل Google Cloud Platform أو Amazon Web Services أو Microsoft Azure، تعتمد النفقات على عوامل مثل حجم الكتلة واستخدام الموارد. بالنسبة للمؤسسات التي لديها بنية Kubernetes الأساسية الحالية، يمكن أن تؤدي عمليات النشر المحلية إلى تقليل التكاليف بشكل أكبر، مما يحد من نفقات الأجهزة والصيانة.

على عكس النماذج التي تتقاضى رسومًا لكل مستخدم أو لكل نموذج، فإن هيكل تكلفة Kubeflow مرتبط فقط باستخدام البنية التحتية، مما يجعله خيارًا قابلاً للتطوير وصديقًا للميزانية للعديد من المؤسسات.

يبسط Kubeflow تنسيق عمليات سير عمل التعلم الآلي باستخدام أدوات مثل خطوط أنابيب Kubeflow ودفاتر Jupyter و Katib و KfServing.

تعتبر المنصة فعالة بشكل خاص لإدارة عمليات سير العمل المعقدة التي تتضمن مراحل متعددة، مثل المعالجة المسبقة للبيانات والتدريب النموذجي والنشر. يضمن إصدار خطوط الأنابيب الخاص به إمكانية تتبع التجارب وتكرارها، بينما توفر أدوات المراقبة رؤى حول استخدام الموارد وأداء النموذج طوال دورة حياة التعلم الآلي.

تقدم Kubeflow خيارات نشر مرنة لتناسب الاحتياجات المختلفة. وهو يتكامل بسلاسة مع الخدمات المُدارة مثل محرك جوجل كوبيرنيتيس وأمازون EKS وخدمة أزور كوبيرنيتيس. بالنسبة للمؤسسات التي تفضل الحلول المحلية، يدعم Kubeflow النشر باستخدام أدوات مثل kubeadm أو منصات المؤسسات مثل Red Hat OpenShift.

بالنسبة للفرق التي تستكشف المنصة، تتوفر خيارات خفيفة مثل MiniKF للتطوير والاختبار المحليين. تسمح عمليات النشر الصغيرة هذه لعلماء البيانات بتجربة Kubeflow قبل الانتقال إلى الإنتاج على نطاق واسع، مما يقلل من المخاطر الأولية والاستثمار.

يتضمن Kubeflow العديد من الميزات التي تهدف إلى تحسين التكاليف:

تساعد هذه الاستراتيجيات، جنبًا إلى جنب مع ميزات الامتثال الخاصة بالمنصة، المؤسسات على زيادة عائد الاستثمار إلى أقصى حد.

يعالج Kubeflow متطلبات الامتثال للمؤسسات من خلال الاستفادة من ميزات الأمان المضمنة في Kubernetes. وهو يدعم التحكم في الوصول المستند إلى الأدوار (RBAC) لإدارة الأذونات ويتكامل مع موفري هوية المؤسسة من خلال مصادقة OIDC.

تقوم سجلات التدقيق بتتبع نشاط المنصة، مما يساعد على الامتثال للوائح مثل GDPR و HIPAA. بالإضافة إلى ذلك، تضمن حصص الموارد والسياسات التخصيص العادل للموارد عبر الفرق والمشاريع، مما يجعل Kubeflow خيارًا قويًا للمنظمات في الصناعات المنظمة.

تأتي كل منصة بمجموعة المزايا والتحديات الخاصة بها. يعد فهم هذه المقايضات أمرًا ضروريًا لضمان توافق اختيارك مع ميزانيتك واحتياجاتك الفنية وأهدافك التشغيلية.

Prompts.ai تتميز بتركيزها على كفاءة التكلفة والحوكمة على مستوى المؤسسة. من خلال الوصول الموحد إلى نماذج متعددة وإمكانيات FinOps في الوقت الفعلي، فإنه يتيح توفيرًا كبيرًا في التكاليف مع الحفاظ على التحكم الصارم في عمليات النشر. ومع ذلك، بالنسبة للمشاريع الصغيرة أو المبكرة، قد تبدو ميزات المؤسسة الشاملة مفرطة.

فلايت يتفوق في إدارة عمليات سير العمل المعقدة والمليئة بالبيانات، مع إعطاء الأولوية للتكرار والكفاءة. يعد التخزين المؤقت وتحسين الموارد مفيدًا بشكل خاص للمهام المتكررة. ومع ذلك، فإن الفرق التي لا تتمتع بخبرة قوية في بايثون قد تعاني من منحنى التعلم الخاص بها، ويمكن أن تكون متطلبات البنية التحتية الخاصة بها عملية.

تدفق الهواء يستفيد من نظام بيئي راسخ ومجموعة واسعة من عمليات الدمج. تسمح بنيتها المرنة بالاتصالات السلسة لمختلف الأدوات والخدمات. على الجانب السلبي، غالبًا ما يتطلب الحفاظ على مجموعات Airflow وإدارة التبعيات موارد DevOps المخصصة، والتي يمكن أن تزيد من التعقيد التشغيلي.

حاكم يتبع نهجًا صديقًا للمطورين من خلال تصميمه البديهي الأصلي لبيثون ونموذج التنفيذ المختلط. إنها جذابة بشكل خاص لإدارة سير العمل وقدرات معالجة الأخطاء. ومع ذلك، فإن نظامها البيئي الأحدث نسبيًا يعني عددًا أقل من عمليات تكامل الجهات الخارجية مقارنة بالمنصات الأكثر نضجًا.

لانج تشين يوفر مرونة لا مثيل لها لإنشاء تطبيقات الذكاء الاصطناعي المخصصة، ودعم عمليات تكامل النماذج المختلفة وسير العمل الإبداعي. في حين أن هذه القدرة على التكيف تشجع التجريب، فإن التطور المستمر للإطار يمكن أن يؤدي أحيانًا إلى مشكلات الاستقرار. قد تتطلب عمليات نشر الإنتاج أيضًا أدوات إضافية للمراقبة والحوكمة.

رون بود يعمل على تبسيط الوصول إلى وحدة معالجة الرسومات (GPU) بأسعار تنافسية، مما يجعلها مثالية لمهام التدريب التي تتطلب الكثير من الحوسبة. يتجنب إعداده المباشر تعقيدات إدارة البنية التحتية. ومع ذلك، فإنه يفتقر إلى ميزات التنسيق المضمنة، مما يجعله أقل ملاءمة لإدارة خطوط أنابيب الذكاء الاصطناعي المعقدة.

كيوبيفلو يوفر إدارة سير عمل التعلم الآلي على مستوى المؤسسة، مع الاستفادة من Kubernetes للتوسع الفعال وتكامل بيئة الحاويات. نموذج الترخيص المجاني الخاص بها هو ميزة كبيرة. ومع ذلك، فإن تحقيق أقصى استفادة من Kubeflow يتطلب خبرة عميقة في Kubernetes، ويمكن أن تكون ميزاته الشاملة مفرطة من أجل سير عمل أبسط. هذه العوامل تجعل من الضروري مواءمة تعقيد المنصة مع احتياجاتك الخاصة.

يقدم الجدول أدناه مقارنة سريعة لنقاط القوة والضعف الرئيسية لكل منصة:

تختلف هياكل التكلفة بشكل كبير بين هذه المنصات. Prompts.ai و كيوبيفلو تتميز بمزاياها الاقتصادية - Prompts.ai من خلال تحسين التكلفة والوصول الموحد إلى النموذج، و Kubeflow بنموذج الترخيص المجاني الخاص بها. رون بود يقدم قيمة كبيرة لاحتياجات الحوسبة الثقيلة، بينما تدفق الهواء و حاكم تتطلب تخطيطًا دقيقًا لإدارة النفقات التشغيلية بفعالية.

تختلف الإجراءات الأمنية عبر المنصات. Prompts.ai يدمج مسارات الحوكمة والتدقيق على مستوى المؤسسة، بينما كيوبيفلو يستفيد من ميزات الأمان المضمنة في Kubernetes. من ناحية أخرى، لانج تشين و رون بود قد تحتاج إلى طبقات أمان إضافية لتلبية متطلبات المؤسسة. من أجل تدفق الهواء، يعتمد الأمان بشكل كبير على كيفية تنفيذ النظام الأساسي وتكوينه.

عندما يتعلق الأمر بالتوسع، فإن المنصات القائمة على Kubernetes مثل كيوبيفلو ومهيأة بشكل جيد تدفق الهواء يمكن للإعدادات التعامل مع عمليات النشر واسعة النطاق، على الرغم من أنها تتطلب خبرة فنية لتحقيق الأداء الأمثل. Prompts.ai يبسط التحجيم من خلال استخلاص الكثير من التعقيد، بينما حاكم يوفر خيارات توسيع مرنة دون الحاجة إلى ملكية البنية التحتية الكاملة.

يعتمد اختيار النظام الأساسي المناسب على حجم مؤسستك وميزانيتها وخبرتها الفنية. استنادًا إلى تحليلنا، حددنا خيارات واضحة مصممة خصيصًا لتلبية الاحتياجات التشغيلية المختلفة، بدءًا من كفاءة التكلفة على مستوى المؤسسة إلى الأدوات المصممة لفرق التطوير الرشيقة.

للمؤسسات التي تركز على التحكم في التكاليف، Prompts.ai تبرز باعتبارها الخيار الأكثر فعالية. فهو يجمع بين التوفير الكبير في التكاليف والوصول الموحد إلى نماذج الذكاء الاصطناعي المتعددة وقدرات FinOps في الوقت الفعلي. يضمن نظام TOKN الائتماني للدفع أولاً بأول الدفع مقابل ما تستخدمه فقط، مما يجعله مثاليًا للمؤسسات التي تهدف إلى إدارة نفقات الذكاء الاصطناعي دون التضحية بالوظائف. بالإضافة إلى ذلك، فإن ميزات الحوكمة والأمان الخاصة بـ Prompts.ai على مستوى المؤسسات تجعلها منافسًا قويًا للصناعات الأكبر والمنظمة.

قد تجد المنظمات ذات الخبرة القوية في Kubernetes كيوبيفلو جذاب. كمنصة مفتوحة المصدر، فإنها توفر ميزات على مستوى المؤسسة دون رسوم ترخيص. ومع ذلك، فإنها تتطلب بنية تحتية قوية لـ Kubernetes وخبرة فنية، مما يجعلها مناسبة بشكل أفضل للفرق الكبيرة المألوفة بالفعل بـ Kubernetes.

بالنسبة للفرق التي تحتاج إلى وصول فعال من حيث التكلفة إلى وحدات معالجة الرسومات لأحمال العمل التدريبية كثيفة الحوسبة، رون بود يقدم حلاً عمليًا. على الرغم من أنها تفتقر إلى ميزات التنسيق المتقدمة، إلا أن أسعارها التنافسية وإعدادها المباشر تجعلها خيارًا جيدًا للتدريب النموذجي.

إذا كانت سهولة التطوير والتجريب هي أولويتك، حاكم يوفر نهج Python الأصلي الذي سيقدره العديد من المطورين. ومع ذلك، ينبغي للمنظمات أن تضع في اعتبارها تكاليفها التشغيلية. وبالمثل، لانج تشين تتفوق في عمليات سير العمل التجريبية والإبداعية، على الرغم من أن كلاً من Prefect و LangChain يتطلبان غالبًا أدوات إضافية لبيئات الإنتاج.

بالنسبة للمؤسسات ذات البنية التحتية لـ DevOps الراسخة، تدفق الهواء لا يزال خيارًا موثوقًا به. ومع ذلك، فإن متطلبات تعقيدها وصيانتها قد تجعلها أقل جاذبية للفرق الصغيرة أو تلك التي ليس لديها دعم فني مخصص.

في نهاية المطاف، Prompts.ai يوفر أفضل قيمة إجمالية لمعظم المؤسسات، خاصة تلك التي تدير العديد من مشاريع الذكاء الاصطناعي. إن قدرتها على خفض التكاليف وتوفير وصول موحد للنماذج والحفاظ على معايير الأمان والامتثال الصارمة تجعلها مفيدة بشكل خاص للمؤسسات الكبيرة والصناعات المنظمة.

بالنسبة للفرق الصغيرة، يعتمد الاختيار على احتياجاتك الخاصة. رون بود مثالي لمشاريع الحوسبة الثقيلة، كيوبيفلو يعمل جيدًا إذا كان لديك خبرة في Kubernetes، و حاكم يناسب عمليات سير العمل المرتكزة على بايثون. ومع ذلك، قد ترغب حتى المؤسسات الصغيرة في استكشاف خطة Creator الخاصة بـ Prompts.ai بسعر 29 دولارًا شهريًا فقط. توفر هذه الخطة وصولاً موحدًا إلى النماذج المتميزة بتكلفة مجمعة أقل من الحفاظ على اشتراكات فردية متعددة.

تستند المعلومات إلى نظرة عامة على النظام الأساسي الرسمي لـ Prompts.ai.

ال نظام TOKN للدفع أولاً بأول من Prompts.ai يخفض نفقات برامج الذكاء الاصطناعي بنسبة تصل إلى 98٪، وذلك بفضل ميزاته الذكية مثل التوجيه الديناميكي، تتبع التكلفة في الوقت الفعلي، و الفواتير القائمة على الاستخدام. باستخدام هذا النظام، تتم محاسبتك فقط على ما تستخدمه بالفعل، مما يساعد على تقليل نفايات الرموز مع تعزيز كفاءة عمليات سير عمل الذكاء الاصطناعي.

من خلال ضبط الاستخدام السريع والابتعاد عن التكاليف غير الضرورية، يقدم نظام TOKN نهجًا فعالاً من حيث التكلفة لإدارة عمليات الذكاء الاصطناعي - مما يوفر الأداء وقابلية التوسع دون إفلاس.

تقدم Prompts.ai حلول نشر متعددة الاستخدامات تتيح لك الوصول إلى أكثر من 35 نموذجًا للذكاء الاصطناعي، بما في ذلك جي بي تي -4، كلود، و لاما، كل ذلك ضمن منصة واحدة سهلة الاستخدام. إنها تسعير الدفع أولاً بأول يضمن التحكم في التكلفة مع تمكين تكامل النموذج بسهولة ومقارنات الأداء في الوقت الفعلي.

تعمل المنصة على تبسيط التكامل من خلال دعم الأدوات الشائعة مثل سلاك، Gmail، و تريلووتبسيط التشغيل الآلي وتحسين التعاون الجماعي. من خلال تقليل التحميل الزائد للأدوات وتمكين عمليات سير العمل القابلة للتطوير، يعد Prompts.ai خيارًا مثاليًا للمؤسسات، حيث يوفر الامتثال والحوكمة دون تعقيد غير ضروري.

تزيل Prompts.ai التخمين فيما يتعلق بالامتثال والحوكمة، وتزود الشركات بأدوات لتبسيط إدارة المخاطر، وتعزيز المساءلة، وتوسيع نطاق تدفقات عمل الذكاء الاصطناعي بشكل فعال. مع ميزات مثل تتبع الاستخدام في الوقت الفعلي، مسارات تدقيق مفصلة، و ضوابط التكلفة، يمكن للمؤسسات تلبية المعايير التنظيمية مع خفض التكاليف التشغيلية بما يصل إلى 98%.

تعمل هذه الأدوات على تمكين الشركات من دعم القيم الأساسية مثل الشفافية والأخلاق والمساءلة، كل ذلك مع تحسين التكاليف وضمان نمو عمليات الذكاء الاصطناعي الخاصة بها بسلاسة.