कई बड़े भाषा मॉडल (LLM) को प्रबंधित करना जटिल हो सकता है, लेकिन सही टूल इसे आसान बनाते हैं। प्लेटफ़ॉर्म जैसे Prompts.ai, अमेज़ॅन सेजमेकर, एज़्योर मशीन लर्निंग, हगिंग फेस ट्रांसफॉर्मर्स, धूमकेतु एमएल, और डीप लेक वर्कफ़्लो को सरल बनाएं, लागत कम करें और सुरक्षा में सुधार करें। यहां बताया गया है कि आपको क्या जानना चाहिए:

क्विक टेकअवे: अपनी टीम की ज़रूरतों के आधार पर टूल चुनें - चाहे वह लागत अनुकूलन हो, स्केलेबिलिटी हो, या सुरक्षा हो - यह सुनिश्चित करते हुए कि वे आपके बुनियादी ढांचे और लक्ष्यों के साथ संरेखित हैं।

Prompts.ai GPT-5, क्लाउड सहित 35 से अधिक शीर्ष स्तरीय AI मॉडल को एक साथ लाता है, लामा, और युग्म, एक एकल, एकीकृत मंच में। कई बड़े भाषा मॉडल (एलएलएम) के प्रबंधन की जटिलताओं को दूर करके, यह बिखरे हुए औजारों के कारण होने वाली अक्षमताओं को दूर करता है।

इसके साथ केंद्रीकृत शीघ्र प्रबंधन प्रणाली, Prompts.ai टीमों को विभिन्न मॉडलों में आसानी से प्रॉम्प्ट डिज़ाइन करने, परीक्षण करने और तैनात करने की अनुमति देता है। प्लेटफ़ॉर्म सहज संस्करण ट्रैकिंग सुनिश्चित करता है, जिससे AI वर्कफ़्लो में स्थिरता बनाए रखने में मदद मिलती है।

प्लेटफ़ॉर्म का वर्कफ़्लो ऑर्केस्ट्रेशन टूल स्वचालित पाइपलाइनों के माध्यम से मल्टी-एलएलएम प्रबंधन को सरल बनाएं। टीमें मॉडल आउटपुट की साथ-साथ तुलना कर सकती हैं, जिससे विशिष्ट कार्यों के लिए सबसे अच्छा प्रदर्शन करने वाले कॉन्फ़िगरेशन की पहचान करना आसान हो जाता है।

Prompts.ai भी फ्रेमवर्क के साथ आसानी से एकीकृत होता है जैसे लैंग चैन, हगिंग फेस, और वर्सेल एआई एसडीके, साथ ही क्लाउड सेवाएं जैसे AWS बेडरॉक और एज़्योर ओपनएआई। ये एकीकरण व्यापक तकनीकी समायोजन की आवश्यकता के बिना वर्कफ़्लो स्वचालन और मॉडल मूल्यांकन को सुव्यवस्थित करते हैं।

इन सुविधाओं से न केवल दक्षता में सुधार होता है बल्कि बेहतर लागत प्रबंधन और मजबूत सुरक्षा प्रोटोकॉल का मार्ग भी प्रशस्त होता है।

Prompts.ai डिलीवर करता है विस्तृत लागत ट्रैकिंग और एनालिटिक्स, वास्तविक समय में प्रत्येक एलएलएम के उपयोग और खर्चों को ट्रैक करने के लिए टोकन-स्तरीय निगरानी की पेशकश करना। AI टूल को समेकित करके, प्लेटफ़ॉर्म निम्नलिखित चीज़ों का दावा करता है 98% लागत बचत।

रीयल-टाइम डैशबोर्ड के माध्यम से, यूज़र लागत एट्रिब्यूशन के बारे में जानकारी प्राप्त करते हैं, जिससे अधिक कुशल प्रॉम्प्ट डिज़ाइन सक्षम होते हैं। इस पारदर्शिता से टीमें प्रदर्शन से समझौता किए बिना अपनी ज़रूरतों के लिए सबसे अधिक लागत प्रभावी मॉडल चुन सकती हैं। इसके अतिरिक्त, प्लेटफ़ॉर्म निर्धारित लागतों को स्केलेबल, ऑन-डिमांड खर्चों में बदल देता है, जिससे AI को अपनाना अधिक लचीला और प्रबंधनीय हो जाता है।

उदाहरण के लिए, एक वित्तीय सेवा कंपनी ने सभी वर्कफ़्लो को प्रबंधित करने के लिए Prompts.ai का उपयोग किया ओपनएआई, एंथ्रोपिक, और गूगल वर्टेक्सएआई मॉडल। त्वरित प्रबंधन और लागत ट्रैकिंग को केंद्रीकृत करके, उन्होंने परिचालन ओवरहेड में 30% की कटौती की और विभिन्न कार्यों के लिए अलग-अलग मॉडल की ताकत का लाभ उठाकर प्रतिक्रिया सटीकता को बढ़ाया।

Prompts.ai जैसी सुविधाओं के साथ सुरक्षा को प्राथमिकता देता है भूमिका-आधारित पहुंच, ऑडिट लॉगिंग, और एन्क्रिप्शन। यह प्रमुख मानकों के अनुपालन का समर्थन करता है, जिसमें शामिल हैं SOC 2 टाइप II, HIPAA, और GDPR, यह सुनिश्चित करना कि कई एलएलएम का प्रबंधन करते समय संगठन विनियामक आवश्यकताओं को पूरा करते हैं।

प्लेटफ़ॉर्म किसके साथ साझेदारी करता है वांता निरंतर नियंत्रण निगरानी के लिए और 19 जून, 2025 को अपनी SOC 2 टाइप II ऑडिट प्रक्रिया शुरू की। इसका ट्रस्ट सेंटर सुरक्षा नीतियों, नियंत्रणों और अनुपालन पर रीयल-टाइम अपडेट प्रदान करता है, जिससे संगठनों को उनकी सुरक्षा स्थिति में पूरी दृश्यता मिलती है।

सभी उद्यम योजनाओं में शासन और अनुपालन उपकरण, ऑफ़र शामिल हैं सभी AI इंटरैक्शन के लिए पूर्ण पारदर्शिता और ऑडिटेबिलिटी। यह मजबूत सुरक्षा ढांचा एंटरप्राइज़-स्केल ऑपरेशंस की मांगों को पूरा करते हुए शासन को बढ़ाता है।

Prompts.ai की वास्तुकला को क्षैतिज रूप से स्केल करने के लिए डिज़ाइन किया गया है, जो दर्जनों या सैकड़ों LLM उदाहरणों का प्रबंधन करता है। स्वचालित लोड संतुलन और संसाधन आवंटन इष्टतम प्रदर्शन सुनिश्चित करते हैं, जबकि इंटेलिजेंट रूटिंग पूर्वनिर्धारित मानदंडों के आधार पर सबसे उपयुक्त मॉडल के अनुरोधों को निर्देशित करती है।

प्लेटफ़ॉर्म क्लाउड और ऑन-प्रिमाइसेस परिनियोजन दोनों का समर्थन करता है, जो विविध अवसंरचना आवश्यकताओं वाले संगठनों के लिए लचीलापन प्रदान करता है। इसका स्केलेबल डिज़ाइन बड़े पुन: कॉन्फ़िगरेशन के बिना सहज विस्तार की अनुमति देता है, जो छोटी टीमों और बड़े उद्यमों दोनों के लिए उपयुक्त है।

रियल-टाइम मॉनिटरिंग टूल में शामिल हैं तत्काल विफलताओं, विलंबता समस्याओं और लागत में वृद्धि के लिए स्वचालित अलर्ट, उत्पादन वातावरण में विश्वसनीय संचालन सुनिश्चित करना। परफ़ॉर्मेंस डैशबोर्ड लेटेंसी, रिस्पॉन्स क्वालिटी और मॉडल ड्रिफ्ट को ट्रैक करते हैं, जिससे टीमें समस्याओं को तुरंत हल कर सकती हैं और विशिष्ट कार्यों के लिए मॉडल चयन को ठीक कर सकती हैं।

Amazon SageMaker बड़े पैमाने पर कई बड़े भाषा मॉडल (LLM) को तैनात करने और प्रबंधित करने के लिए एक मजबूत मंच प्रदान करता है। यह ऑर्केस्ट्रेशन, लागत दक्षता, सुरक्षा और स्केलेबिलिटी पर ध्यान केंद्रित करते हुए एलएलएम परिनियोजन की चुनौतियों का समाधान करने के लिए डिज़ाइन किया गया एंटरप्राइज़-स्तरीय बुनियादी ढांचा प्रदान करता है।

SageMaker's मॉडल रजिस्ट्री विभिन्न एलएलएम संस्करणों के प्रबंधन के लिए एक केंद्रीकृत हब के रूप में कार्य करता है। यह टीमों को मॉडल वंशावली को ट्रैक करने, मेटाडेटा संग्रहीत करने और विभिन्न मॉडलों में अनुमोदन वर्कफ़्लो प्रबंधित करने की अनुमति देता है। सुव्यवस्थित परिचालनों के लिए, सेजमेकर पाइपलाइन जटिल वर्कफ़्लो को स्वचालित करता है, जो अनुक्रमिक या समानांतर कॉन्फ़िगरेशन में कई एलएलएम के ऑर्केस्ट्रेशन को सक्षम करता है।

साथ में मल्टी-मॉडल एंडपॉइंट्स, टीमें एक ही एंडपॉइंट पर कई एलएलएम होस्ट कर सकती हैं, आवश्यकतानुसार गतिशील रूप से मॉडल लोड कर सकती हैं। यह सेटअप न केवल बुनियादी ढांचे की लागत में कटौती करता है, बल्कि मॉडल चुनने में लचीलापन भी सुनिश्चित करता है। चाहे वह हो बर्ट, GPT वेरिएंट, या कस्टम फाइन-ट्यून किए गए मॉडल, इन सभी को एक ही इंफ्रास्ट्रक्चर पर तैनात किया जा सकता है।

बड़े पैमाने पर अनुमान कार्यों के लिए, SageMaker बैच ट्रांसफ़ॉर्म गेम-चेंजर है। यह कई मॉडलों में बड़े पैमाने पर डेटासेट को कुशलतापूर्वक संभालता है, गणना उपयोग को अनुकूलित करने के लिए संसाधन आवंटन और जॉब शेड्यूलिंग को स्वचालित रूप से प्रबंधित करता है।

SageMaker के साथ मूल रूप से एकीकृत करता है AWS कॉस्ट एक्सप्लोरर, एलएलएम परिनियोजन में खर्चों की विस्तृत ट्रैकिंग की पेशकश करना। यह है स्पॉट ट्रेनिंग मॉडल फाइन-ट्यूनिंग और प्रयोगों के लिए अप्रयुक्त AWS क्षमता का लाभ उठाकर सुविधा प्रशिक्षण लागत में 90% तक की कटौती कर सकती है।

प्लेटफ़ॉर्म का ऑटो स्केलिंग सुविधा क्षैतिज और ऊर्ध्वाधर स्केलिंग दोनों का समर्थन करते हुए, ट्रैफ़िक मांगों के जवाब में गणना संसाधनों को समायोजित करती है। यह सुनिश्चित करता है कि संगठन लागत को नियंत्रण में रखते हुए प्रदर्शन बनाए रखें।

SageMaker's अनुमान सुझाने वाला विभिन्न इंस्टेंस प्रकारों और कॉन्फ़िगरेशन का विश्लेषण करके अनुमान को परिनियोजन से बाहर ले जाता है। यह लेटेंसी, थ्रूपुट और बजट की कमी के आधार पर अनुकूलित अनुशंसाएं प्रदान करता है, जिससे टीमों को अपने एलएलएम वर्कलोड के लिए सबसे अधिक लागत प्रभावी सेटअप खोजने में मदद मिलती है।

मॉडल कलाकृतियों और डेटा की सुरक्षा के लिए SageMaker AWS के मजबूत सुरक्षा उपायों का उपयोग करता है, जिसमें आराम और पारगमन दोनों में एन्क्रिप्शन शामिल है। प्लेटफ़ॉर्म सपोर्ट करता है वीपीसी आइसोलेशन, यह सुनिश्चित करना कि सभी ऑपरेशन - जैसे कि प्रशिक्षण और अनुमान - निजी नेटवर्क सीमाओं के भीतर संचालित किए जाते हैं।

के माध्यम से IAM एकीकरण, संगठन सुस्पष्ट अभिगम नियंत्रण लागू कर सकते हैं, मॉडल, डेटासेट और परिनियोजन वातावरण के प्रबंधन के लिए भूमिका-आधारित अनुमतियां प्रदान कर सकते हैं। यह सुनिश्चित करता है कि उपयोगकर्ता की भूमिकाओं और जिम्मेदारियों के आधार पर पहुँच प्रतिबंधित है।

प्लेटफ़ॉर्म प्रमुख उद्योग मानकों का भी अनुपालन करता है, जिसमें शामिल हैं SOC 1, SOC 2, SOC 3, PCI DSS स्तर 1, ISO 27001, और HIPAA। इसके अतिरिक्त, SageMaker सभी मॉडल प्रबंधन गतिविधियों को ट्रैक करने के लिए व्यापक ऑडिट लॉगिंग प्रदान करता है, जो सुरक्षा निगरानी और अनुपालन रिपोर्टिंग दोनों में सहायता करता है।

सेजमेकर को मल्टी-एलएलएम वातावरण की मांगों को संभालने, जीपीयू में फाइन-ट्यूनिंग ऑपरेशन को बढ़ाने और रीयल-टाइम और बैच अनुमान दोनों के लिए प्रोविजनिंग क्षमता को संभालने के लिए बनाया गया है। यह डेटा और मॉडल समानता के माध्यम से संसाधन उपयोग को अनुकूलित करते हुए हजारों समवर्ती अनुरोधों को संभाल सकता है।

इसके लिए धन्यवाद कंटेनर-आधारित आर्किटेक्चर, प्लेटफ़ॉर्म मौजूदा MLOps वर्कफ़्लो के साथ आसानी से एकीकृत हो जाता है। यह कस्टम रनटाइम वातावरण का भी समर्थन करता है, जिससे संगठन पूर्व-निर्मित कंटेनर या विशिष्ट फ़्रेमवर्क और आवश्यकताओं के अनुरूप कस्टम सेटअप का उपयोग करके मॉडल को तैनात कर सकते हैं।

Microsoft Azure Machine Learning बड़े भाषा मॉडल (LLM) के प्रबंधन के लिए एक व्यापक मंच प्रदान करता है, जो Microsoft के क्लाउड इन्फ्रास्ट्रक्चर के साथ MLOps टूल को मूल रूप से एकीकृत करता है। यह इसे उन संगठनों के लिए एक उत्कृष्ट विकल्प बनाता है जो पहले से ही Microsoft इकोसिस्टम का उपयोग कर रहे हैं।

एज़्योर मशीन लर्निंग एलएलएम प्रबंधन को इसके साथ सरल बनाता है मॉडल रजिस्ट्री, जो संस्करण, मेटाडेटा और कलाकृतियों को ट्रैक करता है। जो लोग नो-कोड दृष्टिकोण पसंद करते हैं, उनके लिए डिज़ाइनर इंटरफ़ेस उपयोगकर्ताओं को कई मॉडलों को आसानी से प्रबंधित करने के लिए विज़ुअल वर्कफ़्लो बनाने की अनुमति देता है।

प्लेटफ़ॉर्म का ऑटोमेटेड ML फीचर मॉडल चयन और हाइपरपैरामीटर ट्यूनिंग की परेशानी को दूर करता है, जिससे टीमों को विभिन्न आर्किटेक्चर की तुलना करने में सक्षम बनाया जाता है - ट्रांसफॉर्मर-आधारित मॉडल से कस्टम फाइन-ट्यून किए गए संस्करणों तक - समानांतर प्रयोगों के माध्यम से।

परिनियोजन के लिए, Azure प्रबंधित एंडपॉइंट्स कई एलएलएम में रीयल-टाइम और बैच अनुमान दोनों को संभालें। यह सपोर्ट करता है नीली-हरी तैनाती, टीमों को पूरी तरह से संक्रमण से पहले प्रोडक्शन मॉडल के साथ-साथ नए मॉडल का परीक्षण करने दें। यह डाउनटाइम को कम करता है और एक साथ कई मॉडलों का प्रबंधन करते समय जोखिम को कम करता है।

Azure भी सक्षम बनाता है पाइपलाइन ऑर्केस्ट्रेशन, जिससे टीमों को वर्कफ़्लो डिज़ाइन करने की अनुमति मिलती है जहाँ कई एलएलएम सहयोग करते हैं। उदाहरण के लिए, एक मॉडल टेक्स्ट वर्गीकरण को संभाल सकता है, जबकि दूसरा एकीकृत पाइपलाइन के भीतर भावना विश्लेषण करता है।

इन ऑर्केस्ट्रेशन टूल को मजबूत लागत प्रबंधन क्षमताओं द्वारा पूरित किया जाता है।

एज़्योर मशीन लर्निंग के साथ मूल रूप से एकीकृत होता है एज़्योर कॉस्ट मैनेजमेंट, एलएलएम की तैनाती के लिए विस्तृत व्यय ट्रैकिंग प्रदान करना। लागत में कटौती करने के लिए, प्लेटफ़ॉर्म ऑफ़र करता है स्पॉट वर्चुअल मशीन, जो प्रशिक्षण जैसे गैर-महत्वपूर्ण कार्यों के लिए Azure की अधिशेष गणना क्षमता का उपयोग करते हैं।

द ऑटो-स्केलिंग सुविधा मांग के आधार पर सीपीयू और जीपीयू संसाधनों को स्वचालित रूप से समायोजित करता है, जिससे कुशल उपयोग सुनिश्चित होता है। पूर्वानुमेय कार्यभार के लिए, आरक्षित उदाहरण पे-एज़-यू-गो प्राइसिंग की तुलना में रियायती दरों की पेशकश करें। इसके अतिरिक्त, लागत आबंटन टैग टीमों को प्रोजेक्ट, विभाग या मॉडल प्रकार के अनुसार खर्चों की निगरानी करने दें, जिससे बजट योजना और संसाधन प्रबंधन में मदद मिलती है।

सुरक्षा एज़्योर मशीन लर्निंग की आधारशिला है। प्लेटफ़ॉर्म यह सुनिश्चित करता है कि शुरू से अंत तक एन्क्रिप्शन, ट्रांज़िट और रेस्ट दोनों में डेटा और मॉडल कलाकृतियों की सुरक्षा करना। के साथ एकीकरण एज़्योर एक्टिव डायरेक्टरी एकल साइन-ऑन और केंद्रीकृत पहचान प्रबंधन का समर्थन करता है।

साथ में वर्चुअल नेटवर्क (VNet) एकीकरण, प्रशिक्षण और अनुमान संचालन निजी नेटवर्क के भीतर रहते हैं। टीमें भी सेट अप कर सकती हैं निजी समापन बिंदु इंटरनेट एक्सपोज़र को खत्म करने के लिए, संवेदनशील अनुप्रयोगों के लिए कड़े सुरक्षा आवश्यकताओं को पूरा करना।

एज़्योर मशीन लर्निंग उद्योग के प्रमुख मानकों का पालन करती है जैसे एसओसी 1, एसओसी 2, आईएसओ 27001, हिपा, और FedRamp। उपकरण जैसे एज़्योर कंप्लायंस मैनेजर निरंतर मूल्यांकन और रिपोर्टिंग में सहायता करें, जबकि एज़्योर पॉलिसी नई तैनाती के लिए सुरक्षा सेटिंग्स, डेटा प्रतिधारण नीतियों और एक्सेस नियंत्रण को लागू करके शासन को स्वचालित करता है।

एज़्योर मशीन लर्निंग को बड़े पैमाने पर बनाया गया है, जो इसे सिंगल-मॉडल प्रयोगों से लेकर एंटरप्राइज़-वाइड एलएलएम परिनियोजन तक हर चीज के लिए उपयुक्त बनाता है। इसके कंप्यूट क्लस्टर स्वचालित रूप से वितरित प्रशिक्षण संसाधनों को आवंटित कर सकते हैं, जो कई GPU में डेटा और मॉडल समानता दोनों का समर्थन करते हैं।

के साथ एकीकृत करके एज़्योर कुबेरनेट्स सर्विस (अक्स), प्लेटफ़ॉर्म जटिल, मल्टी-मॉडल सेटअप के लिए कंटेनर ऑर्केस्ट्रेशन को सक्षम करता है। इससे टीमें एलएलएम को माइक्रोसर्विसेज के रूप में तैनात कर सकती हैं, जिनमें से प्रत्येक में स्वतंत्र स्केलिंग और अपडेट क्षमताएं हैं।

ओवर में उपलब्धता के साथ 60 एज़्योर क्षेत्र, प्लेटफ़ॉर्म केंद्रीकृत प्रबंधन और निगरानी को बनाए रखते हुए, वैश्विक तैनाती के लिए कम-विलंबता पहुंच सुनिश्चित करता है। इसके अतिरिक्त, इसके साथ एकीकरण एज़्योर कॉग्निटिव सर्विसेज टीमों को पूर्व-निर्मित AI सेवाओं के साथ कस्टम LLM को संयोजित करने की अनुमति देता है, जिससे हाइब्रिड समाधान तैयार होते हैं जो समय बचाते हैं और विशिष्ट आवश्यकताओं के लिए लचीलापन प्रदान करते हैं।

हगिंग फेस ट्रांसफॉर्मर्स बड़े भाषा मॉडल (एलएलएम) के प्रबंधन को आसान बनाने के लिए डिज़ाइन किया गया एक ओपन-सोर्स टूल है। जैसे फ्रेमवर्क का लाभ उठाकर PyTorch और टेंसरफ़्लो, यह डेवलपर्स को कोड की सिर्फ एक लाइन के साथ हजारों मॉडल लोड करने और प्रबंधित करने के लिए एक सहज, स्केलेबल प्लेटफॉर्म प्रदान करता है। एक्सेसिबिलिटी, दक्षता और स्केलेबिलिटी पर इसका फोकस इसे कई एलएलएम की बाजीगरी करने वाली टीमों के लिए एक उपयोगी समाधान बनाता है।

इसके मूल में, ट्रांसफॉर्मर्स को मॉडल एक्सेस को कारगर बनाने, कुशल ऑर्केस्ट्रेशन और संसाधन प्रबंधन को सक्षम करने के लिए बनाया गया है।

ट्रांसफॉर्मर्स लाइब्रेरी सरल बनाती है मॉडल डिस्कवरी और लोडिंग संक्षिप्त आदेशों के साथ का उपयोग करना from_pretrained () फ़ंक्शन, डेवलपर्स अपने टोकनाइज़र, वज़न और कॉन्फ़िगरेशन के साथ मॉडल को तुरंत लोड कर सकते हैं - कोई अतिरिक्त सेटअप आवश्यक नहीं है।

द पाइपलाइन API निर्बाध कार्य स्विचिंग और स्वचालित GIT-आधारित वर्जनिंग को सक्षम करके उपयोगिता को और बढ़ाता है। उदाहरण के लिए, आप BERT जैसे मॉडल से सेंटीमेंट विश्लेषण आउटपुट की तुलना आसानी से कर सकते हैं, रॉबर्ट ए, और डिस्टिलबर्ट अपनी पाइपलाइन में मॉडल पैरामीटर को समायोजित करके प्रत्येक मॉडल रिपॉजिटरी परिवर्तनों का पूरा इतिहास ट्रैक करती है, जिससे यूज़र पहले के संस्करणों में वापस आ सकते हैं या पुनरावृत्तियों में प्रदर्शन के अंतर का विश्लेषण कर सकते हैं।

जब बात आती है बैच प्रोसेसिंग और अनुमान, लाइब्रेरी में डायनामिक बैचिंग और अटेंशन ऑप्टिमाइज़ेशन शामिल है, जो वेरिएबल-लेंथ इनपुट के कुशल संचालन को सुनिश्चित करता है। जैसी सुविधाएँ ग्रेडिएंट चेकपॉइंटिंग स्मृति खपत को प्रबंधित करने में मदद करें, खासकर बड़े पैमाने के मॉडल के साथ काम करते समय।

हगिंग फेस ट्रांसफॉर्मर्स कंप्यूट और मेमोरी उपयोग को अनुकूलित करने के लिए कई टूल प्रदान करता है, जिससे यह संगठनों के लिए लागत प्रभावी विकल्प बन जाता है। मॉडल परिमाणीकरण प्रदर्शन को बनाए रखते हुए मॉडल के आकार को 75% तक छोटा कर सकता है, जो विशेष रूप से एक साथ कई मॉडलों को संभालने के लिए उपयोगी है।

लाइब्रेरी भी प्रदान करती है डिस्टिल्ड मॉडल, जैसे कि डिस्टिलबर्ट, जो तेज़ प्रदर्शन और कम मेमोरी उपयोग के लिए पूर्व-अनुकूलित हैं। ये मॉडल अपने पूर्ण आकार के समकक्षों की तुलना में लगभग 60% तेज़ी से चलते हैं और 40% कम मेमोरी की खपत करते हैं, जिससे बड़े पैमाने पर तैनाती के लिए महत्वपूर्ण बचत होती है।

डायनामिक मॉडल लोड हो रहा है यह सुनिश्चित करता है कि संसाधनों का उपयोग केवल जरूरत पड़ने पर मॉडल लोड करके कुशलतापूर्वक किया जाता है, बजाय उन सभी को एक ही बार में स्मृति में रखने के। इसके अतिरिक्त, यह मॉडल कैशिंग रणनीतियां स्मृति उपयोग और लोडिंग गति के बीच संतुलन बनाती हैं, जिससे टीमों को मांग के आधार पर संसाधनों को आवंटित करने की सुविधा मिलती है।

और भी अधिक दक्षता के लिए, के साथ एकीकरण ONNX रनटाइम CPU-आधारित अनुमान परिदृश्यों में प्रदर्शन को बढ़ाता है, जो GPU खर्चों को कम करने वाली टीमों के लिए एक लागत प्रभावी विकल्प है। यह अनुकूलन क्षमता संगठनों को उनकी विशिष्ट आवश्यकताओं के अनुरूप परिनियोजन रणनीतियों को चुनने की अनुमति देती है।

हगिंग फेस ट्रांसफॉर्मर्स को आसानी से स्केल करने के लिए डिज़ाइन किया गया है, चाहे आप एक प्रयोग चला रहे हों या पूर्ण पैमाने पर उत्पादन वातावरण का प्रबंधन कर रहे हों। यह सपोर्ट करता है मल्टी-जीपीयू सेटअप और मॉडल समांतरता, जो एकल डिवाइस की मेमोरी से अधिक मॉडल के उपयोग को सक्षम करता है।

लाइब्रेरी लोकप्रिय मशीन लर्निंग फ्रेमवर्क के साथ एकीकृत होती है जैसे किरण और डस्क, जिससे कई मशीनों में क्षैतिज रूप से स्केल करना आसान हो जाता है। यह अनुकूलता मौजूदा MLOps पाइपलाइनों में सहज एकीकरण सुनिश्चित करती है, जिससे टीमों को बड़े पैमाने पर LLM को तैनात करने की अनुमति मिलती है।

के माध्यम से हगिंग फेस हब, संगठन निजी रिपॉजिटरी, एक्सेस कंट्रोल और गवर्नेंस नीतियों जैसी सुविधाओं के साथ अपने मॉडल प्रबंधन को केंद्रीकृत कर सकते हैं। यह केंद्रीकरण टीम सहयोग का समर्थन करता है और एलएलएम के पोर्टफोलियो में प्रभावी निरीक्षण सुनिश्चित करता है।

के लिए उत्पादन की तैनाती, ट्रांसफॉर्मर मॉडल को कंटेनरीकृत किया जा सकता है और जैसे उपकरणों का उपयोग करके तैनात किया जा सकता है डॉकर, कुबेरनेट्स, या क्लाउड-नेटिव सेवाएं। लाइब्रेरी के मानकीकृत इंटरफेस विभिन्न वातावरणों में सुसंगत व्यवहार सुनिश्चित करते हैं, जिससे जटिल मल्टी-मॉडल सिस्टम की तैनाती सरल हो जाती है।

व्यापक सामुदायिक पारिस्थितिकी तंत्र एक और फायदा है, जो हजारों पूर्व-प्रशिक्षित मॉडल, डेटासेट और उपयोगकर्ता द्वारा योगदान किए गए अनुकूलन प्रदान करता है। यह इकोसिस्टम शुरुआत से मॉडल बनाने की आवश्यकता को कम करता है, जिससे अनुप्रयोगों की एक विस्तृत श्रृंखला के लिए उपयोग के लिए तैयार समाधान उपलब्ध होते हैं।

Comet ML एक मजबूत मशीन लर्निंग प्लेटफ़ॉर्म के रूप में सामने आता है, जिसे कई बड़े भाषा मॉडल (LLM) के जीवन चक्र में ट्रैकिंग, निगरानी और प्रबंधन को आसान बनाने के लिए डिज़ाइन किया गया है। प्रयोग ट्रैकिंग, मॉडल रजिस्ट्री और उत्पादन निगरानी को केंद्रीकृत करके, यह पहले चर्चा की गई एकीकृत रणनीतियों का पूरक है। यह इसे एक साथ कई एलएलएम का प्रबंधन करने वाले संगठनों के लिए एक आदर्श उपकरण बनाता है।

धूमकेतु एमएल का प्रयोग ट्रैकिंग सिस्टम एलएलएम प्रशिक्षण से डेटा को स्वचालित रूप से कैप्चर और व्यवस्थित करता है। यह वास्तविक समय में हाइपरपैरामीटर, मेट्रिक्स, कोड संस्करण और सिस्टम संसाधन उपयोग को लॉग करता है, जिससे विभिन्न मॉडलों और कॉन्फ़िगरेशन में प्रदर्शन की तुलना करने के लिए एक विस्तृत रिकॉर्ड बनाया जाता है।

प्लेटफ़ॉर्म की मॉडल रजिस्ट्री कई एलएलएम के भंडारण, संस्करण और प्रबंधन के लिए एक केंद्रीकृत हब के रूप में कार्य करती है। इसमें प्रदर्शन बेंचमार्क, प्रशिक्षण डेटासेट और परिनियोजन आवश्यकताओं जैसे विस्तृत मेटाडेटा शामिल हैं, जिससे यह सुनिश्चित होता है कि टीमों के पास एक ही स्थान पर आवश्यक सभी जानकारी हो।

अनुकूलन योग्य डैशबोर्ड स्वचालित तुलनाओं को सक्षम करते हैं, जिससे टीमों को सटीकता, अनुमान समय और संसाधन उपयोग जैसे मैट्रिक्स का मूल्यांकन करके शीर्ष प्रदर्शन करने वाले मॉडल की तुरंत पहचान करने की अनुमति मिलती है। सहयोगी कार्यक्षेत्र टीम के सदस्यों को प्रयोगों को साझा करने, परिणामों की व्याख्या करने और निष्कर्षों पर कुशलतापूर्वक चर्चा करने, मॉडल जीवनचक्र के दौरान संचार और निर्णय लेने को सुव्यवस्थित करने में सक्षम बनाकर उत्पादकता को और बढ़ाता है।

कॉमेट एमएल एलएलएम प्रयोगों के लिए गहन संसाधन ट्रैकिंग, जीपीयू उपयोग की निगरानी, प्रशिक्षण समय और गणना लागत प्रदान करता है। यह डेटा हाइपरमापदंडों को ठीक करके और प्रशिक्षण कॉन्फ़िगरेशन को अनुकूलित करके खर्चों को कम करने के अवसरों की पहचान करने में मदद करता है। एक समर्पित लागत डैशबोर्ड परियोजनाओं और टीम के सदस्यों के बीच खर्च करने वाले डेटा को समेकित करता है, बुनियादी ढांचे की लागतों के बारे में स्पष्ट जानकारी प्रदान करता है और बेहतर संसाधन आवंटन निर्णयों को सक्षम करता है।

प्लेटफ़ॉर्म संवेदनशील मॉडल डेटा और प्रशिक्षण प्रक्रियाओं की सुरक्षा के लिए सिंगल साइन-ऑन (SSO), रोल-आधारित एक्सेस कंट्रोल और ऑडिट लॉगिंग जैसी सुविधाओं के साथ सुरक्षा को प्राथमिकता देता है। अतिरिक्त नियंत्रण की आवश्यकता वाले संगठनों के लिए, निजी क्लाउड परिनियोजन विकल्प Comet ML को अपने स्वयं के बुनियादी ढांचे के भीतर काम करने की अनुमति देते हैं। इन सुरक्षा उपायों से यह सुनिश्चित होता है कि प्लेटफ़ॉर्म जटिल, मल्टी-एलएलएम वातावरण में भी सुरक्षित रूप से स्केल कर सकता है।

कॉमेट एमएल को वितरित प्रशिक्षण सेटअपों में कई एलएलएम के प्रबंधन की मांगों को पूरा करने के लिए बनाया गया है। यह कई GPU और मशीनों पर प्रयोगों को कुशलतापूर्वक ट्रैक करता है, जो प्रशिक्षण की प्रगति और संसाधनों के उपयोग के बारे में एक एकीकृत दृष्टिकोण पेश करता है। API एकीकरण मौजूदा MLOPS पाइपलाइनों में सहज समावेश सुनिश्चित करता है, जबकि बहु-कार्यक्षेत्र संगठन बड़े संगठनों को टीम, विभाग या उपयोग के मामले के अनुसार परियोजनाओं को विभाजित करने की अनुमति देता है - लचीलेपन का त्याग किए बिना केंद्रीकृत निरीक्षण बनाए रखता है।

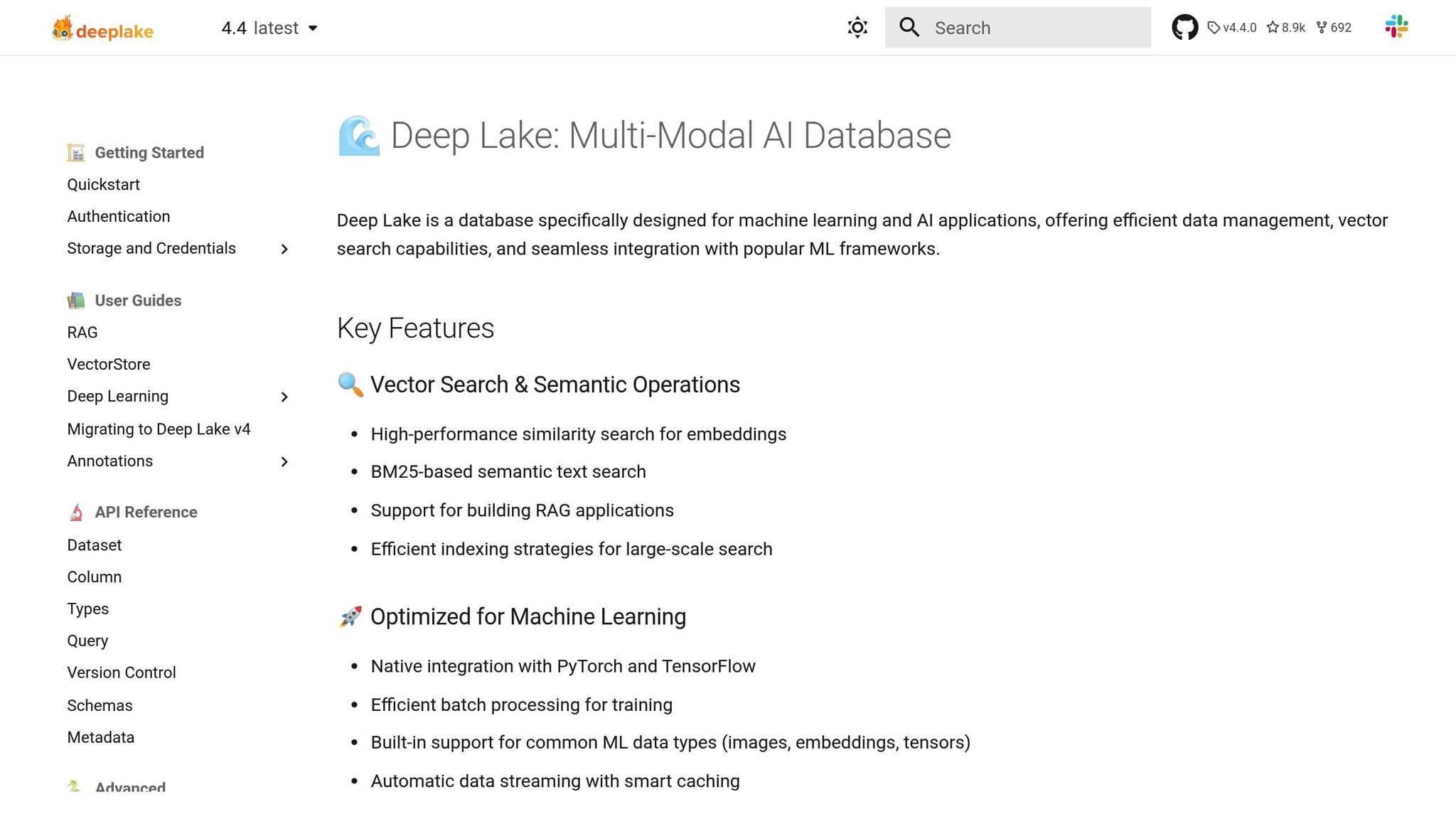

डीपलेक वेक्टर डेटाबेस की सटीकता के साथ डेटा झीलों की अनुकूलन क्षमता को जोड़ती है, जिससे कुशल मल्टी-एलएलएम वर्कफ़्लो की नींव तैयार होती है।

डीपलेक को बड़े पैमाने पर एलएलएम संचालन के लिए डिज़ाइन किया गया है, जो उद्योग की जरूरतों को पूरा करने के लिए लगातार विकसित हो रहा है। यह वेक्टर डेटाबेस की सटीकता के साथ डेटा झीलों की अनुकूलन क्षमता को मिलाता है, जिससे इसकी “सिम्बायोटिक मॉडल एंगेजमेंट” सुविधा के माध्यम से कई एलएलएम में सहज डेटा प्रवाह सक्षम होता है। इसके अतिरिक्त, “एजाइल इवोल्यूशन” और “क्रोनोलॉजिकल एडैप्टिविटी” जैसे टूल त्वरित रीकैलिब्रेशन और रीयल-टाइम सिंक्रोनाइज़ेशन की अनुमति देते हैं, जिससे वर्कफ़्लो कुशल और अद्यतित रहते हैं।

प्लेटफ़ॉर्म की उन्नत मेमोरी क्षमताएं समान डेटा बिंदुओं की पुनर्प्राप्ति को बढ़ाती हैं और वेक्टर एम्बेडिंग को परिष्कृत करती हैं, जिससे एलएलएम के प्रदर्शन को बढ़ावा मिलता है। डीपलेक प्रमुख एआई फ्रेमवर्क के साथ भी एकीकृत होता है, जो रिट्रीवल ऑगमेंटेड जेनरेशन और अन्य एलएलएम-संचालित समाधानों जैसे अनुप्रयोगों का समर्थन करता है।

डायनेमिक डेटा प्रबंधन पर ध्यान केंद्रित करके, डीपलेक मल्टी-एलएलएम इकोसिस्टम को मजबूत करता है, जिससे लागत प्रभावी संचालन को बनाए रखते हुए उन्नत एआई वर्कफ़्लो के लिए निरंतर समर्थन सुनिश्चित होता है।

डीपलेक प्रदर्शन और लागत बचत दोनों देने के लिए बुद्धिमान संसाधन आवंटन को प्राथमिकता देता है।

इसका प्रबंधित टेंसर डेटाबेस हाई-स्पीड, रियल-टाइम डेटा स्ट्रीमिंग को सक्षम करते हुए स्टोरेज खर्च को कम करता है। इसके अतिरिक्त, प्लेटफ़ॉर्म का कुशल वेक्टर स्टोरेज कम्प्यूटेशनल मांगों को कम करता है, जिससे अनावश्यक ओवरहेड के बिना सुचारू संचालन सुनिश्चित होता है।

डीपलेक अपनी “डेटा फोर्टिफिकेशन” पहल के तहत मजबूत सुरक्षा उपायों को शामिल करता है, जो डेटा अखंडता की सुरक्षा और भ्रष्टाचार को रोकने के लिए डिज़ाइन की गई सुविधाओं की पेशकश करता है। यह मल्टी-एलएलएम वातावरण को सुरक्षित बनाए रखने में मदद करने के लिए विस्तृत कार्यान्वयन मार्गदर्शिकाएं भी प्रदान करता है। हालाँकि, विशिष्ट वेक्टर डेटाबेस समाधानों की तुलना में इसकी एंटरप्राइज़-स्तरीय सुरक्षा सुविधाएँ कुछ हद तक सीमित हैं। सख्त अनुपालन आवश्यकताओं वाले संगठनों को यह मूल्यांकन करना चाहिए कि उसके मौजूदा सुरक्षा प्रस्ताव उनकी आवश्यकताओं को पूरा करते हैं या नहीं। इसके बावजूद, डीपलेक एकीकृत मल्टी-एलएलएम प्रबंधन में एक प्रमुख खिलाड़ी बना हुआ है, जो परिचालन दक्षता के साथ सुरक्षा को संतुलित करता है।

डीपलेक का क्लाउड-केंद्रित आर्किटेक्चर स्केलेबल और उच्च-प्रदर्शन वाले मल्टी-एलएलएम वर्कलोड का समर्थन करता है। मल्टी-क्लाउड संगतता और प्रबंधित टेंसर डेटाबेस के साथ, यह रीयल-टाइम डेटा स्ट्रीमिंग और लचीले संसाधन आवंटन की सुविधा प्रदान करता है। यह इसे कई अनुप्रयोगों के लिए उपयुक्त बनाता है, जिसमें रेस्पॉन्सिव चैटबॉट से लेकर विशाल दस्तावेज़ डेटासेट को प्रोसेस करने वाले जटिल मॉडल शामिल हैं।

नीचे दी गई तालिका लोकप्रिय प्लेटफार्मों की मुख्य विशेषताओं पर प्रकाश डालती है, जिससे कई एलएलएम के प्रबंधन के लिए सही समाधान चुनना आसान हो जाता है।

प्रत्येक प्लेटफ़ॉर्म अपनी अनूठी खूबियों के लिए सबसे अलग है। Prompts.ai एकीकृत प्रबंधन और लागत दक्षता में उत्कृष्टता प्राप्त करता है। अमेज़ॅन सेजमेकर और एज़्योर मशीन लर्निंग एंटरप्राइज़ इकोसिस्टम में मूल रूप से एकीकृत करें। हगिंग फेस ट्रांसफॉर्मर्स कोड-प्रथम प्रयोग के लिए आदर्श है, जबकि धूमकेतु एमएल प्रयोग ट्रैकिंग में चमकता है। डीप लेक डेटा-इंटेंसिव वर्कफ़्लो के लिए तैयार किया गया है।

निर्णय लेते समय, अपनी टीम की विशेषज्ञता, मौजूदा बुनियादी ढांचे और एलएलएम के प्रबंधन के लिए विशिष्ट आवश्यकताओं पर विचार करें। लागत दक्षता और शासन पर ध्यान केंद्रित करने वाली टीमें FinOps टूल वाले प्लेटफ़ॉर्म की ओर झुक सकती हैं, जबकि प्रयोग को प्राथमिकता देने वाले लोग विस्तृत ट्रैकिंग और प्रदर्शन तुलना सुविधाओं को पसंद कर सकते हैं। अपने मल्टी-एलएलएम सेटअप के लिए सबसे उपयुक्त विकल्प खोजने के लिए इन क्षमताओं को अपने लक्ष्यों के साथ संरेखित करें।

कई बड़े भाषा मॉडल को प्रभावी ढंग से संभालने के लिए एकीकृत उपकरण, एक स्पष्ट रणनीति और मजबूत शासन की आवश्यकता होती है। यहां जिन प्लेटफार्मों पर चर्चा की गई है, वे एकीकृत इंटरफेस, सख्त लागत प्रबंधन और उद्यम-स्तर की सुरक्षा पर जोर देते हैं।

प्लेटफ़ॉर्म का मूल्यांकन करते समय, अपने संगठन के अद्वितीय बुनियादी ढांचे और लक्ष्यों के साथ अपनी पसंद को संरेखित करना महत्वपूर्ण है। प्राथमिकता देने वाली टीमों के लिए लागत प्रबंधन और सुव्यवस्थित निरीक्षण, रियल-टाइम FinOps टूल और समेकित बिलिंग की पेशकश करने वाले प्लेटफ़ॉर्म सबसे अलग हैं। दूसरी ओर, प्रयोग और अनुकूलन पर ध्यान केंद्रित करने वाली टीमें ओपन-सोर्स लाइब्रेरी और अपनी आवश्यकताओं के अनुरूप लचीले परिनियोजन विकल्पों की ओर झुक सकती हैं।

वर्कफ़्लो में दक्षता सफलता की आधारशिला है। अगल-बगल मॉडल तुलना, व्यवस्थित प्रयोग ट्रैकिंग, और मानकीकृत शीघ्र प्रबंधन जैसी सुविधाएँ करतब दिखाने और बिखरे हुए सिस्टम को प्रबंधित करने में लगने वाले समय में काफी कटौती कर सकती हैं। इस तरह की दक्षता तेजी से मूल्यवान हो जाती है क्योंकि टीमें अपने AI संचालन को बढ़ाती हैं और अधिक जटिल उपयोग के मामलों से निपटती हैं।

शासन, अनुपालन और लागत पारदर्शिता गैर-परक्राम्य बनी हुई है। व्यापक ऑडिट ट्रेल्स, भूमिका-आधारित पहुंच और स्पष्ट मूल्य निर्धारण संरचनाओं वाले प्लेटफ़ॉर्म संगठनों को खर्चों को नियंत्रण में रखते हुए विनियामक मांगों को पूरा करने में सक्षम बनाते हैं। रियल-टाइम यूसेज ट्रैकिंग और बजट नोटिफिकेशन जैसे टूल न केवल ओवरस्पीडिंग को रोकते हैं बल्कि यह भी सुनिश्चित करते हैं कि AI निवेश अधिकतम मूल्य प्रदान करें।

जैसे-जैसे एलएलएम परिदृश्य विकसित हो रहा है, ऐसे प्लेटफॉर्म का चयन करना जो स्केलेबिलिटी के साथ तत्काल जरूरतों को संतुलित करते हैं, आगे रहने के लिए महत्वपूर्ण है। सही विकल्प एक ठोस आधार देता है, जो मौजूदा परियोजनाओं और आपके संगठन के भीतर AI अपनाने की अपरिहार्य वृद्धि दोनों का समर्थन करता है।

Prompts.ai आपको परिचालन लागत में उतनी ही कटौती करने में मदद करता है जितना 98% कई बड़े भाषा मॉडल का प्रबंधन करते समय। आपके सभी कार्यों को एक ही छत के नीचे लाकर, यह वर्कफ़्लो को सरल बनाता है और अनावश्यक कदमों को समाप्त करता है, जिससे समग्र दक्षता और प्रदर्शन में वृद्धि होती है।

जटिल AI सिस्टम की चुनौतियों को ध्यान में रखते हुए बनाया गया, Prompts.ai यह सुनिश्चित करता है कि आप बिना खर्च बढ़ाए अपने मॉडल से अधिकतम मूल्य निकालें।

Prompts.ai सुरक्षा और विनियामक अनुपालन पर जोर देता है, उपयोगकर्ताओं को बड़े भाषा मॉडल (LLM) की सुरक्षा और प्रबंधन के लिए शक्तिशाली उपकरणों से लैस करता है। मुख्य विशेषताओं में शामिल हैं अनुपालन निगरानी विनियामक आवश्यकताओं को पूरा करने के लिए, गवर्नेंस टूल्स पहुंच और उपयोग के प्रबंधन के लिए, और विस्तृत एनालिटिक्स मॉडल के प्रदर्शन का प्रभावी ढंग से मूल्यांकन और सुधार करने के लिए।

प्लेटफ़ॉर्म भी प्रदान करता है केंद्रीकृत भंडारण पूलिंग और प्रशासन के उपकरण कड़े नियंत्रण बनाए रखते हुए वर्कफ़्लो को सरल बनाने के लिए। यह सुनिश्चित करता है कि आपके एलएलएम ऑपरेशन हर समय सुरक्षित, कुशल और सुव्यवस्थित रहें।

Prompts.ai कई बड़े भाषा मॉडल (LLM) उदाहरणों को कुशलतापूर्वक संभालने के लिए तैयार किए गए टूल के साथ स्केलिंग को आसान बनाता है। प्लेटफ़ॉर्म आपको वर्कफ़्लो को समन्वयित करने, प्रदर्शन को ट्रैक करने और संचालन को सरल बनाने में सक्षम बनाता है - यहां तक कि एक साथ दर्जनों या सैकड़ों एलएलएम का प्रबंधन करते समय भी।

मुख्य विशेषताएं जैसे केंद्रीकृत प्रबंधन, स्वचालित वर्कफ़्लो, और प्रदर्शन ट्यूनिंग सुनिश्चित करें कि आपके AI सिस्टम आपके सेटअप की जटिलता की परवाह किए बिना भरोसेमंद और अनुकूलनीय बने रहें। यह व्यापक, मल्टी-मॉडल परिनियोजन की देखरेख करने वाले डेवलपर्स और AI पेशेवरों के लिए एक उपयोगी समाधान है।