La gestion de plusieurs grands modèles de langage (LLM) peut être complexe, mais les bons outils vous faciliteront la tâche. Des plateformes comme Prompts.ai, Amazon SageMaker, Apprentissage automatique Azure, Transformateurs Hugging Face, Comète ML, et Lac Deep simplifiez les flux de travail, réduisez les coûts et améliorez la sécurité. Voici ce que vous devez savoir :

Plats à emporter rapides: Choisissez des outils en fonction des besoins de votre équipe, qu'il s'agisse d'optimisation des coûts, d'évolutivité ou de sécurité, tout en vous assurant qu'ils correspondent à votre infrastructure et à vos objectifs.

Prompts.ai rassemble plus de 35 modèles d'IA de premier plan, dont GPT-5, Claude, Lama, et Gémeaux, au sein d'une plateforme unique et unifiée. En remédiant à la complexité de la gestion de plusieurs grands modèles de langage (LLM), il élimine les inefficacités causées par la dispersion des outils.

Avec ses système de gestion rapide centralisé, Prompts.ai permet aux équipes de concevoir, de tester et de déployer sans effort des instructions sur différents modèles. La plateforme assure un suivi transparent des versions, ce qui permet de maintenir la cohérence des flux de travail d'IA.

La plateforme outils d'orchestration des flux de travail simplifiez la gestion multi-LLM grâce à des pipelines automatisés. Les équipes peuvent comparer les résultats des modèles côte à côte, ce qui permet d'identifier plus facilement les configurations les plus performantes pour des tâches spécifiques.

Prompts.ai s'intègre également parfaitement à des frameworks tels que Chaîne Lang, Hugging Face et Kit de développement logiciel Vercel AI, ainsi que des services cloud tels que AWS Bedrock et Azure OpenAI. Ces intégrations rationalisent l'automatisation des flux de travail et l'évaluation des modèles sans nécessiter d'ajustements techniques importants.

Ces fonctionnalités améliorent non seulement l'efficacité, mais ouvrent également la voie à une meilleure gestion des coûts et à des protocoles de sécurité plus solides.

Prompts.ai livre suivi et analyse détaillés des coûts, offrant une surveillance au niveau des jetons pour suivre l'utilisation et les dépenses de chaque LLM en temps réel. En consolidant les outils d'IA, la plateforme compte jusqu'à 98 % d'économies.

Grâce à des tableaux de bord en temps réel, les utilisateurs obtiennent des informations sur la répartition des coûts, ce qui permet des conceptions rapides plus efficaces. Cette transparence permet aux équipes de choisir les modèles les plus rentables pour leurs besoins sans compromettre les performances. En outre, la plateforme transforme les coûts fixes en dépenses évolutives et à la demande, ce qui rend l'adoption de l'IA plus flexible et plus facile à gérer.

Par exemple, une société de services financiers a utilisé Prompts.ai pour gérer les flux de travail entre IA ouverte, Anthropique, et Google VertexAI modèles. En centralisant la gestion rapide et le suivi des coûts, ils ont réduit les frais opérationnels de 30 % et amélioré la précision des réponses en tirant parti des points forts des modèles individuels pour différentes tâches.

Prompts.ai donne la priorité à la sécurité avec des fonctionnalités telles que accès basé sur les rôles, journalisation des audits et chiffrement. Il favorise la conformité aux normes clés, notamment SOC 2 Type II, HIPAA et RGPD, en veillant à ce que les organisations respectent les exigences réglementaires lorsqu'elles gèrent plusieurs LLM.

La plateforme s'associe à Vanta pour une surveillance continue des contrôles et a entamé son processus d'audit SOC 2 de type II le 19 juin 2025. Son centre de gestion de la confidentialité fournit des mises à jour en temps réel sur les politiques de sécurité, les contrôles et la conformité, offrant ainsi aux entreprises une visibilité complète sur leur posture de sécurité.

Tous les plans d'entreprise incluent des outils de gouvernance et de conformité, offrant transparence et auditabilité complètes pour toutes les interactions avec l'IA. Ce cadre de sécurité robuste améliore la gouvernance tout en répondant aux exigences des opérations à l'échelle de l'entreprise.

L'architecture de Prompts.ai est conçue pour évoluer horizontalement, en gérant des dizaines, voire des centaines d'instances LLM. L'équilibrage de charge et l'allocation des ressources automatisés garantissent des performances optimales, tandis que le routage intelligent dirige les demandes vers le modèle le plus adapté en fonction de critères prédéfinis.

La plateforme prend en charge les déploiements dans le cloud et sur site, offrant ainsi de la flexibilité aux organisations ayant des besoins d'infrastructure divers. Sa conception évolutive permet une expansion fluide sans reconfigurations majeures, s'adressant à la fois aux petites équipes et aux grandes entreprises.

Les outils de surveillance en temps réel incluent alertes automatisées en cas de pannes rapides, de problèmes de latence et de dépassements de coûts, garantissant des opérations fiables dans les environnements de production. Les tableaux de bord de performance suivent la latence, la qualité de réponse et la dérive des modèles, ce qui permet aux équipes de résoudre rapidement les problèmes et d'affiner la sélection des modèles pour des tâches spécifiques.

Amazon SageMaker fournit une plate-forme robuste pour le déploiement et la gestion de plusieurs grands modèles de langage (LLM) à grande échelle. Il propose une infrastructure au niveau de l'entreprise conçue pour relever les défis du déploiement de LLM, en mettant l'accent sur l'orchestration, la rentabilité, la sécurité et l'évolutivité.

SageMaker's Registre des modèles agit comme un hub centralisé pour la gestion des différentes versions de LLM. Il permet aux équipes de suivre le lignage des modèles, de stocker des métadonnées et de gérer les flux de travail d'approbation sur différents modèles. Pour rationaliser les opérations, Canalisations SageMaker automatise les flux de travail complexes, permettant l'orchestration de plusieurs LLM dans des configurations séquentielles ou parallèles.

Avec Points de terminaison multimodèles, les équipes peuvent héberger plusieurs LLM sur un seul terminal, en chargeant dynamiquement les modèles selon les besoins. Cette configuration permet non seulement de réduire les coûts d'infrastructure, mais garantit également une flexibilité dans le choix des modèles. Que ce soit BERT, des variantes GPT ou des modèles personnalisés et affinés, ils peuvent tous être déployés sur la même infrastructure.

Pour les tâches d'inférence à grande échelle, SageMaker's Transformation par lots change la donne. Il gère efficacement des ensembles de données volumineux provenant de plusieurs modèles, gérant automatiquement l'allocation des ressources et la planification des tâches afin d'optimiser l'utilisation du calcul.

SageMaker s'intègre parfaitement à Explorateur de coûts AWS, offrant un suivi détaillé des dépenses liées aux déploiements LLM. C'est Entraînement sportif Cette fonctionnalité peut réduire les coûts de formation jusqu'à 90 % en tirant parti de la capacité AWS inutilisée pour affiner les modèles et effectuer des expériences.

La plateforme Mise à l'échelle automatique cette fonctionnalité ajuste les ressources de calcul en réponse aux demandes de trafic, en prenant en charge la mise à l'échelle horizontale et verticale. Cela garantit que les organisations maintiennent leurs performances tout en maîtrisant les coûts.

SageMaker's Recommandeur d'inférence élimine les incertitudes liées au déploiement en analysant les différents types d'instances et configurations. Il fournit des recommandations personnalisées en fonction des contraintes de latence, de débit et de budget, aidant les équipes à trouver la configuration la plus rentable pour leurs charges de travail LLM.

SageMaker utilise les mesures de sécurité robustes d'AWS, notamment le chiffrement au repos et en transit, pour protéger les artefacts et les données des modèles. La plateforme prend en charge Isolation en PVC, en veillant à ce que toutes les opérations, telles que la formation et l'inférence, soient menées dans les limites d'un réseau privé.

À travers Intégration IAM, les organisations peuvent mettre en œuvre des contrôles d'accès précis, en attribuant des autorisations basées sur les rôles pour gérer les modèles, les ensembles de données et les environnements de déploiement. Cela garantit que l'accès est restreint en fonction des rôles et responsabilités des utilisateurs.

La plateforme est également conforme aux principales normes de l'industrie, notamment SOC 1, SOC 2, SOC 3, PCI DSS niveau 1, ISO 27001 et HIPAA. En outre, SageMaker propose une journalisation complète des audits pour suivre toutes les activités de gestion des modèles, ce qui facilite à la fois la surveillance de la sécurité et les rapports de conformité.

SageMaker est conçu pour répondre aux exigences des environnements multi-LLM, en adaptant les opérations de réglage sur tous les GPU et en fournissant des capacités pour l'inférence en temps réel et par lots. Il peut gérer des milliers de demandes simultanées tout en optimisant l'utilisation des ressources grâce au parallélisme des données et des modèles.

Grâce à ses architecture basée sur des conteneurs, la plateforme s'intègre sans effort aux flux de travail MLOps existants. Il prend également en charge des environnements d'exécution personnalisés, permettant aux entreprises de déployer des modèles à l'aide de conteneurs prédéfinis ou de configurations personnalisées adaptées à des cadres et à des exigences spécifiques.

Microsoft Azure Machine Learning propose une plateforme complète de gestion de grands modèles de langage (LLM), intégrant de manière transparente les outils MLOps à l'infrastructure cloud de Microsoft. Cela en fait un excellent choix pour les organisations qui utilisent déjà l'écosystème Microsoft.

Azure Machine Learning simplifie la gestion du LLM grâce à ses Registre des modèles, qui assure le suivi des versions, des métadonnées et des artefacts. Pour ceux qui préfèrent une approche sans code, le Interface de conception permet aux utilisateurs de créer des flux de travail visuels pour gérer plusieurs modèles sans effort.

La plateforme ML automatisé Cette fonctionnalité simplifie la sélection des modèles et le réglage des hyperparamètres, permettant aux équipes de comparer différentes architectures, des modèles basés sur des transformateurs aux versions personnalisées et affinées, grâce à des expériences parallèles.

Pour le déploiement, Azure Endpoints gérés gérer à la fois l'inférence en temps réel et par lots sur plusieurs LLM. Il prend en charge déploiements bleu-vert, permettant aux équipes de tester de nouveaux modèles en plus de ceux de production avant la transition complète. Cela permet de minimiser les temps d'arrêt et de réduire les risques liés à la gestion de plusieurs modèles à la fois.

Azure permet également orchestration des pipelines, permettant aux équipes de concevoir des flux de travail dans lesquels plusieurs LLM collaborent. Par exemple, un modèle peut gérer la classification du texte tandis qu'un autre effectue une analyse des sentiments, le tout au sein d'un pipeline unifié.

Ces outils d'orchestration sont complétés par de solides fonctionnalités de gestion des coûts.

Azure Machine Learning s'intègre parfaitement à Gestion des coûts Azure, fournissant un suivi détaillé des dépenses pour les déploiements LLM. Pour réduire les coûts, la plateforme propose Localiser les machines virtuelles, qui utilisent la capacité de calcul excédentaire d'Azure pour des tâches non critiques telles que la formation.

Le fonction de mise à l'échelle automatique ajuste automatiquement les ressources du processeur et du processeur graphique en fonction de la demande, garantissant ainsi une utilisation efficace. Pour des charges de travail prévisibles, Instances réservées proposent des tarifs réduits par rapport à la tarification à l'utilisation. En outre, Étiquettes de répartition des coûts permettez aux équipes de suivre les dépenses par projet, département ou type de modèle, en facilitant la planification budgétaire et la gestion des ressources.

La sécurité est la pierre angulaire d'Azure Machine Learning. La plateforme garantit chiffrement de bout en bout, en préservant les données et les artefacts de modèles en transit et au repos. Intégration avec Azure Active Directory prend en charge l'authentification unique et la gestion centralisée des identités.

Avec Intégration au réseau virtuel (VNet), les opérations de formation et d'inférence restent menées dans le cadre de réseaux privés. Les équipes peuvent également configurer Endpoints privés pour éliminer l'exposition à Internet, en répondant à des exigences de sécurité strictes pour les applications sensibles.

Azure Machine Learning respecte les principales normes du secteur, telles que SOC 1, SOC 2, NORME ISO 27001, HIPAA, et Rampe FedRamp. Des outils tels que Gestionnaire de conformité Azure contribuer à l'évaluation et à l'établissement de rapports continus, tout en Politique Azure automatise la gouvernance en appliquant les paramètres de sécurité, les politiques de conservation des données et les contrôles d'accès pour les nouveaux déploiements.

Azure Machine Learning est conçu pour évoluer, ce qui le rend adapté à tout, des expériences à modèle unique aux déploiements LLM à l'échelle de l'entreprise. Ses clusters de calcul peuvent allouer automatiquement des ressources de formation distribuées, prenant en charge à la fois le parallélisme des données et des modèles sur plusieurs GPU.

En s'intégrant à Service Azure Kubernetes (DEMANDE), la plateforme permet l'orchestration de conteneurs pour des configurations multimodèles complexes. Cela permet aux équipes de déployer des LLM sous forme de microservices, chacun doté de fonctionnalités de mise à l'échelle et de mise à jour indépendantes.

Avec une disponibilité dans plus de 60 régions Azure, la plateforme garantit un accès à faible latence pour les déploiements mondiaux, tout en maintenant une gestion et une surveillance centralisées. En outre, l'intégration avec Services cognitifs Azure permet aux équipes de combiner des LLM personnalisés avec des services d'IA prédéfinis, créant ainsi des solutions hybrides qui permettent de gagner du temps et offrent de la flexibilité pour répondre à des besoins spécifiques.

Transformateurs Hugging Face se distingue comme un outil open source conçu pour simplifier la gestion des grands modèles de langage (LLM). En tirant parti de cadres tels que PyTorch et TensorFlow, il fournit aux développeurs une plateforme intuitive et évolutive pour charger et gérer des milliers de modèles avec une seule ligne de code. L'accent mis sur l'accessibilité, l'efficacité et l'évolutivité en fait une solution incontournable pour les équipes qui jonglent avec plusieurs LLM.

À la base, Transformers est conçu pour rationaliser l'accès aux modèles, permettant une orchestration et une gestion des ressources efficaces.

La bibliothèque Transformers simplifie découverte et chargement de modèles avec des commandes concises. À l'aide du from_pretrained () fonction, les développeurs peuvent charger instantanément des modèles avec leurs tokeniseurs, leurs poids et leurs configurations - aucune configuration supplémentaire n'est requise.

Le API pour canalisations améliore encore la convivialité en permettant une commutation de tâches fluide et un versionnage automatique basé sur Git. Par exemple, vous pouvez facilement comparer les résultats de l'analyse des sentiments à partir de modèles tels que BERT, Roberta, et Distilbert en ajustant le paramètre du modèle dans votre pipeline. Chaque référentiel de modèles suit un historique complet des modifications, ce qui permet aux utilisateurs de revenir aux versions précédentes ou d'analyser les différences de performances entre les itérations.

Quand il s'agit de traitement par lots et inférence, la bibliothèque inclut un traitement par lots dynamique et une optimisation de l'attention, garantissant une gestion efficace des entrées de longueur variable. Des fonctionnalités telles que pointage de contrôle en dégradé aident à gérer la consommation de mémoire, en particulier lorsque vous travaillez avec des modèles à grande échelle.

Hugging Face Transformers fournit plusieurs outils pour optimiser l'utilisation du calcul et de la mémoire, ce qui en fait un choix rentable pour les entreprises. Quantification du modèle peut réduire la taille des modèles jusqu'à 75 % tout en maintenant les performances, ce qui est particulièrement utile pour gérer plusieurs modèles simultanément.

La bibliothèque propose également modèles distillés, tels que DisTiLbert, qui sont pré-optimisés pour des performances plus rapides et une utilisation réduite de la mémoire. Ces modèles fonctionnent environ 60 % plus vite et consomment 40 % de mémoire en moins par rapport à leurs homologues de taille standard, ce qui se traduit par des économies importantes pour les déploiements à grande échelle.

Chargement dynamique du modèle garantit une utilisation efficace des ressources en chargeant les modèles uniquement lorsque cela est nécessaire, au lieu de les conserver tous en mémoire en même temps. De plus, son mise en cache de modèles les stratégies permettent de trouver un équilibre entre l'utilisation de la mémoire et la vitesse de chargement, ce qui donne aux équipes la flexibilité d'allouer les ressources en fonction de la demande.

Pour encore plus d'efficacité, intégration avec Exécution ONNX améliore les performances dans les scénarios d'inférence basés sur le processeur, une option rentable pour les équipes qui cherchent à minimiser les dépenses liées au GPU. Cette capacité d'adaptation permet aux organisations de choisir des stratégies de déploiement adaptées à leurs besoins spécifiques.

Hugging Face Transformers est conçu pour évoluer sans effort, que vous meniez une seule expérience ou que vous gériez un environnement de production à grande échelle. Il prend en charge Configurations multi-GPU et le parallélisme des modèles, permettant d'utiliser des modèles qui dépassent la capacité de mémoire d'un seul appareil.

La bibliothèque s'intègre aux frameworks d'apprentissage automatique populaires tels que Ray et Dask, ce qui facilite la mise à l'échelle horizontale sur plusieurs machines. Cette compatibilité garantit une intégration fluide dans les pipelines MLOps existants, permettant aux équipes de déployer des LLM à grande échelle.

Par le biais du Hugging Face Hub, les organisations peuvent centraliser la gestion de leurs modèles grâce à des fonctionnalités telles que des référentiels privés, des contrôles d'accès et des politiques de gouvernance. Cette centralisation favorise la collaboration en équipe et garantit une supervision efficace d'un portefeuille de LLM.

Pour déploiements de production, les modèles Transformers peuvent être conteneurisés et déployés à l'aide d'outils tels que Docker, Kubernetes, ou des services natifs du cloud. Les interfaces standardisées de la bibliothèque garantissent un comportement cohérent dans différents environnements, simplifiant ainsi le déploiement de systèmes multimodèles complexes.

Le vaste écosystème communautaire constitue un autre avantage, car il propose des milliers de modèles, de jeux de données et d'optimisations préentraînés par les utilisateurs. Cet écosystème réduit la nécessité de créer des modèles à partir de zéro, fournissant des solutions prêtes à l'emploi pour un large éventail d'applications.

Comet ML se distingue comme une plate-forme d'apprentissage automatique robuste conçue pour simplifier le suivi, la surveillance et la gestion de plusieurs grands modèles de langage (LLM) tout au long de leur cycle de vie. En centralisant le suivi des expériences, le registre des modèles et le suivi de la production, il complète les stratégies intégrées évoquées précédemment. Cela en fait un outil idéal pour les organisations qui gèrent simultanément de nombreux LLM.

Le système de suivi des expériences de Comet ML capture et organise automatiquement les données des sessions de formation LLM. Il enregistre les hyperparamètres, les métriques, les versions de code et l'utilisation des ressources du système en temps réel, créant ainsi un enregistrement détaillé permettant de comparer les performances entre différents modèles et configurations.

Le registre des modèles de la plateforme sert de hub centralisé pour le stockage, la gestion des versions et la gestion de plusieurs LLM. Il inclut des métadonnées détaillées telles que des benchmarks de performance, des ensembles de données de formation et les exigences de déploiement, afin de garantir que les équipes disposent de toutes les informations dont elles ont besoin en un seul endroit.

Les tableaux de bord personnalisables permettent des comparaisons automatisées, permettant aux équipes d'identifier rapidement les modèles les plus performants en évaluant des indicateurs tels que la précision, les temps d'inférence et l'utilisation des ressources. L'espace de travail collaboratif améliore encore la productivité en permettant aux membres de l'équipe de partager des expériences, d'annoter les résultats et de discuter des résultats de manière efficace, rationalisant ainsi la communication et la prise de décisions tout au long du cycle de vie du modèle.

Comet ML assure un suivi approfondi des ressources, surveille l'utilisation du GPU, les temps d'entraînement et les coûts de calcul pour les expériences LLM. Ces données permettent d'identifier les opportunités de réduction des dépenses en ajustant les hyperparamètres et en optimisant les configurations de formation. Un tableau de bord des coûts dédié consolide les données relatives aux dépenses des projets et des membres de l'équipe, offrant des informations claires sur les coûts d'infrastructure et permettant de prendre des décisions plus intelligentes en matière d'allocation des ressources.

La plateforme donne la priorité à la sécurité grâce à des fonctionnalités telles que l'authentification unique (SSO), les contrôles d'accès basés sur les rôles et la journalisation des audits pour protéger les données sensibles des modèles et les processus de formation. Pour les organisations nécessitant un contrôle supplémentaire, les options de déploiement de cloud privé permettent à Comet ML de fonctionner au sein de leur propre infrastructure. Ces mesures de sécurité garantissent que la plateforme peut évoluer en toute sécurité, même dans des environnements complexes multi-LLM.

Comet ML est conçu pour répondre aux exigences liées à la gestion de plusieurs LLM dans des configurations de formation distribuées. Il suit efficacement les expériences sur plusieurs GPU et machines, offrant une vue unifiée de la progression de l'entraînement et de l'utilisation des ressources. L'intégration des API garantit une intégration fluide dans les pipelines MLOps existants, tandis que l'organisation multi-espaces de travail permet aux grandes organisations de segmenter les projets par équipe, département ou cas d'utilisation, tout en maintenant une supervision centralisée sans sacrifier la flexibilité.

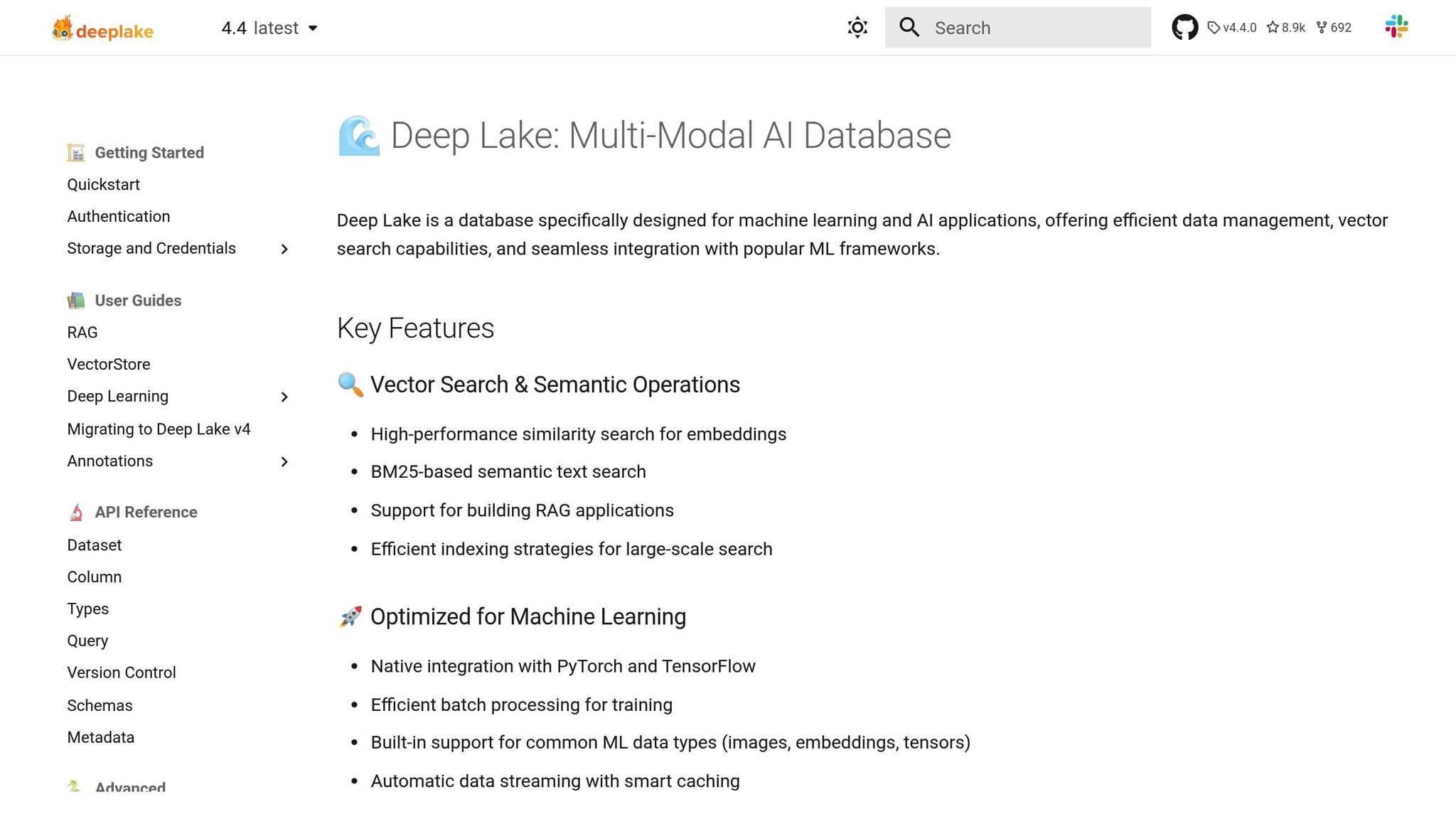

DeepLake associe l'adaptabilité des lacs de données à la précision des bases de données vectorielles, jetant ainsi les bases de flux de travail multi-LLM efficaces.

DeepLake est conçu pour les opérations LLM à grande échelle, en constante évolution pour répondre aux besoins de l'industrie. Il associe l'adaptabilité des lacs de données à la précision des bases de données vectorielles, permettant un flux de données fluide entre plusieurs LLM grâce à sa fonction « Symbiotic Model Engagement ». De plus, des outils tels que « Agile Evolution » et « Chronological Adaptivity » permettent un recalibrage rapide et une synchronisation en temps réel, garantissant ainsi l'efficacité et la mise à jour des flux de travail.

Les capacités de mémoire avancées de la plate-forme améliorent la récupération de points de données similaires et affinent les intégrations vectorielles, améliorant ainsi les performances LLM. DeepLake s'intègre également aux principaux frameworks d'IA, prenant en charge des applications telles que la génération augmentée de récupération et d'autres solutions pilotées par le LLM.

En se concentrant sur la gestion dynamique des données, DeepLake renforce l'écosystème multi-LLM, garantissant un support continu pour les flux de travail d'IA avancés tout en maintenant des opérations rentables.

DeepLake donne la priorité à l'allocation intelligente des ressources pour garantir à la fois des performances et des économies de coûts.

Sa base de données tensorielle gérée réduit les dépenses de stockage tout en permettant une diffusion de données à haut débit en temps réel. En outre, le stockage vectoriel efficace de la plate-forme réduit les exigences de calcul, garantissant ainsi des opérations fluides sans frais supplémentaires inutiles.

DeepLake intègre des mesures de sécurité robustes dans le cadre de son initiative « Data Fortification », offrant des fonctionnalités conçues pour protéger l'intégrité des données et prévenir la corruption. Il fournit également des guides de mise en œuvre détaillés pour aider à maintenir des environnements multi-LLM sécurisés. Cependant, ses fonctionnalités de sécurité au niveau de l'entreprise sont quelque peu limitées par rapport aux solutions de base de données vectorielles spécialisées. Les organisations ayant des besoins de conformité stricts doivent évaluer si leurs offres de sécurité actuelles répondent à leurs exigences. Malgré cela, DeepLake reste un acteur clé de la gestion unifiée multi-LLM, alliant sécurité et efficacité opérationnelle.

L'architecture axée sur le cloud de DeepLake prend en charge des charges de travail multi-LLM évolutives et hautes performances. Grâce à sa compatibilité multicloud et à une base de données tensorielle gérée, il facilite la diffusion de données en temps réel et une allocation flexible des ressources. Cela le rend adapté à de nombreuses applications, des chatbots réactifs aux modèles complexes traitant de vastes ensembles de données documentaires.

Le tableau ci-dessous met en évidence les principales fonctionnalités des plateformes populaires, ce qui facilite le choix de la bonne solution pour gérer plusieurs LLM.

Chaque plateforme se distingue par ses atouts uniques. Prompts.ai excelle en matière de gestion unifiée et de rentabilité. Amazon SageMaker et Apprentissage automatique Azure s'intègrent parfaitement aux écosystèmes d'entreprise. Transformateurs Hugging Face est idéal pour les expériences fondées sur le code, tandis que Comète ML brille dans le suivi des expériences. Lac Deep est conçu pour les flux de travail gourmands en données.

Au moment de prendre une décision, tenez compte de l'expertise de votre équipe, de l'infrastructure existante et des besoins spécifiques en matière de gestion des LLM. Les équipes qui se concentrent sur la rentabilité et la gouvernance peuvent se tourner vers des plateformes dotées d'outils FinOps, tandis que celles qui accordent la priorité à l'expérimentation peuvent préférer des fonctionnalités de suivi détaillé et de comparaison des performances. Alignez ces fonctionnalités avec vos objectifs pour trouver la solution la mieux adaptée à votre configuration multi-LLM.

La gestion efficace de plusieurs grands modèles linguistiques nécessite des outils intégrés, une stratégie claire et une gouvernance solide. Les plateformes abordées ici mettent l'accent sur les interfaces unifiées, la gestion stricte des coûts et la sécurité au niveau de l'entreprise.

Lors de l'évaluation des plateformes, il est essentiel d'aligner votre choix sur l'infrastructure et les objectifs uniques de votre organisation. Pour les équipes qui priorisent gestion des coûts et rationalisation de la supervision, les plateformes proposant des outils FinOps en temps réel et une facturation consolidée se démarquent. D'autre part, les équipes qui se concentrent sur l'expérimentation et la personnalisation peuvent se tourner vers des bibliothèques open source et des options de déploiement flexibles adaptées à leurs besoins.

L'efficacité des flux de travail est la pierre angulaire du succès. Des fonctionnalités telles que la comparaison de modèles côte à côte, le suivi systématique des expériences et la gestion standardisée des rapides peuvent réduire considérablement le temps passé à jongler avec les outils et à gérer des systèmes éparpillés. Ce type d'efficacité devient de plus en plus précieux à mesure que les équipes développent leurs opérations d'IA et abordent des cas d'utilisation de plus en plus complexes.

La gouvernance, la conformité et la transparence des coûts restent non négociables. Les plateformes dotées de pistes d'audit complètes, d'un accès basé sur les rôles et de structures tarifaires claires permettent aux organisations de répondre aux exigences réglementaires tout en maîtrisant leurs dépenses. Des outils tels que le suivi de l'utilisation en temps réel et les notifications budgétaires empêchent non seulement les dépenses excessives, mais garantissent également que les investissements dans l'IA génèrent une valeur maximale.

Alors que le paysage du LLM continue d'évoluer, il est essentiel de sélectionner des plateformes qui équilibrent les besoins immédiats avec l'évolutivité pour garder une longueur d'avance. Le bon choix constitue une base solide, qui soutient à la fois les projets en cours et l'inévitable croissance de l'adoption de l'IA au sein de votre organisation.

Prompts.ai vous aide à réduire vos coûts opérationnels jusqu'à 98 % tout en gérant plusieurs grands modèles de langage. En regroupant toutes vos opérations sous un même toit, il simplifie les flux de travail et élimine les étapes inutiles, améliorant ainsi l'efficacité et les performances globales.

Conçu en tenant compte des défis des systèmes d'IA complexes, Prompts.ai vous permet de tirer le meilleur parti de vos modèles sans augmenter les dépenses.

Prompts.ai met l'accent sur la sécurité et la conformité réglementaire, en fournissant aux utilisateurs de puissants outils pour protéger et gérer les grands modèles linguistiques (LLM). Les principales fonctionnalités incluent surveillance de la conformité pour répondre aux exigences réglementaires, outils de gouvernance pour gérer l'accès et l'utilisation, et analyses détaillées pour évaluer et améliorer efficacement les performances du modèle.

La plateforme propose également pool de stockage centralisé et outils d'administration pour simplifier les flux de travail tout en maintenant un contrôle strict. Cela garantit que vos opérations LLM restent sécurisées, efficaces et bien organisées à tout moment.

Prompts.ai facilite la mise à l'échelle grâce à des outils conçus pour gérer efficacement plusieurs instances de grands modèles de langage (LLM). La plateforme vous permet de coordonner les flux de travail, de suivre les performances et de simplifier les opérations, même lorsque vous gérez des dizaines ou des centaines de LLM à la fois.

Principales fonctionnalités telles que gestion centralisée, flux de travail automatisés, et réglage des performances assurez-vous que vos systèmes d'IA restent fiables et adaptables, quelle que soit la complexité de votre configuration. Il s'agit d'une solution incontournable pour les développeurs et les professionnels de l'IA qui supervisent des déploiements multimodèles étendus.