Reduzca los costos de los tokens de IA hasta en un 98%

Los flujos de trabajo de IA están aumentando los gastos simbólicos para las empresas estadounidenses, ya que la existencia de múltiples LLM suele generar ineficiencias y riesgos de cumplimiento. Las plataformas de múltiples LLM resuelven este problema centralizando el acceso a los modelos, rastreando el uso de los tokens y optimizando los costos. Estas herramientas pueden ayudar a las empresas a ahorrar hasta 98% en gastos simbólicos al tiempo que mejora la gobernanza y la transparencia.

Conclusiones clave:

Descripción general rápida de las principales plataformas:

Comparación rápida

Estas plataformas son esenciales para las empresas que buscan optimizar el gasto en IA y, al mismo tiempo, mantener el control y el cumplimiento. Elija en función de los patrones de uso de los tokens, las necesidades presupuestarias y los requisitos reglamentarios de su organización.

Al seleccionar una plataforma de varios LLM, es fundamental centrarse en las funciones que ayudan a gestionar los costos de los tokens de forma eficaz y, al mismo tiempo, respaldar el crecimiento de su organización. Estos son los aspectos más importantes a tener en cuenta:

Seguimiento detallado del uso de los tokens es esencial para mantener los costos bajo control. Elija plataformas que ofrezcan información detallada sobre el consumo de tokens, desglosándola por llamadas a la API, sesiones de usuario o unidades de negocio. Este nivel de detalle ayuda a los equipos financieros a identificar los factores que impulsan los costos y a asignarlos con precisión.

Monitorización de costos en tiempo real en USD simplifica la presupuestación al proporcionar comentarios instantáneos sobre los gastos simbólicos. Los paneles que convierten el uso de los tokens en montos en dólares permiten a los equipos ajustar su uso de forma proactiva, evitando picos de costes inesperados.

Acceso unificado a múltiples LLM agiliza las operaciones y reduce los costos al eliminar la necesidad de suscripciones independientes y tarifas redundantes. Un único punto de acceso reduce la complejidad y mejora la eficiencia.

Herramientas de FinOps para la supervisión del presupuesto son indispensables para gestionar los gastos. Las funciones de presupuestación, combinadas con las alertas sobre posibles excedentes, permiten a los equipos mantenerse dentro de sus límites y optimizar el uso para cumplir los objetivos financieros.

Cumplimiento normativo no es negociable, especialmente en industrias con requisitos de gobierno estrictos. Las plataformas deben incluir pistas de auditoría sólidas y herramientas de gobernanza para garantizar la rendición de cuentas y la alineación con la normativa estadounidense.

Escalabilidad para las necesidades empresariales garantiza que la plataforma pueda crecer junto con su organización. Funciones como los controles de acceso basados en roles y la administración escalable de usuarios son cruciales para adaptarse a los equipos más grandes y a los requisitos cambiantes.

Integración perfecta con las herramientas existentes minimiza las interrupciones al incorporar capacidades de inteligencia artificial en sus flujos de trabajo actuales. Esto reduce la fricción y la necesidad de una formación exhaustiva, lo que facilita la adopción.

Por último, Modelos de precios de pago por uso ofrecen flexibilidad al vincular los costos directamente al uso. Esto elimina las grandes inversiones iniciales y le permite escalar las iniciativas de IA en función de resultados comprobados.

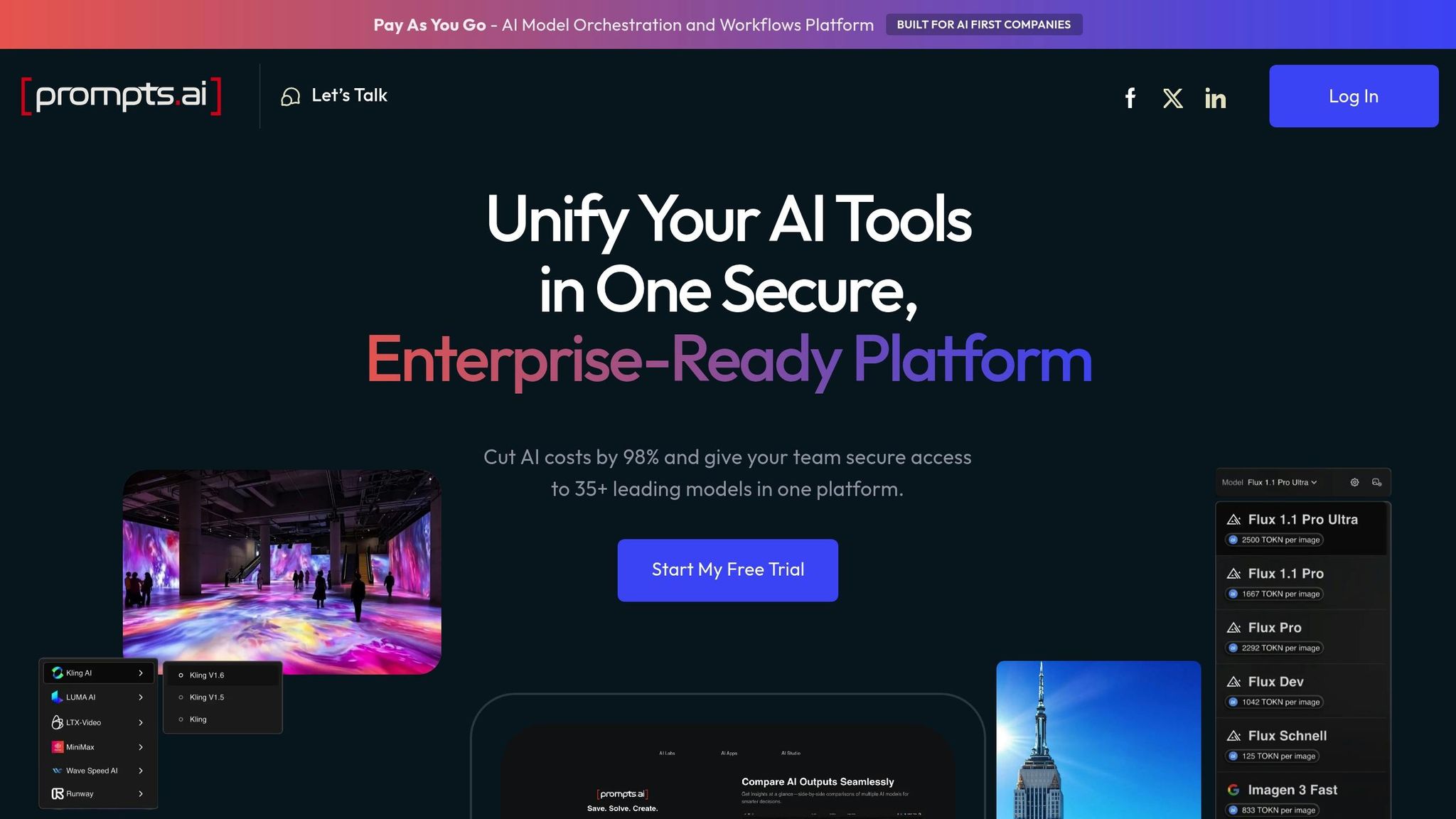

Prompts.ai es una plataforma de varios LLM diseñada para optimizar los costos de los tokens y, al mismo tiempo, garantizar la seguridad y el cumplimiento a nivel empresarial. Reúne el acceso a más de 35 modelos lingüísticos de primer nivel, incluidos el GPT-4.1, el GPT-4.5, el Gemini 2.5 Pro, el Llama 4 y el Command R, en una interfaz optimizada. Esto simplifica la administración de varios modelos, lo que hace que las operaciones sean más eficientes y reduce los gastos. Estas funciones abordan directamente los desafíos relacionados con el costo de los tokens discutidos anteriormente.

La plataforma utiliza su sistema de créditos TOKN patentado para proporcionar información detallada sobre el uso de los tokens en todos los modelos compatibles. Los paneles de control en tiempo real ofrecen un desglose del consumo de tokens por modelo, usuario y proyecto, mientras que las tendencias históricas se muestran en formato MM/DD/AAAA, alineándose con los estándares empresariales estadounidenses.

Las organizaciones pueden exportar los informes de uso en formatos que cumplan con las normas de contabilidad de EE. UU., lo que facilita el seguimiento de los gastos y la asignación de los costos entre los departamentos. Las herramientas de análisis destacan los patrones de uso excesivo e identifican las indicaciones ineficientes, lo que ayuda a los equipos a crear flujos de trabajo eficaces y económicos.

Por ejemplo, un proveedor de atención médica estadounidense de tamaño mediano implementó Prompts.ai para gestionar las interacciones con IA abierta y Google LLM para sus chatbots de asistencia al paciente. Al utilizar las funciones de optimización y seguimiento de costes de la plataforma, redujeron sus gastos mensuales en fichas en un 25%, a la vez que mantuvieron la calidad del servicio y cumplieron la normativa de la HIPAA.

El acceso unificado de la plataforma a múltiples LLM mejora aún más la eficiencia de la administración de los tokens.

Prompts.ai permite cambiar fácilmente entre modelos a través de un único punto final de API. Admite configuraciones y límites de uso específicos del modelo, todos gestionados desde una interfaz centralizada. Este sistema unificado reduce las tareas administrativas y permite a los equipos dirigir las solicitudes al modelo más rentable para cualquier tarea determinada.

Este enfoque centralizado también se vincula con capacidades precisas de seguimiento financiero y elaboración de presupuestos.

Prompts.ai ofrece herramientas de operaciones financieras adaptadas a las necesidades de las empresas estadounidenses. Los administradores pueden establecer límites de uso de los tokens (en USD) de forma mensual o trimestral, con alertas automatizadas para evitar gastos excesivos. La plataforma afirma que puede ayudar a las organizaciones a reducir los costos relacionados con la IA hasta en un 98%, abordando el problema de la «proliferación de herramientas de IA» mediante la consolidación de las herramientas y la optimización del uso de los tokens.

Las herramientas de presupuestación proporcionan previsiones de costos basadas en el uso anterior, consejos prácticos para mejorar la eficiencia inmediata y la agrupación de TOKN para permitir a los equipos compartir los créditos de manera efectiva. La facturación se gestiona en dólares estadounidenses, y las facturas detalladas se generan mensual o trimestralmente en formatos compatibles con el software financiero estadounidense más utilizado.

Prompts.ai está diseñado para cumplir con los estándares de cumplimiento clave de las organizaciones estadounidenses, incluidas la HIPAA y la CCPA, y garantiza la residencia de los datos en EE. UU. Los registros de auditoría exhaustivos brindan a las organizaciones la transparencia necesaria para cumplir con los requisitos reglamentarios.

La plataforma también admite la escalabilidad empresarial con funciones como la integración del inicio de sesión único (SSO), la compatibilidad con los proveedores de identidad estándar de EE. UU. y los controles de acceso basados en funciones para administrar estructuras organizativas complejas. Puede gestionar varios equipos o unidades de negocio en una sola cuenta, con herramientas de gobierno que mantienen la supervisión sin obstaculizar la innovación.

Prompts.ai se integra perfectamente con los principales proveedores de nube de EE. UU. a través de las API y los SDK RESTful, lo que facilita la implementación en las infraestructuras de TI existentes. El servicio de atención al cliente localizado está disponible durante el horario laboral de EE. UU. para ayudar con la implementación y la optimización continua.

Helicone sirve como una plataforma diseñada para simplificar la administración de los gastos simbólicos en varios LLM. Al combinar un análisis de costos detallado con un enrutamiento inteligente, ofrece a los usuarios una visión clara del uso y los precios del modelo. Ya sea mediante una integración directa o un enfoque basado en pasarelas, Helicone garantiza que el seguimiento de los costos sea accesible y preciso.

Helicone proporciona cálculos de costos de alta precisión a través de su AI Gateway, aprovechando el Model Registry v2 para un seguimiento 100% preciso. Para quienes utilizan integraciones directas, ofrece estimaciones de costos aproximadas a través de un repositorio de código abierto. Este repositorio incluye datos de precios para más de 300 modelos y utiliza la detección automática de modelos y el recuento de tokens para proporcionar estimaciones confiables.

La plataforma también ayuda a los usuarios a obtener una visión más profunda de sus gastos al agrupar las solicitudes relacionadas en sesiones, que reflejan los costos de las interacciones completas de los usuarios. Además, los usuarios pueden segmentar sus gastos mediante propiedades personalizadas, lo que permite el análisis por categorías como Nivel de usuario, Característica, o Medio ambiente.

Helicone va más allá del seguimiento al ofrecer servicios financieros avanzados herramientas para optimizar el gasto. Su AI Gateway selecciona dinámicamente los modelos en función de los precios en tiempo real y admite el enrutamiento prioritario con BYOK (traiga su propia clave), lo que garantiza una gestión eficiente de los costos en varios proveedores de LLM.

TrueFoundry es una plataforma diseñada para que las empresas simplifiquen la implementación de varios modelos lingüísticos de gran tamaño y, al mismo tiempo, ofrece monitoreo en tiempo real y alertas presupuestarias automatizadas para el uso de tokens en los flujos de trabajo de IA. Cuenta con paneles para el seguimiento de los tokens en tiempo real, análisis de costos en USD y controles financieros avanzados que cumplen con los estándares de cumplimiento de los EE. UU.

True Foundry el panel centralizado proporciona información clara sobre el uso de los tokens, que muestra métricas en tiempo real con costos convertidos a USD. Desglosa el consumo de tokens por modelo, grupo de usuarios y proyecto, lo que permite a las empresas asignar los gastos con precisión entre los departamentos. Los datos históricos se presentan en formato MM/DD/AAAA, lo que permite a los equipos financieros de EE. UU. revisar las tendencias de gasto e identificar las áreas en las que se pueden ahorrar costos.

El motor de análisis de la plataforma identifica patrones de uso elevado y recomienda opciones de modelos más rentables para tareas específicas. Los informes de uso detallados se pueden exportar en formatos compatibles con el software de contabilidad estándar de EE. UU., lo que simplifica el seguimiento de los gastos y la conciliación del presupuesto.

TrueFoundry incluye un conjunto completo de herramientas de operaciones financieras, que ofrece controles presupuestarios automatizados con límites de gastos ajustables en USD. Los administradores pueden establecer presupuestos mensuales o trimestrales y recibir alertas escalonadas al 75%, el 90% y el 100% del límite. Para evitar gastos excesivos, la plataforma detiene las solicitudes no esenciales una vez que se superan los presupuestos.

Para optimizar los costos, TrueFoundry emplea modelos de enrutamiento inteligentes y selecciona automáticamente el LLM más asequible que cumpla con los criterios de rendimiento de cada solicitud. También proporciona previsiones de costes basadas en datos históricos, lo que permite a las organizaciones planificar los presupuestos de IA con mayor precisión.

TrueFoundry está diseñado para gestionar despliegues empresariales a gran escala, e incluye controles de acceso basados en funciones, integración de inicio de sesión único (SSO) con los principales proveedores de identidad de EE. UU. y registros de auditoría detallados para garantizar el cumplimiento de la normativa. La plataforma garantiza la residencia de los datos dentro de las fronteras de EE. UU. y ofrece informes de cumplimiento para marcos como la HIPAA y el SOC 2.

Da soporte a miles de usuarios en varias unidades de negocio y ofrece centros de costos jerárquicos y opciones de facturación departamental. La integración con las herramientas empresariales existentes es perfecta, gracias a las API RESTful y a los conectores prediseñados para las plataformas en la nube más utilizadas en EE. UU.

Agenta se ha diseñado teniendo en cuenta la gestión de costes y ofrece una plataforma multiLLM fiable que prioriza la claridad en el uso de los tokens y el seguimiento eficiente de los gastos. Su interfaz fácil de usar proporciona actualizaciones en tiempo real sobre el consumo de tokens, lo que ayuda a los equipos de desarrollo de IA a controlar sus presupuestos y evitar gastos excesivos.

Agenta equipa a los equipos con herramientas para monitorear de cerca el uso de los tokens en varios modelos y proyectos. A través de su panel de control intuitivo, los usuarios pueden analizar datos detallados de consumo y tendencias de gasto. Este nivel de transparencia garantiza que las organizaciones mantengan el control sobre sus costos relacionados con la IA y tomen decisiones más inteligentes a la hora de asignar los recursos.

Langfuse es una plataforma de múltiples LLM diseñada para proporcionar información detallada sobre el uso y los costos de los tokens, y ofrece herramientas para administrar y optimizar los gastos relacionados con la IA de manera efectiva.

Langfuse permite a los usuarios importar datos de uso y costos directamente desde las respuestas de LLM a través de API, SDK o integraciones. Esto garantiza un seguimiento preciso del consumo real. Cuando los datos de costos directos no están disponibles, la plataforma estima los valores utilizando tokenizadores predefinidos y modelos de precios de proveedores como OpenAI, Antrópico, y Google. Esta información detallada permite a los usuarios supervisar de cerca sus gastos y mantener un mejor control sobre sus presupuestos.

Con sus capacidades de seguimiento precisas, Langfuse admite herramientas avanzadas de FinOps para agilizar la gestión de gastos de la IA. La API Daily Metrics proporciona datos agregados sobre el uso diario y los costos, que se pueden filtrar por aplicación, usuario o etiquetas. Los usuarios también pueden definir sus propios modelos, incluidas las versiones autohospedadas o ajustadas, y establecer precios personalizados para los diferentes tipos de uso, lo que permite una presupuestación personalizada y una optimización de costos.

La siguiente tabla describe las principales características, beneficios, inconvenientes, estructuras de precios y opciones de cumplimiento para varias plataformas, lo que ayuda a las empresas a evaluar qué solución se ajusta a sus objetivos operativos y de administración de costos.

Esta tabla proporciona una descripción general de las capacidades de las plataformas, centrándose en las funciones de cumplimiento y administración de costos. Destaca el enfoque integral de Prompts.ai, con sus créditos TOKN de pago por uso y sus sólidas herramientas de gobierno, mientras que Helicone destaca por su monitoreo de costos en tiempo real. Las plataformas con entradas «N/A» requieren una investigación más profunda para comprender sus posibles ofertas.

Información clave: Las investigaciones muestran que la optimización del uso de la LLM puede reducir los costos de inferencia hasta en un 98%, a la vez que se mantiene o mejora el rendimiento.

Consideraciones empresariales: Prompts.ai ofrece herramientas avanzadas de FinOps y capacidades de automatización, lo que lo convierte en un candidato sólido para las organizaciones que priorizan la gobernanza y la eficiencia. La fortaleza de Helicone radica en su seguimiento de costos en tiempo real, que ofrece a las empresas información inmediata sobre los patrones de gasto. En el caso de las plataformas con datos incompletos, es esencial profundizar en sus funciones y precios para tomar una decisión informada.

Al elegir una plataforma, las empresas deben equilibrar los costos iniciales con los posibles ahorros simbólicos para lograr eficiencias significativas a largo plazo.

Tras explorar los aspectos clave de varias plataformas, queda claro que elegir la solución de multiLLM adecuada es una decisión fundamental para las empresas estadounidenses que se enfrentan a flujos de trabajo complejos de IA.

Para las organizaciones que buscan administrar los costos de los tokens de manera efectiva, es esencial alinear las capacidades de la plataforma con las prioridades operativas. Esto incluye abordar desafíos como la sobrecarga de herramientas y cumplir con los estándares de cumplimiento. Prompts.ai destaca por su sistema de créditos TOKN de pago por uso, que ofrece hasta Reducción de costos del 98%. Este enfoque no solo reduce los gastos, sino que también libera recursos para reinvertirlos en avances. Con acceso a más de 35 modelos lingüísticos de primer nivel y una sólida gobernanza empresarial, Prompts.ai ofrece una solución integral a los obstáculos operativos.

Al evaluar las plataformas de múltiples LLM, las empresas deben centrarse en factores como la transparencia de los precios, las sólidas funciones de gobierno y la escalabilidad. Al sopesar las exigencias del flujo de trabajo, las necesidades de cumplimiento y las limitaciones presupuestarias, las empresas pueden lograr el equilibrio adecuado entre el gasto inicial y los ahorros a largo plazo.

Las plataformas de múltiples LLM se destacan por reducir los costos de los tokens mediante técnicas inteligentes como optimización rápida, modelo en cascada, y generación aumentada de recuperación (RAG). Estos métodos ayudan a reducir el uso de los tokens al comprimir las solicitudes, reutilizar las respuestas para consultas similares y asignar tareas a los modelos más eficientes.

Otras estrategias incluyen almacenamiento en caché semántico, que evita el uso innecesario de tokens al guardar los resultados de las preguntas más frecuentes, y enrutamiento dinámico, lo que garantiza que las consultas se gestionen con el modelo más rentable. En conjunto, estos enfoques pueden reducir los gastos relacionados con los tokens hasta en un 98%, lo que hace que los flujos de trabajo de IA sean más asequibles y escalables.

Al seleccionar una plataforma de múltiples LLM para administrar los costos de manera efectiva, es crucial buscar herramientas que ofrezcan seguimiento del uso de tokens en tiempo real. Esta función debería permitir a las empresas supervisar el uso en diferentes niveles (ya sea por agente, modelo o proyecto), ofreciendo una visión transparente de los patrones de gasto y destacando las áreas en las que los costos pueden ser innecesariamente altos.

Otra capacidad clave a tener en cuenta es análisis en tiempo real. Estos conocimientos permiten a las empresas identificar rápidamente las tendencias de gasto y realizar ajustes oportunos, lo que ayuda a evitar cargos inesperados. Igualmente importante es enrutamiento de modelos automatizados, lo que garantiza que las solicitudes se dirijan a los terminales modelo más rentables. Esto no solo optimiza el rendimiento, sino que también mantiene los gastos bajo control.

Centrarse en estas funciones puede ayudar a las empresas a tomar el control de los costos relacionados con los tokens y a optimizar sus flujos de trabajo de IA de manera más eficiente.

Prompts.ai garantiza el cumplimiento de las normativas estadounidenses, como HIPAA (Ley de Portabilidad y Responsabilidad del Seguro Médico) y CCPA (Ley de Privacidad del Consumidor de California) mediante el empleo de estrictas medidas de privacidad y protección de datos. Estas incluyen métodos de cifrado avanzados, prácticas seguras de gestión de datos y herramientas para gestionar el consentimiento de los usuarios, todo ello diseñado para proteger la información confidencial de forma eficaz.

La plataforma también se mantiene atenta a los cambios regulatorios y actualiza sus prácticas según sea necesario para alinearlas con los estándares legales en evolución. Este compromiso ayuda a las organizaciones a utilizar con confianza las soluciones impulsadas por la inteligencia artificial y, al mismo tiempo, a cumplir con las leyes aplicables.