Los grandes modelos lingüísticos (LLM) están transformando la forma en que las empresas analizan los datos y toman decisiones. Desde comparar productos a evaluar a los proveedores, estas herramientas agilizan los flujos de trabajo complejos. Sin embargo, no todas las plataformas de LLM ofrecen los mismos resultados. Este artículo evalúa seis plataformas clave: Prompts.ai, IA abierta GPT, Antrópico Claudio, Google Géminis, Meta Llama, y Mistral - en función de sus características, costo, gobierno y casos de uso.

Conclusiones clave:

Comparación rápida:

Cada plataforma se destaca en áreas específicas, por lo que la elección depende de sus necesidades de flujo de trabajo, presupuesto y seguridad. Para una orquestación de IA flexible y rentable, Prompts.ai destaca, mientras que las tareas especializadas pueden beneficiarse de soluciones específicas como OpenAI GPT o Meta Llama.

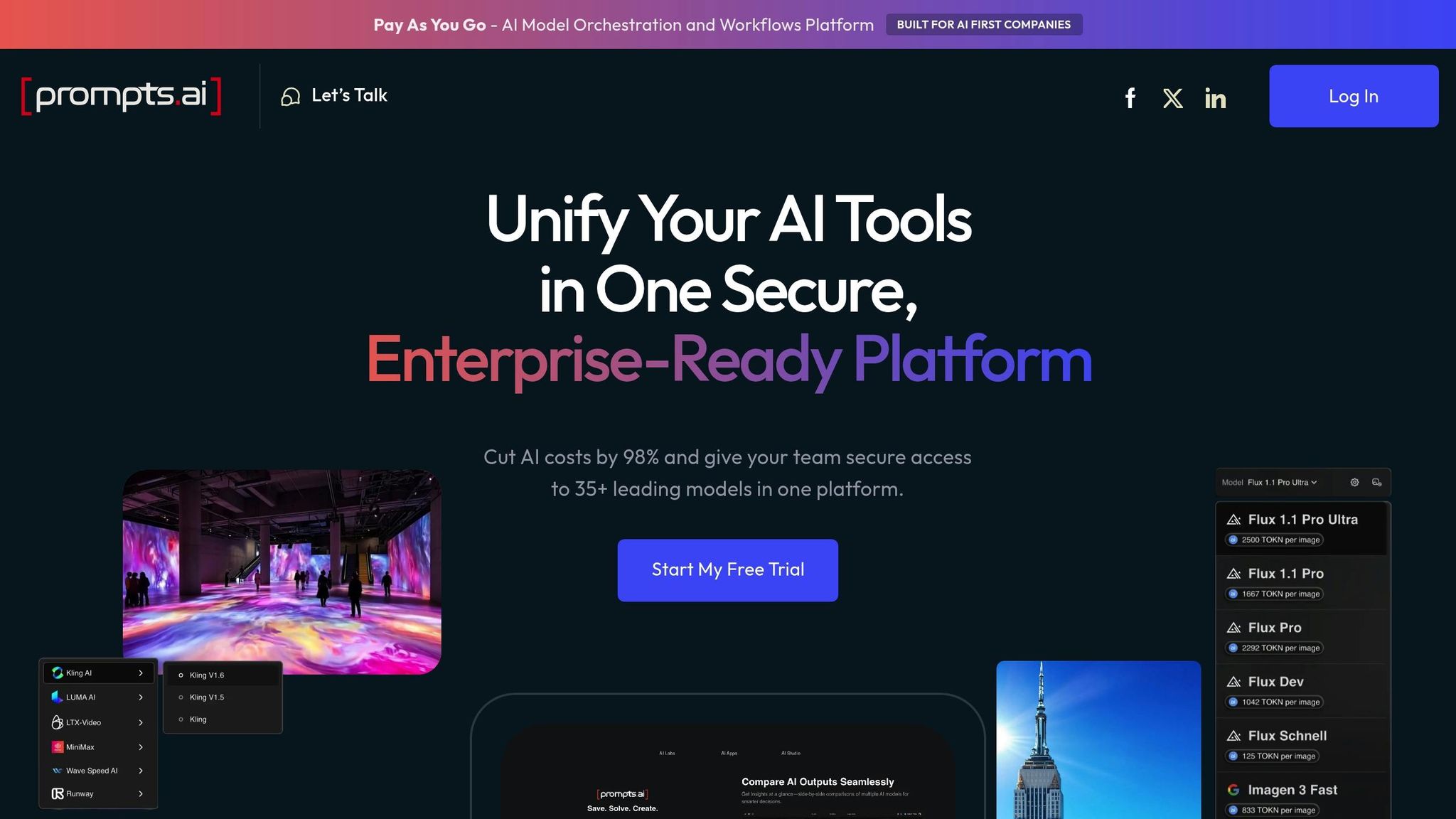

Prompts.ai reúne más de 35 LLM de nivel empresarial, como GPT de OpenAI, Claude de Anthropic, LLama de Meta, Gemini de Google y Mistral, en una plataforma unificada y segura. Al eliminar la necesidad de múltiples suscripciones, ofrece una interfaz optimizada en la que los equipos pueden enviar mensajes idénticos a diferentes modelos simultáneamente. Esto facilita la determinación de qué modelo funciona mejor para tareas como la generación de contenido, la revisión del código o la gestión del razonamiento basado en hechos.

La característica más destacada de la plataforma es su capacidad para permitir la comparación de modelos en paralelo, lo que aumenta la productividad hasta 10 veces. Este acceso centralizado no solo simplifica las comparaciones, sino que también alivia los desafíos técnicos que implica la administración de varios modelos.

Prompts.ai automatiza los procesos clave, como la autenticación, los límites de velocidad y el formato de las respuestas, lo que garantiza un acceso sin problemas a los modelos existentes y emergentes. Los equipos pueden probar los nuevos modelos a medida que se introducen sin necesidad de claves de API adicionales ni enfrentarse a las complejidades de facturación. Este enfoque simplificado permite a las organizaciones mantenerse al día sin interrumpir sus flujos de trabajo.

La plataforma utiliza un sistema de créditos TOKN unificado para el seguimiento del uso en tiempo real y el análisis detallado, lo que ayuda a las empresas a reducir los gastos relacionados con la IA hasta en un 98%. Para las organizaciones, los planes empresariales incluyen la agrupación de TOKN, lo que permite compartir los presupuestos crediticios entre los equipos.

Los precios comienzan en 0 USD al mes para un plan de pago por uso con créditos limitados. Para quienes necesiten funciones más sólidas, el plan Elite está disponible a un precio de 129 USD por miembro y mes, y ofrece 1 000 000 000 de créditos TOKN. Los planes anuales incluyen un descuento del 10% para quienes se comprometan a largo plazo.

Para los clientes empresariales, Prompts.ai incluye herramientas avanzadas de gobierno y administración en sus planes de nivel empresarial. Estas herramientas garantizan el cumplimiento de los estrictos estándares del sector, entre los que se incluyen SOC 2 tipo II, HIPAA, y GDPR. La plataforma inició su SOC 2 tipo II audite el 19 de junio de 2025 y supervise activamente sus controles a través de Vanta. Los usuarios pueden acceder a las actualizaciones de seguridad en tiempo real a través del Trust Center, mientras que funciones como los registros de auditoría, los controles de acceso de los usuarios y la supervisión del cumplimiento proporcionan transparencia y responsabilidad en cuanto al uso de los modelos en toda la organización.

Prompts.ai es particularmente útil para los equipos que necesitan evaluar varios modelos comparándolos con puntos de referencia específicos. Su compatibilidad con bibliotecas de mensajes personalizadas y con el control de versiones lo convierte en una herramienta excelente para los flujos de trabajo de comparación iterativos.

La plataforma ha demostrado su valor en una variedad de aplicaciones. Por ejemplo, Art June Chow, arquitecta, compartió su experiencia:

«Ahora, al comparar diferentes LLM en paralelo en prompts.ai, puede dar vida a proyectos complejos mientras explora conceptos innovadores y oníricos».

Prompts.ai tiene una calificación de usuario de 4,8 sobre 5, y muchos revisores elogian su capacidad para simplificar los flujos de trabajo complejos y mejorar la productividad mediante comparaciones sistemáticas de modelos.

La familia OpenAI GPT representa una serie de modelos lingüísticos avanzados diseñados para comprender y generar texto similar al humano. Estos modelos, con su capacidad para procesar y producir respuestas coherentes y relevantes desde el punto de vista del contexto, se han convertido en la piedra angular de las aplicaciones impulsadas por la inteligencia artificial. Desde el GPT-1 hasta las versiones más recientes, como el GPT-4, cada versión ha mejorado la comprensión, el razonamiento y la versatilidad del lenguaje, lo que las convierte en herramientas invaluables para una amplia gama de industrias y casos de uso.

La serie Claude de Anthropic pone un fuerte énfasis en la seguridad, las consideraciones éticas y la toma de decisiones equilibrada. Diseñados para gestionar tareas analíticas complejas, estos modelos están diseñados para proporcionar perspectivas justas e imparciales, lo que es especialmente importante cuando se realizan evaluaciones comparativas detalladas. Este compromiso con la claridad ética garantiza un desempeño confiable en una variedad de necesidades analíticas.

La serie Claude incluye variantes adaptadas a diferentes requisitos de rendimiento y coste. Una versión está optimizada para ofrecer un razonamiento profundo y una visión contextual, lo que la hace ideal para tareas como el análisis de conjuntos de datos complejos o la evaluación de decisiones empresariales multidimensionales. Otra versión, más simplificada, está diseñada para ofrecer respuestas más rápidas, lo que resulta perfecta para las tareas comparativas rutinarias y, al mismo tiempo, mantiene una precisión fiable.

Anthropic ofrece un modelo de precios sencillo y de pago por uso, que lo hace accesible tanto para proyectos más pequeños como para análisis empresariales a gran escala.

Claude se guía por principios destinados a producir resultados equilibrados y, al mismo tiempo, reducir los sesgos dañinos. Reconoce las áreas de incertidumbre al presentar múltiples perspectivas. Además, las organizaciones pueden personalizar el comportamiento del modelo mediante instrucciones e indicaciones del sistema específicas, garantizando que sus respuestas se ajusten a las normas internas o los principios éticos. Estas características de gobernanza hacen que Claude sea particularmente eficaz a la hora de gestionar tareas comparativas delicadas y matizadas.

La serie Claude es adecuada para una amplia gama de comparaciones estratégicas. En los negocios, puede ayudar a evaluar las estrategias de mercado, evaluar las propuestas de los proveedores o comparar las características de los productos de la competencia. En entornos académicos y de investigación, apoya la comparación de metodologías o estudios contradictorios, garantizando un análisis exhaustivo y objetivo en todos los casos.

Se espera que Google Gemini mejorar los flujos de trabajo de comparación, aunque la información específica sobre sus versiones, precios y gobierno aún no está disponible. A medida que surgen más detalles, Gemini se perfila como un modelo que vale la pena vigilar.

Al igual que otras soluciones nuevas, es probable que los desarrollos futuros de Gemini se basen en las capacidades de plataformas como la serie Llama de Meta.

La serie LLama de Meta amplía los límites del modelado de lenguajes de código abierto, ofreciendo a los investigadores herramientas poderosas y transparentes. Estos modelos están diseñados para simplificar las tareas de comparación intensivas y, al mismo tiempo, hacer que el modelado de lenguaje avanzado sea más accesible.

La serie Llama incluye modelos que van desde De 7 mil millones a 65 mil millones de parámetros, que responde a diversas necesidades computacionales. La última versión, LLama 2, incluye tanto modelos básicos como versiones de chat perfeccionadas diseñadas para tareas conversacionales. Esta gama permite a los usuarios seleccionar el modelo que mejor se adapte a sus flujos de trabajo específicos.

Diseñada pensando en la eficiencia, la arquitectura garantiza un rendimiento fiable, incluso con datos de texto a gran escala. Los modelos son excelentes para comprender el contexto y mantener la coherencia durante largas conversaciones, lo que los hace particularmente útiles para comparar temas o conjuntos de datos complejos.

Meta ha adoptado un enfoque único con LLama, ofreciendo un plataforma orientada a la investigación bajo una licencia comercial personalizada. A diferencia de los servicios tradicionales basados en suscripciones, LLama requiere alojamiento propio, lo que significa que los costos están vinculados a los recursos computacionales en lugar de a los cargos por token.

Esta configuración ofrece gastos predecibles, especialmente para las organizaciones que realizan comparaciones exhaustivas. Los costos dependen del hardware y de los recursos de la nube, y no de las tarifas fluctuantes de las API. Sin embargo, la implementación y el mantenimiento de los modelos exigen conocimientos técnicos, que las organizaciones deben tener en cuenta al evaluar el costo total de propiedad.

Llama se adhiere a Meta Guía de uso responsable, que proporciona directrices claras para implementar y administrar los modelos. Las medidas de seguridad integradas y las funciones de filtrado de contenido ayudan a reducir el riesgo de generar resultados perjudiciales durante las tareas de comparación.

Meta también aborda abiertamente las limitaciones y sesgos de los modelos, lo que permite a los usuarios tomar decisiones informadas sobre sus aplicaciones. La naturaleza de código abierto de Llama fomenta contribuciones a la comunidad para mejorar aún más la plataforma.

Llama se destaca en escenarios que requieren comparaciones analíticas exhaustivas, que ofrece a los usuarios un control total sobre la implementación y la personalización. Es especialmente adecuado para la investigación académica, el análisis de políticas y las aplicaciones empresariales en las que la privacidad y la transparencia de los datos son fundamentales.

Los modelos funcionan excepcionalmente bien con tareas que involucran documentación técnica, trabajos de investigación y análisis de datos estructurados. Los estudios extensos se benefician de la capacidad de LLama para mantener el contexto y respaldar comparaciones detalladas.

Sin embargo, la complejidad de la plataforma la hace ideal para organizaciones con equipos de IA dedicados y recursos computacionales importantes. Esto garantiza que los usuarios puedan aprovechar al máximo sus capacidades y, al mismo tiempo, gestionar las exigencias técnicas de la implementación.

Mistral se centra en ofrecer un modelado de lenguaje rápido y eficiente, optimizado para implementaciones ligeras y que requieren pocos recursos. Sus modelos están diseñados para gestionar con facilidad diversos flujos de trabajo de comparación.

Mistral ofrece una gama de modelos, desde opciones compactas y fáciles de usar hasta soluciones de nivel empresarial. El modelo estrella, Mistral Pequeño, está diseñado para un procesamiento rápido, mientras que las versiones especializadas, como Codestral y Devstral Small sobresalen en la generación de código en más de 80 lenguajes de programación. Su arquitectura abierta permite una amplia personalización para satisfacer diversas necesidades.

Mistral emplea un modelo de precios que prioriza la eficiencia de los recursos, lo que ayuda a mantener los costos manejables y, al mismo tiempo, garantiza una escalabilidad predecible. Su marco de código abierto ofrece soluciones asequibles para empresas emergentes, instituciones académicas e iniciativas de investigación. Para aplicaciones empresariales, Medio magistral admite tareas de razonamiento auditables y específicas de un dominio, lo que agrega valor para las organizaciones más grandes.

Mistral integra medidas de seguridad sólidas para promover el uso responsable de la IA. Es compatible con varios idiomas, incluidos inglés, francés, italiano, alemán y español. Las funciones adicionales incluyen la llamada a funciones para herramientas y API externas, así como el modo JSON para un manejo de datos simplificado. Estas herramientas de gobierno mejoran la capacidad de Mistral para ofrecer flujos de trabajo de comparación de alto rendimiento.

Mistral destaca en las aplicaciones en tiempo real que requieren baja latencia, lo que lo hace ideal para el análisis rápido de datos y las implementaciones en la periferia móvil. Sus modelos especializados son idóneos para generar código en una amplia gama de lenguajes de programación. Además, el API de incrustaciones permite realizar tareas avanzadas de análisis de texto, como la agrupación, la clasificación y la evaluación de opiniones. Esta combinación de funciones convierte a Mistral en una opción sólida para servicios de API escalables y rentables.

Las plataformas de LLM tienen fortalezas y limitaciones específicas, y ofrecen a las organizaciones una variedad de opciones para satisfacer sus necesidades y presupuestos. A continuación se muestra un desglose de los principales beneficios y desafíos asociados a cada plataforma.

Prompts.ai proporciona acceso a más de 35 modelos en un ecosistema unificado, y sus créditos TOKN de pago por uso pueden reducir los costos de IA hasta en un 98%. Sin embargo, las empresas que están profundamente arraigadas en configuraciones de un solo proveedor pueden enfrentarse a obstáculos a la hora de adoptar una plataforma multimodelo debido a las complejidades de la integración.

Familia GPT de OpenAI destaca por sus avanzadas capacidades de razonamiento y su compatibilidad con una amplia gama de entornos de desarrollo. Estos modelos son particularmente eficaces para tareas de comparación complejas que requieren un análisis detallado. Por otro lado, conllevan costos operativos más altos y la posibilidad de que dependan de un solo proveedor, especialmente en el caso de las organizaciones que dependen en gran medida del GPT-4 o el GPT-5 para sus operaciones críticas.

Claude antrópico hace hincapié en la seguridad y la inteligencia artificial ética, lo que la convierte en un fuerte competidor para las industrias que se ocupan de datos confidenciales o regulados. Su diseño constitucional de IA minimiza los resultados dañinos, pero su enfoque cauteloso puede limitar la flexibilidad creativa necesaria para tareas de comparación específicas.

Google Géminis se integra perfectamente con el ecosistema de Google y ofrece capacidades multimodales sólidas que gestionan texto, imágenes y código de forma simultánea. Si bien es una opción eficaz para flujos de trabajo de comparación integrales, las organizaciones que operan fuera de la infraestructura de Google pueden enfrentarse a dificultades en lo que respecta a la implementación y la sincronización de los datos.

Serie Llama de Meta permite una amplia personalización y una implementación rentable con gastos de infraestructura predecibles. Sin embargo, requiere una gran experiencia técnica para implementarlo de manera efectiva, lo que lo hace menos accesible en comparación con las soluciones administradas.

Mistral está diseñado para un procesamiento rápido y operaciones de baja latencia, lo que lo hace ideal para aplicaciones en tiempo real. Sin embargo, al ser un nuevo participante en el mercado, carece de las amplias integraciones de terceros y los recursos comunitarios que ofrecen las plataformas más establecidas.

Al seleccionar la plataforma adecuada, es esencial alinear sus capacidades con las demandas de su flujo de trabajo. Cada opción aporta ventajas diferenciadas a las tareas de comparación, por lo que la elección depende en gran medida de sus necesidades específicas.

Prompts.ai destaca por su integración de más de 35 modelos, precios de crédito TOKN unificados y seguridad de nivel empresarial. Aborda los desafíos de la adopción moderna de la IA al tiempo que simplifica la administración de herramientas.

Familia GPT de OpenAI se destaca en el manejo de tareas de razonamiento complejas, lo que lo convierte en un fuerte candidato para realizar comparaciones intrincadas, aunque conlleva costos operativos más altos.

Claude antrópico se centra en la IA ética y el despliegue seguro, por lo que es ideal para industrias con requisitos reglamentarios estrictos.

Google Gemini offers multimodal capabilities, making it ideal for comparing diverse data types seamlessly.

Meta's LLaMA series provides customizable, open-source models, perfect for deep analytical comparisons tailored to specific needs.

Lastly, Mistral is designed for low-latency, real-time responses, making it a strong choice for customer-facing or interactive applications.

For most enterprises, the decision boils down to balancing cost efficiency, model diversity, and governance needs. Platforms like Prompts.ai, which offer unified access to multiple models in a secure environment, are well-suited for organizations seeking flexibility and cost optimization. On the other hand, businesses with specialized technical requirements or existing infrastructure investments may find targeted solutions more appropriate.

Ultimately, the right platform enhances decision-making efficiency and unlocks AI capabilities tailored to your organization's goals and challenges.

When choosing a Large Language Model (LLM) platform for your business, focus on essential factors such as performance, cost-effectiveness, scalability, and security. Opt for platforms that offer comprehensive performance tracking and comparison tools, ensuring the models align with your specific requirements.

Evaluate whether the platform includes features like version management, team collaboration capabilities, and adherence to industry standards such as SOC 2. These features are critical for seamless integration into production workflows. Striking the right balance between these elements will help you select a platform that matches your operational objectives, budget, and security needs, all while delivering dependable AI-driven solutions.

The TOKN credit system offered by Prompts.ai takes a pay-as-you-go approach, allowing you to pay only for the AI services you use. This eliminates the need for fixed subscription fees, giving you greater flexibility and control over your budget while avoiding unnecessary costs.

With real-time usage tracking, you can keep a close eye on your spending, ensuring complete transparency. This feature lets you monitor and adjust your usage as needed, making it a smart option for managing expenses while still benefiting from top-tier AI services.

Prompts.ai offers powerful governance tools designed to keep your AI operations compliant with industry standards while ensuring secure usage of its models. These tools provide the oversight and control necessary to monitor, manage, and enforce best practices effectively.

With these features in place, users can seamlessly integrate AI-driven workflows into their processes, all while staying aligned with essential regulations and maintaining robust security protocols.