يمكن أن تكون إدارة نماذج اللغات الكبيرة المتعددة (LLMs) معقدة، ولكن الأدوات المناسبة تجعل الأمر أسهل. منصات مثل Prompts.ai، أمازون سيج ميكر، التعلم الآلي من Azure، محولات الوجه المعانقة، كوميت إم إل، و بحيرة عميقة تبسيط عمليات سير العمل وخفض التكاليف وتحسين الأمان. إليك ما تحتاج إلى معرفته:

الوجبات الجاهزة السريعة: اختر الأدوات بناءً على احتياجات فريقك - سواء كانت تحسين التكلفة أو قابلية التوسع أو الأمان - مع ضمان توافقها مع البنية التحتية والأهداف الخاصة بك.

يجمع Prompts.ai أكثر من 35 نموذجًا للذكاء الاصطناعي من الدرجة الأولى، بما في ذلك GPT-5 وكلود لاما، و الجوزاء، في منصة واحدة وموحدة. من خلال معالجة تعقيدات إدارة نماذج اللغات الكبيرة المتعددة (LLMs)، فإنها تقضي على أوجه القصور التي تسببها الأدوات المتناثرة.

مع نظام إدارة موجه مركزي، يسمح Prompts.ai للفرق بتصميم واختبار ونشر المطالبات عبر نماذج مختلفة دون عناء. تضمن المنصة تتبعًا سلسًا للإصدار، مما يساعد في الحفاظ على الاتساق عبر عمليات سير عمل الذكاء الاصطناعي.

المنصة أدوات تنسيق سير العمل تبسيط إدارة LLM المتعددة من خلال خطوط الأنابيب الآلية. يمكن للفرق مقارنة مخرجات النموذج جنبًا إلى جنب، مما يسهل تحديد التكوينات الأفضل أداءً لمهام محددة.

يتكامل Prompts.ai أيضًا بسلاسة مع أطر مثل لانج تشين، معانقة الوجه، و حزمة أدوات Vercel AI، بالإضافة إلى الخدمات السحابية مثل AWS بيدروك و أزور أوبن إيه آي. تعمل عمليات الدمج هذه على تبسيط التشغيل الآلي لسير العمل وتقييم النموذج دون الحاجة إلى تعديلات فنية شاملة.

لا تعمل هذه الميزات على تحسين الكفاءة فحسب، بل تمهد الطريق أيضًا لإدارة أفضل للتكاليف وبروتوكولات أمان أقوى.

يقوم Prompts.ai بالتسليم تتبع التكاليف والتحليلات التفصيلية، مما يوفر مراقبة على مستوى الرمز لتتبع الاستخدام والنفقات لكل LLM في الوقت الفعلي. من خلال دمج أدوات الذكاء الاصطناعي، تفتخر المنصة بما يصل إلى توفير التكاليف بنسبة 98%.

من خلال لوحات المعلومات في الوقت الفعلي، يكتسب المستخدمون رؤى حول نسب التكلفة، مما يتيح تصميمات سريعة أكثر كفاءة. تسمح هذه الشفافية للفرق باختيار النماذج الأكثر فعالية من حيث التكلفة لاحتياجاتهم دون المساس بالأداء. بالإضافة إلى ذلك، تعمل المنصة على تحويل التكاليف الثابتة إلى نفقات قابلة للتطوير حسب الطلب، مما يجعل اعتماد الذكاء الاصطناعي أكثر مرونة وقابلية للإدارة.

على سبيل المثال، استخدمت شركة خدمات مالية Prompts.ai لإدارة عمليات سير العمل عبر أوبن إيه آي، أنثروبي، و جوجل فيرتكساي عارضات ازياء. ومن خلال تركيز الإدارة السريعة وتتبع التكاليف، فإنها تقلل النفقات التشغيلية بنسبة 30% وتعزز دقة الاستجابة من خلال الاستفادة من نقاط القوة في النماذج الفردية للمهام المختلفة.

يعطي Prompts.ai الأولوية للأمان بميزات مثل الوصول المستند إلى الأدوار وتسجيل التدقيق والتشفير. يدعم الامتثال للمعايير الرئيسية، بما في ذلك SOC 2 من النوع الثاني وHIPAA واللائحة العامة لحماية البيانات، مما يضمن تلبية المنظمات للمتطلبات التنظيمية عند إدارة العديد من LLMs.

تتعاون المنصة مع فانتا لمراقبة التحكم المستمر وبدأت عملية تدقيق SOC 2 Type II في 19 يونيو 2025. يوفر مركز الثقة الخاص به تحديثات في الوقت الفعلي حول سياسات الأمان والضوابط والامتثال، مما يمنح المؤسسات رؤية كاملة للوضع الأمني الخاص بها.

تشمل جميع خطط المؤسسة أدوات الحوكمة والامتثال، والعروض الشفافية الكاملة وقابلية التدقيق لجميع تفاعلات الذكاء الاصطناعي. يعمل إطار الأمان القوي هذا على تعزيز الحوكمة مع تلبية متطلبات العمليات على مستوى المؤسسة.

تم تصميم بنية Prompts.ai للتوسع أفقيًا وإدارة العشرات أو حتى المئات من مثيلات LLM. تضمن موازنة التحميل المؤتمتة وتخصيص الموارد الأداء الأمثل، بينما يقوم التوجيه الذكي بتوجيه الطلبات إلى النموذج الأنسب استنادًا إلى معايير محددة مسبقًا.

تدعم المنصة عمليات النشر السحابية والمحلية، مما يوفر المرونة للمؤسسات ذات احتياجات البنية التحتية المتنوعة. يسمح تصميمها القابل للتطوير بالتوسع السلس دون عمليات إعادة تشكيل رئيسية، مما يلبي احتياجات كل من الفرق الصغيرة والمؤسسات الكبيرة.

تشمل أدوات المراقبة في الوقت الفعلي تنبيهات تلقائية لحالات الفشل السريعة ومشكلات وقت الاستجابة وتجاوزات التكلفة، مما يضمن عمليات موثوقة في بيئات الإنتاج. تتعقب لوحات معلومات الأداء وقت الاستجابة وجودة الاستجابة وانحراف النموذج، مما يمكّن الفرق من حل المشكلات بسرعة وضبط اختيار النموذج لمهام محددة.

يوفر Amazon SageMaker منصة قوية لنشر وإدارة نماذج اللغات الكبيرة المتعددة (LLMs) على نطاق واسع. إنه يوفر بنية تحتية على مستوى المؤسسة مصممة لمواجهة تحديات نشر LLM، مع التركيز على التنسيق وكفاءة التكلفة والأمان وقابلية التوسع.

شركة ساج ميكر سجل النموذج يعمل كمحور مركزي لإدارة إصدارات LLM المختلفة. وهو يسمح للفرق بتتبع نسب النماذج وتخزين البيانات الوصفية وإدارة عمليات سير عمل الموافقة عبر النماذج المختلفة. لعمليات مبسطة، خطوط أنابيب سيج ميكر يعمل على أتمتة عمليات سير العمل المعقدة، مما يتيح تنسيق العديد من LLMs في تكوينات متسلسلة أو متوازية.

مع نقاط نهاية متعددة النماذج، يمكن للفرق استضافة العديد من LLMs على نقطة نهاية واحدة، وتحميل النماذج ديناميكيًا حسب الحاجة. لا يؤدي هذا الإعداد إلى خفض تكاليف البنية التحتية فحسب، بل يضمن أيضًا المرونة في اختيار النماذج. سواء كان ذلك بيرتأو متغيرات GPT أو النماذج المخصصة التي تم ضبطها بدقة، يمكن نشرها جميعًا على نفس البنية التحتية.

بالنسبة لمهام الاستدلال واسعة النطاق، فإن SageMaker تحويل الدفعات يغير قواعد اللعبة. إنه يتعامل بكفاءة مع مجموعات البيانات الضخمة عبر نماذج متعددة، ويدير تخصيص الموارد وجدولة المهام تلقائيًا لتحسين استخدام الحوسبة.

يتكامل SageMaker بسلاسة مع مستكشف تكاليف AWS، مما يوفر تتبعًا تفصيليًا للنفقات عبر عمليات نشر LLM. إنها سبوت ترينينغ يمكن للميزة خفض تكاليف التدريب بنسبة تصل إلى 90٪ من خلال الاستفادة من قدرة AWS غير المستخدمة لضبط النموذج والتجارب.

المنصة التحجيم التلقائي تعمل الميزة على ضبط موارد الحوسبة استجابةً لمتطلبات حركة المرور، مما يدعم التحجيم الأفقي والعمودي. هذا يضمن أن المؤسسات تحافظ على الأداء مع الحفاظ على التكاليف تحت السيطرة.

شركة ساج ميكر التوصية بالاستدلال يزيل التخمين عند النشر من خلال تحليل أنواع المثيلات والتكوينات المختلفة. يوفر توصيات مصممة خصيصًا استنادًا إلى وقت الاستجابة والإنتاجية وقيود الميزانية، مما يساعد الفرق في العثور على الإعداد الأكثر فعالية من حيث التكلفة لأحمال عمل LLM الخاصة بهم.

تستخدم SageMaker تدابير الأمان القوية الخاصة بـ AWS، بما في ذلك التشفير أثناء الراحة وأثناء النقل، لحماية عناصر النموذج والبيانات. تدعم المنصة عزل بولي كلوريد الفينيل، مع ضمان إجراء جميع العمليات - مثل التدريب والاستدلال - داخل حدود الشبكة الخاصة.

من خلال تكامل IAM، يمكن للمؤسسات تنفيذ ضوابط وصول دقيقة، وتعيين أذونات قائمة على الأدوار لإدارة النماذج ومجموعات البيانات وبيئات النشر. هذا يضمن تقييد الوصول بناءً على أدوار المستخدم ومسؤولياته.

تتوافق المنصة أيضًا مع معايير الصناعة الرئيسية، بما في ذلك SOC 1، SOC 2، SOC 3، PCI DSS المستوى 1، ISO 27001، و HIPAA. بالإضافة إلى ذلك، تقدم SageMaker سجلات تدقيق شاملة لتتبع جميع أنشطة إدارة النموذج، مما يساعد في كل من المراقبة الأمنية وإعداد تقارير الامتثال.

تم تصميم SageMaker للتعامل مع متطلبات بيئات LLM المتعددة، وتوسيع نطاق عمليات الضبط الدقيق عبر وحدات معالجة الرسومات وتوفير القدرة لكل من الاستدلال في الوقت الفعلي والدفعات. يمكنه التعامل مع آلاف الطلبات المتزامنة مع تحسين استخدام الموارد من خلال التوازي بين البيانات والنموذج.

بفضل ITS بنية قائمة على الحاويات، تتكامل المنصة بسهولة مع عمليات سير عمل MLOPs الحالية. كما أنه يدعم بيئات التشغيل المخصصة، مما يسمح للمؤسسات بنشر النماذج باستخدام حاويات معدة مسبقًا أو إعدادات مخصصة مصممة وفقًا لأطر ومتطلبات محددة.

يوفر Microsoft Azure Machine Learning نظامًا أساسيًا شاملاً لإدارة نماذج اللغات الكبيرة (LLMs)، ودمج أدوات MLPs بسلاسة مع البنية التحتية السحابية لـ Microsoft. هذا يجعله اختيارًا ممتازًا للمؤسسات التي تستخدم بالفعل نظام Microsoft البيئي.

يبسط التعلم الآلي من Azure إدارة LLM من خلال سجل النموذج، الذي يتتبع الإصدارات والبيانات الوصفية والتحف. بالنسبة لأولئك الذين يفضلون نهج عدم البرمجة، فإن واجهة المصمم يسمح للمستخدمين بإنشاء عمليات سير عمل مرئية لإدارة نماذج متعددة دون عناء.

المنصة التعلم الآلي تعمل الميزة على التخلص من متاعب اختيار النموذج وضبط المعلمات الفائقة، مما يمكّن الفرق من مقارنة البنى المختلفة - من النماذج القائمة على المحولات إلى الإصدارات المخصصة الدقيقة - من خلال التجارب الموازية.

للنشر، تستخدم Azure نقاط النهاية المُدارة التعامل مع كل من الاستدلال في الوقت الفعلي والدفعات عبر LLMs المتعددة. إنه يدعم عمليات النشر ذات اللون الأزرق والأخضر، مما يسمح للفرق باختبار نماذج جديدة جنبًا إلى جنب مع نماذج الإنتاج قبل الانتقال الكامل. هذا يقلل من وقت التعطل ويقلل المخاطر عند إدارة عدة نماذج في وقت واحد.

يتيح Azure أيضًا تنسيق خطوط الأنابيب، مما يسمح للفرق بتصميم عمليات سير العمل حيث تتعاون العديد من LLMs. على سبيل المثال، يمكن لنموذج واحد التعامل مع تصنيف النص بينما يقوم آخر بتحليل المشاعر، كل ذلك ضمن خط أنابيب موحد.

يتم استكمال أدوات التنسيق هذه بقدرات قوية لإدارة التكاليف.

يتكامل التعلم الآلي من Azure بسلاسة مع إدارة تكلفة Azure، مما يوفر تتبعًا تفصيليًا للنفقات لعمليات نشر LLM. لخفض التكاليف، تقدم المنصة ماكينات سبوت الافتراضية، والتي تستخدم سعة الحوسبة الفائضة لـ Azure للمهام غير الحرجة مثل التدريب.

ال ميزة التحجيم التلقائي يضبط موارد وحدة المعالجة المركزية ووحدة معالجة الرسومات تلقائيًا بناءً على الطلب، مما يضمن الاستخدام الفعال. لأحمال العمل التي يمكن التنبؤ بها، مثيلات محجوزة تقدم أسعارًا مخفضة مقارنة بتسعير الدفع أولاً بأول. بالإضافة إلى ذلك، علامات تخصيص التكلفة السماح للفرق بمراقبة النفقات حسب المشروع أو القسم أو نوع النموذج، مما يساعد في تخطيط الميزانية وإدارة الموارد.

الأمان هو حجر الزاوية في التعلم الآلي من Azure. تضمن المنصة تشفير من طرف إلى طرف، وحماية البيانات والتحف النموذجية سواء أثناء النقل أو أثناء الراحة. التكامل مع دليل أزور النشط يدعم تسجيل الدخول الأحادي وإدارة الهوية المركزية.

مع تكامل الشبكة الافتراضية (VNet)، تظل عمليات التدريب والاستدلال ضمن الشبكات الخاصة. يمكن أيضًا إعداد الفرق نقاط النهاية الخاصة للقضاء على التعرض للإنترنت، وتلبية متطلبات الأمان الصارمة للتطبيقات الحساسة.

تلتزم Azure Machine Learning بمعايير الصناعة الرئيسية مثل سوك 1، سوك 2، أيزو 27001، هيبا، و خريطة فيدرام. أدوات مثل مدير التوافق في Azure المساعدة في التقييم المستمر وإعداد التقارير، بينما سياسة أزور يعمل على التشغيل الآلي للحوكمة من خلال فرض إعدادات الأمان وسياسات الاحتفاظ بالبيانات وعناصر التحكم في الوصول لعمليات النشر الجديدة.

تم تصميم Azure Machine Learning للتوسع، مما يجعله مناسبًا لكل شيء بدءًا من تجارب النموذج الفردي وحتى عمليات نشر LLM على مستوى المؤسسة. يمكن لمجموعات الحوسبة الخاصة بها تخصيص موارد التدريب الموزعة تلقائيًا، مما يدعم كلاً من البيانات والتوازي النموذجي عبر وحدات معالجة الرسومات المتعددة.

من خلال الدمج مع خدمة أزور كوبيرنيتيس (يسأل)، تتيح المنصة تنسيق الحاويات للإعدادات المعقدة متعددة النماذج. وهذا يسمح للفرق بنشر LLMs كخدمات مصغرة، ولكل منها إمكانات مستقلة للتحجيم والتحديث.

مع توفر أكثر من 60 منطقة أزور، تضمن المنصة الوصول بزمن انتقال منخفض لعمليات النشر العالمية، مع الحفاظ على الإدارة المركزية والمراقبة. بالإضافة إلى ذلك، التكامل مع خدمات Azure المعرفية يسمح للفرق بدمج LLMs المخصصة مع خدمات الذكاء الاصطناعي المبنية مسبقًا، وإنشاء حلول مختلطة توفر الوقت وتوفر المرونة للاحتياجات المتخصصة.

محولات الوجه المعانقة تبرز كأداة مفتوحة المصدر مصممة لتبسيط إدارة نماذج اللغات الكبيرة (LLMs). من خلال الاستفادة من أطر مثل PyTorch و تينسورفلو، فهي توفر للمطورين منصة سهلة الاستخدام وقابلة للتطوير لتحميل وإدارة آلاف النماذج بسطر واحد فقط من التعليمات البرمجية. إن تركيزها على إمكانية الوصول والكفاءة وقابلية التوسع يجعلها حلاً مثاليًا للفرق التي تتعامل مع العديد من LLMs.

في جوهرها، تم تصميم Transformers لتبسيط الوصول إلى النموذج، مما يتيح التنسيق الفعال وإدارة الموارد.

تبسط مكتبة ترانسفورمرز اكتشاف النموذج وتحميله بأوامر موجزة. استخدام من _تم تدريبه مسبقًا () الوظيفة، يمكن للمطورين تحميل النماذج على الفور جنبًا إلى جنب مع الرموز والأوزان والتكوينات - دون الحاجة إلى إعداد إضافي.

ال واجهة برمجة تطبيقات خطوط الأنابيب يعزز قابلية الاستخدام من خلال تمكين التبديل السلس للمهام والإصدار التلقائي المستند إلى Git. على سبيل المثال، يمكنك بسهولة مقارنة مخرجات تحليل المشاعر من نماذج مثل BERT، روبرت أ، و ديستيلبرت عن طريق ضبط معلمة النموذج في خط الأنابيب الخاص بك. يقوم كل مستودع نموذجي بتتبع سجل كامل للتغييرات، مما يسمح للمستخدمين بالعودة إلى الإصدارات السابقة أو تحليل اختلافات الأداء عبر التكرارات.

عندما يتعلق الأمر بـ المعالجة المجمعة والاستدلال، تتضمن المكتبة التجميع الديناميكي وتحسين الانتباه، مما يضمن المعالجة الفعالة للمدخلات ذات الطول المتغير. ميزات مثل نقطة تفتيش متدرجة تساعد في إدارة استهلاك الذاكرة، خاصة عند العمل مع النماذج واسعة النطاق.

يوفر Hugging Face Transformers العديد من الأدوات لتحسين استخدام الحوسبة والذاكرة، مما يجعله خيارًا فعالاً من حيث التكلفة للمؤسسات. تحديد كمية النموذج يمكن تقليص أحجام النماذج بنسبة تصل إلى 75٪ مع الحفاظ على الأداء، وهو أمر مفيد بشكل خاص للتعامل مع نماذج متعددة في وقت واحد.

تقدم المكتبة أيضًا نماذج مقطرة، مثل Distilbert، والتي تم تحسينها مسبقًا للحصول على أداء أسرع وتقليل استخدام الذاكرة. تعمل هذه الطرازات بشكل أسرع بنسبة 60% تقريبًا وتستهلك ذاكرة أقل بنسبة 40% مقارنة بنظيراتها كاملة الحجم، مما يُترجم إلى وفورات كبيرة لعمليات النشر واسعة النطاق.

تحميل النموذج الديناميكي يضمن استخدام الموارد بكفاءة عن طريق تحميل النماذج فقط عند الحاجة، بدلاً من الاحتفاظ بها جميعًا في الذاكرة مرة واحدة. بالإضافة إلى ذلك، فإنه التخزين المؤقت للنموذج تحقق الاستراتيجيات التوازن بين استخدام الذاكرة وسرعة التحميل، مما يمنح الفرق المرونة لتخصيص الموارد بناءً على الطلب.

لمزيد من الكفاءة والتكامل مع وقت تشغيل ONNX يعزز الأداء في سيناريوهات الاستدلال المستندة إلى وحدة المعالجة المركزية، وهو خيار فعال من حيث التكلفة للفرق التي تتطلع إلى تقليل نفقات وحدة معالجة الرسومات. تسمح هذه القدرة على التكيف للمؤسسات باختيار استراتيجيات النشر التي تتوافق مع احتياجاتها الخاصة.

تم تصميم Hugging Face Transformers للتوسع بسهولة، سواء كنت تجري تجربة واحدة أو تدير بيئة إنتاج واسعة النطاق. إنه يدعم إعدادات وحدات معالجة الرسومات المتعددة والتوازي النموذجي، مما يتيح استخدام النماذج التي تتجاوز ذاكرة جهاز واحد.

تتكامل المكتبة مع أطر التعلم الآلي الشائعة مثل شعاع و داسك، مما يجعل من السهل التوسع أفقيًا عبر أجهزة متعددة. يضمن هذا التوافق الاندماج السلس في خطوط أنابيب MLOPs الحالية، مما يسمح للفرق بنشر LLMs على نطاق واسع.

من خلال محور عناق الوجه، يمكن للمؤسسات تركيز إدارة النماذج الخاصة بها باستخدام ميزات مثل المستودعات الخاصة وعناصر التحكم في الوصول وسياسات الحوكمة. تدعم هذه المركزية تعاون الفريق وتضمن الإشراف الفعال عبر مجموعة من LLMs.

من أجل عمليات نشر الإنتاج، يمكن وضع نماذج Transformers في حاويات ونشرها باستخدام أدوات مثل عامل ميناء، كوبيرنيتيس، أو الخدمات السحابية الأصلية. تضمن الواجهات القياسية للمكتبة سلوكًا متسقًا عبر بيئات مختلفة، مما يبسط نشر الأنظمة المعقدة متعددة النماذج.

واسع النطاق النظام البيئي المجتمعي هي ميزة أخرى، حيث تقدم الآلاف من النماذج المدربة مسبقًا ومجموعات البيانات والتحسينات التي يساهم بها المستخدم. يقلل هذا النظام البيئي من الحاجة إلى إنشاء نماذج من الصفر، مما يوفر حلولًا جاهزة للاستخدام لمجموعة واسعة من التطبيقات.

تبرز Comet ML كمنصة قوية للتعلم الآلي مصممة لتبسيط تتبع ومراقبة وإدارة نماذج اللغات الكبيرة المتعددة (LLMs) طوال دورة حياتها. من خلال تركيز تتبع التجارب وتسجيل النماذج ومراقبة الإنتاج، فإنها تكمل الاستراتيجيات المتكاملة التي تمت مناقشتها سابقًا. هذا يجعلها أداة مثالية للمؤسسات التي تدير العديد من LLMs في وقت واحد.

يقوم نظام تتبع التجارب في Comet ML بالتقاط وتنظيم البيانات من تدريب LLM الذي يتم تشغيله تلقائيًا. يقوم بتسجيل المعلمات الفائقة والمقاييس وإصدارات التعليمات البرمجية واستخدام موارد النظام في الوقت الفعلي، مما يؤدي إلى إنشاء سجل مفصل لمقارنة الأداء عبر النماذج والتكوينات المختلفة.

يعمل السجل النموذجي للمنصة كمحور مركزي لتخزين وإصدار وإدارة العديد من LLMs. وهي تتضمن بيانات وصفية مفصلة مثل معايير الأداء ومجموعات بيانات التدريب ومتطلبات النشر، مما يضمن حصول الفرق على جميع المعلومات التي تحتاجها في مكان واحد.

تتيح لوحات المعلومات القابلة للتخصيص إجراء مقارنات تلقائية، مما يسمح للفرق بتحديد النماذج الأفضل أداءً بسرعة من خلال تقييم مقاييس مثل الدقة وأوقات الاستدلال واستخدام الموارد. تعمل مساحة العمل التعاونية على تعزيز الإنتاجية من خلال تمكين أعضاء الفريق من مشاركة التجارب والتعليق على النتائج ومناقشة النتائج بكفاءة وتبسيط الاتصال واتخاذ القرار طوال دورة حياة النموذج.

يوفر Comet ML تتبعًا متعمقًا للموارد ومراقبة استخدام GPU وأوقات التدريب وحساب تكاليف تجارب LLM. تساعد هذه البيانات في تحديد فرص تقليل النفقات من خلال ضبط المعلمات الفائقة وتحسين تكوينات التدريب. تعمل لوحة معلومات التكلفة المخصصة على دمج بيانات الإنفاق عبر المشاريع وأعضاء الفريق، مما يوفر رؤى واضحة حول تكاليف البنية التحتية وتمكين قرارات تخصيص الموارد بشكل أكثر ذكاءً.

تعطي المنصة الأولوية للأمان من خلال ميزات مثل تسجيل الدخول الأحادي (SSO) وعناصر التحكم في الوصول القائمة على الأدوار وتسجيل التدقيق لحماية بيانات النموذج الحساسة وعمليات التدريب. بالنسبة للمؤسسات التي تتطلب تحكمًا إضافيًا، تسمح خيارات نشر السحابة الخاصة لـ Comet ML بالعمل داخل البنية التحتية الخاصة بها. تضمن إجراءات الأمان هذه إمكانية توسيع المنصة بشكل آمن، حتى في البيئات المعقدة والمتعددة LLM.

تم تصميم Comet ML للتعامل مع متطلبات إدارة LLMs المتعددة عبر إعدادات التدريب الموزعة. فهو يتتبع التجارب بكفاءة عبر العديد من وحدات معالجة الرسومات والآلات، مما يوفر رؤية موحدة لتقدم التدريب واستخدام الموارد. يضمن تكامل API دمجًا سلسًا في خطوط أنابيب MLOPs الحالية، بينما تسمح منظمة مساحات العمل المتعددة للمؤسسات الكبيرة بتقسيم المشاريع حسب الفريق أو القسم أو حالة الاستخدام - مع الحفاظ على الإشراف المركزي دون التضحية بالمرونة.

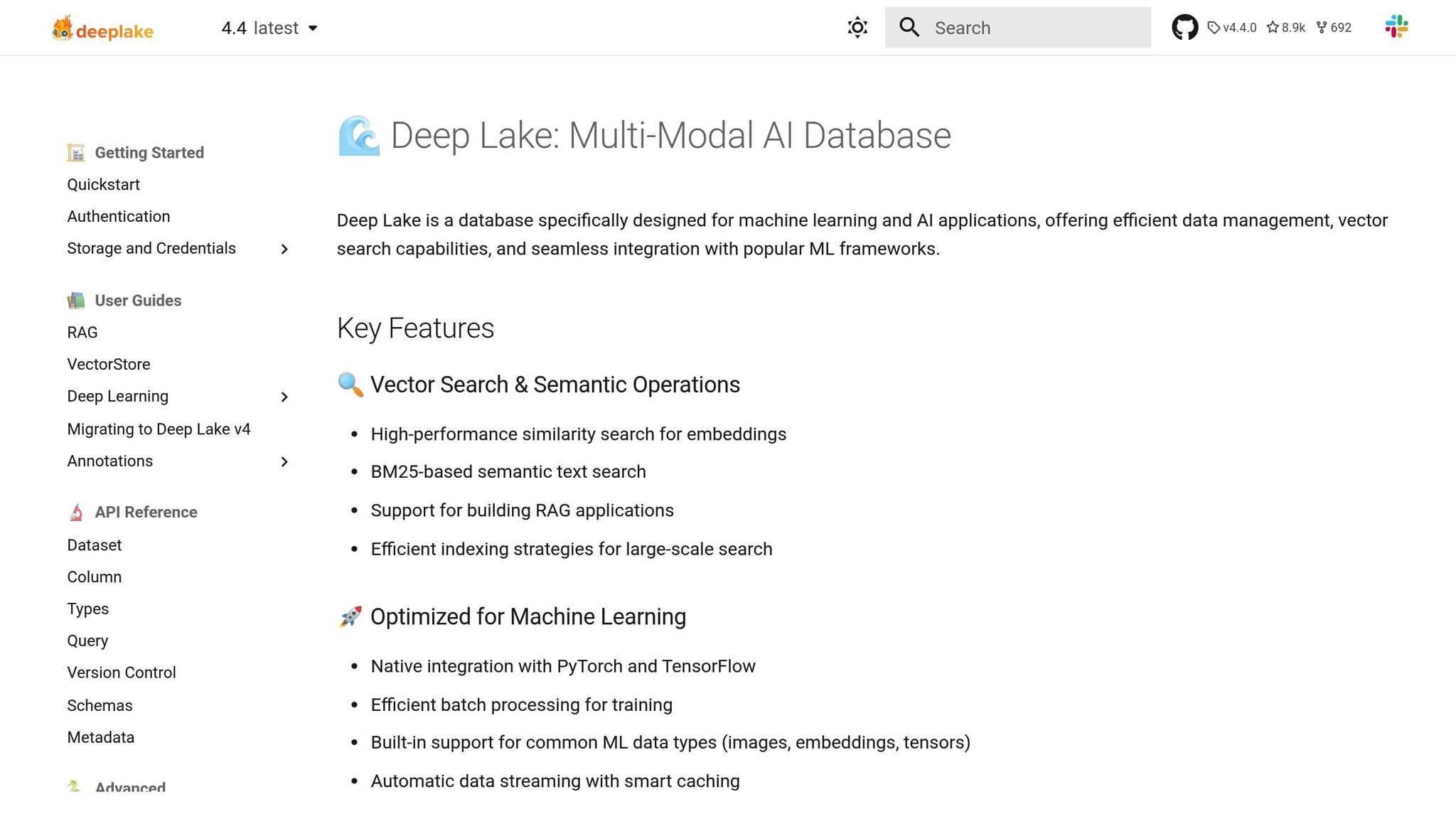

تجمع DeepLake بين قدرة بحيرات البيانات على التكيف مع دقة قواعد بيانات المتجهات، مما يخلق أساسًا لسير عمل متعدد LLM الفعال.

تم تصميم DeepLake لعمليات LLM واسعة النطاق، والتي تتطور باستمرار لتلبية احتياجات الصناعة. إنه يدمج قدرة بحيرات البيانات على التكيف مع دقة قواعد بيانات المتجهات، مما يتيح التدفق السلس للبيانات عبر LLMs المتعددة من خلال ميزة «المشاركة النموذجية التكافلية». بالإضافة إلى ذلك، تسمح أدوات مثل «Agile Evolution» و «التكيف الزمني» بإعادة المعايرة السريعة والمزامنة في الوقت الفعلي، مما يضمن بقاء عمليات سير العمل فعالة ومحدثة.

تعمل إمكانات الذاكرة المتقدمة للمنصة على تحسين استرداد نقاط البيانات المماثلة وتحسين عمليات تضمين المتجهات، مما يعزز أداء LLM. تتكامل DeepLake أيضًا مع أطر الذكاء الاصطناعي البارزة، وتدعم تطبيقات مثل الجيل المعزز للاسترجاع والحلول الأخرى التي تعتمد على LLM.

من خلال التركيز على الإدارة الديناميكية للبيانات، تعمل DeepLake على تعزيز النظام البيئي متعدد LLM، مما يضمن الدعم المستمر لسير عمل الذكاء الاصطناعي المتقدم مع الحفاظ على عمليات فعالة من حيث التكلفة.

تعطي DeepLake الأولوية لتخصيص الموارد الذكية لتقديم كل من الأداء وتوفير التكاليف.

تعمل قاعدة بيانات Tensor المُدارة الخاصة بها على تقليل نفقات التخزين مع تمكين تدفق البيانات بسرعة عالية في الوقت الفعلي. بالإضافة إلى ذلك، يقلل تخزين المتجهات الفعال للمنصة من المتطلبات الحسابية، مما يضمن عمليات سلسة دون أعباء غير ضرورية.

تدمج DeepLake تدابير أمنية قوية في إطار مبادرة «تعزيز البيانات»، وتقدم ميزات مصممة لحماية سلامة البيانات ومنع الفساد. كما يوفر أدلة تنفيذ مفصلة للمساعدة في الحفاظ على بيئات Multi-LLM الآمنة. ومع ذلك، فإن ميزات الأمان على مستوى المؤسسة محدودة إلى حد ما مقارنة بحلول قواعد بيانات المتجهات المتخصصة. يجب على المؤسسات التي لديها احتياجات امتثال صارمة تقييم ما إذا كانت عروض الأمان الحالية تلبي متطلباتها. على الرغم من ذلك، تظل DeepLake لاعبًا رئيسيًا في الإدارة الموحدة متعددة LLM، وتحقيق التوازن بين الأمن والكفاءة التشغيلية.

تدعم بنية DeepLake التي تركز على السحابة أعباء عمل Multi-LLM القابلة للتطوير والأداء العالي. من خلال التوافق مع السحابة المتعددة وقاعدة بيانات Tensor المُدارة، فإنه يسهل تدفق البيانات في الوقت الفعلي وتخصيص الموارد بشكل مرن. وهذا يجعلها مناسبة لمجموعة من التطبيقات، من روبوتات المحادثة سريعة الاستجابة إلى النماذج المعقدة التي تعالج مجموعات بيانات المستندات الضخمة.

يسلط الجدول أدناه الضوء على الميزات الأساسية للمنصات الشائعة، مما يجعل من السهل اختيار الحل المناسب لإدارة LLMs المتعددة.

تتميز كل منصة بنقاط قوتها الفريدة. Prompts.ai يتفوق في الإدارة الموحدة وكفاءة التكلفة. أمازون سيج ميكر و التعلم الآلي من Azure الاندماج بسلاسة في النظم البيئية للمؤسسات. محولات الوجه المعانقة مثالي لتجربة الكود أولاً، بينما كوميت إم إل يتألق في تتبع التجربة. بحيرة عميقة تم تصميمه لعمليات سير العمل كثيفة البيانات.

عند اتخاذ القرار، ضع في اعتبارك خبرة فريقك والبنية التحتية الحالية والاحتياجات المحددة لإدارة LLMs. قد تميل الفرق التي تركز على كفاءة التكلفة والحوكمة نحو المنصات التي تستخدم أدوات FinOps، في حين أن أولئك الذين يعطون الأولوية للتجربة قد يفضلون ميزات التتبع التفصيلي ومقارنة الأداء. قم بمواءمة هذه الإمكانات مع أهدافك للعثور على أفضل ملاءمة لإعداد Multi-LLM الخاص بك.

يتطلب التعامل مع نماذج اللغات الكبيرة المتعددة بفعالية أدوات متكاملة واستراتيجية واضحة وحوكمة قوية. تركز المنصات التي تمت مناقشتها هنا على الواجهات الموحدة والإدارة الصارمة للتكاليف والأمان على مستوى المؤسسة.

عند تقييم المنصات، من الضروري مواءمة اختيارك مع البنية التحتية والأهداف الفريدة لمؤسستك. لتحديد أولويات الفرق إدارة التكاليف والإشراف المبسط، تبرز المنصات التي تقدم أدوات FinOps في الوقت الفعلي والفواتير الموحدة. من ناحية أخرى، قد تميل الفرق التي تركز على التجريب والتخصيص نحو المكتبات مفتوحة المصدر وخيارات النشر المرنة المصممة وفقًا لاحتياجاتها.

الكفاءة في سير العمل هي حجر الزاوية للنجاح. يمكن لميزات مثل مقارنات النماذج جنبًا إلى جنب والتتبع المنهجي للتجارب والإدارة السريعة الموحدة أن تقلل بشكل كبير الوقت المستغرق في التوفيق بين الأدوات وإدارة الأنظمة المتناثرة. يصبح هذا النوع من الكفاءة ذا قيمة متزايدة مع قيام الفرق بتوسيع عمليات الذكاء الاصطناعي الخاصة بها ومعالجة حالات الاستخدام الأكثر تعقيدًا.

تظل الحوكمة والامتثال وشفافية التكلفة غير قابلة للتفاوض. تعمل المنصات ذات مسارات التدقيق الشاملة والوصول القائم على الأدوار وهياكل التسعير الواضحة على تمكين المؤسسات من تلبية المتطلبات التنظيمية مع الحفاظ على النفقات تحت السيطرة. لا تمنع أدوات مثل تتبع الاستخدام في الوقت الفعلي وإشعارات الميزانية الإنفاق الزائد فحسب، بل تضمن أيضًا أن استثمارات الذكاء الاصطناعي تقدم أقصى قيمة.

مع استمرار تطور مشهد LLM، يعد اختيار المنصات التي توازن بين الاحتياجات الفورية وقابلية التوسع أمرًا أساسيًا للبقاء في المقدمة. يضع الاختيار الصحيح أساسًا متينًا، ويدعم كل من المشاريع الحالية والنمو الحتمي لاعتماد الذكاء الاصطناعي داخل مؤسستك.

يساعدك Prompts.ai على خفض التكاليف التشغيلية بمقدار 98% أثناء إدارة العديد من نماذج اللغات الكبيرة. من خلال جمع جميع عملياتك تحت سقف واحد، فإنه يبسط سير العمل ويزيل الخطوات غير الضرورية، مما يعزز الكفاءة والأداء بشكل عام.

تم تصميم Prompts.ai مع وضع تحديات أنظمة الذكاء الاصطناعي المعقدة في الاعتبار، ويضمن لك استخراج أقصى قيمة من نماذجك دون زيادة النفقات.

يركز Prompts.ai بشدة على الأمان والامتثال التنظيمي، ويزود المستخدمين بأدوات قوية لحماية وإدارة نماذج اللغات الكبيرة (LLMs). تشمل الميزات الرئيسية مراقبة الامتثال لتلبية المتطلبات التنظيمية، أدوات الحوكمة لإدارة الوصول والاستخدام، و تحليلات مفصلة لتقييم وتحسين أداء النموذج بشكل فعال.

تقدم المنصة أيضًا تجميع وحدات التخزين المركزية و أدوات الإدارة لتبسيط سير العمل مع الحفاظ على التحكم الدقيق. هذا يضمن أن عمليات LLM الخاصة بك تظل آمنة وفعالة ومنظمة جيدًا في جميع الأوقات.

يجعل Prompts.ai عملية التحجيم سهلة باستخدام أدوات مصممة خصيصًا للتعامل بكفاءة مع مثيلات نماذج اللغة الكبيرة المتعددة (LLM). تتيح لك المنصة تنسيق سير العمل وتتبع الأداء وتبسيط العمليات - حتى عند إدارة العشرات أو المئات من LLMs في وقت واحد.

الميزات الرئيسية مثل إدارة مركزية، عمليات سير العمل الآلية، و ضبط الأداء تأكد من أن أنظمة الذكاء الاصطناعي الخاصة بك تظل موثوقة وقابلة للتكيف، بغض النظر عن مدى تعقيد الإعداد الخاص بك. إنه حل مثالي للمطورين ومحترفي الذكاء الاصطناعي الذين يشرفون على عمليات نشر واسعة النطاق ومتعددة النماذج.